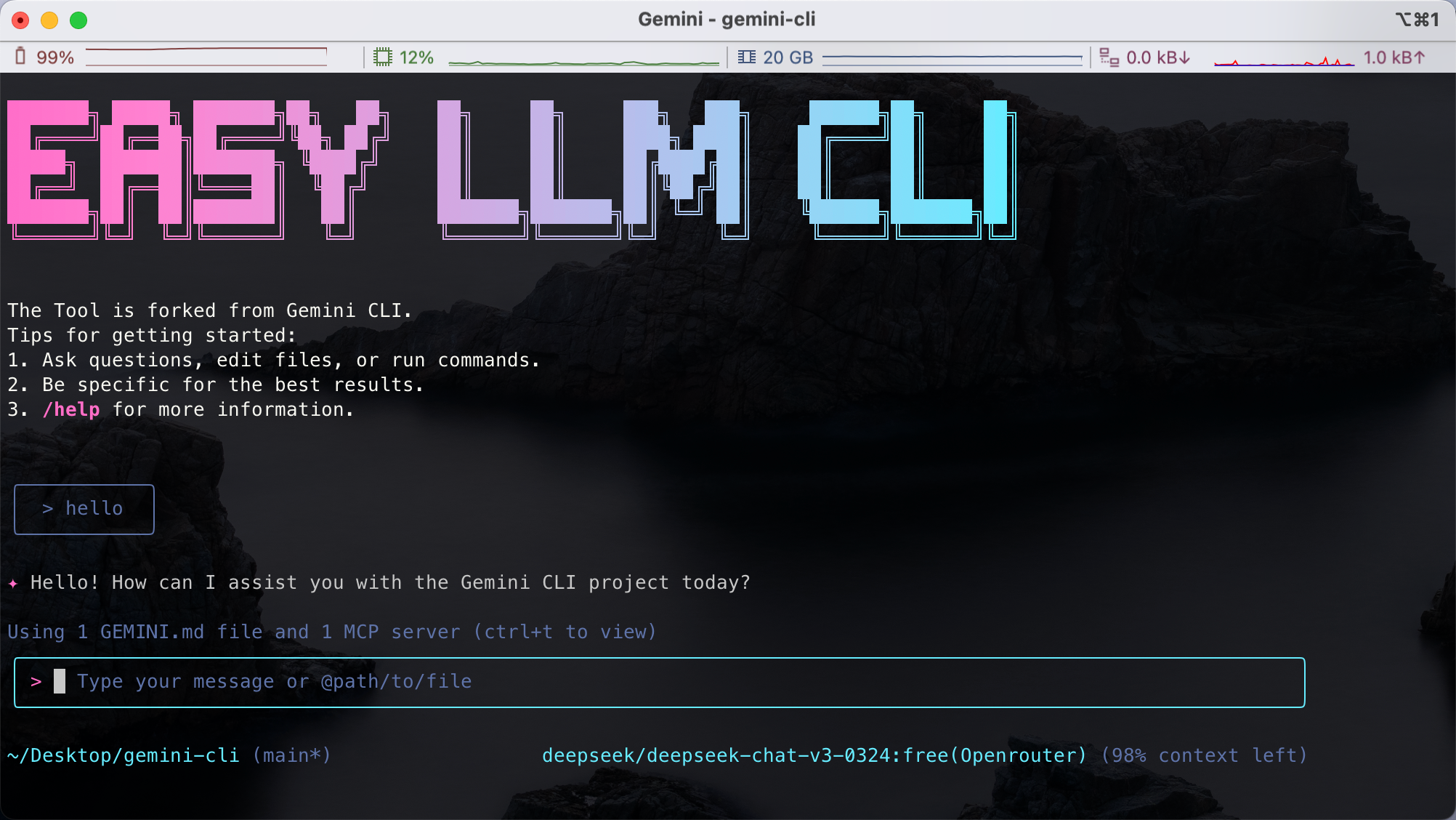

easy-llm-cli ist ein Open-Source-Befehlszeilenwerkzeug, das auf Googles Gemini Die CLI wurde entwickelt, um Entwicklern zu helfen, mehrere Large Language Models (LLMs) mit einfachen Befehlen aufzurufen. Es unterstützt APIs für OpenAI, Gemini, Claude und viele andere Modelle und ist mit jedem Modell kompatibel, das dem OpenAI-API-Format folgt. Benutzer können schnell Text generieren, Code analysieren, multimodale Eingaben (wie Bilder oder PDFs) verarbeiten und sogar komplexe Entwicklungsaufgaben über das Terminal automatisieren. Das Tool ist leichtgewichtig, modular und unterstützt benutzerdefinierte Konfigurationen, so dass es von Entwicklern in lokalen oder Produktionsumgebungen eingesetzt werden kann. Das Projekt wird auf GitHub gehostet und verfügt über eine aktive Community, eine detaillierte Dokumentation und einen einfachen Einstieg.

Funktionsliste

- Unterstützt eine breite Palette von großen Sprachmodellen, einschließlich Gemini, OpenAI, Claude, Qwen und anderen.

- Bietet eine Befehlszeilenschnittstelle zur schnellen Texterstellung, Beantwortung von Fragen oder Verarbeitung von Eingaben.

- Unterstützt multimodale Eingaben und kann auch Nicht-Text-Inhalte wie Bilder und PDFs analysieren.

- Bietet Funktionen zur Codeanalyse, um Codekommentare zu erzeugen oder Änderungen an der Codebasis zusammenzufassen.

- Unterstützung für automatisierte Arbeitsabläufe wie die Verarbeitung von Git-Commits, die Erstellung von Berichten oder Diagrammen.

- Ermöglicht eine kundenspezifische Modellkonfiguration und einen flexiblen Wechsel der LLM-Anbieter über Umgebungsvariablen.

- etw. unterstützen MCP Server, die Verbindung mit externen Tools zur Erweiterung der Funktionalität.

- Open-Source-Projekt mit Unterstützung für Beiträge der Gemeinschaft und lokalen Einsatz.

Hilfe verwenden

Einbauverfahren

Um easy-llm-cli lokal zu verwenden, müssen Sie die folgenden Installationsschritte durchführen. Stellen Sie sicher, dass Ihr System die Mindestanforderungen erfüllt: Node.js 20 oder höher.

- Installation von Node.js

Interviews Node.js offizielle Website Laden Sie Node.js herunter und installieren Sie es (empfohlene Version 20.x oder höher). Führen Sie den folgenden Befehl aus, um die Version zu überprüfen:node -v

2. **快速运行 CLI**

无需克隆仓库,可直接通过 npx 运行:

```bash

npx easy-llm-cli

Dadurch wird das Tool automatisch heruntergeladen und für eine kurze Testphase gestartet.

3. Globale Installation (empfohlen)

Wenn Sie vorhaben, das Programm über einen längeren Zeitraum zu nutzen, empfiehlt es sich, es global zu installieren:

npm install -g easy-llm-cli

Führen Sie nach Abschluss der Installation den folgenden Befehl aus, um das Programm zu starten:

elc

- Installation von der Quelle aus (optional)

Wenn Sie Anpassungen vornehmen oder Code beisteuern möchten, können Sie das Repository klonen:git clone https://github.com/ConardLi/easy-llm-cli.git cd easy-llm-cli npm install npm run start - API-Schlüssel konfigurieren

easy-llm-cli muss mit dem API-Schlüssel des LLM-Anbieters konfiguriert werden. Verwenden Sie zum Beispiel die API von OpenAI:export CUSTOM_LLM_PROVIDER="openai" export CUSTOM_LLM_API_KEY="sk-xxxxxxxxxxxxxxxxxxxx" export CUSTOM_LLM_ENDPOINT="https://api.openai.com/v1" export CUSTOM_LLM_MODEL_NAME="gpt-4o-mini"将

sk-xxxxxxxxxxxxxxxxxxxxersetzen Sie ihn durch Ihren eigentlichen Schlüssel. Den eigentlichen Schlüssel finden Sie in der.bashrc或.zshrcum diese Befehle zur dauerhaften Konfiguration hinzuzufügen. - Docker-Installation (optional)

Wenn Sie die Bereitstellung in Containern bevorzugen, können Sie Docker verwenden:docker build -t easy-llm-cli . docker run -d -p 1717:1717 --name easy-llm-cli easy-llm-cliStellen Sie sicher, dass der Anschluss

1717Unbesetzt.

Hauptfunktionen

Der Kern von easy-llm-cli ist der Aufruf des großen Sprachmodells über die Kommandozeile für Textgenerierung, Codeanalyse und Automatisierungsaufgaben. Im Folgenden wird detailliert beschrieben, wie dies zu bewerkstelligen ist:

1. die Texterstellung

Führen Sie den folgenden Befehl aus, um den Text zu erstellen:

elc "写一篇 200 字的 Python 简介"

- Betriebsanleitung:

elcist der Startbefehl für das Werkzeug, gefolgt von einer Eingabeaufforderung. Das konfigurierte Modell (z. B. Gemini oder OpenAI) wird standardmäßig verwendet. Sie können das Modell über Umgebungsvariablen wechseln. - AusfuhrenDas Modell liefert ein Python-Profil mit 200 Wörtern in einem übersichtlichen Format.

2. die Code-Analyse

Führen Sie den folgenden Befehl im Projektverzeichnis aus, um die Codebasis zu analysieren:

cd my-project

elc "总结昨天的 Git 提交记录"

- BetriebsanleitungDas Tool durchsucht den Git-Verlauf des aktuellen Verzeichnisses und erstellt eine Zusammenfassung der Commits.

- AusfuhrenRückgabe von Einreichungsanweisungen, gruppiert nach Zeit oder Funktion.

3. multimodale Eingaben

easy-llm-cli unterstützt die Verarbeitung von Bildern oder PDFs, z.B. die Extraktion von Text aus PDFs:

elc "提取 PDF 中的文本" -f document.pdf

- Betriebsanleitung:

-fParameter gibt den Dateipfad an. Unterstützte Formate sind PDF und Bilder (JPEG, PNG usw.). - AusfuhrenText: Gibt den extrahierten Textinhalt zurück.

4. automatisierte Arbeitsabläufe

Über den MCP-Server kann das Tool eine Verbindung zu externen Systemen herstellen. Zum Beispiel, um Git-Historiendiagramme zu erstellen:

elc "生成过去 7 天的 Git 提交柱状图"

- BetriebsanleitungSie müssen den MCP-Server konfigurieren (z. B.

@antv/mcp-server-chart). Das Tool ruft das Modell auf, um die Diagrammdaten zu erzeugen, und stellt sie über MCP dar. - AusfuhrenBalkengrafik: Gibt Daten oder Visualisierungsergebnisse zurück.

5. kundenspezifische Modellkonfiguration

Mit Hilfe von Umgebungsvariablen können Sie zu anderen Modellen, wie z. B. Claude, wechseln:

export CUSTOM_LLM_PROVIDER="openrouter"

export CUSTOM_LLM_API_KEY="your-openrouter-key"

export CUSTOM_LLM_MODEL_NAME="claude-sonnet-4"

elc "分析这段代码的功能" < myfile.py

- BetriebsanleitungNachdem Sie die Umgebungsvariablen gesetzt haben, führen Sie den Befehl zum Modellwechsel aus.

- Ausfuhren: Rückkehr Claude Modellanalyse des Codes.

Featured Function Bedienung

1. multimodale Unterstützung

easy-llm-cli unterstützt die Verarbeitung von multimodalen Eingaben wie Bildern, PDFs usw. Zum Beispiel bei der Erstellung von Bewerbungsentwürfen:

elc "根据 sketch.jpg 生成 Web 应用代码" -f sketch.jpg

- BetriebsanleitungLaden Sie eine Designskizze hoch, und das Modell generiert den entsprechenden HTML/CSS/JavaScript-Code.

- AusfuhrenRückgabe des vollständigen Webanwendungscode-Frameworks.

2. automatisierte Aufgaben

Werkzeuge können komplexe Entwicklungsaufgaben bewältigen. Zum Beispiel die Automatisierung von Git-Vorgängen:

elc "处理 GitHub Issue #123 的代码实现"

- BetriebsanleitungDas Tool liest die Problembeschreibung, generiert den Implementierungscode und sendet einen Pull Request ein.

- AusfuhrenRückgabe des generierten Codes und des PR-Links.

3. programmatische Integration

Entwickler können easy-llm-cli in ihren Code integrieren. Zum Beispiel mit Node.js:

import { ElcAgent } from 'easy-llm-cli';

const agent = new ElcAgent({

model: 'gpt-4o-mini',

apiKey: 'your-api-key',

endpoint: 'https://api.openai.com/v1'

});

const result = await agent.run('生成销售数据的柱状图');

console.log(result);

- Betriebsanleitung: durch

ElcAgentKlassenaufrufmodell, geeignet für die Einbettung in Automatisierungsskripte. - AusfuhrenRückgabe der Ergebnisse der Verarbeitung, z. B. Diagrammdaten.

caveat

- Vergewissern Sie sich, dass der API-Schlüssel gültig ist und dass die Netzwerkverbindung stabil ist.

- Multimodale Funktionalität erfordert Modellunterstützung (siehe offizielles Testformular). Zum Beispiel, Gemini-2.5-pro und die GPT-4.1 unterstützt Multimodalität, während einige Modelle wie DeepSeek-R1 Keine Unterstützung.

- Wenn Sie komplexe Aufgaben ausführen, prüfen Sie die

CUSTOM_LLM_MAX_TOKENSausreichend ist (Standardwert 8192). - Wenn Sie auf Probleme stoßen, überprüfen Sie die Dokumentation zur Fehlersuche Oder laufen:

elc logs

Anwendungsszenario

- Analyse der Codebasis

Entwickler können das neue Projekt ausführenelc "描述系统架构"schnell die Codestruktur zu verstehen, geeignet für die Übernahme von unbekannten Projekten. - Generierung von Anwendungsprototypen

Der Designer lädt eine Skizze oder eine PDF-Datei hoch, führtelc "生成 Web 应用"erhalten Sie schnell einen lauffähigen Code-Prototyp. - DevOps-Aufgaben automatisieren

DevOps-Ingenieure könnenelc "生成最近 7 天的 Git 提交报告"Erfasst automatisch den Fortschritt der Arbeit des Teams. - Dateiverarbeitung

Forscher können Folgendes nutzenelc "提取 PDF 中的关键信息" -f paper.pdfden Inhalt von akademischen Dokumenten schnell zu organisieren.

QA

- Welche Modelle werden von easy-llm-cli unterstützt?

Unterstützt Gemini, OpenAI, Claude, Qwen und viele andere sowie jedes benutzerdefinierte Modell, das dem OpenAI-API-Format folgt. Siehe das offizielle Testformular für Details. - Wie behandelt man multimodale Eingaben?

ausnutzen-fum ein Bild oder eine PDF-Datei hochzuladen, zum Beispielelc "提取文本" -f file.pdf. Stellen Sie sicher, dass das Modell Multimodalität unterstützt (z. B. Gemini-2.5-pro). - Brauche ich eine kostenpflichtige API?

Remote-Modelle erfordern einen gültigen API-Schlüssel (z. B. einen kostenpflichtigen Schlüssel für OpenAI oder OpenRouter). Für lokale Modelle wie Qwen2.5-7B-Instruct sind keine zusätzlichen Gebühren erforderlich. - Wie kann ich Fehler beheben?

in Bewegung seinelc logsSehen Sie sich das Protokoll an, oder besuchen Sie Dokumentation zur Fehlersuche Holen Sie sich Hilfe.