Beginnen wir mit einer einfachen Aufgabe: der Planung einer Besprechung.

Wenn ein Nutzer sagt: "Hey, lass uns mal sehen, ob wir morgen eine schnelle Synchronisierung hinbekommen.

Eine KI, die sich nur auf Prompt Engineering verlässt, könnte antworten: "Ja, morgen ist gut. Um wie viel Uhr möchten Sie es denn bitte ansetzen?" Diese Antwort ist zwar korrekt, aber mechanisch und wenig hilfreich, weil ihr das Verständnis für die reale Welt fehlt.

Stellen Sie sich nun eine andere KI vor. Sie sieht nicht nur den Satz, wenn sie dieselbe Anfrage erhält, sondern sie hat auch unmittelbaren Zugang zu einer reichhaltigen Informationsumgebung: Ihr Kalender zeigt, dass der morgige Terminplan voll ist; die E-Mail-Historie mit der anderen Person deutet darauf hin, dass Ihr Kommunikationsstil informell ist; die Kontaktliste kennzeichnet die andere Person als wichtigen Partner; und die KI hat instrumentellen Zugang, um Einladungen zu Treffen und E-Mails direkt zu versenden.

Dann würde es mit etwas wie "Hey Jim! Ich habe nachgeschaut, und mein Terminplan ist morgen komplett voll. Am Donnerstagmorgen scheint ein Termin frei zu sein, würde Ihnen das passen? Wenn das in Ordnung ist, schicke ich einfach eine Einladung.

Der Unterschied liegt nicht darin, dass das zweite KI-Modell per se "intelligenter" ist, sondern darin, dass es in einem umfassenderen "Kontext" steht. Dieser Paradigmenwechsel von der Optimierung einer einzelnen Anweisung hin zum Aufbau dynamischer Informationsumgebungen ist die wichtigste Entwicklung in der heutigen KI-Anwendungsentwicklung - vom Hint Engineering zum Context Engineering.

Was ist kontextbezogene Technik?

Andrej Karpathy bietet eine hervorragende Analogie: Das Large Language Model (LLM) ist wie eine neue Art von Betriebssystem, und sein Kontextfenster ist RAM. Die Kernaufgabe des Contextual Engineering besteht darin, diesen Arbeitsspeicher effizient zu verwalten und vor jeder Operation die wichtigsten Informationen einzugeben.

Eine technischere Definition lautet:Contextual Engineering ist die Disziplin der Entwicklung und des Aufbaus dynamischer Systeme, die die richtigen Informationen und Werkzeuge zur Problemlösung im richtigen Format und zur richtigen Zeit für ein großes Sprachmodell bereitstellen.

Der "Kontext", den es verwaltet, ist ein dreidimensionales, siebendimensionales System:

- Anweisungen. Definition von Hinweisen auf Systemebene für KI-Verhaltenskodex und Identität.

- Benutzeraufforderung. Spezifische Probleme oder Aufgaben, die von Nutzern aufgeworfen werden.

- Kurzzeitgedächtnis (Zustand / Geschichte). Die Interaktionshistorie des aktuellen Dialogs sichert die Kontinuität des Dialogs.

- Langfristiges Gedächtnis. Beständiges Wissen über mehrere Konversationen hinweg, z. B. Benutzerpräferenzen.

- Abgerufene Informationen. Extern erworbenes Wissen in Echtzeit durch Techniken wie RAG.

- Verfügbare Tools. Eine Liste von Funktionen oder APIs, die die KI aufrufen kann.

- Strukturierte Ausgabe. Definition des AI-Ausgabeformats, z. B. eine Anfrage zur Rückgabe von JSON.

Warum ist der Kontext so entscheidend? Die vier Arten des Scheiterns

Wenn ein Agentensystem schlecht funktioniert, liegt die Ursache häufig in einem Problem mit der Kontextverwaltung. Ein zu langer oder minderwertiger Kontext führt in der Regel zu den folgenden vier Fehlerarten:

- Kontext-Vergiftung. Falsche oder durch Modellillusionen erzeugte Informationen gelangen in den Kontext und verunreinigen nachfolgende Entscheidungen.

- Ablenkung durch den Kontext. Zu viele irrelevante Informationen überlagern die Kernanweisungen und führen dazu, dass das Modell von den Missionszielen abweicht.

- Kontext-Verwirrung. Einige zweideutige oder unnötige Details im Kontext beeinträchtigen die Genauigkeit der endgültigen Ausgabe.

- Context Clash. Es gibt faktische oder logische Widersprüche in verschiedenen Teilen des Kontextes.

Um diese Herausforderungen systematisch anzugehen, haben die Entwickler vier Kernstrategien für das Kontextmanagement entwickelt.

Kernstrategie für Contextual Engineering

1. schreiben: Speichert Informationen auf einem externen Speicher.

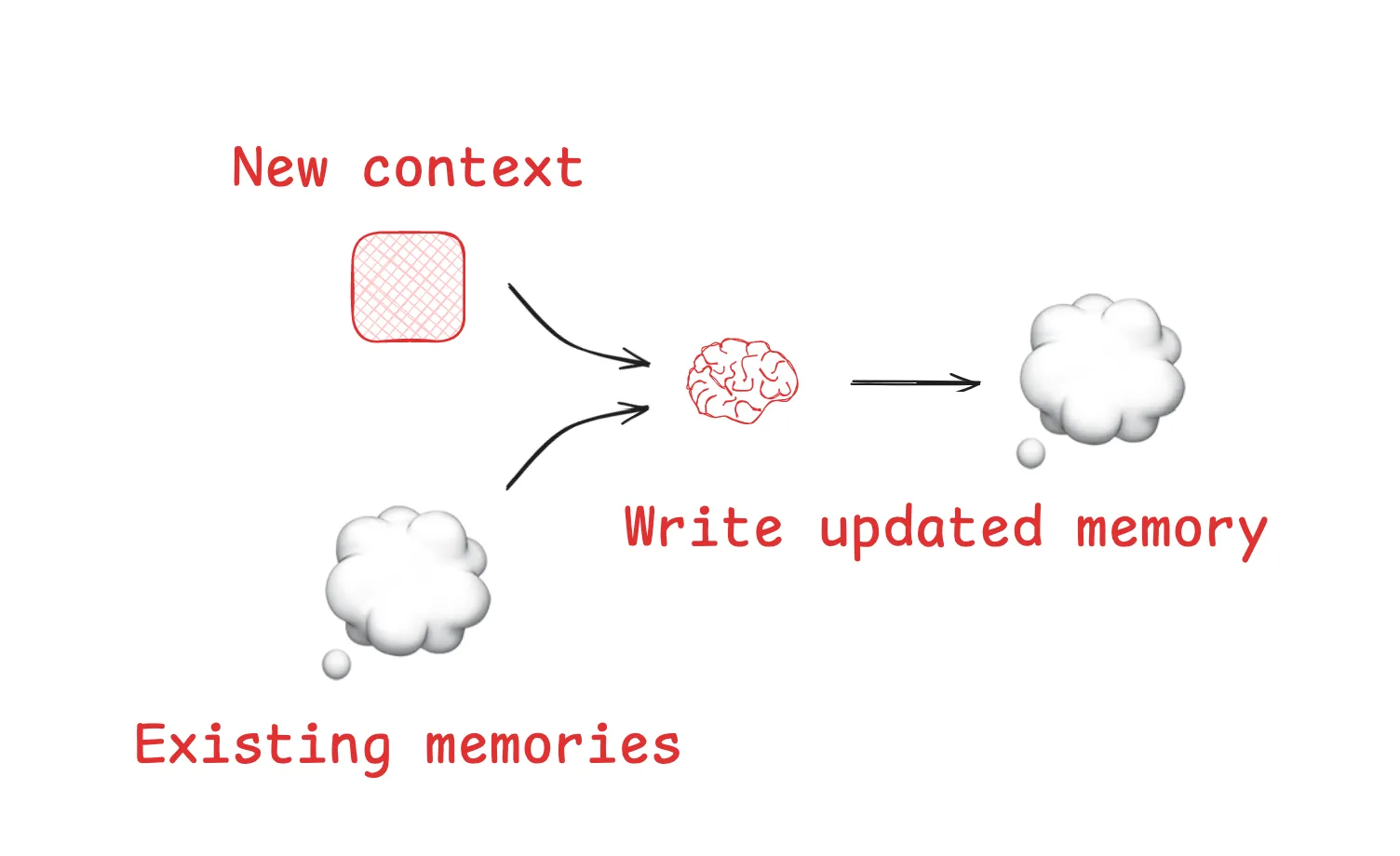

"Schreiben" soll dem Agenten die Möglichkeit geben, Notizen zu machen und wichtige Informationen außerhalb eines begrenzten Kontextfensters zu speichern.

- Kratzpads. Eine Art des Kurzzeitgedächtnisses innerhalb einer Aufgabe. Zum Beispiel.

AnthropicDie Studie zeigte, dass ihreLeadResearcherDer Agent "schreibt" den durchdachten Plan in den externen Speicher, bevor er komplexe Aufgaben ausführt, um zu verhindern, dass der Kernplan aufgrund von Kontextüberlastung verloren geht. - Erinnerungen. Ermöglicht es dem Agenten, Informationen über mehrere Sitzungen hinweg zu speichern. Wie der

ChatGPTSpeicherfunktion, sowie EntwicklungswerkzeugeCursor和Windsurfin allen enthalten Mechanismen zur automatischen Erzeugung und Bewahrung von Langzeitspeichern auf der Grundlage von Benutzerinteraktionen.

2. auswählen: zieht bei Bedarf relevanten Kontext in das Fenster

"Auswahl" ist dafür zuständig, aus der riesigen Menge an externen Informationen die wichtigsten Teile der aktuellen Aufgabe herauszufiltern und zum richtigen Zeitpunkt im Kontextfenster zu platzieren.

- Auswahl aus einer bestimmten Datei:. Einige ausgereifte Agenten erhalten Kontext, indem sie bestimmte Dateien lesen. Zum Beispiel.

Claude Codewird lesenCLAUDE.mdDatei und dieCursorStattdessen werden Regeldateien verwendet, um Kodierungsspezifikationen zu laden, was eine effiziente Art der Auswahl des "prozeduralen Speichers" ist. - Wählen Sie aus dem Toolset. Wenn die Zahl der verfügbaren Werkzeuge sehr hoch ist, wird die Verwendung von RAG Die Technologie ruft dynamisch die für die jeweilige Aufgabe relevantesten Werkzeuge ab und "wählt" sie aus, wodurch die Genauigkeit der Werkzeugauswahl um ein Vielfaches erhöht wird.

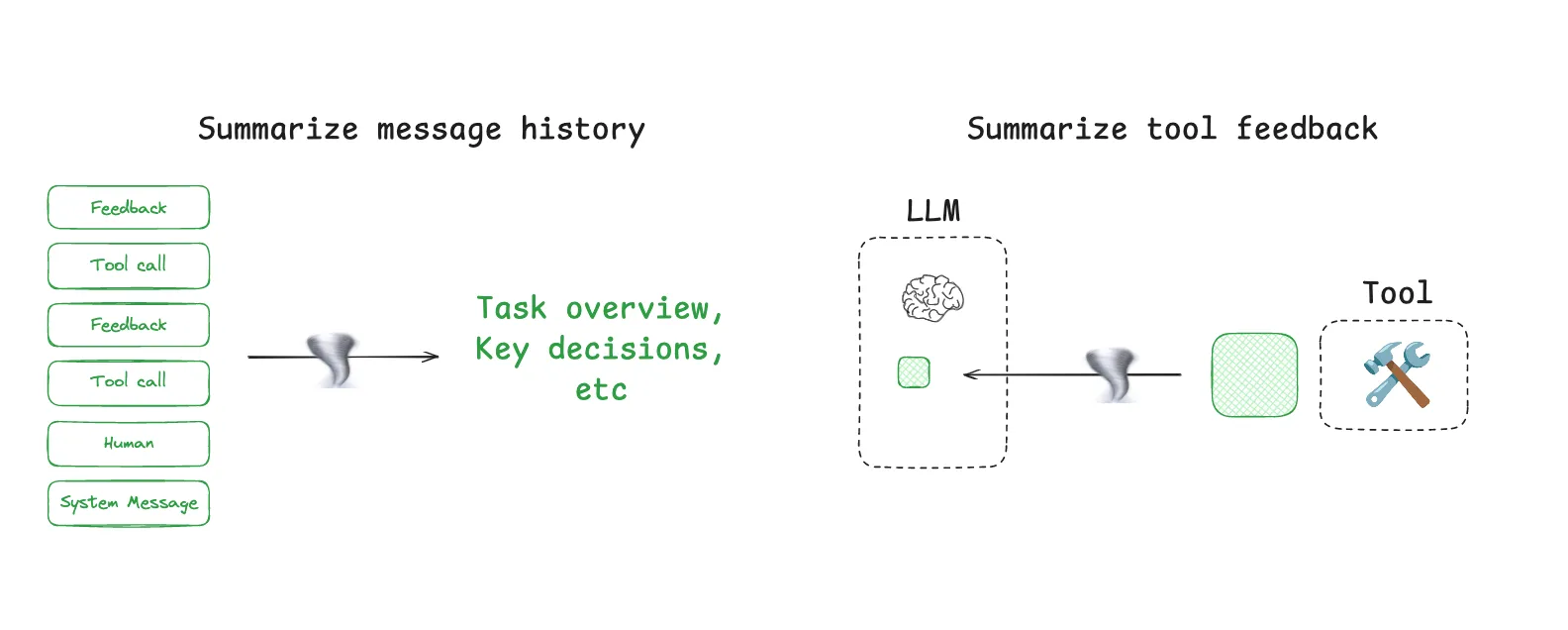

3. komprimieren: das Wesentliche behalten, Redundanz reduzieren

Die "Komprimierung" zielt darauf ab, die Anzahl der vom Kontext belegten Token zu reduzieren, ohne dabei wichtige Informationen zu verlieren.

- Kontext-Zusammenfassung. Wenn der Dialogverlauf zu lang wird, kann LLM aufgerufen werden, um ihn zusammenzufassen.

Claude CodeEin typisches Beispiel hierfür ist die Funktion "Auto-Compact", die automatisch den gesamten Gesprächsverlauf zusammenfasst, wenn die Kontextnutzung 95% überschreitet. - Beschneiden des Kontexts. Ein regelbasierter Filter. Der einfachste Ansatz besteht darin, einfach die frühesten Dialogrunden zu entfernen, während fortgeschrittenere Ansätze speziell trainierte "Context Pruner"-Modelle verwenden, um unwichtige Informationen zu identifizieren und zu entfernen.

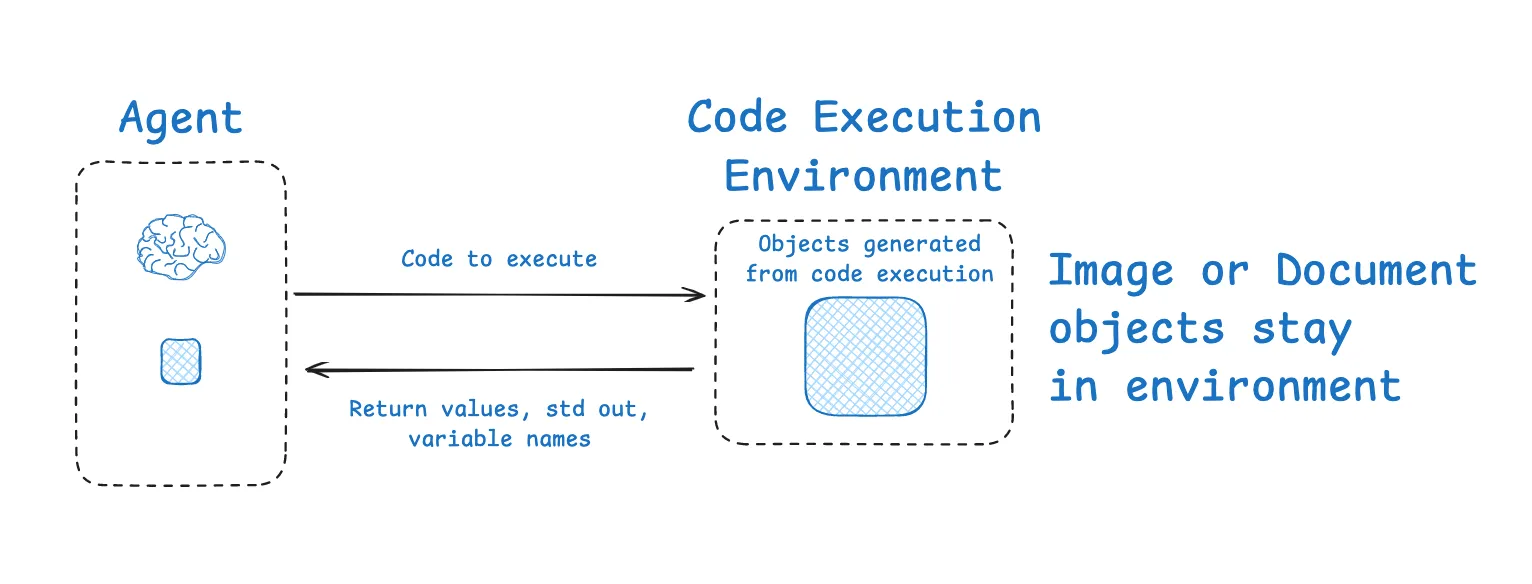

4. isolieren: Aufteilung von Kontexten zur Bewältigung komplexer Aufgaben

Der Kerngedanke der "Isolation" ist das "Teilen und Erobern", d. h. die Aufteilung einer großen Aufgabe, so dass verschiedene Kontexte in isolierten Umgebungen bearbeitet werden.

- Multi-Agent. Zerlegen Sie komplexe Aufgaben in mehrere Expertenagenten mit unabhängigen Kontextfenstern.

Anthropicfanden heraus, dass Teams aus mehreren parallel arbeitenden Subagenten bei einer Forschungsaufgabe einem einzelnen Agenten mit großem Kontext weit überlegen sind. - Sandboxing-Umgebungen. Bei Aufgaben vom Typ Codeausführung kann der Ausführungsprozess in einer Sandbox isoliert werden.

HuggingFace的CodeAgentist ein Beispiel, bei dem LLM für die Generierung des Codes verantwortlich ist. Nachdem der Code in der Sandbox ausgeführt wurde, werden nur die kritischsten Ausführungsergebnisse an den Kontext von LLM zurückgegeben, nicht das vollständige Ausführungsprotokoll.

Werkzeuge für kontextuelles Engineering: LangGraph und LangSmith

Um die oben beschriebenen komplexen Strategien zu verwirklichen, ist ein ausreichend flexibler und kontrollierbarer Rahmen erforderlich.LangChain im Ökosystem LangGraph 和 LangSmith Zu diesem Zweck ist eine starke Unterstützung vorgesehen.

LangGraph ist ein Low-Level-Framework für den Aufbau kontrollierter Agenten. Es baut den Arbeitsablauf eines Agenten als Zustandsdiagramm auf und ist so konzipiert, dass es perfekt auf die Bedürfnisse der kontextuellen Entwicklung abgestimmt ist:

- Staatliches Objekt. Dient als perfekter "Staging-Bereich" (für Schreibvorgänge) und kontextbezogener "Isolationsbereich". Sie können verschiedene Felder im Status definieren, von denen einige für den LLM sichtbar sind und einige intern sind und "selektiv" nach Bedarf verwendet werden.

- Persistenz und Gedächtnis. Die integrierten Checkpointing- und Speichermodule erleichtern das "Schreiben" und "Auswählen" von Kurz- und Langzeitspeichern.

- Anpassbare Knotenpunkte. Jeder Knoten im Diagramm ist ein programmierbarer Schritt. Sie können in den Knoten problemlos eine "Verdichtungslogik" implementieren, z. B. die Zusammenfassung der Ergebnisse unmittelbar nach dem Aufruf eines Werkzeugs.

- Multi-Intelligente Körperarchitektur.

LangGraphInformationen liefern, wie zum Beispielsupervisor和swarmBibliotheken wie das CMS unterstützen von Haus aus den Aufbau komplexer Multi-Intelligenz-Systeme und ermöglichen eine kontextuelle "Isolierung".

LangSmith Es ist eine Observability-Plattform. Sie ermöglicht es Ihnen, jeden Schritt des Entscheidungsfindungsprozesses eines Agenten eindeutig nachzuvollziehen, als ob Sie eine normale Anwendung debuggen würden, und genau zu sehen, welche Informationen im Kontextfenster für jeden LLM-Aufruf enthalten sind. Dies bietet unverzichtbare Einblicke für die Diagnose und Optimierung von kontextbezogenem Engineering und die Möglichkeit, die Wirksamkeit von Optimierungsstrategien durch die Eval-Funktion zu validieren.

Von der "Alchemie" des Cue Engineering zur "Systemwissenschaft" des Contextual Engineering ist dies nicht nur die Evolution der Technologie, sondern auch der unvermeidliche Weg zur Entwicklung zuverlässiger und leistungsstarker KI-Anwendungen. Die Beherrschung dieser Kunst, sowie die LangGraph 和 LangSmith Tools wie diese werden zu einer Kernkompetenz für KI-Ingenieure.