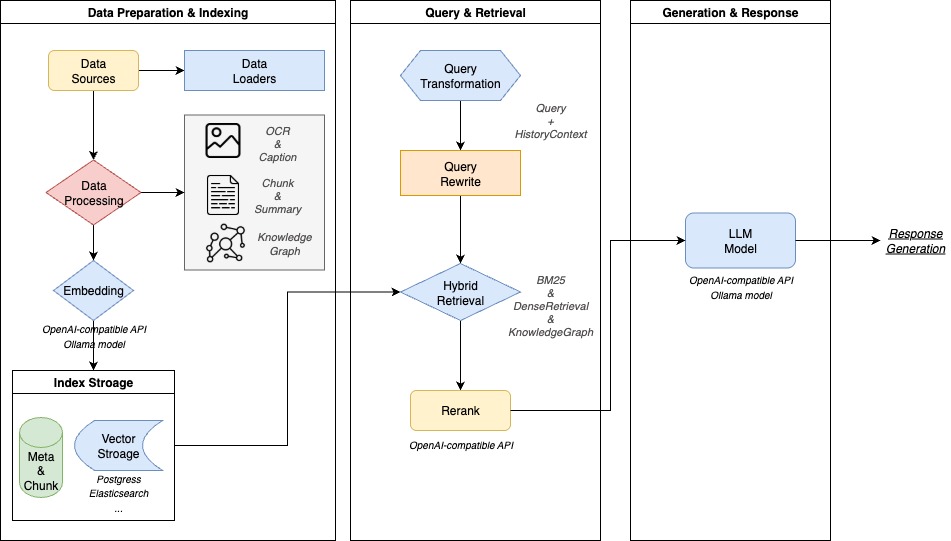

WeKnora は、Tencent によってオープンソース化されたエンタープライズクラスのドキュメント理解と検索 Q&A フレームワークです。 WeKnora のコアは、拡張生成 (RAG) 技術で、より正確で、より事実に近い回答を生成するために、ドキュメントのコンテキストスニペットと大規模な言語モデルの組み合わせから取得されます。フレームワーク全体は、完全かつ効率的な文書Q&Aプロセスを形成するために、文書の解析、コンテンツのリコール、モデルの推論を分離するモジュール設計を採用しています。 ユーザーは、直感的なウェブインタフェースを通じて文書管理とインテリジェントQ&Aを行うことができるだけでなく、APIインタフェースを通じて二次開発と統合を行うこともできます。このフレームワークはプライベートな展開をサポートし、企業データのセキュリティとコントロールを保証します。

機能一覧

- マルチモーダル文書分析PDF、Word、画像、その他の文書を正確に解析し、テキスト、表、画像のセマンティクスを抽出します。

- モジュール式RAG組立ライン検索ストラテジー、大規模言語モデル、ベクトルデータベースの自由な組み立てをサポートし、Ollamaのようなプラットフォームとシームレスに統合し、QwenやDeepSeekのような主流モデルを柔軟に切り替えることができる。

- 知的推理クイズ大きな言語モデルを用いてユーザーの意図とドキュメントのコンテキストを理解し、的確なQ&Aや多ラウンド対話をサポートします。

- 柔軟な検索戦略キーワード検索、ベクトル検索、ナレッジグラフ検索などのストラテジーをミックスして使用し、自由な組み合わせをサポートすることで、想起結果の精度を高めている。

- 既成概念にとらわれない経験ワンクリック・スタートアップ・スクリプトと直感的なWeb UIインターフェイスを提供し、技術者でないユーザーでもデプロイメントとアプリケーションを迅速に完了できます。

- 安全で制御された展開ローカライズされたプライベートクラウドのデプロイメントをサポートし、完全なリンク観測性を実現する監視ロギングシステムを内蔵しているため、ユーザーのデータは完全にユーザーの管理下に置かれる。

- ナレッジグラフ構築文書内容をナレッジグラフに変換し、情報間のつながりを視覚的に示すことで、ユーザーの理解と詳細な検索を支援する機能。

- 豊富なモデルをサポート幅広い埋め込みモデル(BGE/GTEなど)、ベクトルデータベース(PostgreSQL、Elasticsearchなど)、主流の大規模言語モデルに対応。

ヘルプの使用

WeKnoraはツールチェーン一式を提供し、Dockerを通してワンクリックでデプロイと起動を実現し、ユーザーは複雑な設定なしにローカル環境でシステム全体を実行することができ、すぐに本番環境を実現することができます。

環境要件

インストールを開始する前に、以下の3つの基本的なツールがコンピュータにインストールされていることを確認してください:

Dockerアプリケーション・コンテナの管理と実行に使用される。Docker Compose複数のコンテナを持つDockerアプリケーションを定義し、実行するために使用します。GitGitHubからコードリポジトリをクローンする。

インストールとスタートアップ・プロセス

- クローン・コード・リポジトリ

まず、ターミナル(コマンドラインツール)を開いてgitコマンドを使って、公式WeKnoraコードベースをあなたのローカルコンピュータにクローンしてください。git clone https://github.com/Tencent/WeKnora.git - プロジェクト・ディレクトリに移動する

クローニングが完了したら、プロジェクトのあるフォルダに移動する。cd WeKnora - 環境変数の設定

WeKnoraはこれを可能にした。.envファイルでプロジェクトのすべての環境変数を管理します。プロジェクトで提供されるサンプル・ファイルをコピーすることで、独自の設定ファイルを作成することができます。cp .env.example .env ``` 复制后,你可以用文本编辑器打开`.env`文件,根据文件内的注释说明,填入你自己的配置信息。对于初次使用者,可以暂时跳过此步骤,直接启动服务,后续通过Web界面进行配置。 - ワンクリック・スタート・サービス

このプロジェクトは、Ollama(ローカルのビッグモデル管理用)やWeKnoraのバックエンドサービスなど、必要なサービスを一度に起動する便利なスタートアップスクリプトを提供している。./scripts/start_all.shを使用することもできます。

makeコマンドで同じ効果が得られる:make start-allターミナルにサービスが正常に開始されたことが表示されたら、使用を開始できます。

- ウェブインターフェースへのアクセス

起動に成功したら、ブラウザで以下のアドレスにアクセスしてください:- メイン・ウェブ・インターフェイス:

http://localhost - バックエンドAPIドキュメント:

http://localhost:8080 - リンクトレース・システム(イェーガー):

http://localhost:16686(開発者が内部システムコールを監視するために使用)

- メイン・ウェブ・インターフェイス:

初期化モデルの構成

初めての方はhttp://localhostそうすると、システムは自動的に初期化設定ページにジャンプします。このページは、グラフィカルなインターフェースを通じて、大規模言語モデルや組み込みモデルなどの主要コンポーネントの設定を完了するのに役立ち、手動で設定ファイルを修正する複雑さを軽減します。ページ上のプロンプトに従い、正しいモデルAPIアドレス、キー、その他の情報を入力してください。完了後、システムは自動的に保存され、ナレッジベースのホームページにジャンプします。

機能 操作の流れ

- 知識ファイルのアップロード

ウェブインターフェースの知識ベース管理ページでは、ファイルを直接ドラッグ&ドロップするか、アップロードボタンをクリックすることで、ドキュメント(製品マニュアル、社内規定、調査レポートなど)をシステムにアップロードすることができます。 システムは自動的にドキュメントの解析、コンテンツの抽出、ベクトルインデックスの作成を開始し、処理の進捗状況とステータスがインターフェイス上に明確に表示されます。 - 知的な質疑応答の実施

書類が処理されると、Q&A画面にアクセスできます。入力ボックスで質問してください。または、"この製品はどのように失敗を処理しますか?"..質問内容に基づいて、システムはアップロードされた知識ベースから最も関連性の高い文書を意味検索し、大規模な言語モデルを使ってスムーズで正確な回答を生成します。回答には引用が付きますので、情報の出典をたどることができます。 - ナレッジグラフの使用

複雑な構造を持つ文書については、ナレッジグラフ機能をオンにすることができます。システムは、文書内のさまざまな段落やエンティティ間の関係を分析し、グラフの形で視覚的に表示します。これにより、ドキュメントの内部ロジックをより深く理解できるだけでなく、システムにより構造化された検索基盤を提供し、Q&Aの関連性を向上させます。 - サービスの中止

終了したら、以下のスクリプトを実行して、すべてのサービスを停止することができる:./scripts/start_all.sh --stopまたは

make命令だ:make stop-all

アプリケーションシナリオ

- 企業知識管理

企業内に散在する社内文書、規程、業務マニュアルなどのナレッジドキュメントを統合し、スマートQ&Aポータルを構築する。これにより、従業員の情報検索効率を向上させ、社内教育のコストを削減することができる。 - 科学文献の分析

研究者は、膨大な量の学術文献、研究報告書、学術資料を素早く選別し、意味を理解するために利用することができます。これにより、予備的な文献調査を迅速化し、研究の意思決定を支援します。 - 製品テクニカルサポート

製品の技術マニュアルやよくある質問をシステムに入力することで、24時間対応のオンライン・インテリジェント・カスタマーサービスを構築できる。製品の特徴やトラブルシューティングなど、ユーザーからの質問に迅速に対応し、顧客サービスの質を向上させることができる。 - 法令遵守のレビュー

法律分野では、弁護士や法務担当者が膨大な数の契約条項、規則、ポリシー、判例から重要な情報を素早く探し出し、コンプライアンス・レビューの効率を向上させるのに役立ちます。 - 金融投資調査分析

金融アナリストは、多数の企業の決算報告書、業界調査報告書、市場発表を処理し、投資判断に役立つ重要なデータや意見を迅速に抽出するために使用することができます。

QA

- WeKnoraはどのような大規模言語モデルをサポートしていますか?

WeKnoraは、Qwen(Tongyi Thousand Questions)やDeepSeekなど、様々な主流の大規模言語モデルをサポートしています。Ollamaのようなプラットフォームを通してモデルを管理し、ユーザーは外部のAPIサービスにアクセスすることもできます。 - WeKnoraの導入に費用はかかりますか?

WeKnoraプロジェクト自体はMITライセンスに基づくオープンソースであり、商用目的であっても自由に使用、変更、配布することができます。ただし、サードパーティの大規模言語モデルAPIサービスを利用する場合、設定に支払いが必要な場合は、対応するモデルプロバイダから料金を請求されます。 - 技術者でなくてもこのフレームワークを使えるのか?

WeKnoraは "すぐに使える "ウェブインターフェイスとワンクリックで起動するスクリプトを提供し、ユーザーはコードを書くことなく、敷居を低くして、ファイルをドラッグ&ドロップし、ボタンをクリックすることで知識をアップロードし、クイズを実施することができます。 - アップロードされた文書データは安全ですか?

weKnoraはローカライズされたプライベートクラウドのデプロイメントをサポートしており、Q&Aシステム全体をお客様のサーバーまたはローカルコンピュータ上で実行することができます。アップロードされたすべてのドキュメントとデータは、お客様の管理下にあり、外部サーバーにアップロードされることはありません。