Together AIは、生成AIモデルに特化したプラットフォームであり、モデルの学習から微調整、推論に至るまで、あらゆるサービスを提供しています。ユーザーは、Together AIの非常に効率的な推論エンジンとGPUクラスターを活用して、さまざまなオープンソースモデルを迅速に展開し、実行することができます。このプラットフォームは、さまざまなAIアプリケーションの要件を満たすために、複数のモデル・アーキテクチャをサポートしています。

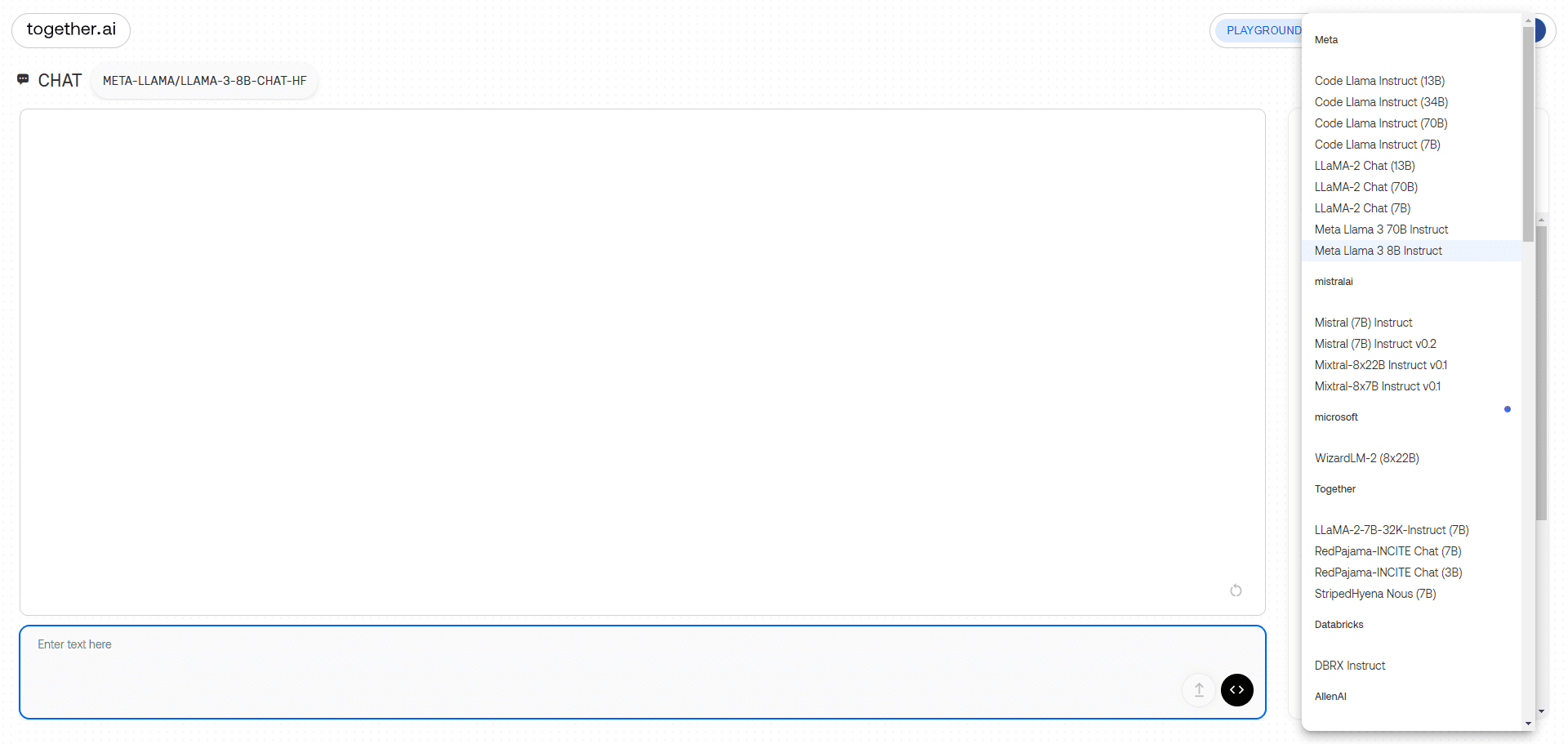

大型モデル・チャット・デモ・インターフェース

機能一覧

- 推論API100以上のオープンソースモデルの推論をサポートし、サーバーレスモデルと専用インスタンスモデルの両方を提供します。

- 微調整機能データの所有権を維持したまま、ユーザーが自分のデータを使って生成AIモデルを微調整できるようにする。

- GPUクラスタ16から1000以上のGPUからなる最先端のクラスタを提供し、大規模なモデルトレーニングをサポートします。

- カスタムモデルのトレーニング最先端のモデルをゼロからトレーニングし、複数のモデルアーキテクチャをサポートします。

- マルチモーダルモデル画像認識、画像推論、画像生成などをサポート。

- 効率的な推論エンジンFlashAttention-3やFlash-Decodingなどの最新の推論技術を統合し、高速で正確な推論サービスを提供します。

ヘルプの使用

インストールと使用

- 登録とログイン:

- Together AIのウェブサイト(https://www.together.ai/)にアクセスし、「Start Building」ボタンをクリックして登録する。

- 登録が完了したら、アカウントにログインし、ユーザーコントロールパネルに移動します。

- セレクト・サービス:

- コントロールパネルで、推論API、微調整機能、GPUクラスタなど、使用するサービスモジュールを選択します。

- 必要に応じてサーバーレスまたは専用インスタンスモードを選択する。

- 推論APIの使用:

- Llama-3、RedPajamaなど、実行するオープンソースモデルを選択します。

- Together AI が提供する API インタフェースを通じて、モデルをアプリケーションに統合します。

- Together AI の組み込みエンドポイントを使用して、独自の RAG アプリケーションを構築します。

- 微調整機能:

- データセットをアップロードし、微調整が必要なモデルを選択します。

- 微調整パラメータを設定し、微調整プロセスを開始する。

- 微調整が完了したら、微調整したモデルをダウンロードし、デプロイする。

- GPUクラスタの使用状況:

- 希望するGPUクラスタサイズを選択し、ハードウェアパラメータを設定します。

- トレーニングデータとモデルコードをアップロードしてトレーニングを開始します。

- 学習が完了すると、学習済みモデルは推論やさらなる微調整のためにダウンロードされる。

- カスタムモデルのトレーニング:

- カスタムモデルトレーニングモジュールを選択して、モデルアーキテクチャとトレーニングパラメータを設定します。

- データセットをアップロードし、トレーニングプロセスを開始する。

- トレーニングが完了すると、モデルは展開と推論のためにダウンロードされる。

ワークフロー

- コントロールパネルへのアクセスログイン後、コントロールパネルで目的のサービスモジュールを選択します。

- 設定パラメータ必要に応じて、推論、微調整、トレーニングパラメータを設定します。

- データのアップロード必要なデータセットまたはモデルコードをアップロードします。

- ミッション開始推論、微調整、トレーニングのタスクを開始し、タスクの進捗状況をリアルタイムで監視します。

- ダウンロード結果タスク完了後、モデルや推論結果はアプリケーション統合のためにダウンロードされる。

一般的な問題

- 正しいモデルの選び方は?

- テキスト生成、画像認識など、アプリケーションのシナリオに基づいて適切なオープンソースモデルを選択します。

- 微調整中にエラーが発生した場合は?

- データセットのフォーマットとパラメーターの設定を確認し、公式ドキュメントを参照して調整してください。

- GPUクラスタ使用時のパフォーマンス低下?

- ハードウェア構成が要件を満たしていることを確認し、トレーニングパラメータを調整して効率を向上させる。

使用可能モデル

| Serverless Endpoints | Author | Type | Pricing (per 1M tokens) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Meta | chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX1.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [schnell] Free | ||||

| Black Forest Labs | image | See pricing | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Meta | chat | $0.06 | ||

| Meta Llama Vision Free | ||||

| Meta | chat | Free | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Meta | moderation | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Mixtral-8x22B Instruct v0.1 | ||||

| mistralai | chat | $1.20 | ||

| Stable Diffusion XL 1.0 | ||||

| Stability AI | image | See pricing | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Meta | chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | chat | $0.10 | ||

| Salesforce Llama Rank V1 (8B) | ||||

| salesforce | rerank | $0.10 | ||

| Meta Llama Guard 3 8B | ||||

| Meta | moderation | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Meta | chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Meta | chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3 70B Instruct Reference | ||||

| Meta | chat | $0.90 | ||

| Meta Llama 3 8B Instruct Reference | ||||

| Meta | chat | $0.20 | ||

| Qwen 2 Instruct (72B) | ||||

| Qwen | chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| chat | $0.80 | |||

| Gemma-2 Instruct (9B) | ||||

| chat | $0.30 | |||

| Mistral (7B) Instruct v0.3 | ||||

| mistralai | chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | chat | $1.80 | ||

| Meta Llama Guard 2 8B | ||||

| Meta | moderation | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | chat | $1.20 | ||

| DBRX Instruct | ||||

| Databricks | chat | $1.20 | ||

| DeepSeek LLM Chat (67B) | ||||

| DeepSeek | chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| chat | $0.10 | |||

| Mistral (7B) Instruct v0.2 | ||||

| mistralai | chat | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| mistralai | chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | language | $0.60 | ||

| Qwen 1.5 Chat (72B) | ||||

| Qwen | chat | $0.90 | ||

| Llama Guard (7B) | ||||

| Meta | moderation | $0.20 | ||

| Nous Hermes 2 – Mixtral 8x7B-DPO | ||||

| NousResearch | chat | $0.60 | ||

| Mistral (7B) Instruct | ||||

| mistralai | chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | language | $0.20 | ||

| LLaMA-2 Chat (13B) | ||||

| Meta | chat | $0.22 | ||

| LLaMA-2 Chat (7B) | ||||

| Meta | chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Meta | language | $0.90 | ||

| Code Llama Instruct (34B) | ||||

| Meta | chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| upstage | chat | $0.30 | ||

| M2-BERT-Retrieval-32k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-8k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-2K | ||||

| Together | embedding | $0.01 | ||

| UAE-Large-V1 | ||||

| WhereIsAI | embedding | $0.02 | ||

| BAAI-Bge-Large-1p5 | ||||

| BAAI | embedding | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | embedding | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | chat | $0.30 |

使用例

モデル推論の例

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

モデルの微調整の例

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)