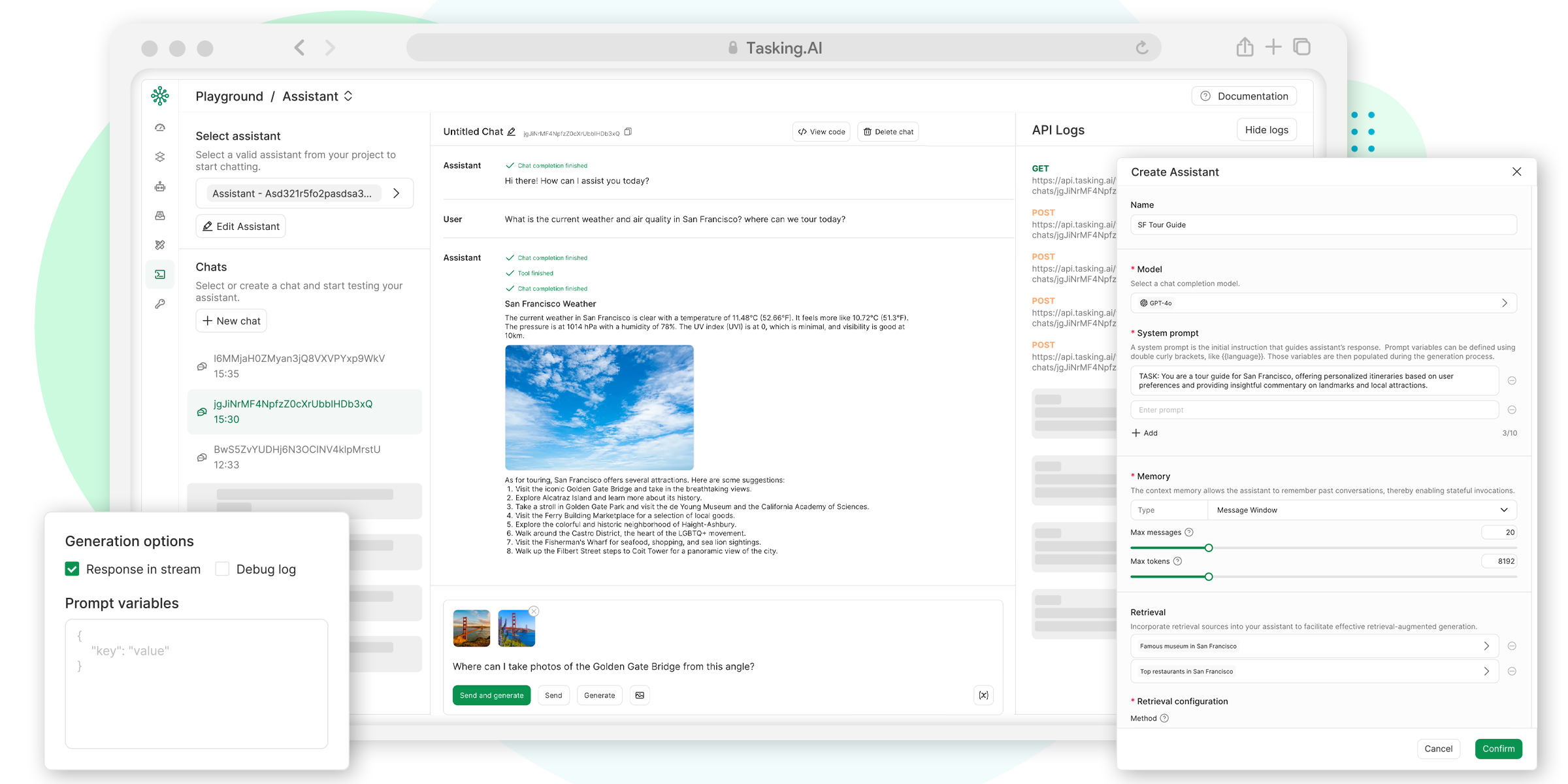

TaskingAIは、開発者がAIネイティブアプリケーションを構築することを支援することに焦点を当てたオープンソースプラットフォームです。直感的なインターフェイス、強力なAPI、柔軟なモジュール設計を提供することで、大規模言語モデル(LLM)の開発プロセスを簡素化します。このプラットフォームは、OpenAI、Anthropic などの主流モデルを幅広くサポートしており、ネイティブモデルの統合も可能です。非同期の高性能、プラグイン拡張、マルチテナント対応に重点を置いた TaskingAI は、初心者からプロの開発者まで幅広く対応しています。ユーザーはDocker経由でコミュニティ版を迅速にデプロイしたり、開発のためにクラウドサービスを利用することができます。TaskingAIは、AIアプリケーションの開発をより簡単で効率的にすることに尽力しており、ユーザーが貢献することを奨励する活発なコミュニティがあります。

機能一覧

- OpenAI、Claude、Mistralなど、幅広い大規模言語モデル(LLM)をサポートし、Ollamaなどのローカルモデルとも統合可能。

- Google検索、ウェブサイトコンテンツの読み取り、株式データの取得など、豊富なプラグインを提供します。 ユーザー定義のツールをサポートします。

- 外部データの取り扱いと管理を容易にするRAG(Retrieval Augmentation Generation)システムを内蔵。

- FastAPIに基づく非同期処理と高性能並行コンピューティングをサポート。

- 直感的なUIコンソールを提供し、プロジェクト管理とテストワークフローを簡素化します。

- 迅速なデプロイとスケーリングのためのマルチテナント・アプリケーション開発をサポートします。

- モデル、ツール、データを簡単に管理するための統一されたAPIインターフェースを提供する。

- OpenAI互換のチャット補完APIをサポートし、タスクの作成と呼び出しを簡素化。

ヘルプの使用

TaskingAIは、開発者がAIネイティブアプリケーションを迅速に構築するための強力なプラットフォームです。下記は、ユーザーがすぐに使い始められるように、インストールと使用方法の詳細ガイドです。

設置プロセス

TaskingAI Community Editionは、Docker経由で素早くデプロイでき、ローカルでの開発やテストに適しています。具体的な手順は以下の通りです:

- 環境への準備

- DockerとDocker Composeをインストールします。

- お使いのシステムがPython 3.8以上をサポートしていることを確認してください。

- オプション:依存関係を分離するためにPython仮想環境を作成する。

- TaskingAI Community Editionのダウンロード

- GitHubリポジトリhttps://github.com/TaskingAI/TaskingAI。

- リポジトリをローカルにクローンする:

git clone https://github.com/TaskingAI/TaskingAI.git - プロジェクト・カタログにアクセスする:

cd TaskingAI

- 環境変数の設定

- プロジェクトのルート・ディレクトリに

.envファイルでAPIキーやその他の設定を行います。例TASKINGAI_API_KEY=your_api_key TASKINGAI_HOST=http://localhost:8080 - APIキーはTaskingAIのコンソールから入手できます(クラウド版はアカウント登録が必要です)。

- プロジェクトのルート・ディレクトリに

- サービス開始

- Docker Composeを使用してTaskingAIサービスを起動します:

cd docker docker-compose -p taskingai pull docker-compose -p taskingai --env-file .env up -d - サービス開始後

http://localhost:8080コンソールを見る。

- Docker Composeを使用してTaskingAIサービスを起動します:

- PythonクライアントSDKのインストール

- pip を使用して TaskingAI Python クライアントをインストールします:

pip install taskingai - SDKを初期化する:

import taskingai taskingai.init(api_key="YOUR_API_KEY", host="http://localhost:8080")

- pip を使用して TaskingAI Python クライアントをインストールします:

主な機能

TaskingAIのコア機能には、モデル統合、プラグイン利用、RAGシステム、APIコールが含まれます。以下、具体的な運用方法について説明します:

- モデル統合

TaskingAIは様々な大規模言語モデルをサポートしています。ユーザーは、コンソールでモデル(例:Claude、Mistral)を選択するか、APIを通じてモデルIDを指定することができます:from openai import OpenAI client = OpenAI( api_key="YOUR_TASKINGAI_API_KEY", base_url="https://oapi.tasking.ai/v1", ) response = client.chat.completions.create( model="YOUR_MODEL_ID", messages=[{"role": "user", "content": "你好,今天天气如何?"}] ) print(response)

- コンソールでは、温度や最大出力長などのパラメーターを調整しながら、モデルの対話効果を直接試すことができる。

- プラグイン使用

TaskingAIは、Google検索、ウェブサイトコンテンツの読み取りなど、様々な組み込みプラグインを提供しています。ユーザーはカスタムプラグインを開発することもできます。操作手順- コンソールのプラグインページでプラグインを選択または追加する。

- APIを通してプラグインの機能を呼び出す。例えば、Google検索プラグインを呼び出す:

import taskingai result = taskingai.plugin.google_search(query="最新AI技术") print(result) - カスタムプラグインは、TaskingAIのツール開発ドキュメントに従い、コードをアップロードし、AIエージェントにバインドする必要があります。

- RAGシステム操作

外部データの処理にはRAG(Retrieval Augmentation Generation)システムを使用する。ユーザーはデータコレクションを作成し、コンテンツを取得することができます:- コレクションの作成

coll = taskingai.retrieval.create_collection( embedding_model_id="YOUR_EMBEDDING_MODEL_ID", capacity=1000 ) print(f"集合ID: {coll.collection_id}") - レコードを追加する:

record = taskingai.retrieval.create_record( collection_id=coll.collection_id, type="text", content="人工智能正在改变世界。", text_splitter={"type": "token", "chunk_size": 200, "chunk_overlap": 20} ) print(f"记录ID: {record.record_id}") - レコードを検索する:

retrieved_record = taskingai.retrieval.get_record( collection_id=coll.collection_id, record_id=record.record_id ) print(f"检索内容: {retrieved_record.content}")

- コレクションの作成

- UIコンソールの使い方

- コンソールにログインした後、"Projects "ページに行き、新しいプロジェクトを作成する。

- モデルページで大きな言語モデルを選択または設定します。

- Testページでワークフローを実行し、AI出力をリアルタイムで確認する。

- APIコールとパフォーマンスを監視するには、「ロギング」機能を使用します。

注目の機能操作

TaskingAIの特徴は、非同期処理とマルチテナント対応である:

- 非同期処理FastAPIをベースとした非同期アーキテクチャは、高い同時実行シナリオに適しています。ユーザーは追加の設定をする必要がなく、APIコールは自動的に非同期をサポートします。例えば、複数のAIエージェントタスクを作成する場合、システムはリクエストを並行して処理します。

- マルチテナント対応マルチユーザー指向のアプリケーション開発に最適です。ユーザーは、コンソールでモデルやプラグインを異なるテナントに割り当てて、データの分離を確保できます。設定方法:

- コンソールのテナント管理画面で新しいテナントを追加します。

- 各テナントに独立したAPIキーとモデル設定を割り当てる。

ほら

- APIキーが安全で、漏洩していないことを確認する。

- Dockerがデプロイされたら、8080番ポートが占有されているかチェックする。

- クラウド版ユーザーはアカウント登録の上、https://www.tasking.ai获取API密钥。

アプリケーションシナリオ

- AIチャットボットの開発

開発者はTaskingAIを使用して、大規模な言語モデルに基づくチャットボットを迅速に構築することができ、複数ラウンドの会話と外部データ検索をサポートし、顧客サービスや教育シナリオに適しています。 - 自動データ分析

プラグインやRAGシステムを通じて、TaskingAIはウェブページや文書からデータを抽出し、AI分析と組み合わせて、市場調査員に適したレポートや洞察を生成することができる。 - ラピッドプロトタイピング

新興企業や個人開発者は、TaskingAIのUIコンソールとAPIを活用して、AIアプリケーションのプロトタイプを素早く構築し、ビジネスアイデアを検証することができます。 - 教育とトレーニング

教育機関は、TaskingAIを使用して、学生が知識ポイントを照会したり、練習問題を生成したりするのをサポートする対話型の学習アシスタントを作成することができます。

QA

- TaskingAIはどのようなモデルをサポートしていますか?

TaskingAIは、OpenAI、Claude、Mistralなど幅広いモデルをサポートしており、Ollamaなどを通じてローカルモデルを統合することができます。 - TaskingAIの使い方を教えてください。

Docker経由でデプロイするためにコミュニティ版をダウンロードするか、APIキーを取得するためにクラウド版にサインアップする。API を呼び出すために Python SDK をインストールする。 - プログラミングの経験は必要ですか?

初心者はUIコンソールで操作でき、開発者はAPIやSDKを使って複雑な機能を実装できる。 - TaskingAI Community EditionとCloud Editionの違いは何ですか?

コミュニティ版は無料で、ローカルへの展開が必要。クラウド版はホスティングサービスを提供し、迅速な開発に適している。