AIアプリケーションの開発では、うまく設計されたプロンプトのパフォーマンスが非常に不安定になることがあります。このランダム性と予測不可能性は、AIアプリケーションがプロトタイプから生産規模に移行するのを妨げる重要な障害です。サービスの継続性と信頼性を求めるすべての開発者は、この課題に直面しなければなりません。

最近、ByteDanceは、同社のワンストップAIアプリケーション開発プラットフォームをオープンソース化した。 Coze Studio というプログラムも開始した。 Coze Loop (バックル・コンパス)。Coze Loop 無視されがちだが、まさに上記のジレンマを解決する核となるコンポーネントである。その価値は、AIモデルの評価と反復のための標準化された「実験的」フレームワークのセットを提供することにあり、開発者が「感覚によるチューニング」から「データに基づく科学的な反復」へとシフトするのを助ける。"AIモデルの評価と反復を行う際に考慮すべき最も重要な点は以下の通りである。

この記事では、「小洪水爆発タイトル生成」という実際のビジネスシナリオを例にとり、以下の使い方を説明する。 Coze Loop AIアプリケーションの厳密な定量評価を行う。

実験」とは何か?AIモデルの標準化された評価プロセス

実験 Coze Loop は抽象的な学問的概念ではなく、完全かつ構造化された一連の評価プロセスであり、そのように理解することができる:AIモデルの標準化された「最終試験」の実施。

このプロセスは、4つの核となる要素で構成されている:

- テストセットに相当する。答案用紙".モデルを検証するための一連の入力サンプル(質問)が含まれており、予想される標準出力(参考解答)は、その後の採点の基準として各サンプルに添付することができます。

- テスト中のユニットすなわち"受験生".特定の

Promptカプセル化されたCoze 智能体または複雑な多段階Coze 工作流。 - 評価者プレー"マーカー候補者」の役割。事前に定義された採点基準に基づいて「候補者」のアウトプットを個々に採点し、採点の理由を示す。

- 実験試験原稿の配布」から「受験者の回答」、「採点者による採点」、そして最終的には「詳細情報の作成」までのプロセスを指す。学校の成績表「すべてのプロセスだ。

この詳細なレポートカードを解釈することで、開発者はAIモデルの長所と短所を明確に把握し、その能力を安定させるために的を絞った最適化を実施することができる。

ステップ1:標準化された試験問題の作成(新しい評価セット)

質の高い評価は、質の高い「試験用紙」から始まります。私たちは、幅広い典型的なシナリオをカバーするアセスメントのコレクションを作成する必要があります。

まず、「Little Red Book Title Writing Skills Test Paper」のように、評価セットに名前を付けます。

次に、テストケースを一行ずつ入力する。各データ項目は個別の質問を構成する。

テストケースの数が膨大な場合、プラットフォームはローカルファイルからのバッチインポートもサポートしており、試験用紙全体を効率的に生成することができます。

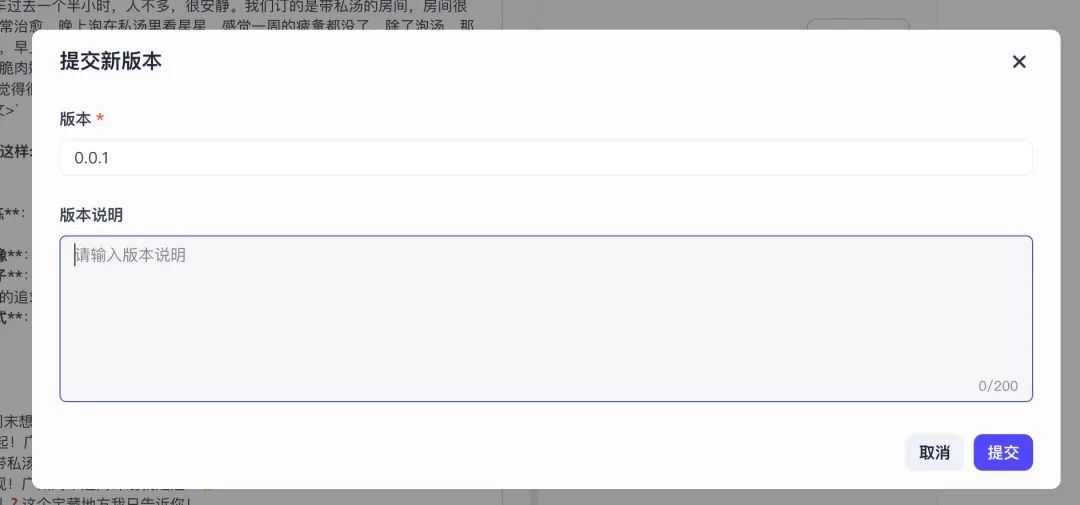

編集後、重要なアクションは「新バージョンの提出」である。このアクションは、下書き状態の「試験用紙」を正式に「印刷」することと同じであり、しっかりとした呼び出し可能なバージョンにします。バージョンを提出することによってのみ、この評価セットは認識され、後続の実験を作成するときにシステムによって使用されます。

ステップ 2: インテリジェントマーカーの定義(評価者の作成)

試験用紙が準備できたら、厳格な「採点官」を任命する必要がある。Coze Loop その繊細さマーカー」自体は、プロンプト主導のAIである。.つまり、私たちはAIを使ってAIを評価し、評価プロセスを自動化しているのだ。

この「AIマーカー」には、採点基準と実行ロジックを明確に定義した詳細な「採点ガイド」(すなわち評価者プロンプト)を提供する必要がある。

例えば、以下は評価者が「指示遵守」を判断するための公式テンプレートである:

title:"指令遵从度"评估器

你的任务是判断 AI 助手生成的回答是否严格遵循了系统或用户的提示指令。

<评判标准>

- 如果 AI 回答完整、准确地响应了提示指令的要求,且未偏离任务,则得 1 分。

- 如果 AI 回答部分遵循了指令,但存在遗漏或偏离部分要求,得 0 分。

- 如果 AI 回答完全忽略或违背了指令,则得 0 分。

</评判标准>

<输入>

[提示指令]:{{instruction}}

[AI 回答]:{{ai_response}}

</输入>

<思考指导>

请仔细阅读提示指令,准确理解用户或系统希望模型执行的操作内容。然后判断 AI 的回答是否严格遵循了这些指令,是否完全准确地完成了任务要求。

根据Prompt 中的评判标准一步步思考、分析,满足评判标准就是 1 分,否则就是 0 分。

</思考指导>

テンプレートからわかるように、この評価者の入力は「試験問題」です。 {{instruction}} と "候補者の回答" {{ai_response}}その出力形式は次のように厳密に規定されている。 0 到 1 点数と点数の間に具体的な根拠を示すことで、評価結果が専門的で解釈しやすいものになります。

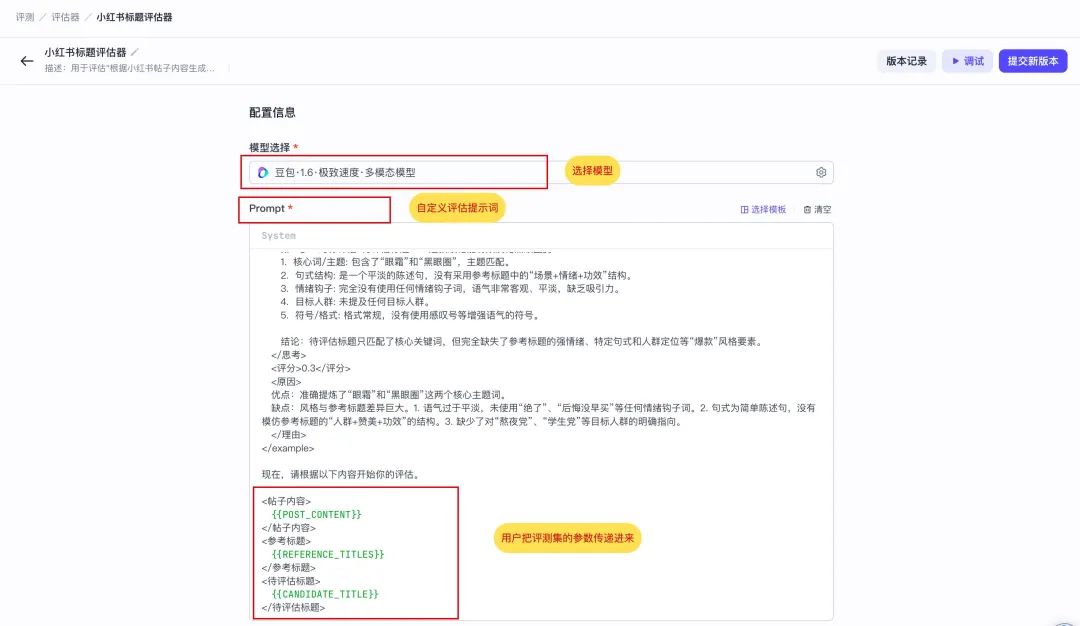

以下は、この "Little Red Book of Explosive Titles "シナリオ用にカスタマイズされた、より専門的なエバリュエーターである。

リトルレッドブック・タイトルレビュアー」と呼ばれるこの命令は、AIリーダーに点数をつける前に深く考えることを要求する。それには3つの入力が必要だ。 {{POST_CONTENT}}リファレンス・ポップアップ・タイトルを提供 {{REFERENCE_TITLES}} (を生成するために評価されるAI(標準的な答え)。 {{CANDIDATE_TITLE}} (候補者の回答)。

你是一位资深的小红书爆款标题专家评估师。你的任务不是创作,而是根据用户提供的“参考标题”作为唯一的黄金标准,来评估一个“待评估标题”的质量。

你的评估过程必须严格遵循以下逻辑:

1. **深度分析参考标题**: 首先,仔细研究“参考标题”列表,在`<思考>`标签内提炼出它们的共同特征。这包括但不限于:

* **核心词/主题**: 它们都围绕哪些关键词展开?(例如:“省钱”、“变美”、“踩坑”)

* **句式结构**: 它们是陈述句、疑问句还是感叹句?是否有固定的模式(如“数字+方法”、“问题+解决方案”)?

* **情绪钩子**: 运用了哪些词语来吸引眼球、引发共鸣或好奇?(例如:“绝了”、“救命”、“后悔没早知道”)

* **目标人群**: 是否明确或暗示了目标读者?(例如:“学生党”、“打工人”、“新手妈妈”)

* **符号/格式**: Emoji、空格、特殊符号的使用风格是怎样的?

2. **对标评估待评估标题**: 接下来,在`<思考>`标签内,将“待评估标题”与你刚提炼出的特征标尺进行比较,判断它在多大程度上模仿了参考标题的风格和精髓。

3. **给出评分和原因**: 基于以上对比分析,给出一个最终评分和评价。

* **评分标准**: 0-1分

* **0.8-1分**: 高度符合。风格、关键词、结构和情绪钩子都与参考标题非常匹配,几乎可以以假真。

* **0.5-0.7分**: 基本符合。抓住了部分核心元素,但在语气、细节或“网感”上存在一定偏差。

* **0.1-0.4分**: 不太符合。与参考标题的风格和核心要素相去甚远,没有学到精髓。

* **原因**: 清晰地说明你打分的原因。必须具体指出“待评估标题”的优点(与参考标题相似之处)和缺点(与参考标题不同之处)。

下面是一个完整的评估示例,请严格按照此格式执行任务。

...(示例部分与原文相同,此处省略以保持简洁)...

现在,请根据以下内容开始你的评估。

<帖子内容>

{{POST_CONTENT}}

</帖子内容>

<参考标题>

{{REFERENCE_TITLES}}

</参考标题>

<待评估标题>

{{CANDIDATE_TITLE}}

</待评估标题>

ステップ3:被験者(候補者)の指定

試験用紙」と「採点者」が揃ったところで、次のステップは評価の中心的な対象である「受験者」を指定することである。次のステップは、この評価の中心的な対象である「受験者」を指定することです。この場合、「受験者」はリトルレッドブックのタイトルを生成するためにデザインされたプロンプトです。

をプロンプトに予約した。 {{POST_CONTENT}} 変数。実験が実行されると、システムは自動的に「試験用紙」(評価セット)の各投稿に変数を入力し、プロンプトを駆動して結果をバッチ生成します。

同様に、"候補 "が実験によって正しく呼び出されるようにするためには、編集後に "新バージョンを提出 "をクリックし、追跡可能なバージョンとして固める必要がある。バージョン管理は、最適化の効果を測定するための複数の比較実験の基礎となる。

"評価対象 "に関する補足説明

Coze Loop 現在、以下の3種類の評価対象がサポートされている:

PromptCoze 智能体Coze 工作流

開発者は、実際のアプリケーションの形状に応じて、評価するユニットを柔軟に選択することができる。

ステップ4:評価実験の開始(新規実験)

すべての要素が整ったら、「試験用紙」「受験者」「採点者」を整理して実験を開始する。

ステップ1:診察室の準備

例えば、「リトルレッドブック第1弾のタイトルに対するプロンプト生成の効果評価」など、実験名を挙げる。

ステップ2:ラボの指示を記入する

その後のトレースのために、この実験の目的を簡単に説明する。

ステップ3:試験用紙の選択

以前に作成したレビューセットとその特定のバージョンを選択します。バージョンオプションが空の場合、ステップ1に戻って、レビューセットが新しいバージョンで正常に送信されたかどうかを確認します。

ステップ4:入学候補者の指定

シナリオ1:プロンプトの評価(この記事の例)

オプション Prompt 見直しの対象となった後、以下の3点を明確にする必要がある:

- Prompt keyテストする特定のプロンプト。

- リリースプロンプトのどの反復をテストするか。

- フィールドマッピングこれはコンフィギュレーションの中心的な側面であり、本質的には次のようなものである。データストリームへの接続を確立する。

選択されたプロンプトに入力変数が含まれていることをシステムが自動的に検出します。 {{POST_CONTENT}}。

という名前の "試験用紙"(評価セット)をシステムに伝える必要がある。 POST_CONTENT をプロンプトの {{POST_CONTENT}} 変数を使用する。こうして、データパスはうまく構築された。

シナリオ2:CozeワークフローまたはIntelligentsiaの評価

審査がより複雑な場合 Coze 工作流 或 智能体プロセスロジックは一貫している。例えば、ワークフローを選択すると、システムは自動的にすべての入力パラメータを認識します。開発者が行う必要があるのは、評価セット内の対応するデータ列をこれらのパラメータに1つずつ対応させる、同じ「フィールドマッピング」を行うことだけである。

Cozeワークフロー・レビュー

に関してインテリジェントボディ例えば、核となる入力は通常、ユーザーの質問である。 inputマッピングの関係はもっと単純だ。

実践的な展望:外部フレームワークとの統合

の使用について LangChain 或 Dify このような主流のオープンソースフレームワーク上で独自のAIアプリケーションを構築するプロの開発者にとっては、外部のAPIインターフェースを直接確認しながら作業する方が効率的だ。現在 Coze Loop APIオブジェクトの直接評価はまだサポートされていないが、これはプラットフォームやツールチェーン統合の二次開発の方向性を示している。

本番環境では、「API」型の評価オブジェクトを追加するプラットフォームの二次開発が考えられる。これにより、APIアドレスと認証情報を渡すだけで、あらゆる外部AIサービスをこの強力な評価システムにシームレスに接続し、技術スタック全体の統一的な評価を実現することができる。このモデルは LangChain 的 LangSmith これは、次のようなLLMOpsプラットフォームですでに実践されている。

ステップ5:マーカーとタスクを割り当てる

最後に、私たちが作成した「Little Red Book Title Review」評価ツールを選択します。

システムは、この評価者に必要な3つの入力を自動的に解析する。私たちは「フィールドマッピング」によって、そのための修正資料を提供する:

{{POST_CONTENT}}→ ソース レビュー 的inputコラム(タイトル)。{{REFERENCE_TITLES}}→ ソース レビュー 的reference_outputコラム(標準解答)。{{CANDIDATE_TITLE}}→ 前のステップから レビューのテーマ(プロンプト) アウトプット(候補者の答え)。

この時点で、自動評価の明確なデータフローが構築された:評価セットが質問する→評価対象者が質問に答える→評価者が標準的な解答と質問に基づいて解答を修正する。

正確な最適化の旅を始めるための「成績表」の解釈

実験の実行をクリックし、詳細な評価レポートが自動的に生成されるまでしばらく待つ。

このレポートは、「形而上学的なチューニング」に別れを告げるための科学的根拠を開発者に提供します。定量的なスコアが記載されているだけでなく、各評価の詳細な理由も記載されており、モデルの能力を洞察し、正確な反復を行うための出発点となります。