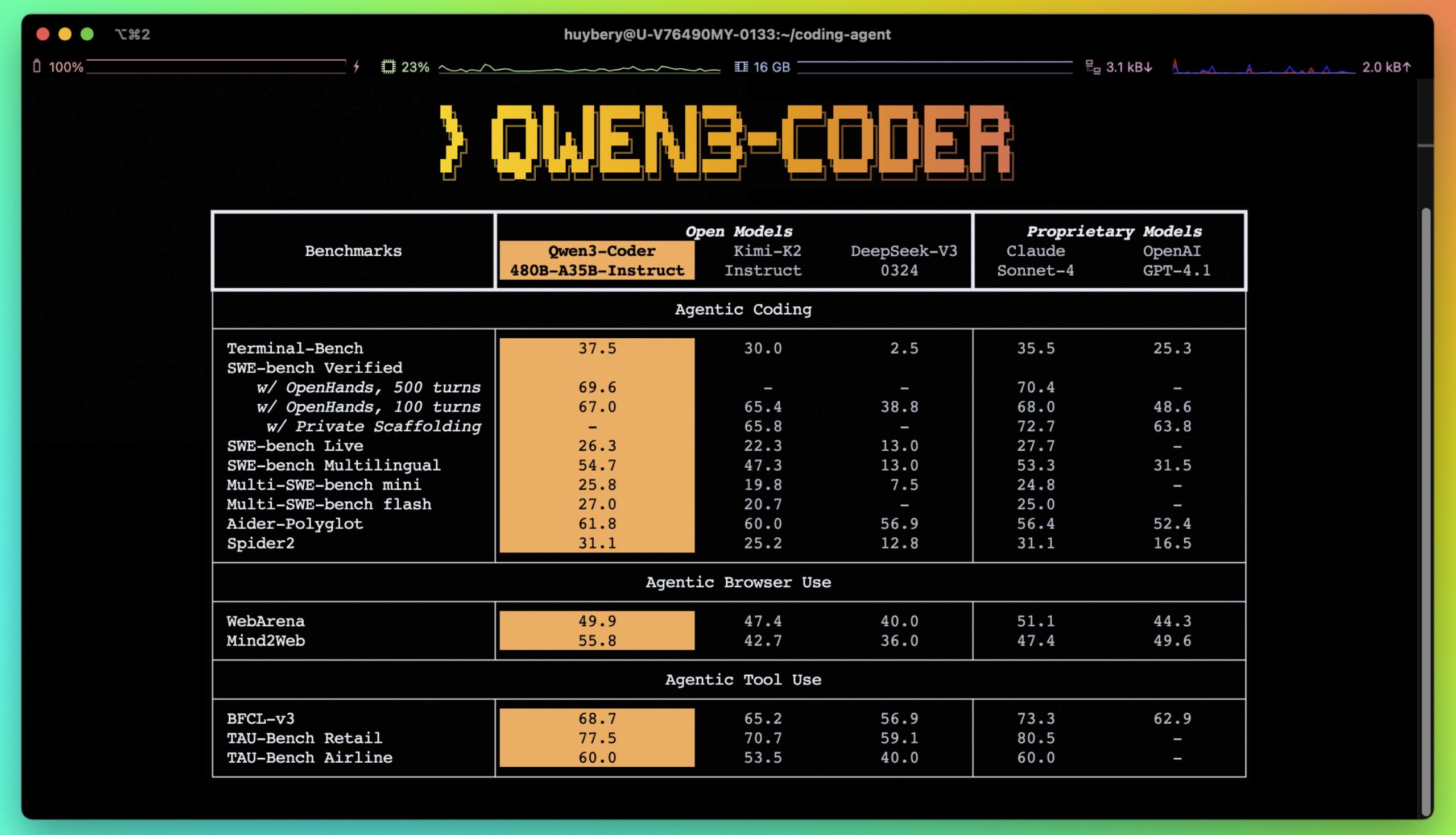

Qwen3-Coderは、Alibaba Cloud Qwenチームによって開発されたオープンソースの大規模言語モデリングファミリーで、コード生成とインテリジェントプログラミングに重点を置いています。コア製品は以下の通りです。 Qwen3-Coder-480B-A35B-InstructQwen3-Coderは、480億のパラメータと35億のアクティブパラメータを持つハイブリッドなエキスパートモデル(MoE)です。Qwen3-Coderは、コード生成、コード修復、エージェントタスク(ブラウザの操作やツールの使用など)において、Qwen3-Coderに匹敵するパフォーマンスを発揮します。 Claude ソネット4.オープンソースのコマンドラインツールで利用できる。 Qwen Code 複雑なコードタスクに取り組む開発者に、強化されたコーディングサポートを提供します。モデルは100以上の言語をサポートし、特に多言語コード生成とシステムプログラミングに優れています。すべてのモデルはApache 2.0ライセンスのオープンソースであり、開発者が自由にダウンロードしてカスタマイズすることができます。

機能一覧

- コード生成Python、C++、Javaなど92のプログラミング言語をサポートし、高品質なコードを生成します。

- コード修正コードのエラーを自動的に検出して修正し、プログラミングの効率を高めます。

- コード補完コード・スニペット・フィラー・パッチをサポートし、開発プロセスを最適化。

- エージェント・ミッション・サポートブラウザの操作や複雑なタスクを処理するために外部ツールを統合します。

- ロングコンテクスト処理256Kトークンコンテキストをネイティブでサポートし、1Mトークンまでスケーラブル。

- 多言語サポート100以上の言語と方言をカバーし、多言語開発や翻訳に適しています。

- コマンドラインツール提供

Qwen Codeコード管理と自動化タスクを簡素化するために、パーサーとツールサポートを最適化する。 - オープンソースモデル複数のモデルサイズ(0.6B~480B)を提供し、開発者のカスタマイズと微調整をサポートします。

ヘルプの使用

インストールと展開

Qwen3-CoderモデルはGitHubでホストされており、開発者は以下の手順でインストールして使用することができる:

- クローン倉庫

ターミナルで以下のコマンドを実行し、Qwen3-Coderリポジトリをクローンします:git clone https://github.com/QwenLM/Qwen3-Coder.gitこれでプロジェクトファイルがローカルにダウンロードされる。

- 依存関係のインストール

プロジェクト・ディレクトリに移動し、必要なPythonの依存関係をインストールする:cd Qwen3-Coder pip install -e ./"[gui,rag,code_interpreter,mcp]"最小限の依存関係しか必要ない場合は、次のように実行できます。

pip install -e ./。 - 環境変数の設定

Qwen3-Coderは、Alibaba CloudのDashScope APIまたはネイティブデプロイメントモデルによる使用をサポートしています。- DashScope API の使用クラウドサービスを利用するための環境変数の設定:

export OPENAI_API_KEY="your_api_key_here" export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1" export OPENAI_MODEL="qwen3-coder-plus"APIキーはAlibaba CloudのDashScopeプラットフォームから入手できる。

- ローカル展開使用

llama.cpp或Ollama展開モデル。- オッラマの使用Ollama(バージョン0.6.6以上)をインストールし、実行する:

ollama serve ollama run qwen3:8bコンテキストの長さと生成パラメータを設定する:

/set parameter num_ctx 40960 /set parameter num_predict 32768APIのアドレスは

http://localhost:11434/v1/。 - llama.cppの使用以下のコマンドを実行してサービスを開始する:

./llama-server -hf Qwen/Qwen3-8B-GGUF:Q8_0 --jinja --reasoning-format deepseek -ngl 99 -fa -sm row --temp 0.6 --top-k 20 --top-p 0.95 --min-p 0 -c 40960 -n 32768 --no-context-shift --port 8080これは、APIアドレスが

http://localhost:8080/v1。

- オッラマの使用Ollama(バージョン0.6.6以上)をインストールし、実行する:

- DashScope API の使用クラウドサービスを利用するための環境変数の設定:

- ダウンロードモデル

モデルウェイトは、ハギング・フェイスまたはモデルスコープからダウンロードできます。例- Hugging Face:

https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct - ModelScope:

https://modelscope.cn/organization/qwen

利用するtransformersライブラリ搭載モデル:

from transformers import AutoTokenizer, AutoModelForCausalLM device = "cuda" # 使用 GPU tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct", device_map="auto").eval() - Hugging Face:

Qwen3-Coderの使用

Qwen3-Coderには様々な機能がありますが、主な機能の詳細な操作手順を以下に示します:

- コード生成

Qwen3-Coderは高品質のコードを生成します。例えば、高速なソートアルゴリズムを生成します:input_text = "#write a quick sort algorithm" model_inputs = tokenizer([input_text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)このモデルは完全なクイックソート・コードを返す。サポートされているプログラミング言語には、C、C++、Python、Javaなどがあり、さまざまな開発シナリオに適している。

- コード補完

Qwen3-CoderはFill-in-the-Middleをサポートしています。例えば、クイックソート機能を埋めてください:input_text = """<|fim_prefix|>def quicksort(arr): if len(arr) <= 1: return arr pivot = arr[len(arr) // 2] <|fim_suffix|> middle = [x for x in arr if x == pivot] right = [x for x in arr if x > pivot] return quicksort(left) + middle + quicksort(right)<|fim_middle|>""" messages = [{"role": "system", "content": "You are a code completion assistant."}, {"role": "user", "content": input_text}] text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True) model_inputs = tokenizer([text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)このモデルは、欠落しているコード部分を自動的に埋める。

- コード修正

Qwen3-Coder はコードエラーを検出し、修正します。ユーザーがエラーを含むコードを入力すると、モデルは修正されたバージョンを返します。例えば、Aiderベンチマークでは、Qwen3-Coder-480B-A35B-Instructは、複雑なバグ修正のGPT-4oと同等のスコアを出しています。 - Qwenコードツールの使用

Qwen Codeは、Qwen3-Coder の解析とツールのサポートに最適化されたコマンドラインツールです。以下のコマンドを実行してください:cd your-project/ qwenコマンドの例:

- プロジェクト・アーキテクチャを見る

qwen > Describe the main pieces of this system's architecture - 改善機能:

qwen > Refactor this function to improve readability and performance - 文書を作成する:

qwen > Generate comprehensive JSDoc comments for this function

このツールは、gitコミットの処理やコードのリファクタリングなどの自動化タスクをサポートしている。

- プロジェクト・アーキテクチャを見る

- 代理店の割り当て

Qwen3-Coderは、ブラウザアクションやツールコールなどのプロキシタスクをサポートしています。設定方法- APIプロバイダーを

OpenAI Compatible。 - DashScope API キーを入力します。

- カスタムURLを設定します:

https://dashscope-intl.aliyuncs.com/compatible-mode/v1。 - モデルを選択します:

qwen3-coder-plus。

モデルは、スクリプトの自動実行やブラウザとの対話といった複雑なエージェントタスクを処理することができる。

- APIプロバイダーを

ほら

- コンテキストの長さデフォルトでは256Kトークンをサポートしており、大規模なコードベース解析に適している。YaRNで1Mトークンまで拡張可能。

- ハードウェア要件GPU(例:CUDAデバイス)は、より高速な推論を行うために推奨される。低リソース環境では、小型モデル(Qwen3-8Bなど)が適している。

- ライセンスこのモデルはアパッチ2.0ライセンスの下でオープンソース化されており、自由な使用と改変が認められているが、商用利用はライセンス契約の対象となる。

アプリケーションシナリオ

- ソフトウェア開発

開発者は、Qwen3-Coderを使用して、初心者からプロの開発者まで幅広いプロジェクトで、コードをすばやく生成したり、バグを修正したり、機能を修正したりすることができます。例えば、ウェブアプリケーションのバックエンドコードの生成や、組み込みシステムのコードの最適化などです。 - 自動化されたワークフロー

とおすQwen Code開発者がチームコラボレーションやDevOpsシナリオのために、gitコミット、コードリファクタリング、ドキュメント生成を自動化できるツール。 - 多言語プロジェクト

Qwen3-Coderは100以上の言語をサポートしており、多言語アプリケーションの開発や、PythonのコードをC++に変換するなどのコード翻訳に最適です。 - 大規模なコードベースの管理

256Kトークンのコンテキストサポートにより、このモデルは大規模なコードベースを扱うことができ、企業ソフトウェアやオープンソースリポジトリのような複雑なプロジェクトの分析と最適化に適している。

QA

- Qwen3-Coderはどのプログラミング言語をサポートしていますか?

Python、C、C++、Java、JavaScriptなど92のプログラミング言語をサポートしており、主流の開発ニーズに対応している。 - 大規模なコードベースをどのように扱っていますか?

このモデルはネイティブで256Kトークンコンテキストをサポートし、YaRNで1Mトークンまで拡張できる。モデルはQwen Code大規模なコードベースを直接照会し、編集するためのツール。 - Qwen3-Coderは無料ですか?

モデルはApache 2.0ライセンスに基づくオープンソースであり、無料でダウンロードして使用することができます。商用利用にはライセンス契約が必要です。 - モデルのパフォーマンスを最適化するには?

CUDAなどのGPUデバイスを使用することで、推論速度が向上する。以下のようなパラメータを調整することで、推論速度が向上します。max_new_tokens和top_p発電品質を最適化することができる。