Lemon AIは、クラウドサービスに依存することなく、完全にローカルな実行環境を提供するフルスタックのオープンソースAI知能体フレームワークです。DeepSeek、Qwen、Llamaなど、ローカルの大規模言語モデル(LLM)をサポートしています。 Ollama Lemon AIは、ローカライズされたAIソリューションを必要とする個人や企業向けに、コードの実行を保護する仮想マシン・サンドボックスを統合している。PCや企業サーバーに簡単に導入でき、シンプルで幅広い環境に対応します。Lemon AIは、ワンクリックで導入できるため、技術的な敷居を低くし、APIを介してClaude、GPT、Gemini、Grokなどのクラウドモデルとの接続をサポートし、ローカルとクラウドの柔軟性のバランスをとっている。

機能一覧

- ローカルで実行されるAIインテリジェンス:DeepSeek、Qwen、Llamaなどのローカルの大きな言語モデルをサポートし、データ処理全体をローカライズする。

- 仮想マシン・サンドボックス:ユーザー・デバイスを潜在的なリスクから保護する安全なコード実行環境を提供する。

- コード生成と解釈:高品質のコードを生成し、16Kの出力長をサポートし、コード形式と構文を最適化します。

- 綿密なリサーチとウェブ閲覧:複雑なタスクの計画、実行、考察をサポートし、リサーチやデータ収集に適しています。

- データ分析:データを処理・分析し、さまざまな分析シナリオに対応するための可視化結果を生成。

- API統合:クラウドモデル(クロード、GPTなど)への接続をサポートし、機能を拡張。

- ワンクリック・デプロイメント: Dockerコンテナを提供し、PCやエンタープライズ・サーバーと互換性のある簡素化されたインストール・プロセスを提供します。

- 柔軟なカスタマイズ: アーキテクチャは、ユーザーがニーズに応じて変更・拡張し、さまざまなビジネスシナリオに適応することをサポートします。

ヘルプの使用

設置プロセス

Lemon AIは、オープンソースコード、Dockerコンテナ、クライアントアプリケーション、オンラインサブスクリプションなど、複数のデプロイ方法を提供しています。以下はDockerデプロイの例で、初心者からプロフェッショナルユーザーまで、詳細なインストールと使用プロセスを紹介します。

- Dockerのインストール

お使いのデバイスにDockerがインストールされていることを確認してください。インストールされていない場合は、Dockerのウェブサイトにアクセスしてダウンロードとインストールを行ってください。 Windowsユーザーは、Dockerコマンドを実行するためにWSL(Windows Subsystem for Linux)を有効にする必要があります。 - レモンのAIコードを取得する

Lemon AI の GitHub リポジトリを見るhttps://github.com/hexdocom/lemonai緑色のボタン「Code」をクリックし、「Download ZIP」を選択してソースコードをダウンロードしてください。緑色のボタン「Code」をクリックし、「Download ZIP」を選択してソースコードをダウンロードするか、Gitを使ってリポジトリをクローンしてください:git clone https://github.com/hexdocom/lemonai.git

ファイルを解凍するか、クローンしたディレクトリに移動する。

- Dockerコンテナの実行

WSLターミナル(Windowsユーザー)または通常のターミナル(Linux/Macユーザー)を開き、Lemon AIプロジェクト・ディレクトリに移動します。以下のコマンドを実行し、Dockerコンテナを起動します:docker-compose up -dこのコマンドは、必要なイメージを自動的に取得し、Lemon AIサービスを開始します。Docker Composeがインストールされていることを確認してください。

- ローカルモデルの設定

Lemon AIはデフォルトでOllamaを使用し、ローカルの大規模言語モデルを実行します。Ollamaをインストールし(Ollamaの公式ウェブサイトを参照)、サポートされているモデルを引き出します:ollama pull deepseekレモンAIの設定ページで、モデルパスを設定します。

- インストールの確認

起動後、ローカルアドレス(通常はhttp://localhost:3000) Lemon AIのインターフェイスを表示します。インターフェイスにはモデルのステータスと利用可能な機能が表示されます。モデルがロードされていない場合は、Ollamaが正しく実行されているか確認してください。

機能 操作の流れ

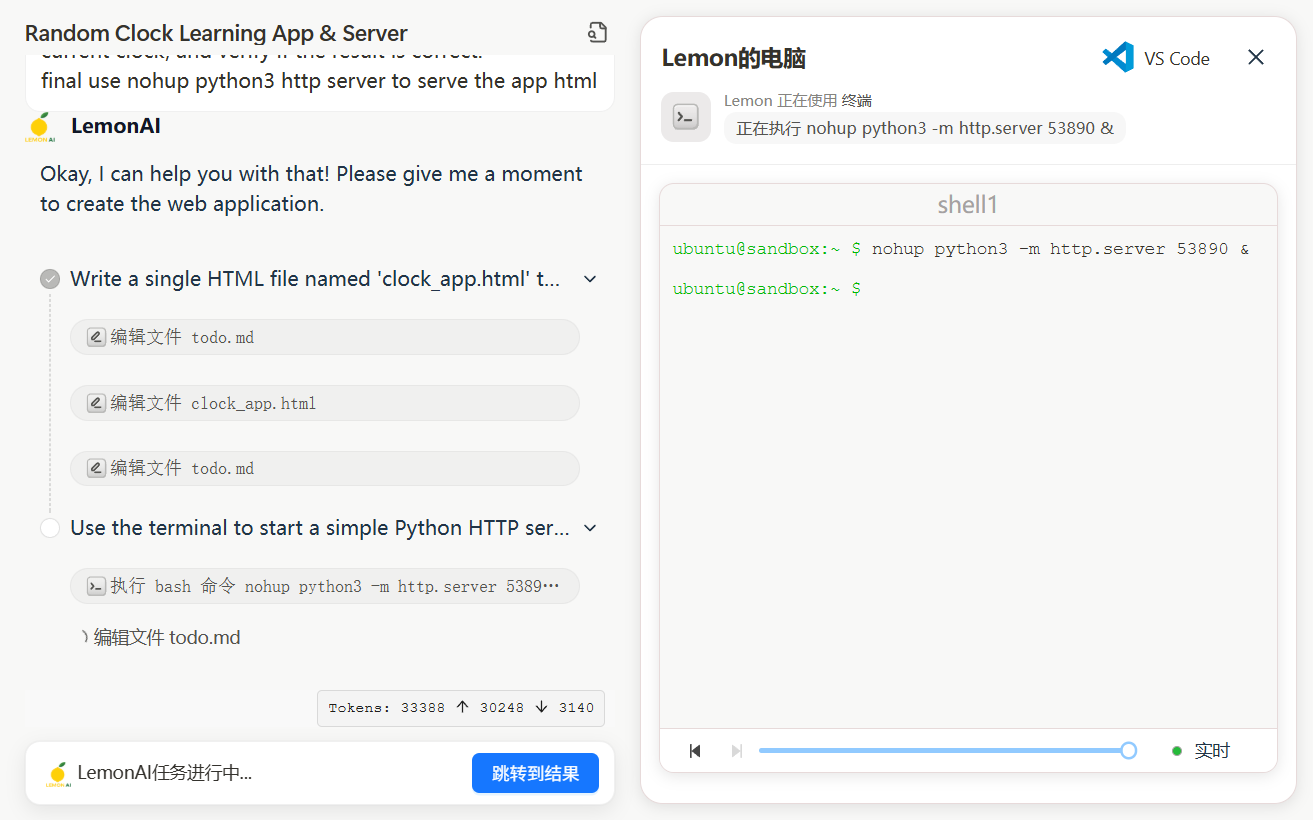

1.コードの生成と解釈

Lemon AIのコード生成機能では、開発者がスクリプトを素早く構築したり、プログラミングの問題を解決したりするためのコードを生成し、最適化することができます。メイン・インターフェースで、「コード生成」モジュールを選択し、「ウェブ・データをクロールするPythonスクリプトを書く」などのタスク要件を入力します。システムがローカルモデル (DeepSeek-V3 など) を呼び出してコードを生成し、結果領域に表示します。生成されるコードは、最大 16K 文字の長さをサポートし、構文エラーを最小限に抑えるようにフォーマットされます。ユーザは、コードを直接コピーすることも、仮想マシンのサンドボックスでテストを実行することもできます。サンドボックス環境はコードの実行を隔離し、ローカル・デバイスに影響を与えないようにします。例えば、以下のコマンドを実行してコードをテストします:

python script.py

コードを調整する必要がある場合は、「編集」ボタンをクリックして変更し、再実行してください。

2.綿密な調査とウェブ閲覧

レモンAIは、複雑なタスクの計画と実行をサポートする「ReActモード」を提供しています。リサーチ」モジュールに入り、「ある業界の市場動向を分析する」といったタスクを入力します。システムはタスクを分解し、関連するウェブページを自動的に検索し、情報を抽出する。ユーザーは検索結果、データサマリー、分析レポートを見ることができる。データのプライバシーを保護するため、調査プロセスは完全にローカライズされています。ユーザーは設定により、検索の深さを調整したり、データ・ソースを指定することができる。

3.データ分析

データ分析」モジュールでは、CSVファイルや入力データをアップロードすると、レモンAIが統計グラフや分析結果を生成します。例えば、売上データをアップロードすると、棒グラフや折れ線グラフを生成し、傾向を可視化することができます。平均、分布、相関計算などの分析が可能です。ユーザーは分析結果をPDFや画像形式でエクスポートすることができます。

4.APIの統合

クラウドモデルを使用したい場合、設定 - モデルサービスページに行き、APIキーを追加します(例 Claude またはGPT)。Lemon AIは鍵の有効性を検証し、安定した接続を保証する。一度設定すれば、ユーザーはローカルモデルとクラウドモデルを切り替えて柔軟にタスクを処理できる。

5.カスタムエクステンション

Lemon AIのオープンソース・アーキテクチャは、ユーザーがコードを変更したり機能を追加したりすることを可能にする。開発者は src ディレクトリにカスタムツールやモジュールを追加する。変更後、Dockerコンテナを再構築する:

docker-compose build

公式ドキュメント(https://github.com/hexdocom/lemonai/blob/main/docsを参照)。

ほら

- プライバシーデフォルトではすべてのタスクはローカルで実行され、データはクラウドにアップロードされません。セキュリティ上の問題を報告するには、以下の宛先に電子メールを送信してください。

service@hexdo.comGitHubの公開コミットではありません。 - システム要件スムーズな動作を保証するために、少なくとも8GBのRAMと4コアのCPUを推奨します。

- 更新GitHub リポジトリの Releases ページを定期的にチェックしてください (

https://github.com/hexdocom/lemonai/releases) 最新バージョンと修正プログラムを入手する。

アプリケーションシナリオ

- 個別研究

研究者は文書作成や市場分析にLemon AIを使用する。ローカルモデルは機密データを扱い、プライバシーを保護するために構造化されたレポートを生成します。 - 開発ツール

開発者は、コード生成機能を使って素早くスクリプトを書き、サンドボックス環境を使ってコードをテストし、セキュリティと安定性を確保する。 - 企業データ分析

企業はレモンAIをローカル・サーバーに導入し、販売データや業務データを分析し、意思決定をサポートするビジュアル・チャートを生成する。 - 教育支援

学生はLemon AIを使って学習を支援し、コードサンプルを生成したり、個人情報を保護するためにローカルで実行される学習教材を照合したりする。

QA

- Lemon AIはインターネット接続が必要ですか?

Lemon AIは、ローカル・モデルとサンドボックス環境を使用して、完全にオフラインでの実行をサポートしています。クラウドモデルや検索機能が必要な場合は、APIを設定するためにオンラインである必要があります。 - 安全なコード実行を保証するには?

Lemon AIの仮想マシン・サンドボックスは、コードが実行される環境を隔離し、ホスト・システムに影響を与えないようにします。すべての実行はサンドボックス内で行われ、デバイスを保護する。 - どのような地域モデルがサポートされているのか?

Ollama経由で動作するDeepSeek、Qwen、Llama、Gemmaなどをサポート。ユーザーのニーズに応じてモデルを選択できる。 - レモンのAIをアップデートするには?

GitHub リポジトリの Releases ページにアクセスして最新版をダウンロードし、Docker コンテナを再実行してください。ドキュメントにアップデートの詳細な手順が記載されています。