DeepInfraは、開発者向けにAIモデル呼び出しサービスを提供するクラウドプラットフォームである。ユーザーはシンプルなAPIインターフェースを通じて、Meta Llama 3、Mistral AI、Google Gemmaなど、さまざまな主流のオープンソースAIモデルにアクセスし、実行することができる。 このプラットフォームの最大の特徴は「サーバーレス」であることで、ユーザーは複雑なサーバーハードウェアを導入・維持する必要がなく、使用量に応じて直接料金を支払うことができるため、AIアプリケーションの開発・運用保守の敷居を大幅に下げることができる。 DeepInfraチャットは、プラットフォームが提供する直感的なデモページで、ユーザーはプラットフォーム上に配置された様々な大規模言語モデルと直接会話し、様々なモデルの性能や特性を体感することができる。また、APIサービスの実際の結果も表示されるため、開発者は自社のアプリケーションに統合するモデルを迅速にテスト・評価することができる。

機能一覧

- マルチモデル対応このプラットフォームは、Llama、Mistral、Gemmaなどのオープンソースの大規模言語モデルを豊富に提供しています。

- オンライン・チャット・インターフェース登録や設定なしで、ユーザーがテスト用に選択したAIモデルと直接対話できるクリーンなウェブチャットウィンドウを提供します。

- APIコールサービス核となる機能は、開発者に安定した拡張可能なAPIインターフェースを提供し、AIモデルの機能を自社のソフトウェアやサービスに簡単に統合できるようにすることです。

- 必要に応じて支払う使用ごと(通常はトークン数ごと)の課金モデルを採用することで、ユーザーは実際に消費されたコンピューティング・リソースに対してのみ料金を支払うことになり、コスト効率に優れています。

- 本番環境ですぐに使える開発者が機械学習オペレーション(ML Ops)の複雑さに対処する必要のない、スケーラブルで低レイテンシーのプロダクショングレードのインフラを提供します。

- 開発者ツールの統合LangChainやLlamaIndexといった主流のAI開発フレームワークとの統合をサポートし、複雑なAIアプリケーションの構築プロセスを簡素化します。

ヘルプの使用

DeepInfra Chatは、様々な大規模言語モデルを素早く体験し、レビューしたい一般ユーザーと、AIモデル機能を製品に統合する必要がある開発者の2つのタイプのユーザーを対象としています。それぞれの使い方については後述する。

1.ウェブベースのチャット機能(クイック・エクスペリエンス)

AIモデルの対話能力を直接体験したい人にとっては、使い方はとても簡単だ:

- ウェブサイトへのアクセスブラウザでウェブサイトを開く

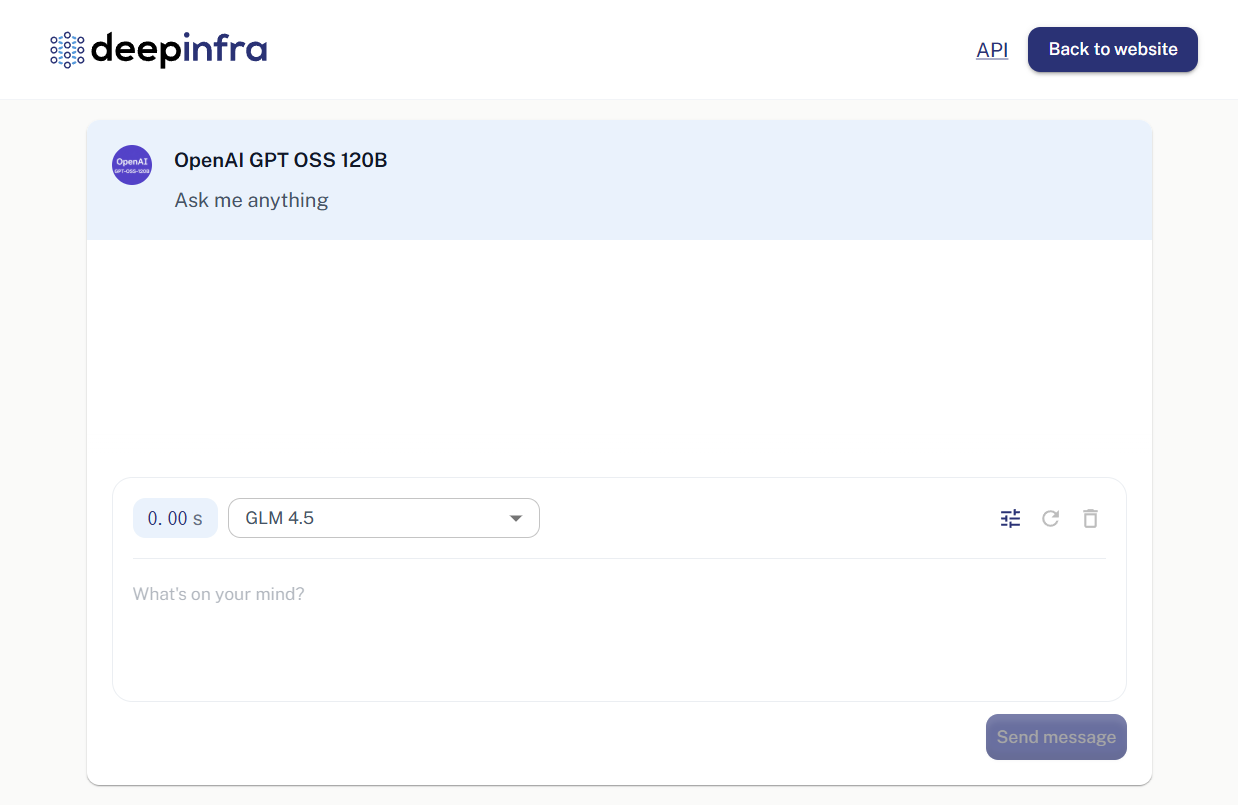

https://deepinfra.com/chat。 - モデルを選択ページがロードされると、チャットインターフェースが表示されます。インターフェースの上部には通常、現在使用中のモデル名が表示されます(例:"OpenAI GPT OSS 120B")。モデル名をクリックすると、Llama 3やMistralシリーズなど、興味のある他のモデルをドロップダウンリストから選択して切り替えることができます。

- 対話の開始ページ下部の入力ボックスに、質問したいことや言いたいことを入力し、エンターキーを押すか、送信ボタンをクリックしてください。

- 返信を見るAIモデルからの応答は、チャットウィンドウに直接表示されます。あなたは質問を続け、モデルの論理的、言語的、知的能力をテストするために何度も対話をすることができます。

このプロセスはログインや設定を必要とせず、モデルを素早くレビューするのに最適です。

2.APIコールサービス(開発者が利用)

開発者にとってのDeepInfraのコアバリューは、その強力なAPIサービスです。APIを介して、これらのAIモデルの機能をウェブサイト、アプリ、またはバックエンド・サービスに統合することができます。

ステップ1: アカウントの作成とAPIキーの取得

- 登録/ログインディープインフラのウェブサイトへ

https://deepinfra.com/通常、GitHubアカウントを使って直接ログインできます。 - APIキーの生成ログイン後、アカウントのダッシュボードにアクセスし、APIキーの管理ページを見つけます。

https://deepinfra.com/dash/api_keys)。 - 新しいキーの作成New API Key "ボタンをクリックし、キーに名前を付けて(例:"MyTestApp")、"Generate "をクリックします。

- キーを保存するで始まる文字列を生成する。

di-文字がAPIキーです。すぐにコピーして大切に保管してください。セキュリティ上の問題から、この完全なキーは一度しか表示されない。

ステップ2:APIを呼び出す

DeepInfraのAPIエンドポイントはOpenAIのフォーマットと互換性があり、移行や利用が容易です。コアとなるチャットAPIエンドポイントは以下の通りです:

https://api.deepinfra.com/v1/openai/chat/completions

HTTPリクエストをサポートするツールやプログラミング言語であれば、どのようなものでも呼び出すことができる。

利用する curl コマンドの簡単な例:

ターミナルを開き {YOUR_API_KEY} 先ほど生成したキーに置き換える。{MODEL_ID} これを呼び出したいモデルのIDに置き換える(例えば meta-llama/Meta-Llama-3-8B-Instruct)。

curl -X POST https://api.deepinfra.com/v1/openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer {YOUR_API_KEY}" \

-d '{

"model": "{MODEL_ID}",

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

]

}'

Pythonの使用例:

をインストールする必要があります。 requests ライブラリー pip install requests )。

import requests

import json

# 替换成你的API密钥

api_key = "{YOUR_API_KEY}"

# 替换成你想使用的模型ID

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

url = "https://api.deepinfra.com/v1/openai/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": model_id,

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

],

"stream": False # 如果需要流式输出,可以设置为True

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

# 打印出模型返回的内容

print(result['choices'][0]['message']['content'])

else:

print(f"请求失败,状态码: {response.status_code}")

print(response.text)

サポートされているすべての DeepInfra の公式ドキュメントは、以下のとおりです。モデルIDリスト。

アプリケーションシナリオ

- AIチャットボット開発

ウェブサイト、アプリ、社内システム向けに、カスタマーサービスボット、インテリジェントアシスタント、またはドメイン固有のQ&Aボットを構築できます。開発者は、コストとパフォーマンスの要件に基づいて、さまざまなモデルを柔軟に選択できます。 - コンテンツ作成支援

このモデルのテキスト生成機能を使って、マーケティングコピー、ブログ記事、コード、電子メール、またはテキストのタッチアップの作成を支援します。 - 教育・研究

研究者や学生はこのプラットフォームを利用することで、高額なハードウェア導入コストをかけることなく、最先端のオープンソースAIモデルを幅広く簡単に呼び出し、テストすることができる。 - 迅速なプロトタイプ検証

プロダクトマネージャーや開発者は、製品開発の初期段階でDeepInfraを使用することで、AI機能を含むプロトタイプを迅速に構築し、機能検証や結果のデモンストレーションを行うことができます。

QA

- DeepInfra Chatは無料ですか?

ウェブ版のチャット・エクスペリエンスは無料だが、一定の使用制限があり、主に機能のデモンストレーションやモデルのレビューに使用される。 APIを通じて呼び出す場合は、選択したモデルと要求されたトークンの数に応じて支払う必要があり、プラットフォームは一定量の無料トライアル・コンピューティング・リソースを提供する。 - どのようなAIモデルを使用できますか?

DeepInfraは、MetaのLlamaシリーズ(Llama 3など)、Mistral AIのモデル、GoogleのGemma、CodeLlamaなどのコード生成に特化したモデルを含むがこれらに限定されない、主流のオープンソースのビッグ言語モデルを幅広くサポートしている。 具体的な対応モデル一覧は公式サイトで確認できる。 - このプラットフォームの主なユーザーは?

AIアプリケーション開発者、技術研究者、AI機能を既存のビジネスに統合しようとしている企業を対象としている。また、ウェブチャット機能は、AI技術に興味があり、さまざまなモデル機能を体験したい一般ユーザーにも適している。 - APIを使用するために、独自のサーバーを設定する必要がありますか?

DeepInfraは、すべてのモデルをホストし、実行し、弾力的にスケールする「サーバーレス」プラットフォームです。開発者はAPIキーを介してリクエストを開始するだけでよく、基盤となるハードウェアや運用について心配する必要はない。