CoreはRedPlanetHQによって開発されたオープンソースのツールで、大規模モデル(LLM)向けにパーソナライズされたメモリー保存機能を提供することを目的としている。Coreを使えば、ユーザーは自分自身のメモリーマップを構築・管理し、テキストやダイアログ、その他のデータをプライベートな知識ベースに保存することができる。このツールは、構造化されたメモリーノードを形成するために、ユーザーとビッグモデルとのインタラクションの記録を保存することをサポートしており、その後に簡単にクエリーを実行したり、他のツールに接続したりすることができます。Coreは、開発者とカジュアルユーザーの両方のために、シンプルさを念頭に置いて設計されています。直感的なダッシュボードで操作でき、さまざまなユーザーのニーズを満たすためにローカルデプロイとクラウドサービスの両方をサポートしている。このプロジェクトは現在活発な開発段階にあり、特に大規模モデルのメモリ最適化のために継続的な改善が行われている。

機能一覧

- 記憶装置ユーザーが入力したテキストやダイアログをナレッジグラフに保存します。

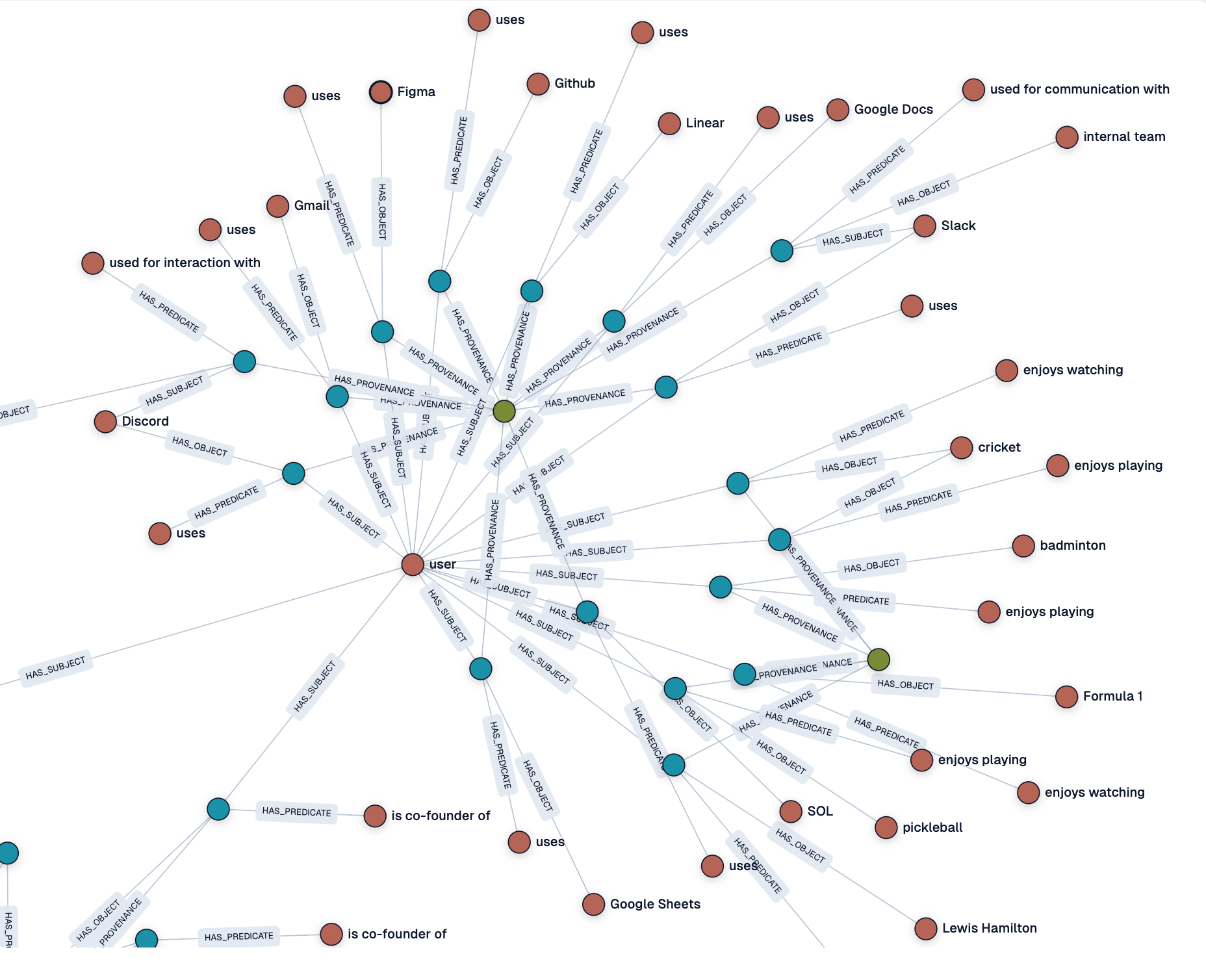

- 知識グラフの生成簡単に検索できるように、入力を構造化されたメモリノードに自動的に変換します。

- ダッシュボード管理メモリマップのノードと状態を表示、管理するための視覚的なインターフェイスを提供します。

- ローカルおよびクラウド展開に対応ユーザーはローカルで実行するか、Core Cloudサービスを利用するかを選択できる。

- 大規模モデルとの統合相互作用の記録を保存するための様々な大規模モデルとのインターフェイスをサポートします。

- ログ監視メモリー処理のログをリアルタイムで表示し、データ処理の状況を把握できる。

- オープンソースプロジェクトユーザーは自由にコードにアクセスし、機能の開発やカスタマイズに参加することができます。

ヘルプの使用

設置プロセス

Core を使用するには、まずインストールと環境設定が必要です。以下は、インストールと使用方法の詳細です:

- クローン倉庫:

- ターミナルを開き、以下のコマンドを実行してCoreリポジトリをクローンする:

git clone https://github.com/RedPlanetHQ/core.git - プロジェクト・カタログにアクセスする:

cd core

- ターミナルを開き、以下のコマンドを実行してCoreリポジトリをクローンする:

- 依存関係のインストール:

- CoreはNode.js環境を使用しており、Node.jsの最新バージョン(16.x以上を推奨)をインストールすることを推奨します。

- 依存パッケージをインストールします:

npm install

- 環境変数の設定:

- プロジェクトのルート・ディレクトリに

.envファイルに以下を追加する:API_TOKEN=YOUR_API_TOKEN_HERE API_BASE_URL=https://core.heysol.ai SOURCE=cursor API_TOKENCore Cloudの公式サイト(https://core.heysol.ai)からアカウントを登録した後に入手する必要がある。

- プロジェクトのルート・ディレクトリに

- ローカルサービスの運営:

- Coreのメモリーコントロールパネル(MCP)を起動する:

npx -y @redplanethq/core-mcp - サービスが開始されたら、ブラウザを開き、次のサイトにアクセスする。

http://localhost:3000。

- Coreのメモリーコントロールパネル(MCP)を起動する:

- コアクラウドの使用(オプション):

- クラウドサービスを選択した場合は、https://core.heysol.ai、アカウントに登録してログインします。

- ローカルに展開することなく、クラウドダッシュボードで直接メモリを管理。

主な機能

1.思い出の追加

- 手続き:

- ログインダッシュボード(ローカルまたはクラウド)。

- 右上の入力ボックスに、保存したいテキストを入力します。例:「バドミントンをするのが好きです」。

- 追加」ボタンをクリックすると、テキストが処理キューに送られます。

- ログ」画面で処理状況を確認し、終了するとダッシュボードにメモリーノードが表示されます。

- 機能説明:

- 追加されたテキストごとにメモリーノードが自動的に生成され、そのノードにはテキストの内容とメタデータ(タイムスタンプなど)が含まれる。

- これらのノードは、その後のクエリや分析のための知識グラフを形成するために接続することができる。

2.メモリの表示と管理

- 手続き:

- ダッシュボードの "Graph "ページを開き、すべてのメモリーノードを見る。

- ノードをクリックすると詳細が表示され、編集することもできます。

- 検索機能をサポートし、キーワードを入力すると、関連する思い出をすばやく見つけることができます。

- 機能説明:

- ダッシュボードは、ノード間の関係が一目でわかる視覚的なナレッジグラフを提供します。

- ユーザーは手動でノードの接続を調整したり、不要なメモリを削除したりできる。

3.大型モデルとの統合

- 手続き:

- 設定ページで、マクロモデル・ダイアログを自動的に保存するルールを追加する:

- 設定」→「ユーザールール」→「新規ルール」を開く。

- ユーザーのクエリとモデルの応答が、対話のたびにCoreメモリに保存されるようにルールを追加する。

- セットアップ

sessionIdはダイアログの一意識別子(UUID)である。

- ルール設定例:

{ "mcpServers": { "memory": { "command": "npx", "args": ["-y", "@redplanethq/core-mcp"], "env": { "API_TOKEN": "YOUR_API_TOKEN_HERE", "API_BASE_URL": "https://core.heysol.ai", "SOURCE": "cursor" } } } }

- 設定ページで、マクロモデル・ダイアログを自動的に保存するルールを追加する:

- 機能説明:

- Coreは、大規模なモデルとのユーザー・インタラクションを自動的にキャプチャし、構造化データとして保存する。

- 幅広い大型モデルをサポートしているが、ラマ・モデルのサポートは将来的な互換性向上のため、現在最適化中である。

4.ログ監視

- 手続き:

- ダッシュボードの「ログ」ページを開く。

- メモリの追加、処理状況、エラーメッセージなどのリアルタイム処理ログを表示します。

- 機能説明:

- ロギング機能は、ユーザーがデータ処理の流れを監視し、データ保存の信頼性を確保するのに役立ちます。

- 処理に失敗した場合、ログにエラーの詳細が記録され、トラブルシューティングが容易になります。

ほら

- ローカル展開ネットワークが安定しており、ポート3000が占有されていないことを確認してください。

- クラウドサービス安定したAPIキーが必要で、キーの有効性は定期的にチェックされます。

- ラマモデル・サポート現在のところ、CoreはLlamaモデルとの互換性が限られているため、最良の結果を得るためには他の主要モデルの使用を推奨する。

- 地域支援もし問題が発生したら、GitHubに問題を提出するか、コミュニティのディスカッションに参加することができます。

アプリケーションシナリオ

- 個人の知識管理

- ユーザーはCoreを使用して、日々の学習メモ、インスピレーション、重要な会話などを保存し、個人的な知識ベースを形成することができます。例えば、学生は授業のノートをメモリーノードとして保存し、簡単に復習することができます。

- 開発者による大規模モデルのデバッグ

- 開発者は、大規模なモデルとのインタラクションを記録し、モデルの出力を分析し、プロンプト設計を最適化することができます。例えば、チャットボットをデバッグする際、Coreはすべてのテスト会話を保存することができます。

- チームワーク

- チームメンバーは、Core Cloudを通じてメモリーマップを共有し、プロジェクトのナレッジベースを共同で構築することができます。例えば、製品チームはユーザーからのフィードバックをCoreに預け、要件分析マップを作成することができます。

- 研究支援

- 研究者は、文献の要約や実験データをCoreに保存し、その後の分析や引用のために構造化された研究メモリを形成することができます。

QA

- Coreはどのような大型モデルをサポートしていますか?

- Coreは現在、主要なビッグモデルの多くをサポートしているが、ラマモデルとの互換性はまだ最適化されていない。最良の結果を得るためには、他のモデルを使用することをお勧めします。

- ローカル展開とクラウドサービスの違いは?

- 一方、クラウド・サービスはインストールが不要で、すぐに利用できる。

- メモリーデータのセキュリティを確保するには?

- ローカルに配置されたメモリー・データは、ユーザーによってセキュリティが管理された状態でユーザーのデバイスに保存される。クラウド・サービスでは、安全なデータ・アクセスを保証するために、APIキーによる暗号化通信が使用される。

- Coreは完全に無料ですか?

- Coreはオープンソースのプロジェクトで、ローカルに導入する場合は無料。クラウドサービスにはサブスクリプション料金がかかる場合があるので、価格については公式サイトを確認してほしい。