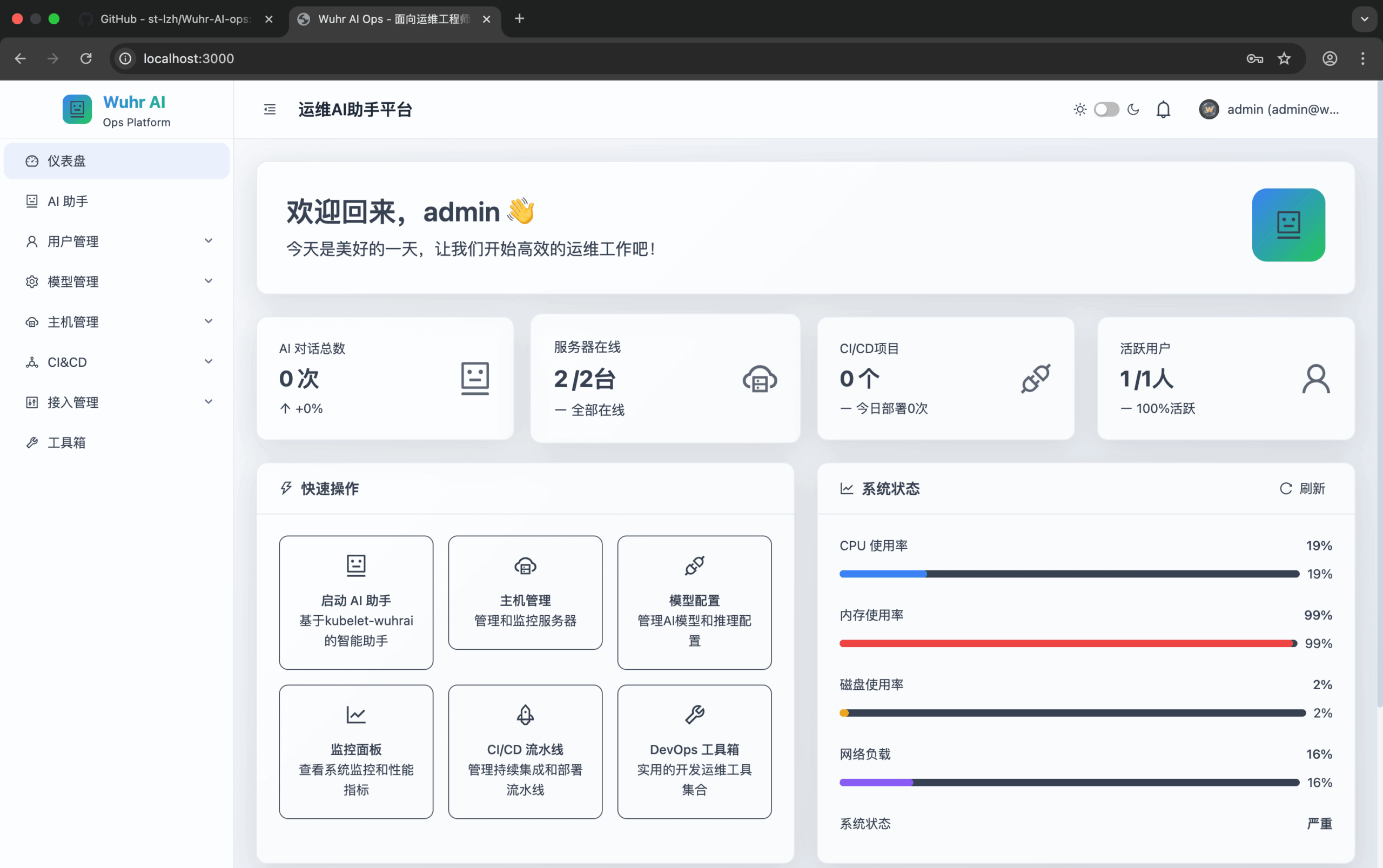

Wuhr-AI-ops ist eine Open-Source-Plattform für intelligentes O&M-Management, die multimodale KI-Assistenten, Echtzeitüberwachung, Protokollanalyse und CI/CD-Management integriert. Sie vereinfacht komplexe O&M-Aufgaben durch KI-Technologie und hilft O&M-Teams, IT-Systeme effizient zu verwalten. Die Plattform unterstützt natürlichsprachliche Operationen und kombiniert gängige KI-Modelle wie GPT-4o und Gemini, um eine Lösung aus einer Hand zu bieten. Wuhr-AI-ops eignet sich für Unternehmen oder Teams, die die Verwaltung lokaler und entfernter Hosts vereinheitlichen müssen. Der Code wird auf GitHub gehostet, was es für Entwickler einfach macht, Beiträge zu leisten und Anpassungen vorzunehmen.

Funktionsliste

- Intelligenter AI-AssistentUnterstützt die Eingabe in natürlicher Sprache, ruft Modelle wie GPT-4o und Gemini auf und führt O&M-Aufgaben aus.

- Ausführung von Multimodus-BefehlenUnterstützung von Kubernetes-Clustern und Linux-Systembefehlen, intelligente Switching-Ausführungsumgebung.

- Echtzeit-ÜberwachungELK-Protokollanalyse und Grafana-Leistungsüberwachung integrieren, um den Systemstatus in Echtzeit anzuzeigen.

- CI/CD-VerwaltungUnterstützt automatisierte Deployment-Pipelines und integriert sich mit Jenkins für einen effizienten Entwicklungsprozess.

- RechteverwaltungRollenbasierte Zugangskontrolle, Einrichtung von Genehmigungsverfahren und Gewährleistung der Systemsicherheit.

- Unterstützung mehrerer UmgebungenEinheitliche Verwaltung von lokalen und entfernten Hosts zur Vereinfachung von Betrieb und Wartung in mehreren Umgebungen.

Hilfe verwenden

Einbauverfahren

Um Wuhr-AI-ops zu verwenden, muss es in einer Umgebung installiert werden, die Node.js und Docker unterstützt. Hier sind die detaillierten Installationsschritte:

- Klonprojekt:

git clone https://github.com/st-lzh/wuhr-ai-ops.git cd wuhr-ai-ops

Dadurch wird der Projektcode lokal heruntergeladen und in das Projektverzeichnis verschoben.

- Umgebungsvariablen konfigurieren:

Kopieren Sie die Beispiel-Umgebungsvariablendatei und bearbeiten Sie sie:cp .env.example .envÖffnen mit einem Texteditor

.envDatei, um die Datenbankverbindungsinformationen und den API-Schlüssel für das AI-Modell zu konfigurieren. Beispiel:DATABASE_URL=postgresql://user:password@localhost:5432/wuhrai OPENAI_API_KEY=sk-xxxAchten Sie darauf, dass Sie die richtige Datenbankadresse und einen gültigen API-Schlüssel eingeben.

- Einrichten von npm-Spiegeln (für heimische Nutzer):

Um die Installation von Abhängigkeiten zu beschleunigen, konfigurieren Sie die npm-Spiegelquelle:npm config set registry https://registry.npmmirror.com/ - Werkzeug kubelet-wuhrai herunterladen:

Herunterladen und Ausführungsberechtigungen festlegen:wget -O kubelet-wuhrai https://wuhrai-wordpress.oss-cn-hangzhou.aliyuncs.com/kubelet-wuhrai chmod +x kubelet-wuhrai - Starten von Datenbankdiensten:

Starten von PostgreSQL, Redis und pgAdmin mit Docker Compose:docker-compose up -d postgres redis pgadmin sleep 30Warten Sie 30 Sekunden, um sicherzustellen, dass der Dienst vollständig gestartet ist.

- Installation von Abhängigkeiten:

Führen Sie den folgenden Befehl aus, um die Projektabhängigkeiten zu installieren:npm install - Initialisierung der Datenbank:

Initialisieren Sie die Datenbankstruktur und die Daten:npx prisma migrate reset --force npx prisma generate npx prisma db push - Initialisierung von Benutzern und Berechtigungen:

Führen Sie das folgende Skript aus, um den Administratorbenutzer und die Berechtigungen festzulegen:node scripts/ensure-admin-user.js node scripts/init-permissions.js node scripts/init-super-admin.ts - Initialisierung von voreingestellten Modellen und ELK-Vorlagen:

Konfigurieren Sie AI-Modelle und Vorlagen für die Protokollanalyse:node scripts/init-preset-models.js node scripts/init-elk-templates.js - Starten des Entwicklungsservers:

Starten Sie die Entwicklungsumgebung:npm run devSobald das Projekt gestartet ist, kann über einen Browser auf den lokalen Dienst zugegriffen werden (der Standardport hängt von der Konfiguration ab).

- Durchführung von Tests (optional):

Überprüfen Sie, ob das Projekt ordnungsgemäß funktioniert:npm test

Verwendung der Hauptfunktionen

Intelligenter AI-Assistent

Die Kernfunktion von Wuhr-AI-ops ist ein intelligenter KI-Assistent. Benutzer können O&M-Befehle in natürlicher Sprache eingeben, wie z.B. "Check logs in production" oder "deploy latest code to test server". Der KI-Assistent analysiert die Befehle, ruft das GPT-4o oder Gemini-Modell auf, generiert entsprechende Befehle und führt sie aus. Ausführen. Die Schritte sind wie folgt:

- Loggen Sie sich in die Web-Oberfläche von Wuhr-AI-ops ein.

- Geben Sie Befehle in natürlicher Sprache in das Eingabefeld des KI-Assistenten ein.

- Das System analysiert automatisch die Ausführungsergebnisse und zeigt sie an, z. B. in Form von Berichten zur Protokollanalyse oder zum Einsatzstatus.

- Wenn Sie das KI-Modell anpassen müssen, können Sie dies in der

.envDatei, um den API-Schlüssel zu ersetzen.

Echtzeit-Überwachung

Die Plattform ist mit ELK und Grafana für die Echtzeitüberwachung der Systemleistung und Protokollierung integriert:

- ELK-Log-AnalyseWählen Sie in der Weboberfläche das Modul "Protokollanalyse", um die Systemprotokolle einzusehen. Benutzer können den Zeitbereich oder Schlüsselwörter filtern, um die Fehlerprotokolle schnell zu finden. Geben Sie zum Beispiel "error" ein, um alle Fehlerprotokolle anzuzeigen.

- Grafana LeistungsüberwachungZugriff auf das Grafana-Dashboard zur Anzeige von Metriken wie CPU, Speicher, Netzwerk und mehr. Benutzer können das Dashboard anpassen, um spezifische Überwachungselemente hinzuzufügen, z. B. den Kubernetes-Pod-Status.

CI/CD-Verwaltung

Wuhr-AI-ops unterstützt automatisierte Deployment-Pipelines mit Jenkins-Integration:

- Wählen Sie in der Weboberfläche das Modul "CI/CD Management".

- Konfigurieren Sie Jenkins-Aufgaben, wie z. B. das Festlegen der Adresse des Code-Repositorys und des Bereitstellungsziels.

- Bereitstellungen werden durch Befehle in natürlicher Sprache ausgelöst, z. B. "main branch to production".

- Das System führt die Jenkins-Pipeline automatisch aus und gibt die Ergebnisse der Bereitstellung zurück.

Rechteverwaltung

Die Plattform unterstützt eine rollenbasierte Zugangskontrolle:

- Administratoren können über das Modul Rechteverwaltung Benutzer und Rollen hinzufügen.

- Richten Sie Genehmigungsverfahren ein, z. B. müssen leitende Verwaltungsangestellte risikoreiche Vorgänge genehmigen.

- Um die Sicherheit des Systems zu gewährleisten, können Benutzer nur auf die Funktionen zugreifen, für die sie in ihrer Rolle berechtigt sind, nachdem sie sich angemeldet haben.

caveat

- Stellen Sie sicher, dass die Docker- und Node.js-Versionen mit den Projektanforderungen kompatibel sind (siehe GitHub-Dokumentation).

- Inländischen Benutzern wird empfohlen, das chinesische Installationsskript zu verwenden

./install-zh.shVon ausländischen Nutzern verwendet./install-en.sh。 - Prüfen Sie das GitHub-Repository regelmäßig auf Updates für die neuesten Funktionen und Fehlerbehebungen.

Anwendungsszenario

- IT-Betrieb im Unternehmen

Wuhr-AI-ops ist für die Verwaltung komplexer Unternehmens-IT-Systeme geeignet. Ops-Teams können Probleme schnell mit natürlicher Sprache beheben, z. B. bei der Analyse von Serverprotokollen oder der Überwachung der Leistung von Kubernetes-Clustern, was den Zeitaufwand für manuelle Aufgaben reduziert. - Zusammenarbeit im Entwicklungsteam

Entwicklungsteams können CI/CD-Management-Funktionen nutzen, um die Bereitstellung von Code in Test- oder Produktionsumgebungen zu automatisieren. In Kombination mit der Rechteverwaltung wird sichergestellt, dass nur autorisierte Mitarbeiter sensible Vorgänge durchführen können. - Multi-Umwelt-Management

Für Unternehmen, die sowohl lokale als auch Cloud-Hosts verwalten müssen, bietet die Plattform eine einheitliche Schnittstelle, die umgebungsübergreifende Aufgaben wie die Synchronisierung der Konfiguration oder die Überwachung von Remote-Servern vereinfacht.

QA

- Welche KI-Modelle werden von Wuhr-AI-ops unterstützt?

Die Plattform unterstützt viele gängige multimodale KI-Modelle wie GPT-4o und Gemini. Weitere Informationen finden die Nutzer auf der.envDatei, um den API-Schlüssel für den Modellwechsel zu konfigurieren. - Wie kann ich mein System sichern?

Die Plattform gewährleistet Sicherheit durch rollenbasierte Zugriffskontrolle und Genehmigungsprozesse. Für sensible Vorgänge ist die Genehmigung eines Administrators erforderlich, und Protokolle und Berechtigungsänderungen sind nachvollziehbar. - Ist es für kleine Teams geeignet?

Ja, Wuhr-AI-ops ist quelloffen und auch für kleine Teams leicht zu implementieren. Seine natürlichsprachlichen Operationen senken die technische Barriere. - Wie gehe ich mit Abhängigkeitsfehlern in meiner Installation um?

Überprüfen Sie die Node.js- und npm-Versionen auf Kompatibilität und verwenden Sie inländische Mirrors, um die Downloads zu beschleunigen. Wenn das Problem weiterhin besteht, prüfen Sie die GitHub Issues-Seite oder melden Sie einen Fehler.