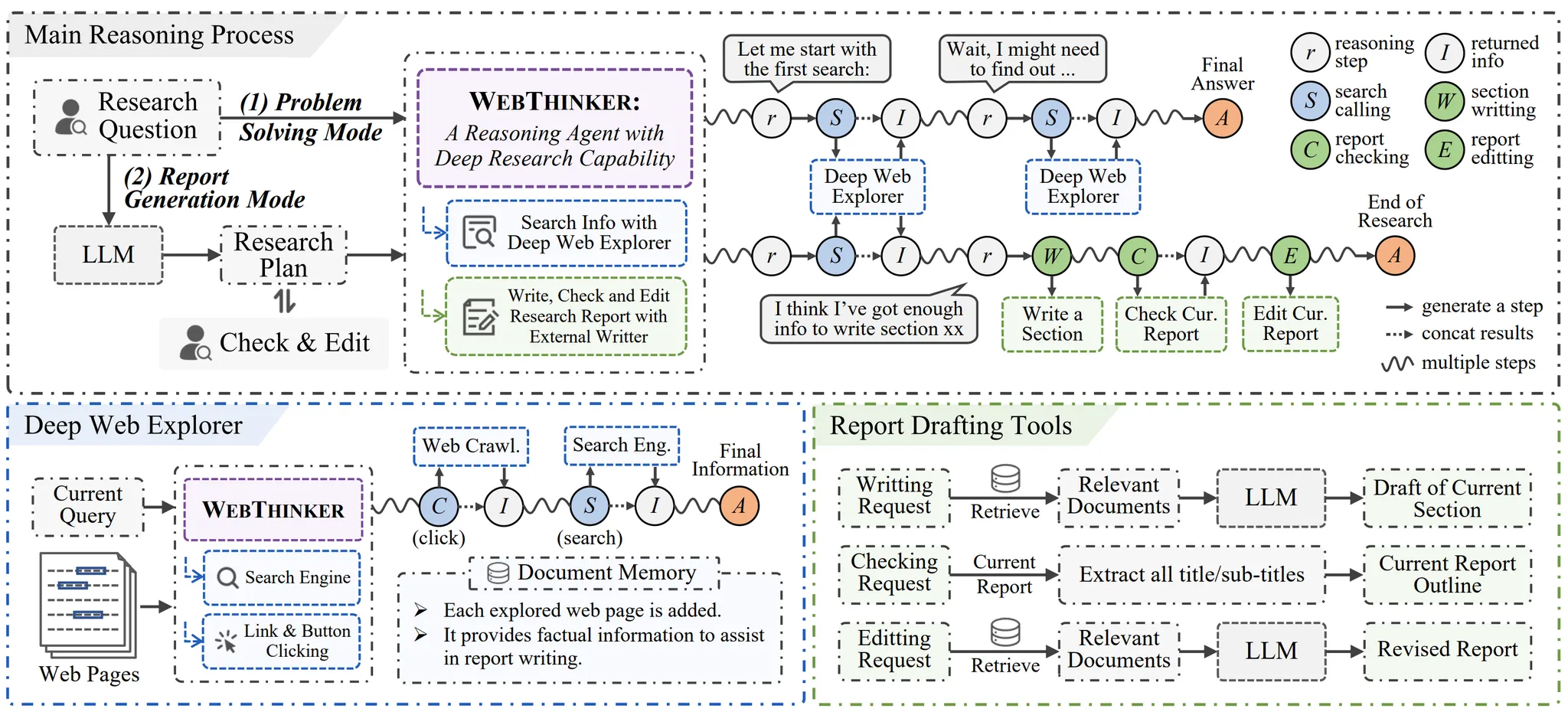

WebThinker ist ein Open-Source-Projekt, das die autonomen Forschungsfähigkeiten von Large-Scale Reasoning Models (LRMs) verbessern soll. Es ermöglicht den Modellen, während des Schlussfolgerungsprozesses selbstständig Websuche, Navigation und Informationsextraktion durchzuführen und schließlich detaillierte Berichte zu erstellen. Das Projekt wird vom Information Retrieval and Natural Language Processing Laboratory der Renmin University of China (RUC-NLPIR) entwickelt und basiert auf dem QwQ-32B WebThinker durchbricht die Beschränkungen der traditionellen Retrieval Augmentation Generation (RAG) mit einem Modell, das Such- und Navigationsoperationen direkt durchführt und eine durchgängige Aufgabenbearbeitung ermöglicht. Es zeichnet sich durch wissensintensive, komplexe Schlussfolgerungsaufgaben (z.B. GPQA, GAIA, WebWalkerQA, HLE) und Aufgaben zur Erstellung von Berichten mit offenem Ende aus, wodurch die Zeit und die Kosten der Informationsbeschaffung für Forscher drastisch reduziert werden. Das Projekt steht unter der MIT-Lizenz, und der Code und die Dokumentation sind für Forscher und Entwickler öffentlich auf GitHub verfügbar.

Funktionsliste

- Autonome Websuche: Das Modell kann automatisch eine Suche einleiten und relevante Informationen auf der Grundlage der Aufgabenanforderungen extrahieren.

- Deep-Web-Navigation: Unterstützt das Anklicken von Links oder Schaltflächen, um Webinhalte in der Tiefe zu erkunden.

- Automatische Berichtserstellung: Schreiben Sie Berichte während Ihrer Suche und generieren Sie strukturierte, benutzerdefinierte Inhalte.

- Berichtsbearbeitung und -überprüfung: Bietet Werkzeuge zur Überprüfung und Überarbeitung von Berichten, um die Genauigkeit und Konsistenz des Inhalts sicherzustellen.

- Unterstützung mehrerer Inferenzmodi: Führen Sie verschiedene Aufgabenmodi über Skripte aus, um sich an unterschiedliche Anforderungen anzupassen.

- integriert (wie in integrierter Schaltung) Crawl4AI Ans: Optimieren Sie die Extraktion von mit JavaScript gerenderten Webseiten.

- Open Source und erweiterbar: Der Code ist offen und erlaubt es den Benutzern, Modelle und Funktionen anzupassen.

Hilfe verwenden

Einbauverfahren

Um WebThinker zu verwenden, müssen Benutzer die folgenden Schritte befolgen, um die Umgebung zu konfigurieren und das Projekt zu starten. Nachfolgend finden Sie eine detaillierte Installations- und Nutzungsanleitung, um sicherzustellen, dass die Benutzer schnell loslegen können.

1. die Conda-Umgebung erstellen und aktivieren

WebThinker verlässt sich auf eine Python 3.9-Umgebung, die mit Conda verwaltet werden sollte. Führen Sie den folgenden Befehl aus, um die Umgebung zu erstellen und zu aktivieren:

conda create -n webthinker python=3.9

conda activate webthinker

Dadurch wird eine Datei namens webthinker der virtuellen Umgebung, um die Isolierung von Abhängigkeiten zu gewährleisten.

2. das Projekt klonen und die Abhängigkeiten installieren

Klonen Sie das WebThinker-Repository von GitHub und installieren Sie die notwendigen Python-Pakete:

git clone https://github.com/RUC-NLPIR/WebThinker.git

cd WebThinker-main

pip install -r requirements.txt

requirements.txt Enthält alle für das Projekt erforderlichen Abhängigkeitspakete, wie z. B. die vLLM und Crawl4AI. Sorgen Sie für eine stabile Netzwerkverbindung, damit die Installation abgeschlossen werden kann.

3. die Konfiguration von Inferenzmodellen und Hilfsmodellen

WebThinker benötigt ein Inferenzmodell und ein Hilfsmodell. Die offizielle Empfehlung ist, QwQ-32B als Inferenzmodell und Qwen-32B-Instruct als Hilfsmodell für die Kerninferenz und das Lesen von Webseiten bzw. das Schreiben von Berichten zu verwenden. Die Benutzer müssen diese Modelle über vLLM bereitstellen. Stellen Sie vor der Ausführung sicher, dass die Modelle heruntergeladen und lokal oder auf dem Server gestartet wurden. Die Bereitstellungsschritte sind in der offiziellen Dokumentation zu finden (verlinkt in der README des GitHub-Repositorys).

4. einen Web-Parsing-Client einrichten

Um das Web-Crawling zu verbessern, wird empfohlen, dass die <WebThinker-main>/scripts/search/bing_search.py Der Crawl4AI-Client wird in Crawl4AI konfiguriert. Crawl4AI kann in JavaScript gerenderte dynamische Webinhalte verarbeiten, um die Zuverlässigkeit der Informationsextraktion zu verbessern. Die Benutzer müssen sich für den Crawl4AI-Dienst registrieren und einen API-Schlüssel erhalten und dann der Dokumentation folgen, um ihn zu konfigurieren.

5) WebThinker ausführen

Nach Abschluss der obigen Konfiguration kann der Benutzer verschiedene Inferenzmodi mit den bereitgestellten Skripten ausführen. Beispiel:

python scripts/run_inference.py --mode report_generation

Mit diesem Befehl wird der Berichtserstellungsmodus gestartet. Andere Modi (z. B. komplexe Schlussfolgerungsaufgaben) können im Skript angegeben werden. Stellen Sie vor der Ausführung sicher, dass der Modelldienst gestartet ist.

Hauptfunktionen

Der Kern von WebThinker ist die autonome Suche und Berichtserstellung. Unten finden Sie einen detaillierten Ablauf der Hauptfunktionen:

Autonome Websuche

Nachdem der Nutzer eine Forschungsfrage eingegeben hat, ruft WebThinker automatisch ein Suchwerkzeug (z.B. Bing Search) auf, um relevante Webseiten zu erhalten. Das Modell analysiert die ersten Suchergebnisse, extrahiert Schlüsselwörter und entscheidet, ob weitere Suchen erforderlich sind. Fragt ein Nutzer beispielsweise nach "neuesten KI-Forschungstrends", sucht WebThinker nach relevanten akademischen Artikeln und Nachrichten, um hochwertige Inhalte herauszufiltern.

Eingehende Web-Navigation

Das Deep Web Explorer Modul von WebThinker erlaubt es den Modellen, auf Links oder Schaltflächen auf einer Webseite zu klicken, um Informationen zu vertiefen. Zum Beispiel kann das Modell beim Besuch einer akademischen Website auf die Schaltfläche "Nächste Seite" oder "PDF herunterladen" klicken, um auf detailliertere Daten zuzugreifen. Ein manuelles Eingreifen ist nicht erforderlich, da das Modell automatisch ermittelt, welche Links am relevantesten sind.

Erstellung und Bearbeitung von Berichten

WebThinker bietet drei Werkzeuge für die Berichterstattung:

- Kapitel Inhalt schreibenDas Modell generiert automatisch bestimmte Abschnitte des Berichts, wie z. B. "Hintergrund" oder "Datenanalyse", basierend auf den Suchergebnissen. Der Benutzer kann die Struktur des Berichts angeben, und das Modell füllt den Inhalt nach Bedarf auf.

- Meldung von InspektionenDas Modell prüft die Logik und Vollständigkeit des Berichts und weist auf fehlende Informationen oder inkonsistente Abschnitte hin.

- Bericht EditorBenutzer können den Inhalt des Berichts anpassen, indem sie die Bearbeitungsfunktion über ein Skript aufrufen. Führen Sie zum Beispiel aus:

python scripts/edit_report.py --report_path ./outputs/report.txtMit diesem Befehl kann das Modell den Wortlaut und die Struktur des angegebenen Berichts optimieren.

Optimierung des Crawling mit Crawl4AI

Crawl4AI ist in der Lage, komplexe Inhalte auf dynamischen Webseiten zu analysieren, wie z.B. Nachrichtenseiten mit JavaScript. Die Benutzer werden gebeten bing_search.py Konfigurieren Sie den API-Schlüssel in Crawl4AI und stellen Sie die Netzwerkkonnektivität sicher. Nach der Konfiguration ruft das Modell automatisch Crawl4AI auf, um Webtext, Bilder oder andere Elemente zu extrahieren.

caveat

- Hardware-VoraussetzungHochleistungs-GPUs (z. B. NVIDIA A100) sind erforderlich, um große Modelle wie QwQ-32B auszuführen. Stellen Sie sicher, dass die Hardware vLLM-Inferenz unterstützt.

- NetzwerkumgebungDie Such- und Crawl-Funktionen erfordern ein stabiles Netzwerk. Es wird empfohlen, einen Proxy oder ein VPN zu verwenden, um mögliche geografische Beschränkungen zu umgehen.

- Auswahl des ModellsBenutzer können andere Modelle zur Feinabstimmung von Befehlen (z. B. LLaMA) als Hilfsmodelle ausprobieren, müssen aber die Kompatibilität sicherstellen.

- Output-AnsichtDer erstellte Bericht wird in der Datei

<WebThinker-main>/outputs/Verzeichnis, das die gleichen Informationen wie Grok3 DeepSearch und das Gemini 2.0 Der vergleichende Bericht von Deep Research.

Mit diesen Schritten können Sie WebThinker einfach einsetzen und seine Such- und Berichtserstellungsfunktionen nutzen. Die Projektdokumentation ist detailliert und für Benutzer mit einem gewissen technischen Hintergrund geeignet.

Anwendungsszenario

- akademische Forschung

Für Forscher, die schnell die neuesten Entwicklungen in einem bestimmten Bereich erfassen müssen, durchsucht WebThinker automatisch akademische Artikel, Nachrichten und Blogs und erstellt Berichte mit Zitaten und Analysen. Geben Sie zum Beispiel "Neueste Fortschritte im Quantencomputing" ein und das Modell durchsucht arXiv und Google Scholar, um einen strukturierten Bericht zu erstellen. - Marktanalyse

WebThinker durchsucht Branchennachrichten, Unternehmenswebseiten und soziale Medien, um Berichte über Markttrends zu erstellen und so Zeit für die manuelle Erfassung zu sparen. - Technologieentwicklung

WebThinker navigiert durch Technologie-Blogs und GitHub-Repositories, extrahiert wichtige Informationen und erstellt technische Zusammenfassungen zur Unterstützung der Projektentwicklung.

QA

- Welche Modelle werden von WebThinker unterstützt?

Die offiziellen Empfehlungen sind QwQ-32B (Inferenzmodell) und Qwen-32B-Instruct (Hilfsmodell). Benutzer können auch andere Modelle für die Feinabstimmung von Befehlen ausprobieren, müssen aber die Kompatibilität mit vLLM sicherstellen. - Wie geht man mit dynamischen Webinhalten um?

Konfigurieren Sie den Crawl4AI-Client, bearbeiten Sie die<WebThinker-main>/scripts/search/bing_search.pyCrawl4AI analysiert gerenderte JavaScript-Inhalte. - Wie lange dauert es, einen Bericht zu erstellen?

Hängt von der Komplexität der Aufgabe und der Netzwerkgeschwindigkeit ab. Einfache Berichte dauern etwa 5-10 Minuten, komplexe Aufgaben können mehr als 30 Minuten in Anspruch nehmen. - Ist Programmiererfahrung erforderlich?

Der Einsatz von WebThinker erfordert grundlegende Python- und Conda-Kenntnisse. Die Verwendung von vorkonfigurierten Skripten ist einfach und für Anfänger geeignet.