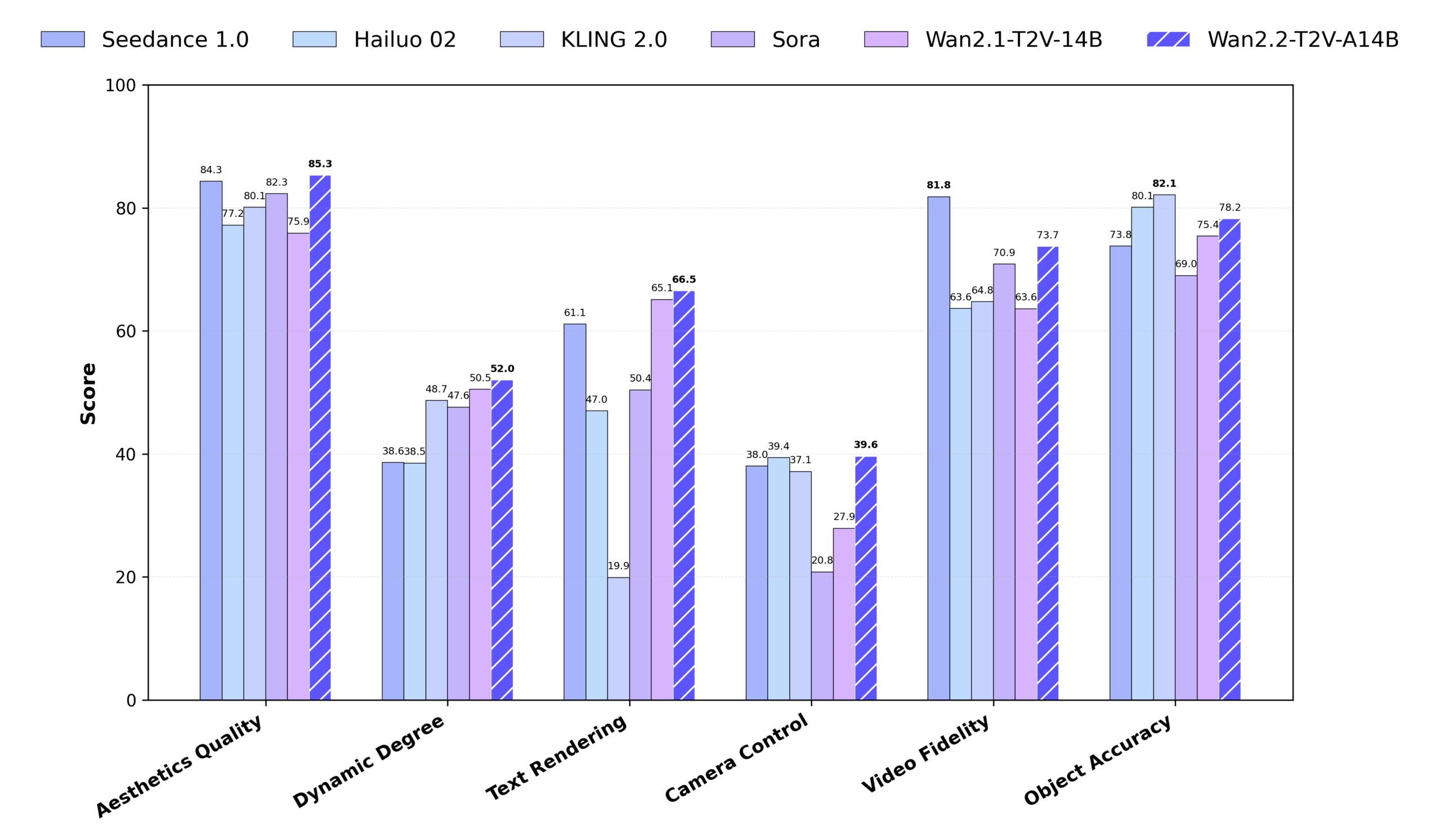

Wan2.2 ist ein von Alibaba Tongyi Labs entwickeltes Open-Source-Videogenerierungsmodell, das sich auf die Generierung hochwertiger Videos aus Text oder Bildern konzentriert. Es verwendet die Mixed Expert (MoE)-Architektur, die durch die Trennung des Entrauschungsprozesses von rauschintensiven und rauscharmen Phasen die Generierungsqualität deutlich verbessert und gleichzeitig die Recheneffizienz beibehält. Wan2.2 unterstützt die Generierung von HD-Videos mit 720P@24fps und läuft auf Consumer-GPUs (z. B. RTX 4090), wodurch es sich für individuelle Kreative und Entwickler eignet. Im Vergleich zu Wan2.1 fügt Wan2.2 den Trainingsdaten 65,6% Bilder und 83,2% Videos hinzu und verbessert damit die Bewegungserzeugung, das semantische Verständnis und die Ästhetik erheblich. Wan2.2 unterstützt Text-zu-Video (T2V), Bild-zu-Video (I2V) und Text-Bild-Ko-Generierung (TI2V) und ist mit Diffusoren und ComfyUI integriert, um eine flexible Nutzung zu ermöglichen. Wan2.2 übertrifft einige der kommerziellen Modelle in den Wan-Bench 2.0-Benchmarks und demonstriert damit seine starke Leistung und sein breites Anwendungspotenzial.

Funktionsliste

- Text zu Video (T2V) Erzeugt 5 Sekunden 480P- oder 720P-Video aus Textbeschreibungen und unterstützt komplexe Szenen und Aktionen.

- Bild zu Video (I2V) Generierung von bewegten Videos aus Standbildern unter Wahrung von Bildkonsistenz und Stil.

- Gemeinsame Generierung von Text und Bild (TI2V) Kombiniert Text und Bilder, um 720P@24fps Video für Geräte mit geringem RAM zu erzeugen.

- Hocheffizienter Video-Variable-Auto-Encoder (Wan-VAE) Erzielt ein Kompressionsverhältnis von 16×16×4 und unterstützt eine hochwertige Videorekonstruktion.

- Hybride Expertenarchitektur (MoE) Verbesserung der Generierungsqualität und Beibehaltung der Recheneffizienz unter Verwendung von Expertenmodellen mit hohem und niedrigem Rauschen.

- Filmische Ästhetik Unterstützt die Feinsteuerung von Beleuchtung, Komposition und Ton, um professionelle Videos im Kino-Stil zu produzieren.

- Erzeugung komplexer Bewegungen Unterstützung dynamischer Aktionen wie Tanzen, Kämpfen, Parkour usw. mit sanften und natürlichen Bewegungen.

- Spitze Erweiterung Anreicherung von Texthinweisen und Verbesserung von Videodetails mit der Dashscope-API oder nativen Qwen-Modellen.

- Optimierung für geringen Speicherbedarf Unterstützt FP8-Quantisierung und Modell-Offloading zur Reduzierung des GPU-Speicherbedarfs.

- Integration mehrerer Plattformen Unterstützt Diffuser und ComfyUI und bietet sowohl Befehlszeilen- als auch grafische Schnittstellenbedienung.

Hilfe verwenden

Einbauverfahren

Um Wan2.2 zu nutzen, müssen Sie Ihre Umgebung lokal oder auf einem Server konfigurieren. Die folgenden detaillierten Installations- und Nutzungsschritte sind für Anfänger und erfahrene Entwickler geeignet.

1. die Vorbereitung der Umwelt

Stellen Sie sicher, dass Ihr System die folgenden Anforderungen erfüllt:

- Software Die Modelle T2V-A14B und I2V-A14B erfordern eine GPU mit mindestens 80 GB Videospeicher (z. B. A100); das Modell TI2V-5B unterstützt Consumer-GPUs mit 24 GB Videospeicher (z. B. RTX 4090).

- Betriebssystem Windows, Linux oder macOS werden unterstützt.

- Python-Version Python 3.10 oder höher.

- Abhängige Werkzeuge Git, PyTorch (2.4.0 oder höher empfohlen), Hugging Face CLI, ModelScope CLI.

2. das Klonen der Codebasis

Führen Sie den folgenden Befehl in einem Terminal oder einer Eingabeaufforderung aus, um die Codebasis von Wan2.2 zu klonen:

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

3. die Installation von Abhängigkeiten

Installieren Sie die erforderlichen Python-Bibliotheken. Führen Sie den folgenden Befehl aus:

pip install -r requirements.txt

pip install "huggingface_hub[cli]" modelscope

Wenn Sie die Multi-GPU-Beschleunigung verwenden, müssen Sie die xfuser>=0.4.1:

pip install "xfuser>=0.4.1"

zur Kenntnis nehmen : Wenn flash_attn Wenn die Installation fehlschlägt, wird empfohlen, zunächst andere Abhängigkeiten zu installieren und sie anschließend separat zu installieren flash_attn。

4 Herunterladen von Modellgewichten

Wan2.2 bietet drei Modelle: T2V-A14B, I2V-A14B und TI2V-5B. Im Folgenden sind die Download-Befehle aufgeführt:

Gesicht umarmen Downloads :

huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14B

huggingface-cli download Wan-AI/Wan2.2-I2V-A14B --local-dir ./Wan2.2-I2V-A14B

huggingface-cli download Wan-AI/Wan2.2-TI2V-5B --local-dir ./Wan2.2-TI2V-5B

ModelScope herunterladen :

modelscope download Wan-AI/Wan2.2-T2V-A14B --local_dir ./Wan2.2-T2V-A14B

modelscope download Wan-AI/Wan2.2-I2V-A14B --local_dir ./Wan2.2-I2V-A14B

modelscope download Wan-AI/Wan2.2-TI2V-5B --local_dir ./Wan2.2-TI2V-5B

5. die Umgebungsvariablen konfigurieren (optional)

Wenn Sie die Hint Extension verwenden, müssen Sie den Dashscope API-Schlüssel konfigurieren:

export DASH_API_KEY=your_dashscope_api_key

Für internationale Benutzer sind zusätzliche Einstellungen erforderlich:

export DASH_API_URL=https://dashscope-intl.aliyuncs.com/api/v1

Sie müssen im Voraus einen API-Schlüssel bei Alibaba Cloud beantragen.

6. das Generierungsskript ausführen

Wan2.2 Bereitstellung generate.py Skripte werden zur Erstellung von Videos verwendet. Im Folgenden finden Sie ein Beispiel dafür, wie die einzelnen Aufgaben ausgeführt werden:

Text zu Video (T2V-A14B) :

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- Einzelne GPU : 80 GB Videospeicher erforderlich, aktivieren

--offload_model True和--convert_model_dtypeGeringere Anforderungen an den Grafikspeicher. - Multi-GPU :

torchrun --nproc_per_node=8 generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

Bild zu Video (I2V-A14B) :

python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --offload_model True --convert_model_dtype --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上,背景是模糊的海景和绿色山丘"

- Die Bildauflösung muss mit der Zielvideoauflösung übereinstimmen.

- Unterstützt unaufgeforderte Worterzeugung, die sich nur auf das Eingabebild stützt:

DASH_API_KEY=your_key python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --prompt '' --image examples/i2v_input.JPG --use_prompt_extend --prompt_extend_method 'dashscope'

Gemeinsame Erzeugung von Text und Bild (TI2V-5B) :

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- Bildeingabe (I2V-Modus):

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上"

- Die TI2V-5B unterstützt GPUs mit 24 GB Videospeicher und benötigt etwa 9 Minuten, um ein Video mit 720P@24fps zu erstellen.

Spitze Erweiterung :

Verwenden Sie die Dashscope-API:

DASH_API_KEY=your_key python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'dashscope' --prompt_extend_target_lang 'zh' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

Die Verwendung eines nativen Qwen-Modells (z. B. Qwen/Qwen2.5-7B-Instruct):

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'local_qwen' --prompt_extend_model 'Qwen/Qwen2.5-7B-Instruct' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

7. die Verwendung von ComfyUI

Wan2.2 ist in ComfyUI für GUI-Benutzer integriert. Schritte zur Installation:

- Klonen Sie ComfyUI-WanVideoWrapper:

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git

cd ComfyUI-WanVideoWrapper

pip install -r requirements.txt

- Legen Sie die Modelldatei in den Ordner ComfyUI Katalog:

- Modell T2V/I2V:

ComfyUI/models/diffusion_models/ - VAE-Modell:

ComfyUI/models/vae/ - CLIP-Modell:

ComfyUI/models/clip_vision/

- Modell T2V/I2V:

- Laden Sie den Workflow in ComfyUI, importieren Sie das Wan2.2-Modell, stellen Sie die Prompts ein und führen Sie ihn aus.

8. die Verwendung von Diffusoren

Wan2.2 wurde in Diffusoren integriert, um den Modellaufruf zu vereinfachen:

from diffusers import DiffusionPipeline

pipeline = DiffusionPipeline.from_pretrained("Wan-AI/Wan2.2-TI2V-5B-Diffusers")

pipeline.to("cuda")

video = pipeline(prompt="两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战").videos

Die Modelle T2V-A14B, I2V-A14B und TI2V-5B werden unterstützt.

Bedienung der Hauptfunktionen

Text zu Video

Erstellen Sie ein 5-Sekunden-Video, indem Sie eine detaillierte Textbeschreibung eingeben, z. B. "Eine nächtliche Stadtsilhouette mit blinkenden Neonlichtern". Es werden spezifische Stichwörter empfohlen, z. B. "Ein Mädchen in einem roten Mantel, das im Schnee spazieren geht, mit einem verschneiten Wald im Hintergrund". Aktivieren Sie Cue-Erweiterungen (--use_prompt_extend) Die Beschreibungen können automatisch angereichert werden, um ein detaillierteres Bild zu erhalten.

Bild zu Video

Laden Sie ein Bild mit einer Textbeschreibung hoch, um ein animiertes Video zu erstellen. Laden Sie z. B. ein Foto einer Katze hoch und geben Sie "Katze jagt Schmetterling im Gras" ein, um die entsprechende Animation zu erstellen. Achten Sie darauf, dass die Bildauflösung mit der des Zielvideos übereinstimmt.

Gemeinsame Erzeugung von Text und Bild

Das Modell TI2V-5B unterstützt Text- oder Bildeingaben zur Erzeugung von 720P@24fps-Videos. Geeignet für Geräte mit geringem Videospeicher, schnelle Generierungsgeschwindigkeit und stabile Ergebnisse.

Filmische Ästhetik

Wan2.2 unterstützt die Feinsteuerung von Beleuchtung, Komposition und Farbtönen. Geben Sie z. B. "Seitliche Beleuchtung, hoher Kontrast, warme Töne, ein junger Mann steht im Wald" ein, um ein Video im Filmstil zu erstellen.

Erzeugung komplexer Bewegungen

Unterstützung bei der Erzeugung dynamischer Aktionen, wie z. B. "Straßenparkour-Sportler, die über Hindernisse springen" oder "Hip-Hop-Tänzer, die auf einer Neonbühne auftreten", mit sanften und natürlichen Bewegungen.

Anwendungsszenario

- Erstellung von Inhalten

- Schöpfer können Text oder Bilder in kurze Videos für Werbespots, Kurzfilme oder Inhalte für soziale Medien verwandeln. Erstellen Sie zum Beispiel ein animiertes Video von einem "Sci-Fi-Raumschiff, das über die Sterne fliegt".

- Bildung & Präsentation

- Lehrkräfte können statische Kursunterlagen in dynamische Videos umwandeln, um das Lehren und Lernen zu verbessern. Zum Beispiel werden Beschreibungen historischer Ereignisse in Videos umgewandelt, um historische Szenen zu zeigen.

- Entwicklung von Spielen und Animationen

- Entwickler können Spielhintergrundvideos oder animierte Prototypen erstellen. Erstellen Sie zum Beispiel ein "tägliches Leben in einem mittelalterlichen Dorf" als Referenz für eine Spielszene.

- Kommerzielle Werbung

- Unternehmen können Werbevideos für ihre Produkte erstellen. Geben Sie z. B. "die Verwendung von Smartwatches in Outdoor-Sportarten" ein, um ein kurzes Video zu erstellen, das die Funktion demonstriert.

- Kunst

- Künstler können statische Bilder in dynamische Videos verwandeln. Verwandeln Sie zum Beispiel ein abstraktes Gemälde in einen fließenden Animationseffekt.

QA

- Welche Auflösungen werden von Wan2.2 unterstützt?

- T2V-A14B und I2V-A14B unterstützen 480P und 720P; TI2V-5B unterstützt 720P (1280).704 oder 7041280)。

- Wie funktionieren Geräte mit niedrigem Videospeicher?

- Bei Verwendung des Modells TI2V-5B (24 GB Videospeicher) aktivieren Sie die

--offload_model True、--convert_model_dtype和--t5_cpuGeringere Anforderungen an den Grafikspeicher.

- Bei Verwendung des Modells TI2V-5B (24 GB Videospeicher) aktivieren Sie die

- Wie kann ich meine Videoqualität verbessern?

- Verwenden Sie detaillierte Cue-Wörter, aktivieren Sie die Cue-Erweiterung und wählen Sie FP16-Modelle (höhere Qualität als FP8).

- Unterstützt es die kommerzielle Nutzung?

- Ja, Wan2.2 steht unter der Apache 2.0-Lizenz und kann in kommerziellen Projekten verwendet werden, sofern die entsprechenden Gesetze eingehalten werden.

- Was sind die Verbesserungen von Wan2.2 gegenüber Wan2.1?

- Durch die Einführung der MoE-Architektur werden die Trainingsdaten um 65,6% an Bildern und 83,2% an Videos erweitert, wodurch komplexere Bewegungen und ästhetische Effekte in Kinoqualität unterstützt werden.