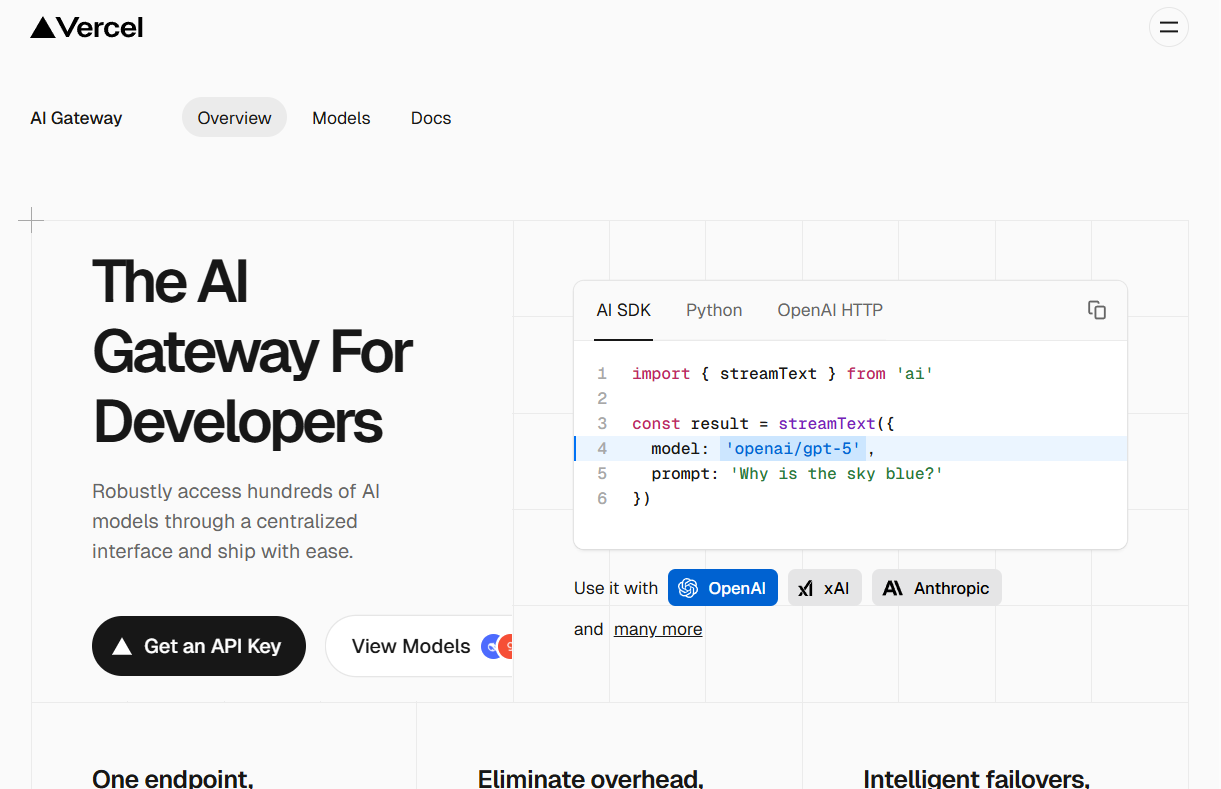

Vercel AI Gateway ist ein für Entwickler konzipierter Middle-Tier-Dienst. Er ermöglicht Entwicklern den Zugriff auf mehrere KI-Modelle von verschiedenen Anbietern mit einem Satz Code, indem er eine einheitliche API-Schnittstelle bereitstellt. Der Hauptzweck dieses Dienstes besteht darin, den Prozess der Entwicklung und Verwaltung von KI-Anwendungen zu vereinfachen. Entwickler müssen nicht mehr für jedes KI-Modell einen eigenen API-Schlüssel verwalten, sich mit komplexen Abrechnungen befassen und mit Tarifbeschränkungen von verschiedenen Dienstanbietern zurechtkommen. Darüber hinaus verfügt es über eine integrierte intelligente Fehler-Backup-Funktion, die es dem System ermöglicht, automatisch auf ein Backup-Modell umzuschalten, wenn ein KI-Modelldienst ausfällt, wodurch die Stabilität und Zuverlässigkeit der Anwendung verbessert wird. Darüber hinaus bietet AI Gateway Protokollierungs- und Analysetools, mit denen Entwickler die Ausgaben und die Leistung von Anwendungen überwachen können, um eine bessere Kostenkontrolle und Serviceoptimierung zu erreichen.

Funktionsliste

- Vereinheitlichte API-SchnittstelleBereitstellung eines einzigen API-Einstiegspunkts (Endpunkt), um Hunderte von KI-Modellen verschiedener Anbieter wie OpenAI, Anthropic, xAI usw. durch Änderung einer einzigen Codezeile zu wechseln und zu verwenden.

- Intelligente AusfallsicherungWenn der Dienst eines KI-Modellanbieters unterbrochen wird, kann das Gateway die Anfrage automatisch auf ein anderes Modell oder einen anderen Anbieter umleiten und so die Kontinuität der Anwendungsdienste gewährleisten.

- Leistungsüberwachung und ProtokollierungZentralisierte Protokollierung aller KI-Anfragen über das Gateway, die es den Entwicklern erleichtert, Probleme mit der Anwendungsleistung zu verfolgen, zu analysieren und zu beheben.

- Kostenkontrolle und BudgetverwaltungErmöglicht es Entwicklern, Budgets festzulegen und die Kosten für KI-Modellaufrufe in Echtzeit zu überwachen, um Kostenüberschreitungen zu vermeiden.

- Vereinfachte SchlüsselverwaltungEntwickler müssen keine API-Schlüssel von mehreren Anbietern in ihren eigenen Anwendungen verwalten, da alle Schlüssel zentral von Vercels Backend verwaltet werden.

- nahtlose IntegrationEs kann leicht in das Vercel AI SDK, OpenAI SDK und andere Mainstream-Frameworks integriert werden, und Entwickler können ihre eigenen vertrauten Tools für die Entwicklung verwenden.

- unbegrenzte GeschwindigkeitVercel selbst legt keine Ratenbeschränkungen für API-Anfragen fest, so dass Entwickler den maximalen Durchsatz, der von Upstream-Providern angeboten wird, voll ausschöpfen können.

Hilfe verwenden

Das Vercel AI Gateway wurde entwickelt, um den Prozess der Integration und Verwaltung von Large Language Models (LLMs) in Anwendungen zu vereinfachen. Es fungiert als Proxy-Schicht, die es Entwicklern ermöglicht, viele der wichtigsten KI-Modelle auf dem Markt aufzurufen, indem sie einfach mit Vercels einheitlicher Schnittstelle interagieren.

Schritt 1: Abrufen des API-Schlüssels

- Besuchen Sie die offizielle Vercel AI Gateway Website.

- Klicken Sie auf "Anmelden", um sich für ein Vercel-Konto zu registrieren. Neue Benutzer erhalten ein kostenloses Guthaben von 5 $ pro Monat, um jedes Modell auf der Plattform zu testen.

- Nach der Anmeldung können Sie im AI Gateway-Kontrollzentrum ein neues Projekt erstellen und einen exklusiven API-Schlüssel erhalten. Dieser Schlüssel wird für die Authentifizierung bei allen nachfolgenden API-Anfragen verwendet, also bewahren Sie ihn bitte sicher auf.

Schritt 2: Konfigurieren Sie die Entwicklungsumgebung

AI Gateway kann mit mehreren Programmiersprachen und Frameworks integriert werden. Im Folgenden finden Sie ein Beispiel für die Konfiguration und Verwendung der Python-Umgebung und des offiziellen OpenAI SDK.

Stellen Sie zunächst sicher, dass die OpenAI Python-Bibliothek in Ihrer Entwicklungsumgebung installiert ist. Wenn sie nicht bereits installiert ist, können Sie diepipum es zu installieren:

pip install openai

Sobald die Installation abgeschlossen ist, müssen Sie den API-Schlüssel, den Sie von Vercel erhalten haben, als Umgebungsvariable konfigurieren. Dies ist sicherer als die Festcodierung des Schlüssels in Ihrem Code.

Setzen Sie die Umgebungsvariablen in Ihrem Terminal:

export AI_GATEWAY_API_KEY='你的Vercel AI Gateway API密钥'

bitte angeben你的Vercel AI Gateway API密钥Ersetzen Sie ihn durch den echten Schlüssel, den Sie im ersten Schritt erhalten haben.

Schritt 3: API-Anfrage senden

Sobald die Konfiguration abgeschlossen ist, können Sie das KI-Modell aufrufen, indem Sie Code schreiben. Der Hauptvorgang ist die Initialisierung des OpenAI-Clients mit derbase_urlwird als Unified Interface-Adresse des Vercel AI Gateway angegeben.

Im Folgenden finden Sie ein vollständiges Python-Codebeispiel, das zeigt, wie Sie xAI über das AI Gateway aufrufengrok-4Modelle:

import os

from openai import OpenAI

# 初始化OpenAI客户端

# 客户端会自动读取名为'AI_GATEWAY_API_KEY'的环境变量作为api_key

# 同时,必须将base_url指向Vercel的网关地址

client = OpenAI(

api_key=os.getenv('AI_GATEWAY_API_KEY'),

base_url='https://ai-gateway.vercel.sh/v1'

)

# 发起聊天补全请求

try:

response = client.chat.completions.create(

# 'model'参数指定了你想要调用的模型

# 格式为 '供应商/模型名称'

model='xai/grok-4',

messages=[

{

'role': 'user',

'content': '天空为什么是蓝色的?'

}

]

)

# 打印模型返回的回答

print(response.choices[0].message.content)

except Exception as e:

print(f"请求发生错误: {e}")

In diesem Code wird diebase_url='https://ai-gateway.vercel.sh/v1'ist der Schlüssel. Es leitet die Anfrage, die an OpenAI gesendet werden sollte, an das Vercel AI Gateway weiter, das die Anfrage erhält und auf der Grundlage der von Ihnen angegebenenmodel='xai/grok-4'leitet die Anfrage an den entsprechenden KI-Anbieter (in diesem Fall xAI) weiter und gibt das Endergebnis an Sie zurück.

Modelle umschalten

Eine der größten Annehmlichkeiten von AI Gateway ist die Möglichkeit, das Modell einfach zu wechseln. Wenn Sie zu Anthropic's wechseln möchtenclaude-sonnet-4Modell, ändern Sie einfach diemodelist ausreichend, und der Rest des Codes bleibt unverändert:

response = client.chat.completions.create(

model='anthropic/claude-sonnet-4',

messages=[

{

'role': 'user',

'content': '请给我写一个关于太空旅行的短故事。'

}

]

)

print(response.choices[0].message.content)

Dieses Design gibt den Entwicklern die Flexibilität, zwischen den Modellen zu testen und zu wechseln, ohne den zugrunde liegenden Code für die Authentifizierung und die Netzwerkanfragen ändern zu müssen.

Anwendungsszenario

- Schnelles Prototyping

In der Anfangsphase der Entwicklung einer KI-Anwendung müssen die Entwickler viele verschiedene Modelle ausprobieren, um dasjenige zu finden, das am besten zum Anwendungsszenario passt. Mit AI Gateway können Entwickler die Leistung und Kosten verschiedener Modelle schnell testen und vergleichen, indem sie einfach den Modellidentifikator ändern, ohne für jedes Modell eine vollständige Integration entwickeln zu müssen. - Verbesserung der Anwendungszuverlässigkeit

Für Anwendungen in Produktionsumgebungen, die bereits online und für den Benutzer zugänglich sind, ist die Stabilität des Dienstes von entscheidender Bedeutung, da es bei Anbietern von KI-Modellen gelegentlich zu Dienstunterbrechungen kommt. Durch die Konfiguration der Fault-Backup-Funktion von AI Gateway kann das System automatisch auf das Standby-Modell umschalten, wenn der primäre Modelldienst nicht verfügbar ist, um sicherzustellen, dass die Kernfunktionalität der Anwendung nicht beeinträchtigt wird, und so die Benutzerfreundlichkeit zu verbessern. - Kostenkontrolle für Start-ups

Startups oder kleine Entwicklungsteams haben nur begrenzte Ressourcen und müssen die Betriebskosten im Griff haben. Die Überwachungs- und Budgetverwaltungsfunktionen von AI Gateway verfolgen den Token-Verbrauch und die Ausgaben in Echtzeit und helfen den Teams, die Kostenkomponenten zu verstehen. Durch die Festlegung einer Budgetobergrenze können Sie unerwartet hohe Rechnungen aufgrund von Codefehlern oder Verkehrsspitzen wirksam verhindern. - Einheitliche Verwaltung von Multimodell-Anwendungen

AI Gateway vereinfacht die Komplexität von O&M, indem es eine einheitliche Verwaltungsplattform bereitstellt, auf der Entwickler API-Aufrufe, Protokolle und Ausgaben für alle Modelle an einem Ort überwachen und verwalten können.

QA

- Muss ich für die Nutzung von Vercel AI Gateway bezahlen?

Vercel bietet Neuanmeldungen ein kostenloses Guthaben in Höhe von 5 US-Dollar pro Monat, mit dem jedes der KI-Modelle auf der Plattform ausprobiert werden kann. Sobald das kostenlose Guthaben aufgebraucht ist oder der Nutzer die erste Zahlung geleistet hat, wird die weitere Nutzung auf einer volumenbasierten Grundlage abgerechnet. - Welche KI-Modelle werden von AI Gateway unterstützt?

AI Gateway unterstützt Hunderte von Modellen von OpenAI, Anthropic, Google, xAI, Groq und vielen anderen großen Anbietern. Die vollständige Liste der unterstützten Modelle kann in der offiziellen Dokumentation von Vercel oder auf dem Model Marketplace eingesehen werden. - Begrenzt Vercel AI Gateway die Geschwindigkeit von API-Anfragen?

Vercel selbst legt keine Ratenbeschränkungen für API-Anfragen über das Gateway fest. Die Anfragerate und der Durchsatz, die den Entwicklern zur Verfügung stehen, hängen weitgehend von den eigenen Begrenzungsrichtlinien des vorgelagerten KI-Modellanbieters ab. - Wenn ich bereits das SDK von OpenAI verwende, ist es dann kompliziert, zu AI Gateway zu migrieren?

Der Migrationsprozess ist sehr einfach. Sie müssen lediglich den OpenAI-Client mit dembase_urlwird auf die von Vercel bereitgestellte Gateway-Adresse geändert, und der Parameterapi_keyEs genügt, den Schlüssel durch den von Vercel bezogenen zu ersetzen, und der Kerngeschäftscode muss nur wenig oder gar nicht geändert werden.