CogVLM2 是由清华大学数据挖掘研究组(THUDM)开发的开源多模态模型,基于 Llama3-8B 架构,旨在提供与 GPT-4V 相当甚至更优的性能。该模型支持图像理解、多轮对话以及视频理解,能够处理长达 8K 的内容,并支持高达 1344×1344 的图像分辨率。CogVLM2 系列包括多个子模型,分别针对不同任务进行了优化,如文本问答、文档问答和视频问答等。该模型不仅支持中英文双语,还提供了多种在线体验和部署方式,方便用户进行测试和应用。

Weitere Informationen:Wie lange kann ein Video von einem großen Modell verstanden werden? Smart Spectrum GLM-4V-Plus: 2 Stunden

Funktionsliste

- grafisches VerständnisUnterstützt das Verständnis und die Verarbeitung von hochauflösenden Bildern.

- vielschichtiger DialogFähigkeit zu mehreren Dialogrunden, geeignet für komplexe Interaktionsszenarien.

- Video-VerständnisUnterstützt das Verstehen von Videoinhalten mit einer Länge von bis zu 1 Minute durch Extraktion von Keyframes.

- Unterstützung mehrerer SprachenChinesische und englische Zweisprachigkeit unterstützen, um sich an unterschiedliche Sprachumgebungen anzupassen.

- Open Source (Datenverarbeitung)Der vollständige Quellcode und die Modellgewichte werden zur Verfügung gestellt, um die Sekundärentwicklung zu erleichtern.

- Online-ErfahrungBietet eine Online-Demoplattform, auf der die Benutzer die Funktionalität des Modells direkt erleben können.

- Mehrere EinsatzoptionenUnterstützt Huggingface, ModelScope und andere Plattformen.

Hilfe verwenden

Installation und Einsatz

- Klon-Lager::

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- Installation von Abhängigkeiten::

pip install -r requirements.txt

- Download ModellgewichteDownloaden Sie die entsprechenden Modellgewichte und legen Sie sie im angegebenen Verzeichnis ab.

Anwendungsbeispiel

grafisches Verständnis

- Modelle laden::

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- Prozessabbild::

image = load_image('path_to_image')

result = model.predict(image)

print(result)

vielschichtiger Dialog

- Initialisierung des Dialogs::

conversation = model.start_conversation()

- einen Dialog führen::

response = conversation.ask('你的问题')

print(response)

Video-Verständnis

- Video laden::

video = load_video('path_to_video')

result = model.predict(video)

print(result)

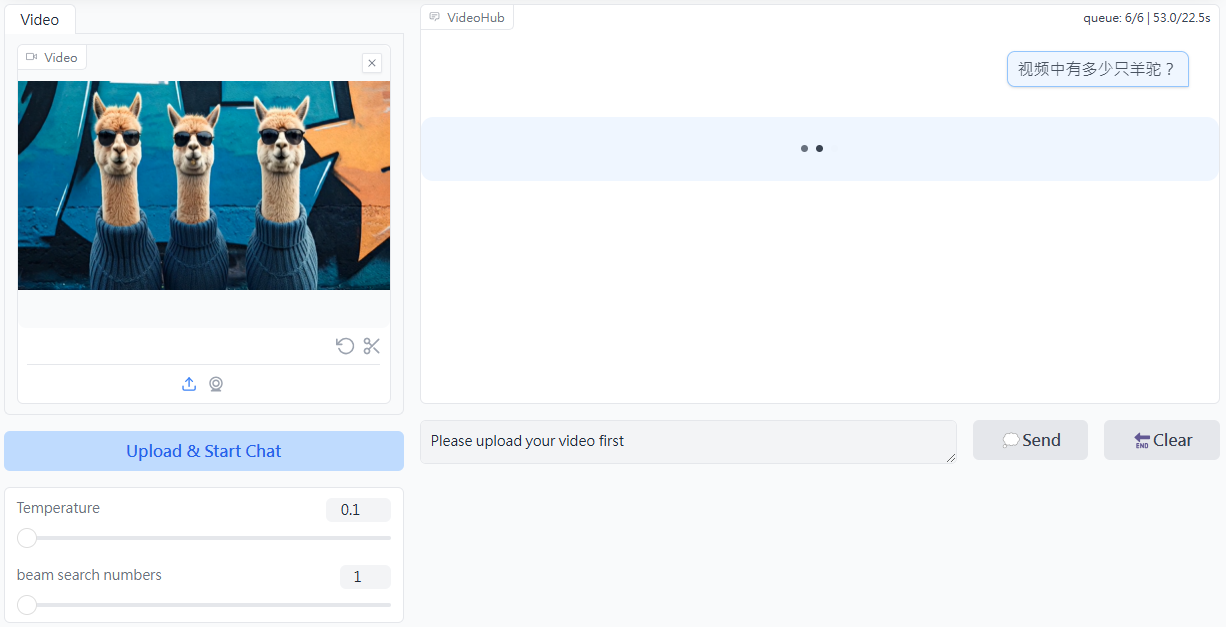

Online-Erfahrung

Benutzer können auf die Online-Demoplattform von CogVLM2 zugreifen, um die Funktionalität des Modells online und ohne lokalen Einsatz zu testen.