TaskingAI ist eine Open-Source-Plattform, die Entwicklern hilft, KI-native Anwendungen zu erstellen. Sie vereinfacht den Entwicklungsprozess von Large Language Models (LLMs) durch eine intuitive Benutzeroberfläche, leistungsstarke APIs und ein flexibles modulares Design. Die Plattform unterstützt eine breite Palette von Mainstream-Modellen wie OpenAI, Anthropic usw. und ermöglicht die Integration nativer Modelle. TaskingAI ist sowohl für Anfänger als auch für professionelle Entwickler geeignet, wobei der Schwerpunkt auf asynchroner Hochleistung, Plug-in-Erweiterungen und mandantenfähiger Unterstützung liegt. Benutzer können die Community-Edition schnell über Docker bereitstellen oder Cloud-Dienste für die Entwicklung nutzen. TaskingAI hat sich zum Ziel gesetzt, die Entwicklung von KI-Anwendungen einfacher und effizienter zu machen, und verfügt über eine aktive Community, die die Nutzer zur Mitarbeit ermutigt.

Funktionsliste

- Unterstützt eine breite Palette von Large Language Models (LLMs), einschließlich OpenAI, Claude, Mistral usw., und kann mit lokalen Modellen wie Ollama integriert werden.

- Bieten Sie umfangreiche Plug-ins an, z. B. für die Google-Suche, das Lesen von Website-Inhalten, die Erfassung von Börsendaten usw. Unterstützen Sie benutzerdefinierte Tools.

- Eingebautes RAG-System (Retrieval Augmentation Generation) zur einfachen Handhabung und Verwaltung externer Daten.

- Unterstützt asynchrone Verarbeitung und hochleistungsfähiges Concurrent Computing auf der Grundlage von FastAPI.

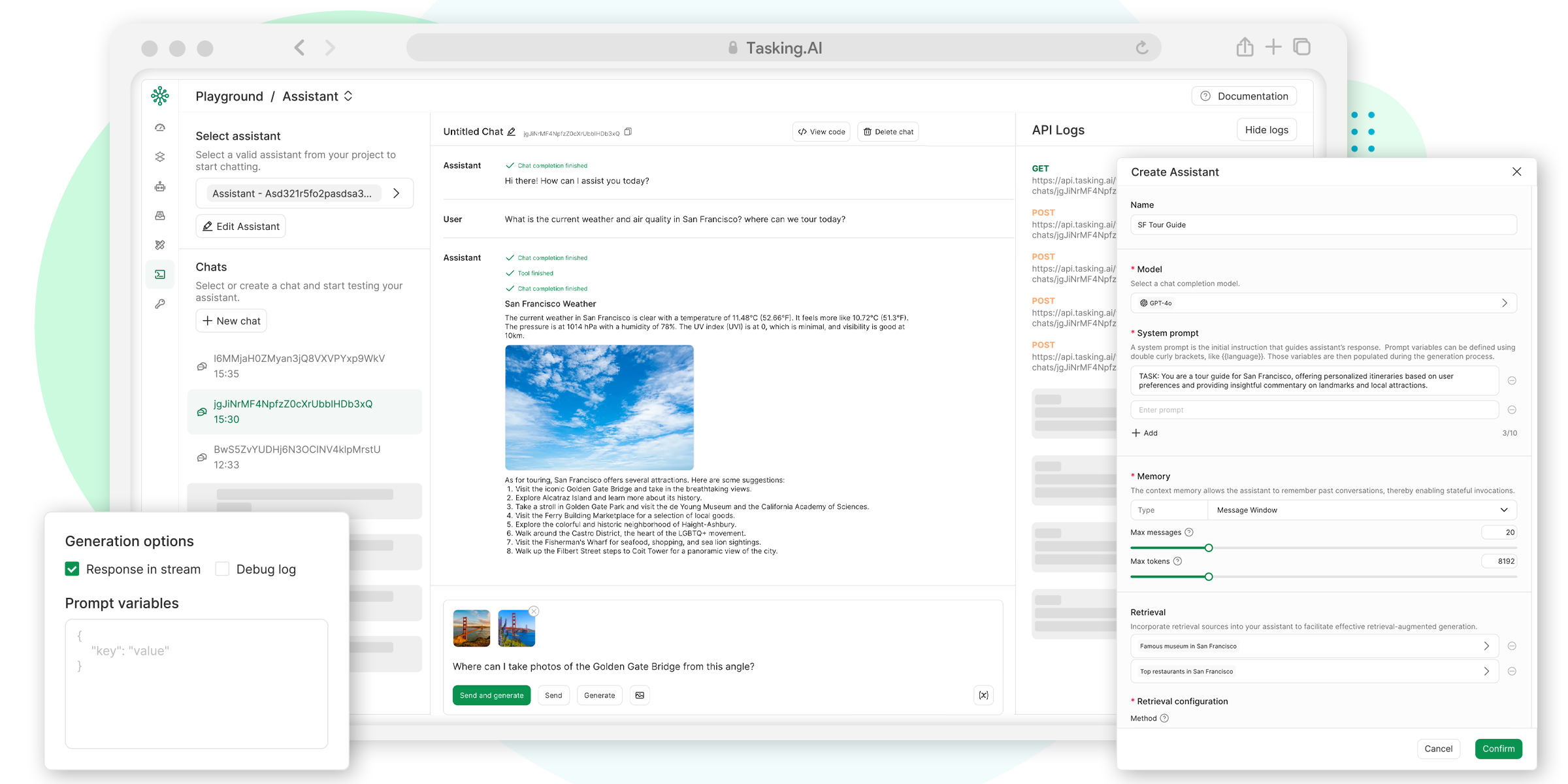

- Bietet eine intuitive UI-Konsole zur Vereinfachung des Projektmanagements und der Testabläufe.

- Unterstützt die Entwicklung mandantenfähiger Anwendungen für eine schnelle Bereitstellung und Skalierung.

- Bereitstellung einer einheitlichen API-Schnittstelle für die einfache Verwaltung von Modellen, Tools und Daten.

- Unterstützung für OpenAI-kompatible Chat-Vervollständigungs-APIs zur Vereinfachung der Aufgabenerstellung und -aufrufe.

Hilfe verwenden

TaskingAI ist eine leistungsstarke Plattform für Entwickler, um schnell native KI-Anwendungen zu erstellen. Nachfolgend finden Sie eine ausführliche Installations- und Nutzungsanleitung, um den Benutzern einen schnellen Einstieg zu ermöglichen.

Einbauverfahren

Die TaskingAI Community Edition kann schnell über Docker bereitgestellt werden und eignet sich für lokale Entwicklung oder Tests. Hier sind die spezifischen Schritte:

- Bereitschaft für die Umwelt sicherstellen

- Installieren Sie Docker und Docker Compose.

- Stellen Sie sicher, dass Ihr System Python 3.8 oder höher unterstützt.

- Optional: Erstellen Sie eine virtuelle Python-Umgebung, um Abhängigkeiten zu isolieren.

- TaskingAI Gemeinschaftsausgabe herunterladen

- Besuchen Sie das GitHub-Repository unter https://github.com/TaskingAI/TaskingAI.

- Klonen Sie das Repository nach lokal:

git clone https://github.com/TaskingAI/TaskingAI.git - Rufen Sie den Projektkatalog auf:

cd TaskingAI

- Umgebungsvariablen konfigurieren

- Erstellen Sie im Stammverzeichnis des Projekts die Datei

.envDatei, um den API-Schlüssel und andere Konfigurationen festzulegen. Beispiel:TASKINGAI_API_KEY=your_api_key TASKINGAI_HOST=http://localhost:8080 - API-Schlüssel sind über die TaskingAI-Konsole erhältlich (für die Cloud-Version ist eine Kontoregistrierung erforderlich).

- Erstellen Sie im Stammverzeichnis des Projekts die Datei

- Neue Dienste

- Starten Sie den TaskingAI-Dienst mit Docker Compose:

cd docker docker-compose -p taskingai pull docker-compose -p taskingai --env-file .env up -d - Nachdem der Dienst gestartet ist, rufen Sie die

http://localhost:8080Ansicht Konsole.

- Starten Sie den TaskingAI-Dienst mit Docker Compose:

- Installation des Python-Client-SDK

- Installieren Sie den TaskingAI Python-Client mit pip:

pip install taskingai - Initialisieren Sie das SDK:

import taskingai taskingai.init(api_key="YOUR_API_KEY", host="http://localhost:8080")

- Installieren Sie den TaskingAI Python-Client mit pip:

Hauptfunktionen

Zu den Kernfunktionen von TaskingAI gehören die Modellintegration, die Verwendung von Plugins, das RAG-System und API-Aufrufe. Nachfolgend finden Sie die spezifischen Betriebsrichtlinien:

- Modellintegration

TaskingAI unterstützt eine breite Palette von großen Sprachmodellen. Benutzer können Modelle (z.B. Claude, Mistral) in der Konsole auswählen oder Modell-IDs über die API angeben. z.B.:from openai import OpenAI client = OpenAI( api_key="YOUR_TASKINGAI_API_KEY", base_url="https://oapi.tasking.ai/v1", ) response = client.chat.completions.create( model="YOUR_MODEL_ID", messages=[{"role": "user", "content": "你好,今天天气如何?"}] ) print(response)

- In der Konsole kann der Benutzer die Auswirkungen des Modells auf den Dialog direkt testen und Parameter wie die Temperatur oder die maximale Ausgangslänge einstellen.

- Plug-in-Verwendung

TaskingAI bietet eine Vielzahl von eingebauten Plugins wie Google-Suche, Lesen von Website-Inhalten usw. Benutzer können auch eigene Plug-ins entwickeln. Arbeitsschritte:- Wählen Sie auf der Seite Plug-ins der Konsole ein Plug-in aus oder fügen Sie es hinzu.

- Aufrufen von Plugin-Funktionen über die API. Zum Beispiel der Aufruf des Google-Such-Plugins:

import taskingai result = taskingai.plugin.google_search(query="最新AI技术") print(result) - Benutzerdefinierte Plugins müssen die Entwicklungsdokumentation des TaskingAI-Tools befolgen, Code hochladen und sich mit dem KI-Agenten verbinden.

- Betrieb des RAG-Systems

Das RAG-System (Retrieval Augmentation Generation) wird zur Verarbeitung externer Daten verwendet. Benutzer können Datensammlungen erstellen und Inhalte abrufen:- Sammlungen erstellen:

coll = taskingai.retrieval.create_collection( embedding_model_id="YOUR_EMBEDDING_MODEL_ID", capacity=1000 ) print(f"集合ID: {coll.collection_id}") - Einen Datensatz hinzufügen:

record = taskingai.retrieval.create_record( collection_id=coll.collection_id, type="text", content="人工智能正在改变世界。", text_splitter={"type": "token", "chunk_size": 200, "chunk_overlap": 20} ) print(f"记录ID: {record.record_id}") - Rufen Sie Datensätze ab:

retrieved_record = taskingai.retrieval.get_record( collection_id=coll.collection_id, record_id=record.record_id ) print(f"检索内容: {retrieved_record.content}")

- Sammlungen erstellen:

- Verwendung der UI-Konsole

- Nachdem Sie sich bei der Konsole angemeldet haben, gehen Sie auf die Seite "Projekte" und erstellen ein neues Projekt.

- Wählen oder konfigurieren Sie ein großes Sprachmodell auf der Seite Modell.

- Führen Sie den Workflow auf der Testseite aus, um die AI-Ausgabe in Echtzeit zu sehen.

- Verwenden Sie die Funktion "Protokollierung", um API-Aufrufe und Leistung zu überwachen.

Featured Function Bedienung

Zu den Funktionen von TaskingAI gehören die asynchrone Verarbeitung und die Unterstützung mehrerer Mandanten:

- asynchrone VerarbeitungAsynchrone Architektur auf der Grundlage von FastAPI, geeignet für Szenarien mit hoher Gleichzeitigkeit. Die Benutzer benötigen keine zusätzliche Konfiguration, und API-Aufrufe unterstützen automatisch die Asynchronität. Wenn zum Beispiel mehrere KI-Agentenaufgaben erstellt werden, verarbeitet das System die Anfragen parallel.

- Unterstützung von mehreren MandantenIdeal für die Entwicklung mehrbenutzerorientierter Anwendungen. Benutzer können Modelle und Plug-ins verschiedenen Tenants in der Konsole zuweisen, um die Datenisolierung zu gewährleisten. Konfigurationsmethoden:

- Fügen Sie einen neuen Mieter auf dem Bildschirm Mieterverwaltung der Konsole hinzu.

- Weisen Sie jedem Mandanten unabhängige API-Schlüssel und Modellkonfigurationen zu.

caveat

- Stellen Sie sicher, dass der API-Schlüssel sicher und nicht kompromittiert ist.

- Prüfen Sie bei der Bereitstellung von Docker, ob Port 8080 belegt ist.

- Nutzer der Cloud-Version müssen sich für ein Konto registrieren und https://www.tasking.ai获取API密钥 besuchen.

Anwendungsszenario

- Entwicklung von AI-Chatbots

Entwickler können TaskingAI nutzen, um schnell Chatbots zu erstellen, die auf umfangreichen Sprachmodellen basieren und Gespräche mit mehreren Runden sowie die Abfrage externer Daten unterstützen, die für den Kundenservice oder für Bildungsszenarien geeignet sind. - Automatisierte Datenanalyse

Mit Plug-ins und einem RAG-System kann TaskingAI Daten aus Webseiten oder Dokumenten extrahieren und sie mit KI-Analysen kombinieren, um Berichte oder Einblicke zu generieren, die für Marktforscher geeignet sind. - Schnelles Prototyping

Startups oder einzelne Entwickler können die UI-Konsole und APIs von TaskingAI nutzen, um schnell KI-Anwendungsprototypen zu erstellen und Geschäftsideen zu validieren. - Bildung und Ausbildung

Bildungseinrichtungen können TaskingAI nutzen, um interaktive Lernassistenten zu erstellen, die Studierende bei der Abfrage von Wissenspunkten oder der Erstellung von Übungsfragen unterstützen.

QA

- Welche Modelle werden von TaskingAI unterstützt?

TaskingAI unterstützt eine breite Palette von Modellen wie OpenAI, Claude, Mistral usw. und kann lokale Modelle über Ollama usw. integrieren. - Wie kann ich mit TaskingAI anfangen?

Laden Sie die Community-Version herunter, um sie über Docker bereitzustellen, oder melden Sie sich für die Cloud-Version an, um den API-Schlüssel zu erhalten. Installieren Sie das Python-SDK, um die API aufzurufen. - Ist Programmiererfahrung erforderlich?

Einsteiger können mit der UI-Konsole arbeiten, und Entwickler können komplexe Funktionen über APIs und SDKs implementieren. - Was ist der Unterschied zwischen der TaskingAI Community Edition und der Cloud Edition?

Die Community-Version ist kostenlos und erfordert eine lokale Bereitstellung; die Cloud-Version bietet Hosting-Dienste und ist für eine schnelle Entwicklung geeignet.