Sim ist eine Open-Source-Plattform für die Erstellung von KI-Agenten-Workflows, mit der Benutzer schnell große Sprachmodelle (LLMs) erstellen und einsetzen können, die verschiedene Tools miteinander verbinden. Sim Studio unterstützt sowohl Cloud- als auch lokale Implementierungen und ist flexibel und kompatibel mit einer Vielzahl von Betriebsumgebungen. Benutzer können es schnell mit einfachen NPM-Befehlen oder Docker Compose starten oder es manuell durch Konfiguration oder Entwicklung von Containern ausführen. Die Plattform unterstützt das lokale Laden von Modellen und ist mit NVIDIA GPU- oder CPU-Umgebungen kompatibel.Sim Studio legt Wert auf ein schlankes Design und eine benutzerfreundliche Erfahrung für die schnelle Entwicklung von KI-gesteuerten Workflows.

Funktionsliste

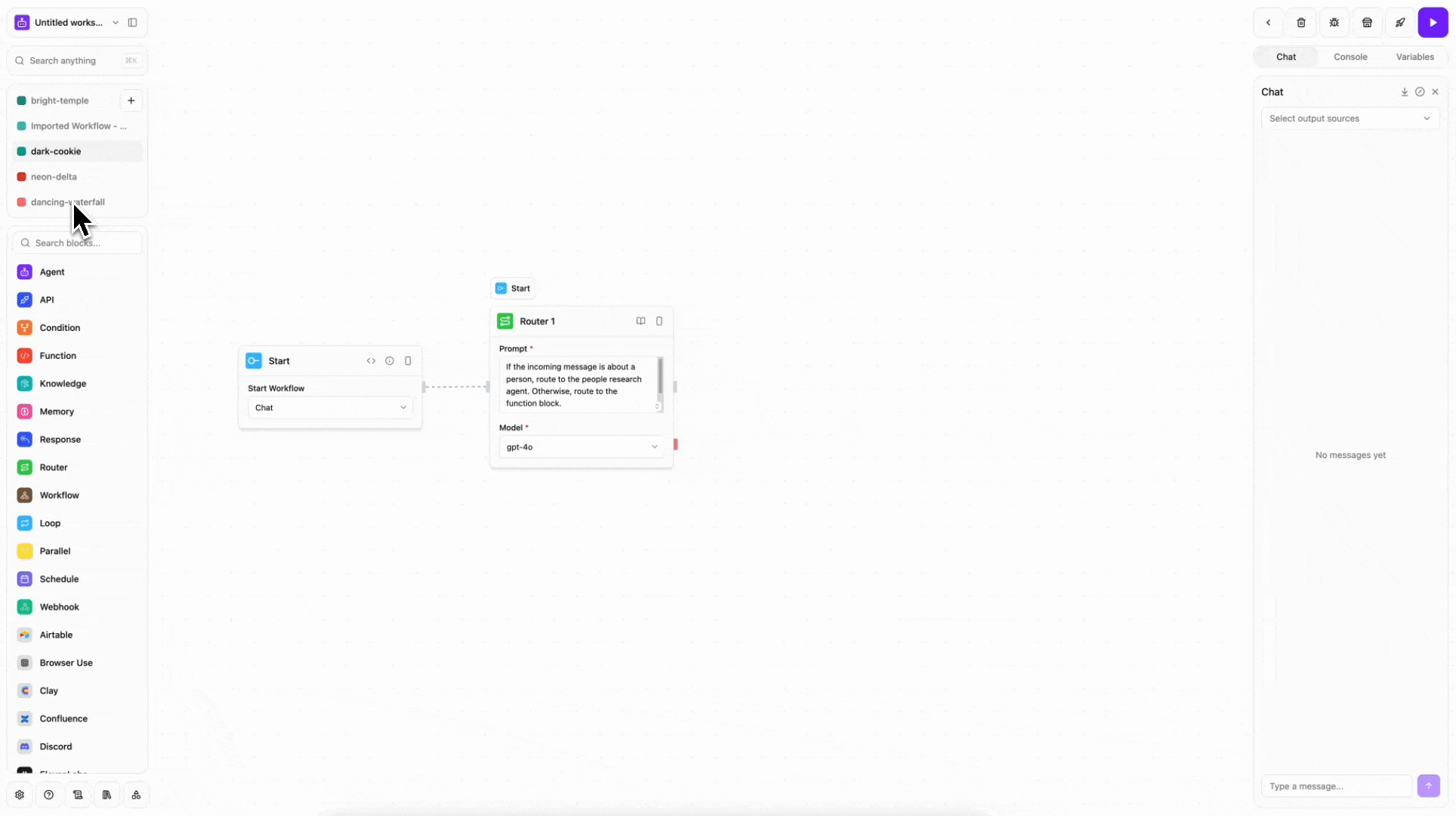

- Konstruktion des ArbeitsablaufsSchnelles Entwerfen von KI-Agenten-Workflows und Verbinden mit externen Tools und Datenquellen über eine intuitive Benutzeroberfläche.

- Mehrere EinsatzoptionenUnterstützung für Cloud-Hosting, lokale Ausführung (NPM, Docker Compose, Entwicklungscontainer, manuelle Konfiguration).

- Lokale ModellunterstützungIntegration großer nativer Sprachmodelle, die durch Skripte gezogen und an GPU- oder CPU-Umgebungen angepasst werden können.

- Live-ServerEchtzeit-Kommunikationsfunktionen zur Unterstützung dynamischer Workflow-Anpassungen und Dateninteraktionen.

- Datenbank-IntegrationDrizzle ORM: Unterstützt die Konfiguration von Datenbanken durch Drizzle ORM, um die Datenverwaltung zu vereinfachen.

- Open Source und Beiträge der GemeinschaftBasierend auf der Apache-2.0-Lizenz wird die Beteiligung der Gemeinschaft an der Entwicklung und Optimierung gefördert.

Hilfe verwenden

Installation und Einsatz

Sim Studio bietet eine Vielzahl von Installations- und Bereitstellungsoptionen, um den unterschiedlichen Benutzeranforderungen gerecht zu werden. Nachfolgend finden Sie die detaillierten Schritte:

Methode 1: NPM-Paket verwenden (am einfachsten)

Dies ist der schnellste Weg für eine lokale Bereitstellung: Installieren Sie einfach Docker.

- Stellen Sie sicher, dass Docker installiert ist und läuft.

- Führen Sie den folgenden Befehl im Terminal aus:

npx simstudio - Öffnen Sie Ihren Browser und besuchen Sie

http://localhost:3000/。 - Optionale Parameter:

-p, --port <port>Gibt den Run-Port an (Standard 3000).--no-pullÜberspringen Sie das Ziehen des neuesten Docker-Images.

Methode 2: Docker Compose verwenden

Ideal für Benutzer, die mehr Kontrolle benötigen.

- Klon-Lagerhaus:

git clone https://github.com/simstudioai/sim.git cd sim - Führen Sie Docker Compose aus:

docker compose -f docker-compose.prod.yml up -d - Interviews

http://localhost:3000/。 - Wenn ein lokales Modell verwendet wird:

- Ziehen Sie das Modell:

./apps/sim/scripts/ollama_docker.sh pull <model_name> - Schaffung eines Umfelds, das lokale Modelle unterstützt:

- GPU-Umgebung:

docker compose --profile local-gpu -f docker-compose.ollama.yml up -d - CPU-Umgebung:

docker compose --profile local-cpu -f docker-compose.ollama.yml up -d

- GPU-Umgebung:

- Server-Einsatz: Editorial

docker-compose.prod.ymlEinstellungenOLLAMA_URList die öffentliche IP des Servers (z. B.http://1.1.1.1:11434), und führen Sie es dann erneut aus.

- Ziehen Sie das Modell:

Ansatz 3: Verwendung von Entwicklungscontainern

Für Entwickler, die VS Code verwenden.

- Installieren Sie VS Code und die Erweiterung Remote - Containers.

- Wenn Sie das geklonte Sim Studio-Projekt öffnen, fordert VS Code Sie auf, es erneut in einem Container zu öffnen.

- Klicken Sie auf die Eingabeaufforderung und das Projekt wird automatisch im Container ausgeführt.

- Läuft im Terminal:

bun run dev:fulloder verwenden Sie einen Kurzbefehl:

sim-start

Methode 4: Manuelle Konfiguration

Ideal für Benutzer, die eine vollständige Anpassung benötigen.

- Klonen Sie das Repository und installieren Sie die Abhängigkeiten:

git clone https://github.com/simstudioai/sim.git cd sim bun install - Konfigurieren Sie die Umgebungsvariablen:

cd apps/sim cp .env.example .envCompiler

.envDatei, setzen Sie dieDATABASE_URL、BETTER_AUTH_SECRET和BETTER_AUTH_URL。 - Initialisieren Sie die Datenbank:

bunx drizzle-kit push - Starten Sie den Dienst:

- Starten Sie das Next.js Frontend:

bun run dev - Betreiben Sie einen Live-Server:

bun run dev:sockets - Führen Sie beide gleichzeitig aus (empfohlen):

bun run dev:full

- Starten Sie das Next.js Frontend:

Hauptfunktionen

- Erstellen von AI-Workflows:

- Melden Sie sich bei Sim Studio an (Cloud oder lokal).

- Wählen Sie in der Schnittstelle "Neuer Workflow".

- Ziehen Sie Module per Drag & Drop oder konfigurieren Sie KI-Agenten über Vorlagen, um eine Verbindung zu Tools wie Slack, Notion oder benutzerdefinierten APIs herzustellen.

- Legen Sie Auslösebedingungen und Ausgabeziele fest, speichern und testen Sie den Workflow.

- Lokale Modelle verwenden:

- Pull-Modelle (z. B. LLaMA oder andere Open-Source-Modelle):

./apps/sim/scripts/ollama_docker.sh pull <model_name> - Wählen Sie Lokales Modell in der Workflow-Konfiguration, um den GPU- oder CPU-Modus festzulegen.

- Testen Sie die Reaktion des Modells, um sicherzustellen, dass der Arbeitsablauf ordnungsgemäß funktioniert.

- Pull-Modelle (z. B. LLaMA oder andere Open-Source-Modelle):

- Echtzeitkommunikation:

- Der Real-Time Server von Sim Studio unterstützt die dynamische Anpassung von Arbeitsabläufen.

- Aktivieren Sie den Echtzeitmodus in der Schnittstelle, um den Datenfluss und die Ausgabeergebnisse zu beobachten.

- Workflow-Aktualisierungen können manuell über die API oder die Schnittstelle ausgelöst werden.

- Verwaltung von Datenbanken:

- Verwenden Sie Drizzle ORM, um eine Datenbank zum Speichern von Workflow-Daten zu konfigurieren.

- 在

.envaufstellenDATABASE_URLLaufenbunx drizzle-kit pushInitialisierung. - Anzeigen und Verwalten von Datentabellen über die Schnittstelle.

caveat

- Stellen Sie sicher, dass die Docker-Version auf dem neuesten Stand ist, um Kompatibilitätsprobleme zu vermeiden.

- Lokale Modelle benötigen viel Speicherplatz und Rechenressourcen, weshalb leistungsstarke GPUs empfohlen werden.

- Die Serverbereitstellung erfordert die Konfiguration öffentlicher IPs und Ports, um einen ordnungsgemäßen externen Zugriff zu gewährleisten.

Anwendungsszenario

- Automatisierte Kundenbetreuung

Verwenden Sie Sim Studio, um KI-Kundendienstagenten zu erstellen, die sich mit CRM-Systemen und Chat-Tools verbinden, um Kundenanfragen automatisch und mit weniger menschlichen Eingriffen zu beantworten. - Generierung von Inhalten

Entwickler können Artikel, Code oder Designentwürfe aus lokalen Modellen generieren und dabei die Notion oder Google Drive Speicherausgabe. - Arbeitsablauf der Datenanalyse

Konfigurieren Sie KI-Agenten, um CSV-Daten zu analysieren, visuelle Berichte zu erstellen, Verbindungen zu Tableau oder benutzerdefinierten APIs herzustellen, um die Verarbeitung zu automatisieren. - Persönliche Produktivitätswerkzeuge

Verbinden Sie Kalender-, E-Mail- und Aufgabenverwaltungstools, um automatisch Besprechungen zu planen oder Zusammenfassungen zu erstellen.

QA

- Ist Sim Studio kostenlos?

Sim Studio ist ein Open-Source-Projekt, das auf der Apache-2.0-Lizenz basiert und kostenlos genutzt werden kann. Für die Cloud-Version können Hosting-Gebühren anfallen; Details finden Sie in der offiziellen Preisübersicht. - Programmiererfahrung erforderlich?

Nicht erforderlich. Die Schnittstelle ist einfach und für technisch nicht versierte Benutzer geeignet. Entwickler können jedoch komplexere Funktionen durch manuelle Konfiguration oder APIs implementieren. - Welche großen Sprachmodelle werden unterstützt?

Unterstützt eine breite Palette von Open-Source-Modellen (z. B. LLaMA), die über Skripte abgerufen und lokal ausgeführt werden können. - Wie kann ich Code beisteuern?

Lesen Sie den Contributing Guide im GitHub-Repository und reichen Sie einen Pull Request ein, um sich an der Entwicklung zu beteiligen.