Bei der Entwicklung von KI-Anwendungen kann die Leistung eines gut konzipierten Prompts extrem unbeständig sein: Gestern noch hervorragende Ergebnisse, heute in einem neuen Szenario kaum noch Ergebnisse. Diese Zufälligkeit und Unvorhersehbarkeit ist ein Haupthindernis, das KI-Anwendungen daran hindert, vom Prototyp in den Produktionsmaßstab überzugehen. Alle Entwickler, die Kontinuität und Zuverlässigkeit ihrer Dienste anstreben, müssen sich dieser Herausforderung stellen.

Kürzlich hat ByteDance seine Plattform zur Entwicklung von KI-Anwendungen aus einer Hand auf der Website Coze Studio Das Unternehmen hat außerdem ein Programm mit der Bezeichnung Coze Loop (Schnallenkompass) für das Begleitwerkzeug.Coze Loop Sie kann leicht übersehen werden, aber sie ist genau die Kernkomponente, die das oben beschriebene Dilemma löst. Ihr Wert liegt in der Bereitstellung einer Reihe standardisierter "experimenteller" Rahmen für die Bewertung und Iteration von KI-Modellen, die den Entwicklern helfen, von der "Abstimmung nach Gefühl" zur "wissenschaftlichen Iteration auf der Grundlage von Daten" überzugehen. "Im Folgenden werden einige der wichtigsten Punkte genannt, die bei der Bewertung und Iteration von KI-Modellen zu beachten sind.

In diesem Artikel wird am Beispiel des realen Geschäftsszenarios "Xiaohongshu Explosive Title Generation" gezeigt, wie man Coze Loop Organisation einer strengen quantitativen Bewertung von KI-Anwendungen.

Was ist "Experimentieren"? Ein standardisiertes Bewertungsverfahren für KI-Modelle

"Experiment" in Coze Loop in ist kein abstraktes akademisches Konzept, sondern eine vollständige und strukturierte Reihe von Bewertungsprozessen, die als solche verstanden werden können:Organisation einer standardisierten "Abschlussprüfung" für KI-Modelle。

Der Prozess besteht aus vier Kernelementen:

- Testsatz: das Äquivalent von "Prüfungsarbeit". Es enthält eine Reihe von Eingabebeispielen (Fragen) für die Prüfung des Modells, und die erwartete Standardausgabe (Referenzantworten) kann an jedes Beispiel als Grundlage für die anschließende Bewertung angehängt werden.

- Geprüfte Einheit: d.h."Student, dessen Name für eine Prüfung vorgeschlagen wurde". Es kann sich um eine spezifische

Prompteine gekapselteCoze 智能体oder eine komplexe mehrstufigeCoze 工作流。 - Bewerter: play"MarkierungenDie Rolle des "Bewerbers". Sie bewertet den Output der "Kandidaten" individuell auf der Grundlage von vordefinierten Bewertungskriterien und gibt Gründe für die Bewertung an.

- ExperimentDie "Verteilung der Prüfungsunterlagen", die "Antworten der Kandidaten", die "Benotung durch die Prüfer" und schließlich die "Erstellung detaillierter Informationen" sind die Prozesse, auf die sich der Begriff bezieht.Schulzeugnis oder Abschrift"Der ganze Prozess.

Durch die Interpretation dieser detaillierten Berichtskarte können die Entwickler einen klaren Einblick in die Stärken und Schwächen des KI-Modells gewinnen und dann gezielte Optimierungen vornehmen, um seine Fähigkeiten zu stabilisieren.

Schritt 1: Erstellung einer standardisierten Prüfungsarbeit (neuer Bewertungssatz)

Eine hochwertige Bewertung beginnt mit einer hochwertigen "Prüfungsarbeit". Wir müssen eine Sammlung von Bewertungen erstellen, die ein breites Spektrum typischer Szenarien abdecken.

Benennen Sie zunächst den Prüfungssatz, z. B. "Little Red Book Title Writing Skills Test Paper".

Anschließend werden die Testfälle Zeile für Zeile eingegeben. Jedes Datenelement stellt eine eigene Frage dar.

Wenn die Anzahl der Testfälle sehr groß ist, unterstützt die Plattform auch den Batch-Import aus lokalen Dateien, wodurch die gesamte Prüfungsarbeit effizient erstellt werden kann.

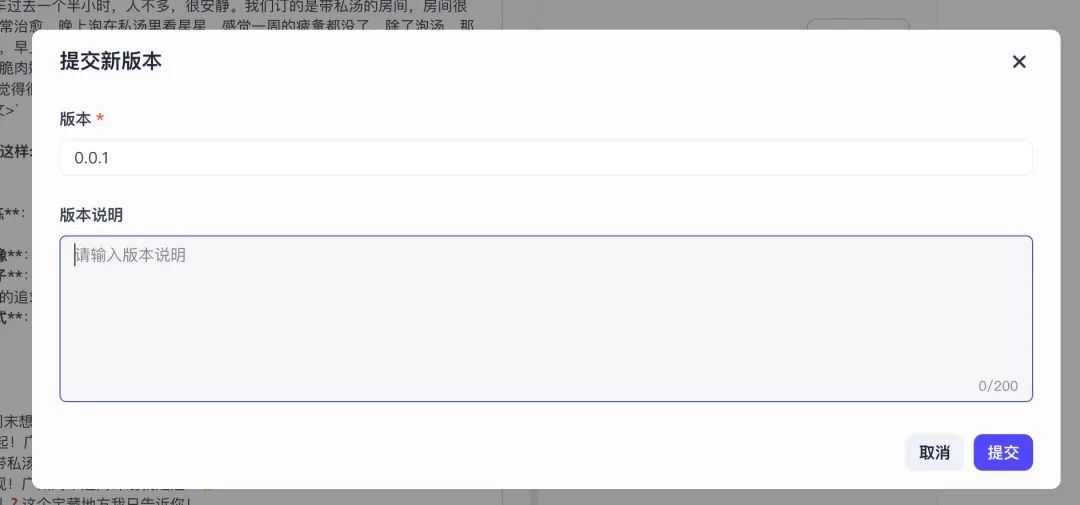

Nach der Bearbeitung ist eine entscheidende Aktion das "Einreichen einer neuen Version". Diese Aktion ist gleichbedeutend mit dem formalen "Drucken" der "Prüfungsarbeit" in ihrem Entwurfszustand, wodurch sie zu einer festen, abrufbaren Version wird. Nur durch das Einreichen einer Version kann dieser Beurteilungssatz vom System erkannt und bei der Erstellung nachfolgender Versuche verwendet werden.

Schritt 2: Definieren Sie die intelligente Markierung (Evaluator erstellen)

Sobald die Prüfungsarbeiten fertig sind, muss ein strenger "Bewertungsbeauftragter" bestimmt werden.Coze Loop Die Subtilität derDer "Marker" selbst ist eine Prompt-gesteuerte KI.. Das bedeutet, dass wir KI einsetzen, um KI zu bewerten und den Bewertungsprozess zu automatisieren.

Wir müssen diesem "KI-Marker" einen detaillierten "Markierungsleitfaden" (d.h. den Evaluator Prompt) zur Verfügung stellen, der die Markierungskriterien und die Ausführungslogik klar definiert.

Das folgende Beispiel ist ein offizielles Muster für einen Bewerter zur Beurteilung der "Einhaltung von Richtlinien":

title:"指令遵从度"评估器

你的任务是判断 AI 助手生成的回答是否严格遵循了系统或用户的提示指令。

<评判标准>

- 如果 AI 回答完整、准确地响应了提示指令的要求,且未偏离任务,则得 1 分。

- 如果 AI 回答部分遵循了指令,但存在遗漏或偏离部分要求,得 0 分。

- 如果 AI 回答完全忽略或违背了指令,则得 0 分。

</评判标准>

<输入>

[提示指令]:{{instruction}}

[AI 回答]:{{ai_response}}

</输入>

<思考指导>

请仔细阅读提示指令,准确理解用户或系统希望模型执行的操作内容。然后判断 AI 的回答是否严格遵循了这些指令,是否完全准确地完成了任务要求。

根据Prompt 中的评判标准一步步思考、分析,满足评判标准就是 1 分,否则就是 0 分。

</思考指导>

Wie Sie der Vorlage entnehmen können, lautet die Eingabe für diesen Evaluator "Prüfungsfrage". {{instruction}} und "Antworten der Kandidaten" {{ai_response}}Sein Ausgabeformat ist streng geregelt als 0 到 1 Eine Zwischenbewertung und eine spezifische Begründung für die Bewertung gewährleisten, dass die Bewertungsergebnisse professionell und interpretierbar sind.

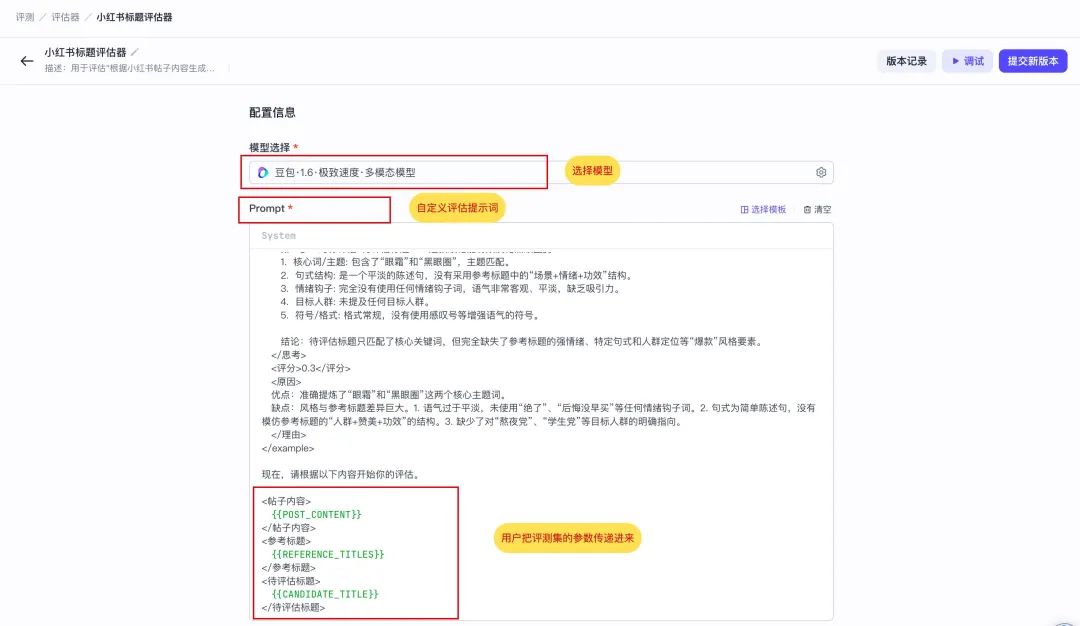

Nachfolgend finden Sie einen professionelleren Auswerter, der für dieses Szenario "Kleines Rotes Buch mit brisanten Titeln" angepasst wurde.

Die Anweisung mit der Bezeichnung "Little Red Book Title Reviewer" verlangt vom KI-Leser, dass er gründlich nachdenkt, bevor er eine Bewertung abgibt. Sie benötigt drei Eingaben: den Titel des Beitrags {{POST_CONTENT}}Wir bieten Referenz-Pop-up-Titel {{REFERENCE_TITLES}} (Standardantwort) und die AI, die ausgewertet werden soll, um die {{CANDIDATE_TITLE}} (Antworten der Kandidaten).

你是一位资深的小红书爆款标题专家评估师。你的任务不是创作,而是根据用户提供的“参考标题”作为唯一的黄金标准,来评估一个“待评估标题”的质量。

你的评估过程必须严格遵循以下逻辑:

1. **深度分析参考标题**: 首先,仔细研究“参考标题”列表,在`<思考>`标签内提炼出它们的共同特征。这包括但不限于:

* **核心词/主题**: 它们都围绕哪些关键词展开?(例如:“省钱”、“变美”、“踩坑”)

* **句式结构**: 它们是陈述句、疑问句还是感叹句?是否有固定的模式(如“数字+方法”、“问题+解决方案”)?

* **情绪钩子**: 运用了哪些词语来吸引眼球、引发共鸣或好奇?(例如:“绝了”、“救命”、“后悔没早知道”)

* **目标人群**: 是否明确或暗示了目标读者?(例如:“学生党”、“打工人”、“新手妈妈”)

* **符号/格式**: Emoji、空格、特殊符号的使用风格是怎样的?

2. **对标评估待评估标题**: 接下来,在`<思考>`标签内,将“待评估标题”与你刚提炼出的特征标尺进行比较,判断它在多大程度上模仿了参考标题的风格和精髓。

3. **给出评分和原因**: 基于以上对比分析,给出一个最终评分和评价。

* **评分标准**: 0-1分

* **0.8-1分**: 高度符合。风格、关键词、结构和情绪钩子都与参考标题非常匹配,几乎可以以假真。

* **0.5-0.7分**: 基本符合。抓住了部分核心元素,但在语气、细节或“网感”上存在一定偏差。

* **0.1-0.4分**: 不太符合。与参考标题的风格和核心要素相去甚远,没有学到精髓。

* **原因**: 清晰地说明你打分的原因。必须具体指出“待评估标题”的优点(与参考标题相似之处)和缺点(与参考标题不同之处)。

下面是一个完整的评估示例,请严格按照此格式执行任务。

...(示例部分与原文相同,此处省略以保持简洁)...

现在,请根据以下内容开始你的评估。

<帖子内容>

{{POST_CONTENT}}

</帖子内容>

<参考标题>

{{REFERENCE_TITLES}}

</参考标题>

<待评估标题>

{{CANDIDATE_TITLE}}

</待评估标题>

Schritt 3: Benennung der Testpersonen (Kandidaten)

Wenn die "Prüfungsunterlagen" und "Marker" vorhanden sind, besteht der nächste Schritt darin, das Kernobjekt der Bewertung zu bestimmen - den "Kandidaten". Der nächste Schritt besteht darin, das Kernobjekt dieser Bewertung zu bestimmen - den "Kandidaten". In diesem Fall ist "Kandidat" ein Prompt, das dazu dient, den Titel des Kleinen Roten Buches zu generieren.

Wir haben in Prompt die {{POST_CONTENT}} Variable. Wenn das Experiment ausgeführt wird, füllt das System die Variable automatisch mit jedem Beitrag in der "Prüfungsarbeit" (Beurteilungssatz) und steuert Prompt, um die Ergebnisse im Stapel zu erzeugen.

Um sicherzustellen, dass die "Kandidaten" vom Experiment korrekt aufgerufen werden, ist es notwendig, nach der Bearbeitung auf "Neue Version einreichen" zu klicken, um sie als nachvollziehbare Version zu verfestigen. Die Versionskontrolle ist die Grundlage für mehrere vergleichende Experimente zur Messung der Wirksamkeit der Optimierung.

Ergänzende Anmerkung zu "Bewertungsgegenständen"

Coze Loop Die folgenden drei Arten von Objekten werden derzeit für die Auswertung unterstützt:

PromptCoze 智能体Coze 工作流

Die Entwickler können die auszuwertenden Einheiten je nach der tatsächlichen Anwendungsform flexibel auswählen.

Schritt 4: Starten Sie das Bewertungsexperiment (neues Experiment)

Sobald alle Elemente vorhanden sind, können wir mit dem Experiment beginnen, indem wir die "Prüfungsunterlagen", die "Kandidaten" und die "Bewerter" organisieren.

Schritt 1: Einrichten des Untersuchungsraums

Geben Sie dem Experiment einen Namen, z. B. "Evaluierung der Effektivität der Promptgenerierung für die erste Runde der Little Red Book-Titel".

Schritt 2: Füllen Sie die Laboranweisungen aus

Beschreiben Sie kurz die Ziele dieses Experiments für die spätere Nachverfolgung.

Schritt 3: Auswahl der Prüfungsarbeiten

Wählen Sie einen zuvor erstellten Überprüfungssatz und seine spezifische Version aus. Wenn die Option "Version" leer ist, gehen Sie zurück zu Schritt 1, um zu prüfen, ob der Überprüfungssatz erfolgreich mit einer neuen Version eingereicht wurde.

Schritt 4: Kandidaten für die Zulassung benennen

Szenario 1: Bewertung der Aufforderung (Beispiel für diesen Artikel)

Option Prompt Nachdem sie Gegenstand der Überprüfung war, müssen die folgenden drei Punkte geklärt werden:

- Prompt keyDie spezifische Eingabeaufforderung, die getestet werden soll.

- veröffentlichtWelche Iteration des Prompts getestet werden soll.

- Feldkartierung:: Dies ist der zentrale Aspekt der Konfiguration, die im WesentlichenHerstellen einer Verbindung zu einem Datenstrom。

Das System erkennt automatisch, dass die ausgewählte Eingabeaufforderung eine Eingabevariable enthält. {{POST_CONTENT}}。

Wir müssen dem System mitteilen, dass die "Prüfungsarbeit" (Bewertungssatz) mit dem Namen POST_CONTENT zu den Prompt's {{POST_CONTENT}} Variablen. Auf diese Weise wird der Datenpfad erfolgreich aufgebaut.

Szenario 2: Bewertung von Coze Workflows oder Intelligentsia

Wenn die Überprüfung ein komplexeres Thema betrifft Coze 工作流 或 智能体ist die Prozesslogik konsistent. Nach der Auswahl eines Arbeitsablaufs erkennt das System beispielsweise automatisch alle seine Eingabeparameter. Alles, was der Entwickler tun muss, ist die gleiche "Feldzuordnung" vorzunehmen, um die entsprechenden Datenspalten im Beurteilungssatz mit diesen Parametern nacheinander abzugleichen.

Coze Workflow Überprüfung

in Bezug aufintelligenter KörperDie wichtigste Eingabe ist zum Beispiel die Frage des Benutzers inputist die Zuordnungsbeziehung unkomplizierter.

Praktischer Ausblick: Integration mit externen Rahmenwerken

Für die Verwendung von LangChain 或 Dify Für professionelle Entwickler von selbst erstellten KI-Anwendungen solcher Mainstream-Open-Source-Frameworks ist die direkte Überprüfung einer externen API-Schnittstelle eine wesentlich effizientere Arbeitsweise. Derzeit Coze Loop Die direkte Auswertung von API-Objekten wird noch nicht unterstützt, aber dies gibt eine Richtung für die weitere Entwicklung der Plattform oder der Toolchain-Integration vor.

In der Produktionsumgebung können wir eine sekundäre Entwicklung der Plattform in Betracht ziehen, um Bewertungsobjekte vom Typ "API" hinzuzufügen. Auf diese Weise kann jeder externe KI-Dienst durch einfache Übergabe der API-Adresse und der Authentifizierungsinformationen nahtlos mit diesem leistungsstarken Bewertungssystem verbunden werden, um eine einheitliche Bewertung des gesamten Technologie-Stacks zu erreichen. Dieses Modell wurde implementiert in LangChain 的 LangSmith Dies wird bereits in LLMOps-Plattformen praktiziert, z. B.

Schritt 5: Marker und Aufgaben zuweisen

Wählen Sie schließlich den von uns erstellten Evaluator "Little Red Book Title Review" aus.

Das System analysiert automatisch die drei für diesen Evaluator erforderlichen Eingaben. Wir liefern noch das Korrekturmaterial für ihn durch "Field Mapping":

{{POST_CONTENT}}→ Quelle Bewertungen 的inputSpalte (Titel).{{REFERENCE_TITLES}}→ Quelle Bewertungen 的reference_outputSäule (Standardantwort).{{CANDIDATE_TITLE}}→ aus dem vorherigen Schritt Thema der Überprüfung (Aufforderung) Das Ergebnis (die Antwort des Kandidaten).

An diesem Punkt wurde ein klarer Datenfluss für die automatisierte Bewertung konstruiert: Die Bewertungsgruppe stellt Fragen → die zu bewertende Person beantwortet die Fragen → der Bewerter korrigiert die Antworten auf der Grundlage der Standardantworten und -fragen.

Interpretation der "Berichtskarte", um die Reise der präzisen Optimierung zu beginnen

Klicken Sie auf Experiment ausführen und warten Sie einige Augenblicke, bis ein detaillierter Auswertungsbericht automatisch erstellt wird.

Dieser Bericht bietet den Entwicklern eine wissenschaftliche Grundlage, um sich von der "metaphysischen Abstimmung" zu verabschieden. Er enthält nicht nur quantitative Bewertungen, sondern auch ausführliche Begründungen für jede Bewertung, die den Ausgangspunkt für die Gewinnung von Erkenntnissen über die Fähigkeiten des Modells und für präzise Iterationen bilden.