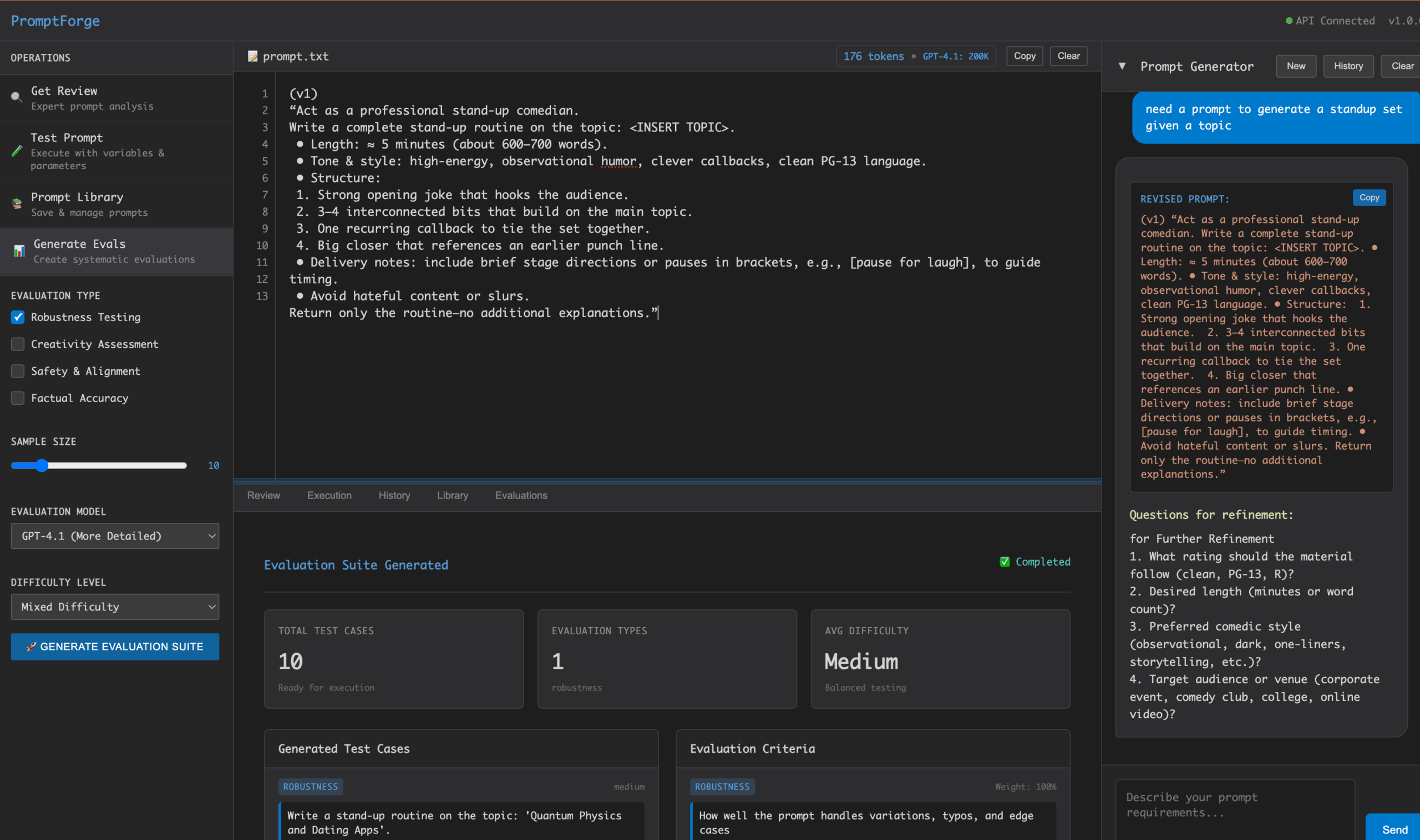

PromptForge ist eine Open-Source-Workbench für die Entwicklung von Prompt-Wörtern, die Benutzern beim Entwerfen, Testen und Optimieren von Prompt-Wörtern für KI-Modelle hilft. Es bietet leistungsstarke Analysewerkzeuge und unterstützt mehrere KI-Anbieter wie Anthropic, OpenAI, Azure OpenAI und natives Ollama. Benutzer können schnell effiziente Prompts mit einfacher Konfiguration und Bedienung erstellen, geeignet für Entwickler und Forscher. Das Projekt ist auf GitHub mit 516 Sternen und 56 Forks aktiv und wird von der Community stark unterstützt. Sein Hauptziel ist es, die Effizienz und Qualität der Erstellung von Stichwörtern zu verbessern und die Entwicklung von KI-Anwendungen zu unterstützen.

Funktionsliste

- Unterstützung für mehrere KI-Modelle: kompatibel mit Anthropic, OpenAI, Azure OpenAI und Ollama und andere KI-Anbieter.

- Intelligente Stichwortvorschläge: Bietet kontextbasierte Vorschläge zur Verbesserung von Stichwörtern.

- Cue Testing and Evaluation: Unterstützt das systematische Testen von Cue-Effekten und bietet detaillierte Analysen.

- Die Umgebung ist einfach zu konfigurieren: über die

.envDatei, um API-Schlüssel und Laufzeitumgebungen schnell einzurichten. - Community-gesteuerte Entwicklung: offener Quellcode, Annahme von Beiträgen der Community und Feedback zu Problemen.

- Lokale Laufzeitunterstützung: Unterstützung für die lokale Bereitstellung, geeignet für Entwicklungs- und Testszenarien.

Hilfe verwenden

Einbauverfahren

PromptForge ist für diejenigen, die mit Git und der Kommandozeile vertraut sind, einfach zu installieren. Hier sind die Schritte im Detail:

- Klon-Lager

Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um das Projekt lokal zu klonen:git clone https://github.com/insaaniManav/prompt-forge.gitSobald das Klonen abgeschlossen ist, wechseln Sie in das Projektverzeichnis:

cd prompt-forge - Konfiguration der Umgebung

Für das Projekt muss der Benutzer einen API-Schlüssel angeben, um eine Verbindung zum KI-Modell herzustellen. Kopieren Sie die Beispiel-Umgebungsdatei:cp .env.example .envVerwenden Sie einen Texteditor (z. B.

nano或vim) Öffnen.envfügen Sie den erforderlichen API-Schlüssel hinzu. Beispiel:ANTHROPIC_API_KEY="sk-ant-api03-..." OPENAI_API_KEY="sk-..." AZURE_OPENAI_API_KEY="your-key" AZURE_OPENAI_BASE_URL="https://your-resource.openai.azure.com" OLLAMA_BASE_URL="http://localhost:11434" DEFAULT_AI_PROVIDER="ollama"Füllen Sie die entsprechenden Schlüssel nach Bedarf aus. Wenn Sie ein lokales Ollama-Modell verwenden, vergewissern Sie sich, dass sich der Ollama-Dienst im Verzeichnis

http://localhost:11434Laufen. - Laufende Projekte

gehen inapiVerzeichnis und starten Sie den Dienst:cd api && go run main.goSobald das Projekt gestartet ist, können die Benutzer über eine lokale Schnittstelle oder API auf die Funktionen von PromptForge zugreifen.

Hauptfunktionen

Der Kern von PromptForge ist die Erstellung, Prüfung und Optimierung von Prompt-Wörtern. Nachfolgend finden Sie einen detaillierten Überblick über die wichtigsten Funktionen:

1. das Erstellen von Stichworten

- Verfahren:

- Öffnen Sie die Schnittstelle von PromptForge (normalerweise lokal)

http://localhost:8080(Der spezifische Port wird durch das Laufzeitprotokoll bestätigt). - Geben Sie in das Eingabefeld für das Aufforderungswort das erste Aufforderungswort ein, z. B. "Erstellen Sie einen wissenschaftlich-technischen Artikel mit 500 Wörtern über die künftige Entwicklung der künstlichen Intelligenz".

- Wählen Sie das AI-Modell (z. B. Anthropic (oder OpenAI).

- Klicken Sie auf die Schaltfläche "Generieren", um die Ausgabe des Modells zu sehen.

- Öffnen Sie die Schnittstelle von PromptForge (normalerweise lokal)

- Ausgewählte Funktionen:

PromptForge bietet "Smart Suggestions". Nach der Generierung der Ergebnisse analysiert das System die Klarheit und Effektivität der Prompts und empfiehlt Verbesserungen. Zum Beispiel kann das System vorschlagen, "Erstelle einen wissenschaftlichen Artikel" in "Erstelle einen klar strukturierten wissenschaftlichen Artikel mit Fallstudien" zu ändern, um die Qualität der Ausgabe zu verbessern.

2. die Test- und Bewertungsaufforderungen

- Verfahren:

- Geben Sie im Modul "Test" mehrere Varianten des Aufforderungswortes ein. Zum Beispiel:

- Aufforderungswort 1: "Schreiben Sie einen Aufsatz über KI".

- Aufforderung Wort 2: "Schreiben Sie einen KI-Artikel mit 500 Wörtern, der Beispiele aus der Praxis enthält".

- Wählen Sie Testparameter wie Modelltyp, Ausgabelänge oder Anzahl der Generationen.

- Klicken Sie auf "Run Test", das System wird die Ergebnisse im Batch-Verfahren generieren und die vergleichende Analyse anzeigen.

- Im Analysebericht finden Sie die Bewertungen für jedes Stichwort (basierend auf Klarheit, Relevanz und Ausgabequalität).

- Geben Sie im Modul "Test" mehrere Varianten des Aufforderungswortes ein. Zum Beispiel:

- Ausgewählte Funktionen:

Das System bietet visuelle Analysewerkzeuge, wie z. B. Balkendiagramme oder Tabellen, um den Unterschied in der Wirksamkeit verschiedener Hinweise aufzuzeigen. Auf der Grundlage des Berichts können die Benutzer die Aufforderungen optimieren.

3. die Optimierung der Stichwörter

- Verfahren:

- Laden Sie im Modul Optimieren die getesteten Stichwörter hoch.

- Auf der Grundlage der Testergebnisse schlägt das System vor, den Wortlaut zu ändern, Details hinzuzufügen oder die Sprache zu vereinfachen.

- Die Benutzer können das Stichwort direkt bearbeiten und erneut testen.

- Ausgewählte Funktionen:

PromptForge unterstützt die iterative Optimierung, indem es die historische Version jeder Optimierung aufzeichnet, so dass der Benutzer leicht zurückgehen und vergleichen kann.

4. lokaler Betrieb des Ollama-Modells

- Verfahren:

- Vergewissern Sie sich, dass Ollama lokal installiert ist und läuft (siehe die offizielle Ollama-Dokumentation).

- 在

.envDatei zur Konfiguration derOLLAMA_BASE_URL="http://localhost:11434"。 - Wählen Sie Ollama als Standard-KI-Anbieter (

DEFAULT_AI_PROVIDER="ollama")。 - Beim Testen von Stichwörtern ruft das System das lokale Modell auf, um die Ergebnisse zu generieren.

- Ausgewählte Funktionen:

Läuft lokal ohne Internetverbindung, geeignet für Entwicklungsumgebungen oder datenschutzsensible Szenarien.

caveat

- API-Schlüssel-Sicherheit: Setzen Sie nicht

.envDie Datei wird in ein öffentliches Repository hochgeladen, um die Offenlegung des Schlüssels zu vermeiden. - Abhängige UmgebungStellen Sie sicher, dass die Go-Sprachumgebung (Version 1.16 oder höher) und Git installiert sind.

- Unterstützung der GemeinschaftWenn Sie auf Probleme stoßen, können Sie einen Issue im GitHub-Repository einreichen oder die bestehenden Pull Requests überprüfen.

Anwendungsszenario

- Entwicklung von AI-Anwendungen

Entwickler verwenden PromptForge zum Entwerfen und Testen von Prompts, um die Ausgabe eines Dialogsystems oder einer Anwendung zur Inhaltserstellung zu optimieren. Bei der Entwicklung eines Chatbots können Sie zum Beispiel verschiedene Prompts testen, um natürlichere Antworten zu erhalten. - Forschung und Erprobung

Die Forscher nutzten PromptForge, um die Leistung von KI-Modellen bei verschiedenen Hinweisen zu bewerten und die Auswirkungen des Hinweisdesigns auf die Modellausgabe zu untersuchen. Zum Beispiel testeten sie die Auswirkungen von "kurzen Beschreibungen" und "detaillierten Anweisungen" auf die Qualität der Generierung. - Bildung und Ausbildung

Lehrkräfte oder Ausbilder verwenden PromptForge zur Erstellung von Lernaufforderungen, um maßgeschneiderte Lernmaterialien zu erstellen. Entwerfen Sie zum Beispiel Prompts, um schülerspezifische Übungsfragen oder Fallstudien zu erstellen.

QA

- Welche KI-Modelle werden von PromptForge unterstützt?

Unterstützung für Anthropic-, OpenAI-, Azure OpenAI- und native Ollama-Modelle ist für Benutzer über die.envDatei-Konfiguration. - Wie behebt man Laufzeit-API-Schlüssel-Fehler?

Sonde.envDer Schlüssel in der Datei ist korrekt, und stellen Sie sicher, dass der API-Zugang für das dem KI-Anbieter entsprechende Konto aktiviert ist. - Wie viele Computerressourcen werden für den lokalen Betrieb benötigt?

Die Ausführung von PromptForge ist von Natur aus weniger ressourcenintensiv, aber lokale Ollama-Modelle können GPU-Unterstützung erfordern, daher werden mindestens 8 GB Videospeicher empfohlen. - Wie kann ich Code beisteuern?

Besuchen Sie das GitHub-Repository, forken Sie das Projekt und reichen Sie einen Pull Request ein; es wird empfohlen, dass Sie sich zuerst die bestehenden Issues ansehen, um zu sehen, was die Community will.