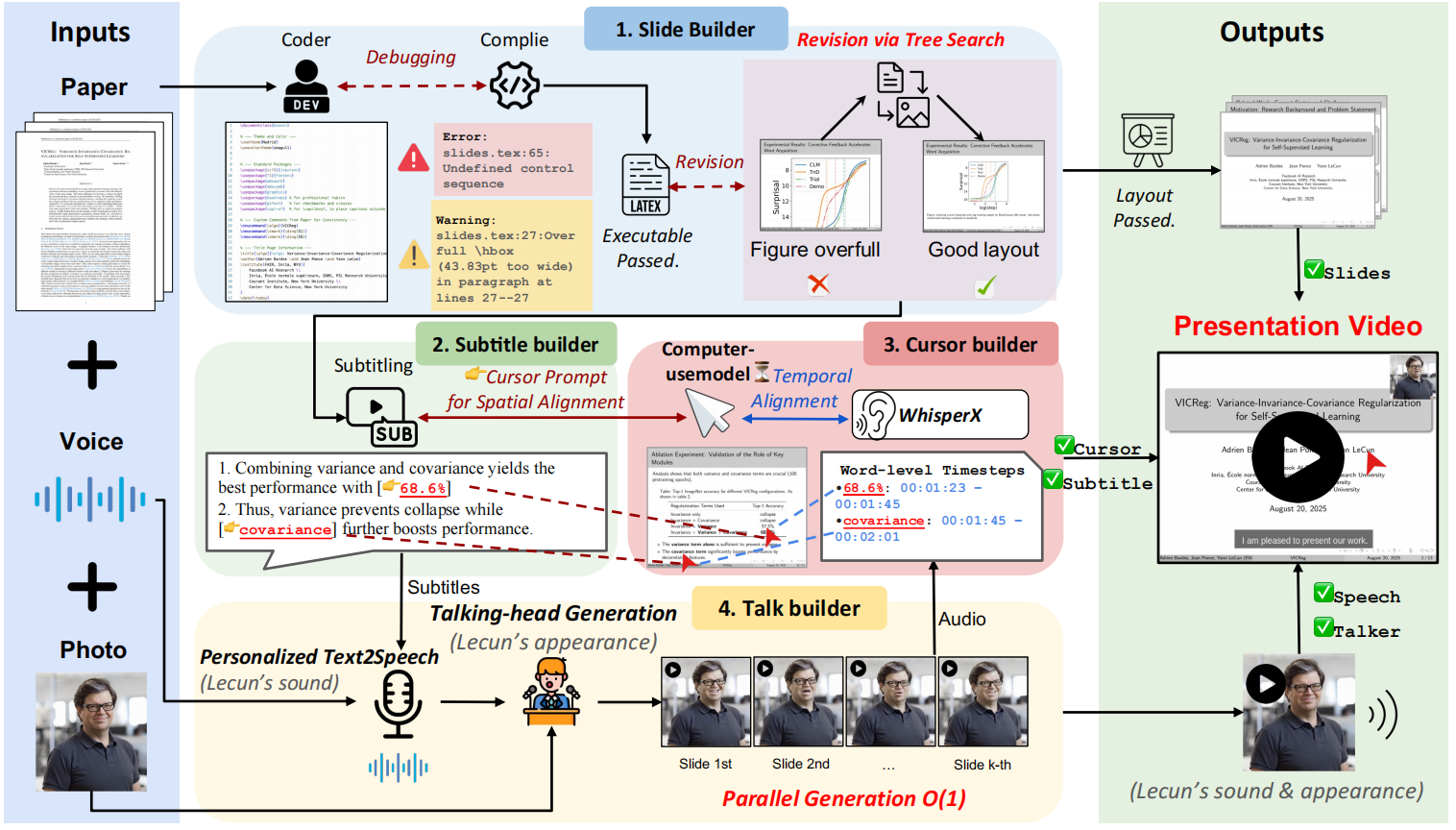

Paper2Video ist ein Open-Source-Projekt, das Forscher von der mühsamen Vorbereitung von Videos akademischer Präsentationen befreien soll. Das Herzstück des Projekts ist ein Multi-Intelligenz-Framework namens PaperTalker, das ein in LaTeX geschriebenes Papier, ein Referenzbild des Sprechers und ein Referenz-Audio erhält und dann vollautomatisch ein komplettes Video der Präsentation erstellt. PaperTalker automatisiert den gesamten Prozess von der Extraktion des Inhalts, der Erstellung von Folien (Slides), der Generierung von Untertiteln, der Sprachsynthese, der Mausverfolgung und dem Rendering des virtuellen digitalen menschlichen Vortragsvideos. Um die Qualität des generierten Videos wissenschaftlich zu bewerten, schlägt das Projekt auch einen Benchmark namens Paper2Video vor, der 101 Vorträge und die dazugehörigen Vortragsvideos der Autoren enthält, und entwickelt mehrere Bewertungsdimensionen, um zu messen, ob das Video die Informationen des Vortrags genau wiedergeben kann.

Funktionsliste

- Multi-Intelligenz-ZusammenarbeitNutzung mehrerer Intelligenzen, einschließlich Foliengeneratoren und Untertitelgeneratoren, um die Arbeit aufzuteilen und komplexe Aufgaben der Videoerstellung zu erledigen.

- Automatisierte DiaserzeugungExtrahiert den Kerninhalt direkt aus dem LaTeX-Quellcode eines Papiers, generiert automatisch Folien für Präsentationen und optimiert das Layout durch Kompilierungs-Feedback.

- Sprach- und UntertitelsyntheseGenerieren Sie entsprechende Präsentationen auf der Grundlage von Folieninhalten und synthetisieren Sie Audio mithilfe von Text-to-Speech (TTS)-Technologie, während Sie Untertitel mit genau abgestimmten Zeitstempeln erzeugen.

- Mausspur-SimulationAnalyse von Präsentationsinhalten und Folienelementen zur automatischen Generierung von Mausbewegungen und Klickverläufen, die denen von echten Menschen nachempfunden sind und dazu dienen, die Aufmerksamkeit des Publikums während der Präsentation zu lenken.

- Erzeugung virtueller digitaler PersonenMit einem Foto des Sprechers in der Vorderansicht kann eine virtuelle digitale Person (Talking Head) erzeugt werden, die im Video spricht und das Video ausdrucksstärker macht.

- ParallelverarbeitungParallele Verarbeitung von Generierungsaufgaben, die sich auf jede Folienseite beziehen (z. B. Stimme, Mausspur usw.), um die Effizienz der Videogenerierung drastisch zu verbessern.

- Zwei GenerierungsmodiEin vollständiger Modus mit VMs und ein schneller Modus ohne VMs stehen zur Verfügung, und die Benutzer können je nach ihren Bedürfnissen wählen.

Hilfe verwenden

Paper2Video bietet eine automatisierte Pipeline zur Synthese von LaTeX-formatierten Papierprojekten, Sprecherbildern und Audiobeispielen zu einem vollständigen akademischen Vorlesungsvideo.

1. die Vorbereitung der Umwelt

Bevor Sie beginnen, müssen Sie die Umgebung für die Ausführung des Projekts vorbereiten. Es wird empfohlen, mit Conda eine separate Python-Umgebung zu erstellen, um Paketversionskonflikte zu vermeiden.

Installation der primären Umgebung:

Klonen Sie zunächst den Projektcode und gehen Sie zu src Verzeichnis, erstellen und aktivieren Sie dann die Conda-Umgebung.

git clone https://github.com/showlab/Paper2Video.git

cd Paper2Video/src

conda create -n p2v python=3.10

conda activate p2v

Als nächstes installieren Sie alle notwendigen Python-Abhängigkeiten und den LaTeX-Compiler tectonic。

pip install -r requirements.txt

conda install -c conda-forge tectonic

Installation der virtuellen Digimon-Umgebung (optional):

Wenn Sie kein Video der Virtual Digitizer-Präsentation erstellen müssen (d. h. die Schnellversion ausführen), können Sie diesen Schritt überspringen. Abhängigkeiten der Virtual Digital Man-Funktionalität Hallo2 Projekt zu erstellen, muss dafür eine eigene Umgebung geschaffen werden.

# 在 Paper2Video 项目根目录下

git clone https://github.com/fudan-generative-vision/hallo2.git

cd hallo2

conda create -n hallo python=3.10

conda activate hallo

pip install -r requirements.txt

Sobald die Installation abgeschlossen ist, müssen Sie sich Folgendes notieren hallo Der Pfad zum Python-Interpreter für Ihre Umgebung, der für nachfolgende Läufe verwendet wird. Sie können den Pfad mit dem folgenden Befehl ermitteln:

which python

2. das große Sprachmodell (LLM) konfigurieren

Die Fähigkeit von Paper2Video, Inhalte zu verstehen und zu generieren, basiert auf einem leistungsstarken Sprachmodell. Sie müssen Ihren API-Schlüssel konfigurieren. Das Projekt empfiehlt die Verwendung von GPT-4.1 或 Gemini 2.5-Pro für beste Ergebnisse.

Exportieren Sie Ihren API-Schlüssel als Umgebungsvariable in das Terminal:

export GEMINI_API_KEY="你的Gemini密钥"

export OPENAI_API_KEY="你的OpenAI密钥"

3. die Umsetzung der Videogenerierung

Paper2Video bietet zwei Hauptausführungsskripte:pipeline_light.py für die schnelle Erstellung (ohne virtuellen digitalen Menschen).pipeline.py Wird verwendet, um eine Vollversion eines Videos zu erstellen, das eine virtuelle digitale Person enthält.

Mindestanforderungen an die HardwareEin NVIDIA A6000-Grafikprozessor mit mindestens 48 GB Videospeicher wird für die Ausführung dieses Prozesses empfohlen.

Schnellmodus (ohne virtuellen digitalen Mann)

Dieser Modus überspringt den zeitaufwändigen Schritt des Renderns einer virtuellen digitalen Person und erzeugt schnell ein Diashow-Video mit Voiceover, Untertiteln und Mausspur.

Führen Sie den folgenden Befehl aus:

python pipeline_light.py \

--model_name_t gpt-4.1 \

--model_name_v gpt-4.1 \

--result_dir /path/to/output \

--paper_latex_root /path/to/latex_proj \

--ref_img /path/to/ref_img.png \

--ref_audio /path/to/ref_audio.wav \

--gpu_list [0,1,2,3,4,5,6,7]

Vollmodus (mit virtueller digitaler Person)

In diesem Modus werden alle Schritte zur Erstellung eines vollständigen Videos mit dem Bildschirm des Sprechers durchgeführt.

Führen Sie den folgenden Befehl aus:

python pipeline.py \

--model_name_t gpt-4.1 \

--model_name_v gpt-4.1 \

--model_name_talking hallo2 \

--result_dir /path/to/output \

--paper_latex_root /path/to/latex_proj \

--ref_img /path/to/ref_img.png \

--ref_audio /path/to/ref_audio.wav \

--talking_head_env /path/to/hallo2_env \

--gpu_list [0,1,2,3,4,5,6,7]

Beschreibung der Parameter

model_name_tName des großen Sprachmodells, das für die Verarbeitung von Textaufgaben verwendet wird, z. B.gpt-4.1。result_dirSpeichern des Verzeichnisses für die Ausgabeergebnisse, einschließlich der erzeugten Folien, Videos usw.paper_latex_root: Das Stammverzeichnis Ihres LaTeX-Projekts.ref_img:: Referenzbild des Redners, bei dem es sich um ein quadratisches Porträtfoto handeln muss.ref_audioReferenzton des Lautsprechers zum Klonen von Tönen, empfohlen wird ein Sample von etwa 10 Sekunden.talking_head_env(nur für den Vollmodus erforderlich) Zuvor installierthalloPfad zum Python-Interpreter für Ihre Umgebung.gpu_listGPU: Eine Liste von GPU-Geräten, die für parallele Berechnungen verwendet werden.

Am Ende des Laufs können Sie die result_dir Verzeichnis, um alle Zwischendateien und das endgültige Video zu finden.

Anwendungsszenario

- Berichte über wissenschaftliche Konferenzen

Mit Paper2Video können Forscher ihre Arbeiten schnell in Videopräsentationen umwandeln, um sie auf Online-Konferenzen zu präsentieren oder als Konferenzbeiträge einzureichen. Dies spart viel Zeit bei der manuellen Erstellung von Folien und der Aufnahme von Videos. - Verbreitung der Forschungsergebnisse

Die Erstellung leicht verständlicher Videos zu komplexen Dissertationsinhalten und deren Veröffentlichung in sozialen Medien oder auf Videoplattformen kann dazu beitragen, dass die Forschungsergebnisse ein breiteres Publikum erreichen und die wissenschaftliche Wirkung erhöhen. - Bildungs- und Lehrplanmaterialien

Lehrkräfte und Akademiker können klassische oder aktuelle wissenschaftliche Arbeiten in Lehrvideos umwandeln, die als Unterrichtsmaterial verwendet werden können, um den Schülern ein besseres Verständnis der neuesten wissenschaftlichen Erkenntnisse zu vermitteln. - Referat vor der Präsentation und Probe

Vor der formalen Verteidigung oder der Offline-Berichterstellung können die Autoren mit dem Tool ein Vorschaufilmchen erstellen, um den logischen Ablauf, die Zeitsteuerung und die visuelle Gestaltung des Berichts zu überprüfen und zu optimieren.

QA

- Welches Kernproblem wird mit diesem Projekt angegangen?

Dieses Projekt konzentriert sich auf die Lösung des zeit- und arbeitsintensiven Problems der akademischen Videoproduktion von Vorlesungen. Traditionell verbringen Forscher viel Zeit mit dem Entwerfen von Folien, dem Schreiben von Vorträgen, der Aufnahme und dem Schnitt. paper2Video will Forscher von dieser mühsamen Aufgabe befreien, indem es sie automatisiert. - Welche Eingabedateien muss ich vorbereiten, um ein Video zu erstellen?

Sie müssen drei Dinge vorbereiten: ein vollständiges, im LaTeX-Format geschriebenes Projekt, ein quadratisches Frontalfoto des Redners und eine Referenzaufnahme von etwa 10 Sekunden des Redners. - Ich weiß nicht viel über die Hardware-Anforderungen, kann mein normaler Computer das Programm ausführen?

Die Hardware-Anforderungen für dieses Projekt sind sehr hoch, insbesondere für den Grafikprozessor. Die offizielle Empfehlung lautet, mindestens einen NVIDIA A6000-Grafikprozessor mit 48 GB Videospeicher zu verwenden. Ein gewöhnlicher PC oder Laptop wird höchstwahrscheinlich nicht in der Lage sein, den gesamten Generierungsprozess auszuführen, insbesondere den Teil, der das Rendern der virtuellen digitalen Person beinhaltet. - Kann ich dieses Tool auch verwenden, wenn ich mein Gesicht in dem Video nicht zeigen möchte?

kann. Das Projekt bietetpipeline_light.pySkript wird ein schneller Modus ausgeführt, der ein Video mit allen Kernelementen (Folien, Voice-over, Untertitel, Mausspuren) erzeugt, aber nicht den Bildschirm der virtuellen digitalen Person enthält. Dieser Modus erfordert ebenfalls relativ geringe Rechenressourcen.