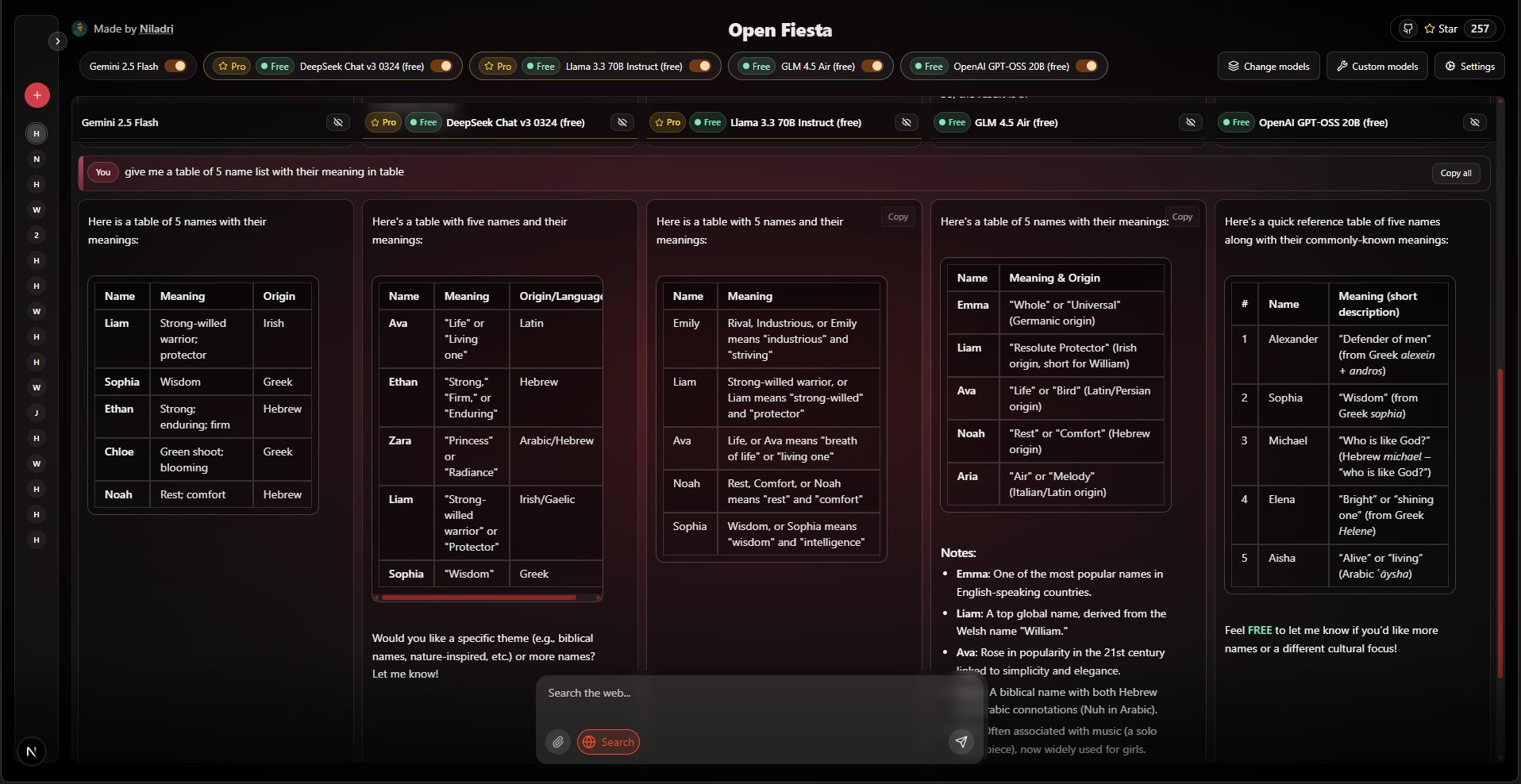

Open-Fiesta ist ein Open-Source-KI-Chat-Tool. Es ermöglicht Nutzern, mit mehreren verschiedenen großen Sprachmodellen gleichzeitig über dieselbe Schnittstelle zu sprechen. Die Benutzer können bis zu fünf Modelle auswählen, einmal eine Frage senden und die verschiedenen Antworten der einzelnen Modelle zum direkten Vergleich nebeneinander sehen. Das Tool unterstützt den Zugang zu einer breiten Palette von Modellen auf den Plattformen Gemini und OpenRouter, wie Llama 3.3, Qwen und Mistral. Neben dem Text-Chat bietet es zusätzliche Funktionen für die Websuche und das Hochladen von Bildern (nur Gemini-Modelle), um die Antwortmöglichkeiten des Modells zu verbessern. Das gesamte Projekt wurde mit dem Next.js-Framework entwickelt, das es den Benutzern ermöglicht, es selbst einzusetzen und zu nutzen, indem sie ihren API-Schlüssel in den Einstellungen eingeben.

Funktionsliste

- Multimodel-ChatUnterstützung für die Auswahl von bis zu 5 KI-Modellen in der gleichen Schnittstelle für den gleichzeitigen Dialog und Vergleich.

- Umfangreiche ModellunterstützungUnterstützung einschließlich DeepSeek R1, Llama 3.3, Qwen, durch Zugang zu Gemini und OpenRouter. Mistral, Moonshot, Reka, Sarvam und viele andere Mainstream- und Open-Source-Modelle.

- Suche im InternetSie können wählen, ob Sie die Web-Suchfunktion beim Senden jeder Nachricht aktivieren möchten, damit das Modell auf die neuesten Internet-Informationen zugreifen kann, um Fragen zu beantworten.

- Bild-EingabeBei der Verwendung des Gemini-Modells kann der Benutzer ein Bild hochladen und das Modell den Inhalt des Bildes verstehen lassen sowie Fragen und Antworten aufnehmen.

- Einfache BenutzeroberflächeDie Benutzeroberfläche ist klar und übersichtlich, unterstützt die direkte Eingabe von Fragen über die Tastatur und zeigt die vom Modell generierten Antworten in Echtzeit an.

- API-SchlüsselverwaltungBenutzer können ihre API-Schlüssel jederzeit im Bereich "Einstellungen" der grafischen Benutzeroberfläche angeben oder ändern oder sie über die Umgebungsvariablendatei konfigurieren.

- Formatierung der AntwortSpezielle Verarbeitung für die Ausgabe des DeepSeek R1-Modells entfernt automatisch Inferenz-Tags und wandelt die Markdown-Formatierung in einfachen Text um, um die Lesbarkeit des Inhalts zu verbessern.

- Offener Quellcode und SelbsteinführungDas Projekt basiert auf der MIT-Lizenz Open Source, Benutzer können den Quellcode herunterladen und lokal oder auf dem Server ausführen.

Hilfe verwenden

Open-Fiesta ist eine Webanwendung, die Sie direkt über die vom Entwickler angegebene URL nutzen können. Sie können aber auch den Quellcode herunterladen und auf Ihrem eigenen Computer oder Server installieren. Nachstehend finden Sie eine detaillierte Beschreibung der Nutzung und des Einsatzes.

Lokaler Bereitstellungsprozess

Wenn Sie Open-Fiesta auf Ihrem eigenen Computer ausführen möchten, müssen Sie zunächst die Node.js-Umgebung installieren und dann die folgenden Schritte ausführen:

- Code herunterladen

Öffnen Sie ein Terminal (Befehlszeilentool) und verwenden SiegitBefehl, um den Projektcode auf Ihren Computer zu klonen:git clone https://github.com/NiladriHazra/Open-Fiesta.gitWechseln Sie dann in das Projektverzeichnis:

cd Open-Fiesta - Installation von Abhängigkeiten

Führen Sie im Stammverzeichnis des Projekts den folgenden Befehl aus, um alle Abhängigkeiten zu installieren, die für die Ausführung des Projekts erforderlich sind:npm i - Konfigurieren des API-Schlüssels

Das Projekt benötigt einen API-Schlüssel, um eine Verbindung zum Big Model-Dienst herzustellen. Sie müssen eine lokale Umgebungsvariablendatei erstellen.env.localum den Schlüssel zu speichern.- Erstellen Sie im Stammverzeichnis des Projekts manuell eine Datei namens

.env.localdes Dokuments. - Öffnen Sie diese Datei und fügen Sie je nach Modell, das Sie verwenden möchten, Folgendes hinzu:

Wenn Sie Modelle von der OpenRouter-Plattform verwenden möchten (was empfohlen wird, da sie eine breite Palette von kostenlosen und kostenpflichtigen Modellen unterstützt), müssen Sie den API-Schlüssel von https://openrouter.ai erhalten und ihn der Datei hinzufügen:

OPENROUTER_API_KEY=你的OpenRouter密钥Wenn Sie das Gemini-Modell von Google verwenden möchten (das Bildeingaben unterstützt), müssen Sie mit der Google AI Studio Ermitteln Sie den API-Schlüssel und fügen Sie ihn der Datei hinzu:

GOOGLE_GENERATIVE_AI_API_KEY=你的Gemini密钥

Sie können beide Schlüssel oder nur einen konfigurieren.

- Erstellen Sie im Stammverzeichnis des Projekts manuell eine Datei namens

- Starten des Entwicklungsservers

Nachdem Sie die obigen Schritte ausgeführt haben, starten Sie das Projekt mit dem folgenden Befehl:npm run devDas Terminal zeigt an, dass die Anwendung erfolgreich gestartet wurde und gibt eine lokale URL an, normalerweise die

http://localhost:3000。 - anfangen zu benutzen

In Ihrem Browser öffnenhttp://localhost:3000Anschließend können Sie Open-Fiesta für Ihren eigenen Einsatz verwenden.

Funktion Betriebsanleitung

Wenn Sie die Open-Fiesta-Schnittstelle öffnen, sehen Sie ein sehr übersichtliches Chat-Fenster.

- Modell auswählen

Oben auf der Chat-Oberfläche sehen Sie den Bereich für die Modellauswahl. Wenn Sie darauf klicken, wird eine Liste der Modelle angezeigt, in der alle von OpenRouter und Gemini unterstützten Modelle aufgeführt sind. Sie können bis zu 5 Modelle aus dieser Liste ankreuzen, mit denen Sie gleichzeitig sprechen möchten. - eine Nachricht senden

Geben Sie Ihre Frage oder Anweisung in das Eingabefeld am unteren Rand ein. Wenn Sie mit der Eingabe fertig sind, können Sie einfach die Eingabetaste (Enter) drücken, um sie zu senden. - Websuche verwenden

Neben dem Eingabefeld befindet sich ein Schalter "Websuche". Wenn Sie möchten, dass das Modell vor der Beantwortung der Frage im Internet nach Informationen sucht, können Sie diesen Schalter aktivieren, bevor Sie die Frage senden. Dies ist besonders nützlich für Fragen, die aktuelle Informationen oder Faktenüberprüfungen erfordern. - Bilder hochladen (nur Gemini)

Wenn Sie ein Modell auswählen, das Gemini enthält, wird neben dem Eingabefeld auch eine Schaltfläche zum Hochladen eines Bildes angezeigt. Klicken Sie darauf, um ein Bild von Ihrem Computer auszuwählen. Sobald das Bild hochgeladen ist, können Sie eine Frage stellen, die das Gemini-Modell dann mit dem Bild beantworten wird. Du könntest zum Beispiel ein Bild von einem Essen hochladen und fragen: "Was ist das für ein Gericht?". . - Antworten ansehen und vergleichen

Nachdem Sie eine Frage gestellt haben, beginnen mehrere Modelle Ihrer Wahl gleichzeitig mit der Erstellung von Antworten. Die Antworten werden nebeneinander in den jeweiligen Karten angezeigt, so dass Sie die Unterschiede sowie die Vor- und Nachteile der verschiedenen Modelle direkt vergleichen können. - Schlüssel für die Laufzeitkonfiguration

Wenn Sie den Einsatz ohne Konfiguration der.env.localDatei, oder wenn Sie vorübergehend einen anderen API-Schlüssel verwenden möchten, können Sie auf die Schaltfläche "Einstellungen" auf der Benutzeroberfläche klicken. In dem Popup-Fenster können Sie direkt Ihren OpenRouter- oder Gemini-API-Schlüssel eingeben. Der Schlüssel, den Sie hier eingeben, ist nur für die aktuelle Browsersitzung gültig; Sie müssen ihn nach dem Schließen der Webseite erneut eingeben.

Anwendungsszenario

- Ersteller von Inhalten

Autoren von Inhalten, z. B. Blogger oder Vermarkter, können dasselbe Thema oder dieselben Anweisungen gleichzeitig in mehrere KI-Modelle eingeben, um schnell einen Textentwurf in verschiedenen Stilen und Winkeln zu erhalten. Dies hilft ihnen, die Schreibfähigkeiten verschiedener Modelle zu vergleichen und die besten Inhalte auszuwählen oder zu kombinieren, was die kreative Effizienz erheblich verbessert. - Entwickler und Forscher

Entwickler, die Code schreiben oder technische Probleme lösen, können mehreren Modellen Fragen stellen, um die Codebeispiele, Lösungen oder Fehlerbehebungsvorschläge zu vergleichen, die sie liefern. Forscher wiederum können dieses Tool nutzen, um die Tiefe des Wissens und die Argumentationsfähigkeit verschiedener Modelle in bestimmten Fachbereichen zu vergleichen, um ihre Forschung zu unterstützen. - Studenten und Pädagogen

Studierende, die komplexe Konzepte erlernen oder Arbeiten schreiben, können dieses Tool nutzen, um ihr Verständnis zu vertiefen, indem sie verschiedene Interpretationen und Perspektiven von mehreren KI-"Tutoren" erhalten. Sie können das Modell bitten, ein wissenschaftliches Prinzip zu erklären, einen Kontext für ein historisches Ereignis zu liefern oder eine Gliederung für einen Aufsatz zu entwerfen, und die Ergebnisse vergleichen, um ein umfassenderes Bild zu erhalten. - Neugierige Erkundung für den Durchschnittsnutzer

Für jeden an KI-Technologie interessierten Nutzer bietet dieses Tool eine hervorragende Spielwiese. Die Benutzer können beliebig viele Fragen stellen, die vom Alltag ("Hilf mir, einen Wochenendausflug zu planen") bis zu fantasievollen Themen ("Schreib eine kurze Geschichte über ein Weltraumabenteuer") reichen, um die verschiedenen KI-Modelle zu visualisieren. vom Alltag ("Helfen Sie mir, einen Wochenendausflug zu planen") bis hin zu fantasievollen Themen ("Schreiben Sie eine Kurzgeschichte über ein Weltraumabenteuer"), die "Persönlichkeiten" und Fähigkeitsunterschiede der verschiedenen KI-Modelle intuitiv zu spüren und ihre Neugier zu befriedigen.

QA

- Ist dieses Programm kostenlos?

Das Projekt selbst ist quelloffen und kostenlos, und es steht Ihnen frei, es herunterzuladen und einzusetzen. Die Nutzung erfordert jedoch den Aufruf von KI-Modelldiensten von Drittanbietern (wie OpenRouter oder Google Gemini), die unter Umständen eine Gebühr erheben. Die OpenRouter-Plattform bietet jedoch auch viele Modelle an, die kostenlos genutzt werden können, wobei die Menge für den täglichen Gebrauch ausreicht. - Ist mein API-Schlüssel sicher?

Wenn Sie lokal bereitstellen, wird Ihr API-Schlüssel nur auf Ihrem eigenen Computer gespeichert (.env.localDatei), ist sicher. Wenn Sie den Schlüssel in den Einstellungen der Webversion eingeben, wird der Schlüssel ebenfalls nur in Ihrem Browser gespeichert und nicht auf den Server hochgeladen. - Warum sind einige der Antworten der Modelle von geringer Qualität?

Open-Fiesta ist nur ein Schnittstellenwerkzeug zum Aufrufen verschiedener Modelle, und die Qualität der Antwort hängt ganz von den Fähigkeiten des von Ihnen gewählten KI-Modells selbst ab. Verschiedene Modelle haben ihre eigenen Stärken, Schwächen und Fachgebiete, und Sie können einige weitere Modelle ausprobieren, um dasjenige zu finden, das Ihren Bedürfnissen am besten entspricht. - Ist es möglich, weitere Modelle hinzuzufügen?

können. Wenn Sie ein Entwickler sind, können Sie dielib/um alle neuen Modelle, die von der OpenRouter-Plattform unterstützt werden, in das bestehende Format einzufügen.