Das Kundenverhalten von Großnutzern zu verstehen, ist eine zentrale Herausforderung für moderne Finanzinstitute. Wenn Milliarden von Transaktionen von Millionen von Nutzern generiert werden, hängt die Fähigkeit, diese Daten zu interpretieren, direkt mit dem Erfolg oder Misserfolg von Produktempfehlungen, Betrugserkennung, Risikobewertung und Nutzererfahrung zusammen.

In der Vergangenheit hat sich die Finanzbranche auf traditionelle Methoden des maschinellen Lernens verlassen, die auf tabellarischen Daten basieren. Bei diesem Modell wurden Transaktionsrohdaten manuell in strukturierte "Merkmale" umgewandelt, z. B. Einkommenshöhe, Ausgabenkategorien oder Anzahl der Transaktionen, und diese Merkmale dann in Vorhersagemodelle eingespeist. Dieser Ansatz ist zwar effektiv, hat aber zwei fatale Schwächen: Erstens ist die manuelle Erstellung von Merkmalen zeitaufwändig und anfällig und hängt in hohem Maße von der Erfahrung der Fachleute ab; zweitens ist er nicht sehr vielseitig, da Merkmale, die für die Kreditrisikokontrolle entwickelt wurden, nur schwer für die Betrugserkennung verwendet werden können, was zu Doppelarbeit in verschiedenen Teams führt.

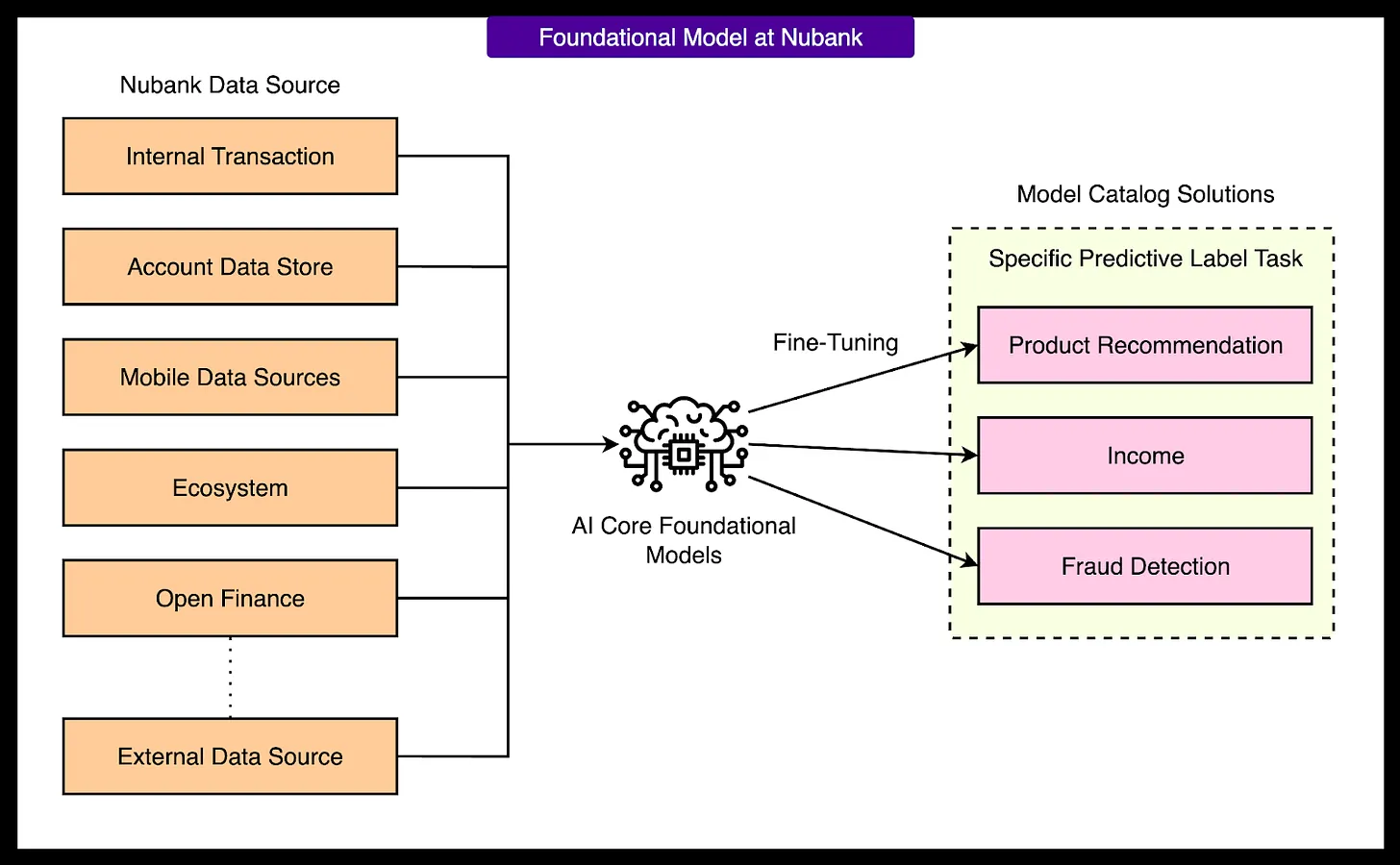

Um diese Beschränkungen zu durchbrechen.Nubank Wir wenden uns einer Technik zu, die die Bereiche der Verarbeitung natürlicher Sprache und der Computer Vision verändert: Foundation Models. Anstatt sich auf künstliche Merkmale zu stützen, lernen Foundation Models durch selbstüberwachtes Lernen automatisch generische "Einbettungen" direkt aus riesigen Mengen von Transaktionsrohdaten. Diese Einbettungen erfassen tiefgreifende Muster des Nutzerverhaltens auf kompakte und aussagekräftige Weise.

Nubank Ziel ist es, Billionen von Transaktionen zu verarbeiten und eine gemeinsame Benutzerdarstellung zu extrahieren, die eine Vielzahl von nachgelagerten Aufgaben wie Kreditmodellierung, personalisierte Empfehlungen, Erkennung von Anomalien und mehr unterstützen kann. Auf diese Weise hofft man, die Modellierungsstandards zu vereinheitlichen, die wiederholte Entwicklung von Merkmalen zu reduzieren und die Vorhersageleistung insgesamt zu verbessern.

Dieser Artikel befasst sich mit den Nubank Die für die Erstellung und den Einsatz dieser Basismodelle verwendete Technologie umfasst den gesamten Lebenszyklus von der Datendarstellung und der Modellarchitektur bis hin zum Pre-Training, der Feinabstimmung und der Integration mit herkömmlichen Tabellensystemen.

Die allgemeine Systemarchitektur von Nubank

Nubank Das Basismodellsystem wurde entwickelt, um generische Benutzerrepräsentationen aus massiven Finanzdaten zu extrahieren. Diese Repräsentationen, die als "Einbettungen" bezeichnet werden, werden später in Geschäftsszenarien wie Kreditwürdigkeitsprüfung, Produktempfehlung und Betrugserkennung weit verbreitet sein. Die gesamte Architektur basiert auf Transformer Das Modell ist auf mehrere Schlüsselphasen ausgerichtet.

1 - Aufnahme von Transaktionsdaten

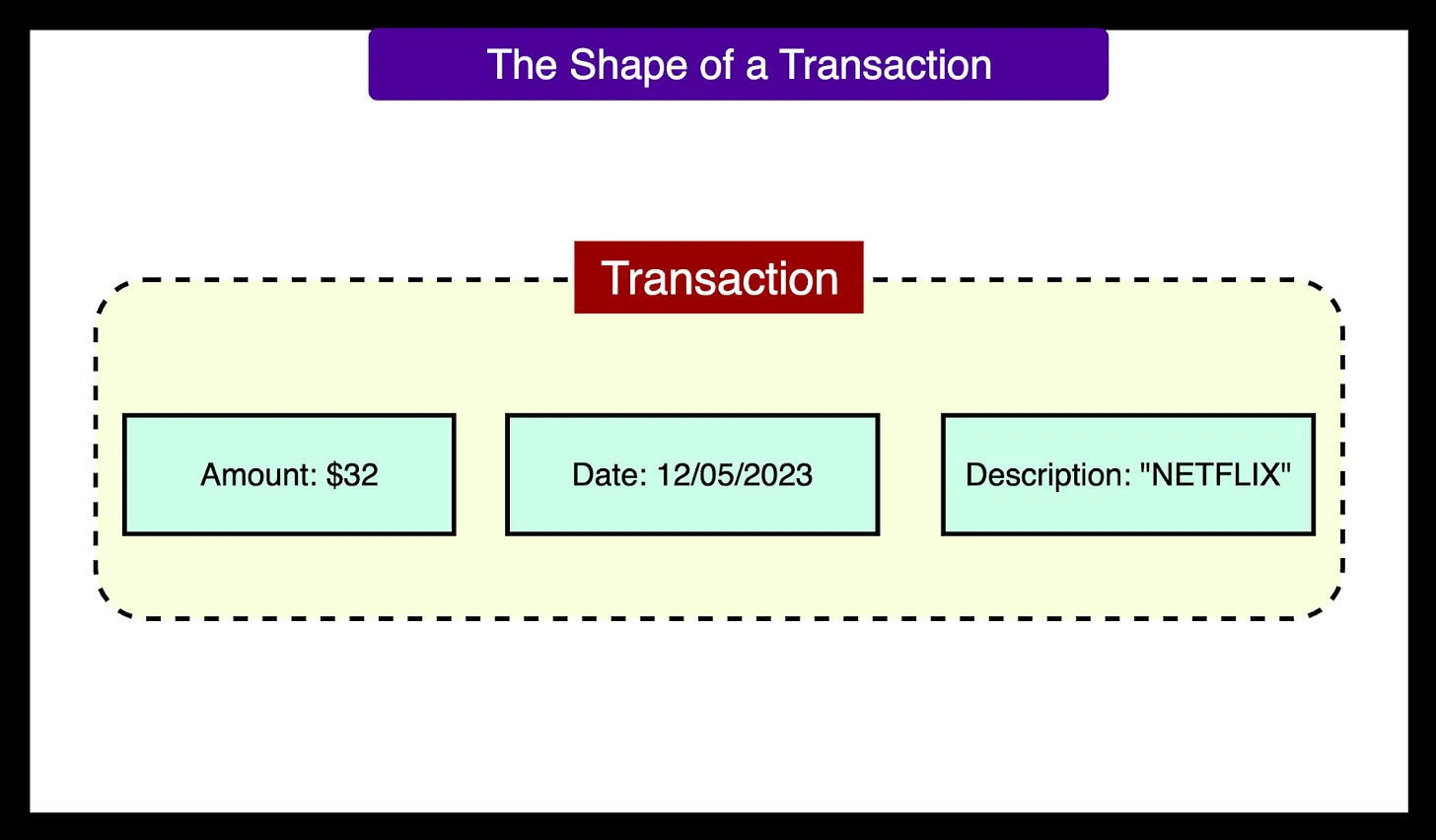

Ausgangspunkt für das System ist die Sammlung von Transaktionsrohdaten für jeden Kunden, einschließlich Informationen wie Transaktionsbeträge, Zeitstempel und Händlerbeschreibungen. Die Datenmenge ist enorm und umfasst Billionen von Transaktionen von über 100 Millionen Nutzern. Jeder Nutzer hat eine chronologische Abfolge von Transaktionen, die für das Modell entscheidend ist, um die Entwicklung des Konsumverhaltens des Nutzers zu verstehen.

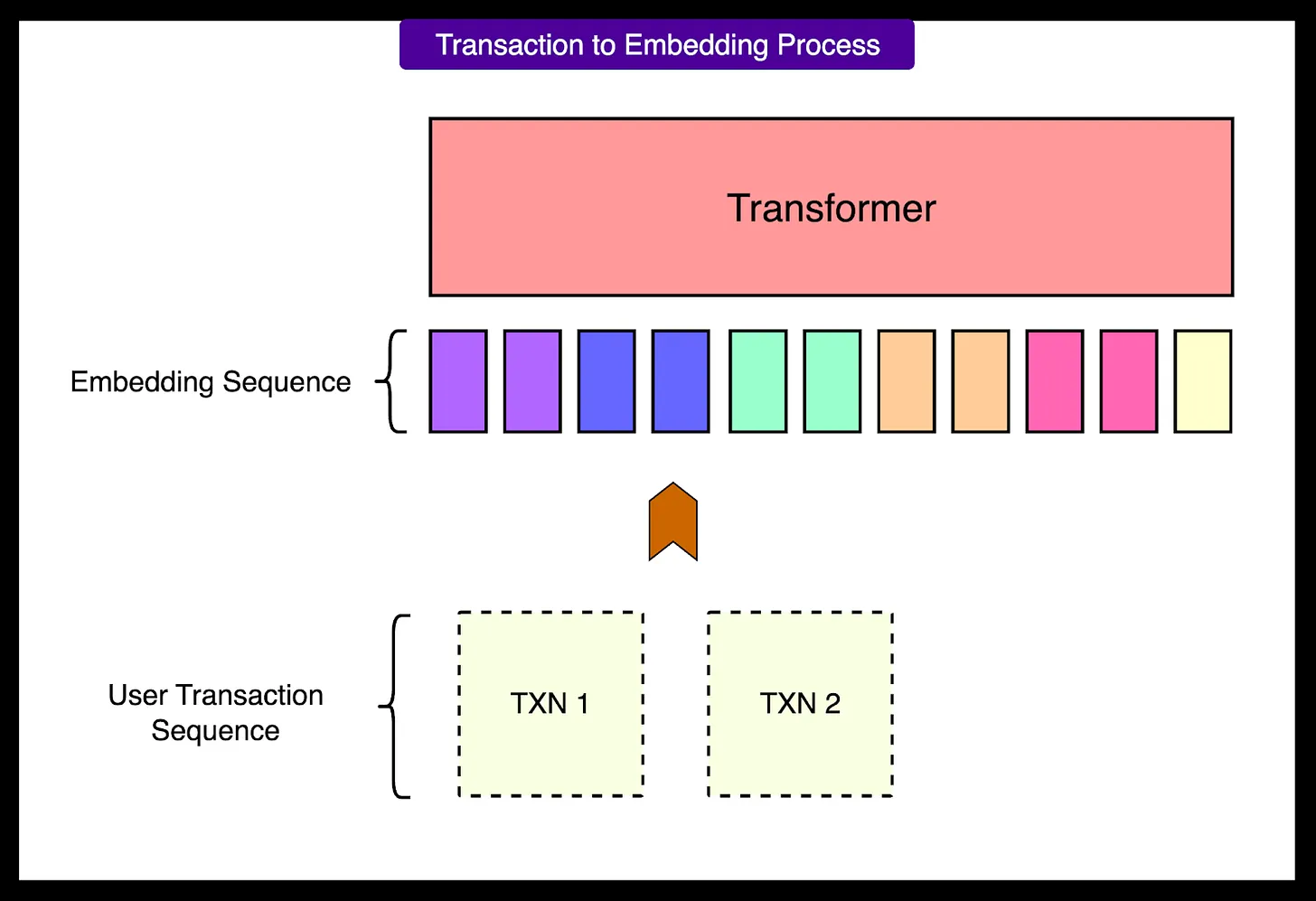

2 - Eingebettete Schnittstelle

Die rohen Transaktionsdaten müssen konvertiert werden in Transformer Ein Format, das das Modell versteht.Nubank Es wird eine hybride Kodierungsstrategie verwendet, bei der jede Transaktion als strukturierte Folge von Token behandelt wird (Token).

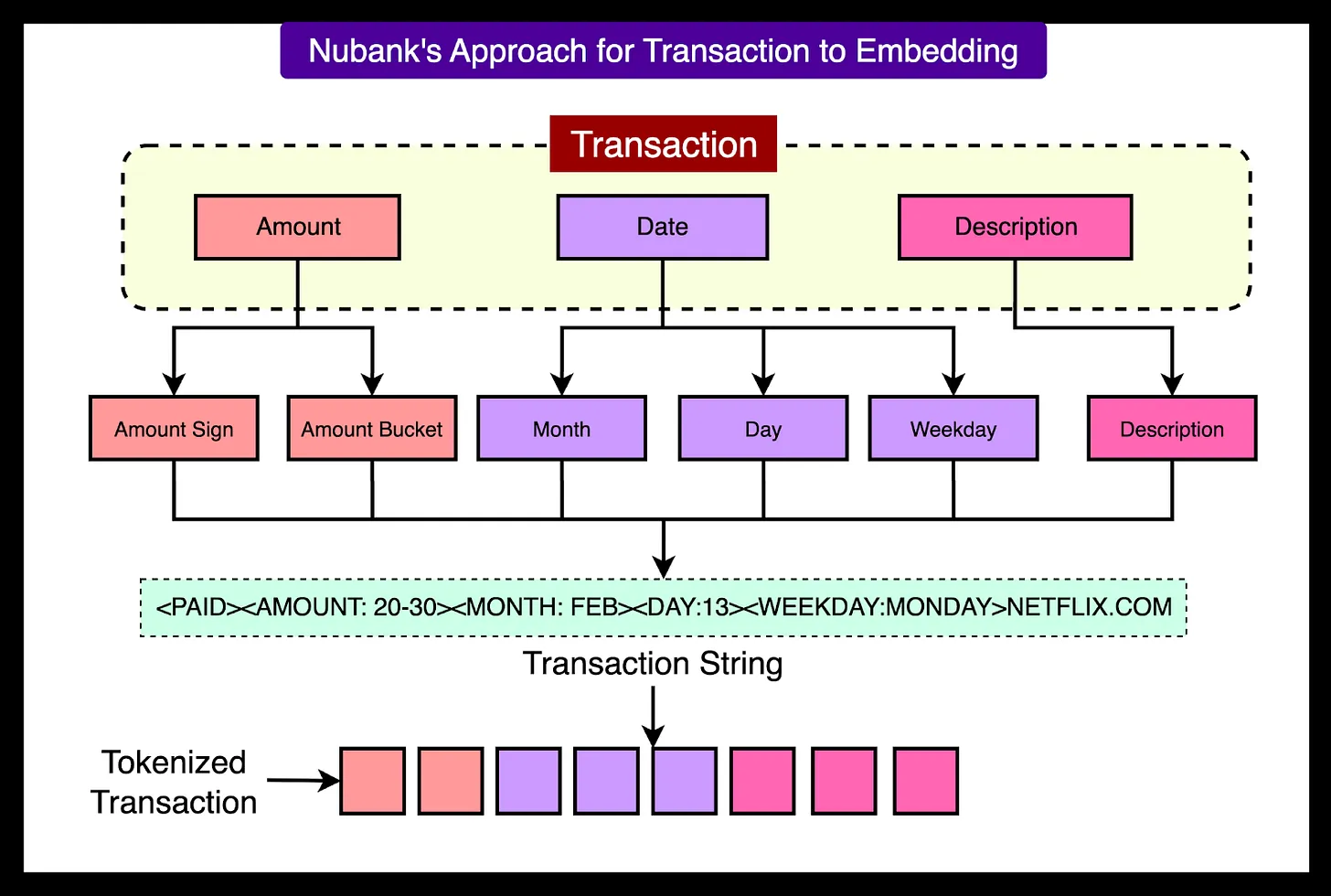

Jede Transaktion ist in mehrere Schlüsselelemente unterteilt:

- DollarzeichenKlassifizierungstoken: Ein Klassifizierungstoken wird verwendet, um anzuzeigen, ob eine Transaktion positiv (z. B. Einzahlung) oder negativ (z. B. Verbrauch) ist.

- GeldausgabeautomatTransaktionsbeträge werden quantifiziert und in vordefinierte "Boxen" unterteilt, um die Varianz der Werte zu verringern.

- DatumstokenDatum: Datumsangaben wie Monat, Wochentag und Zahl werden ebenfalls in separate Token umgewandelt.

- Beschreibung des HändlersStandard-Texttrenner verwenden (z.B.

Byte Pair Encoding) zerlegt den Händlernamen in mehrere Teilwort-Token.

Diese tokenisierte Sequenz bewahrt sowohl die Struktur und Semantik der ursprünglichen Daten als auch die Kompaktheit der Eingabesequenz. Dies ist wichtig, weil die Transformer Der Rechenaufwand für den Mechanismus der mittleren Aufmerksamkeit ist proportional zum Quadrat der Eingabelänge.

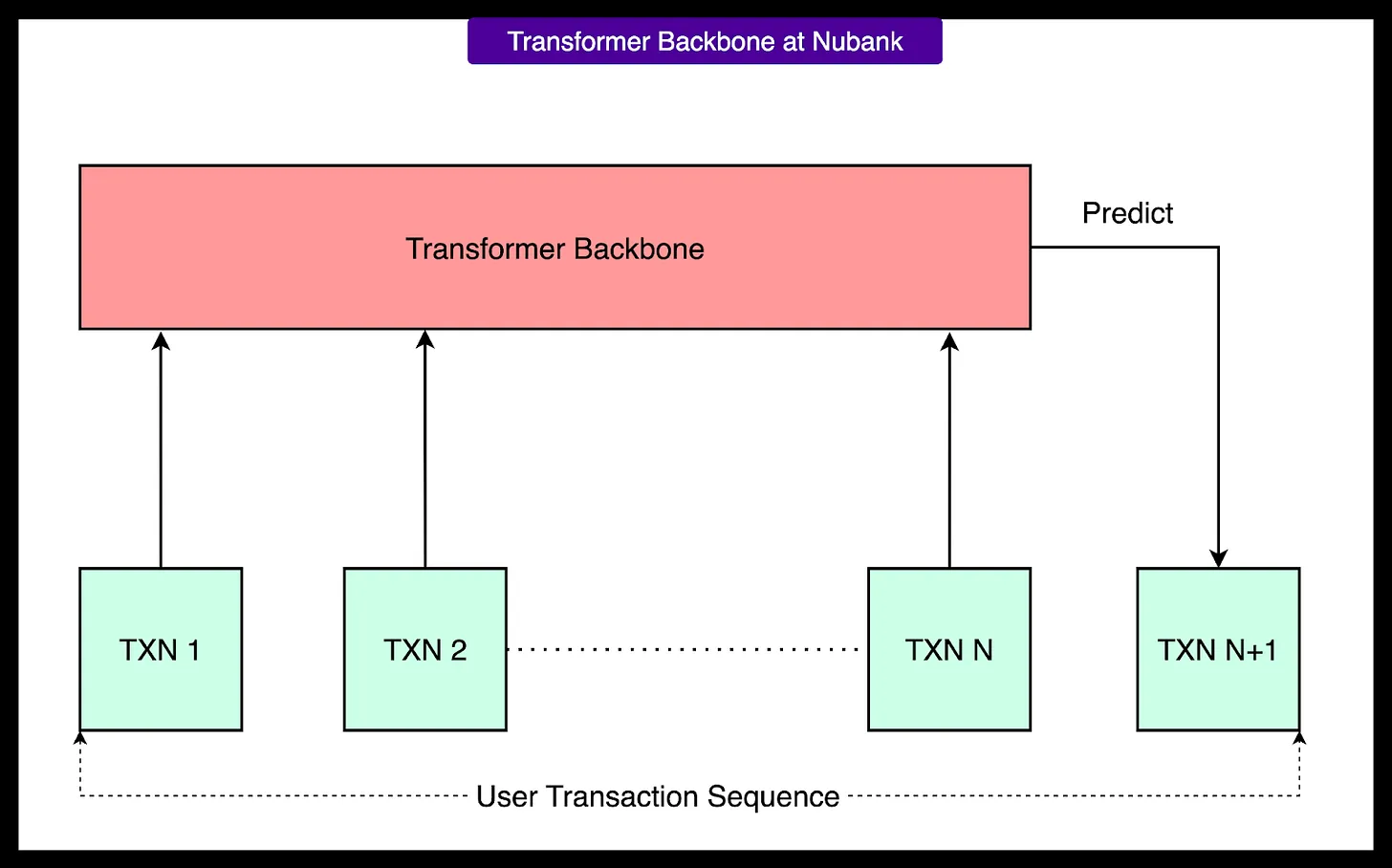

3 - Transformator-Backbone

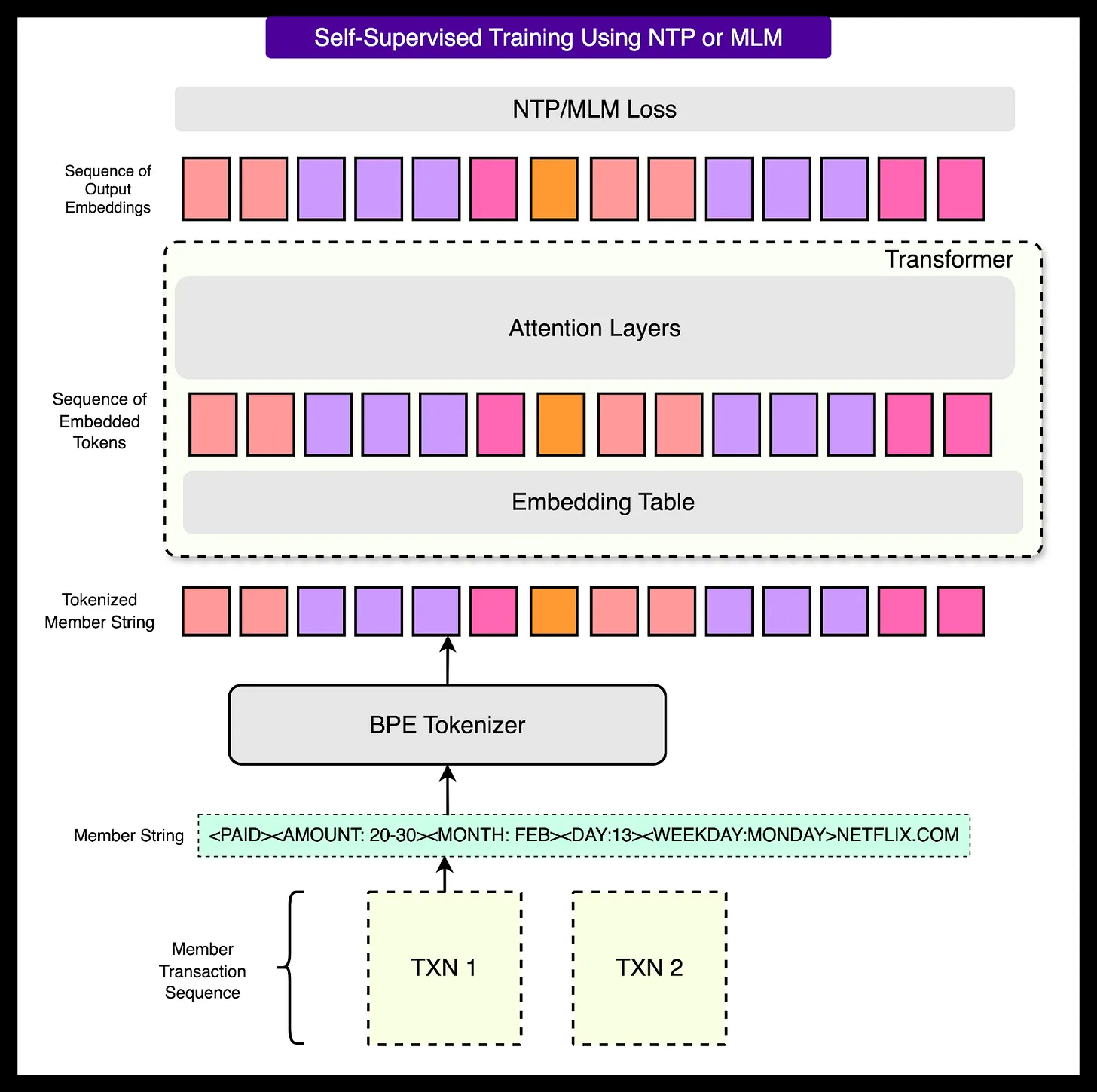

Die tokenisierte Transaktionssequenz wird in die Transformer Modelle.Nubank Versucht eine Vielzahl von Transformer Varianten, um die Leistung zu optimieren. Diese Modelle werden durch selbstüberwachtes Lernen ohne manuell markierte Daten trainiert. Sie befassen sich mit zwei Haupttypen von Aufgaben:

- Maskierte Sprachmodellierung (MLM)Das Verstecken eines Teils der Token in einer Folge von Transaktionen ermöglicht es dem Modell, vorherzusagen, was versteckt wird.

- Nächste Token-Vorhersage (NTP): Lassen Sie das Modell lernen, das nächste Token in der Sequenz vorherzusagen.

Transformer Die Ausgabe des Programms ist eine Benutzereinbettung fester Länge, die in der Regel aus dem verborgenen Zustand des letzten Tokens stammt.

4 - Selbstgesteuertes Training

Das Modell wird auf umfangreichen, nicht gekennzeichneten Transaktionsdaten trainiert. Da keine manuelle Kennzeichnung erforderlich ist, kann das System die gesamte Transaktionshistorie eines jeden Nutzers auswerten. Durch ständige Vorhersage der fehlenden oder zukünftigen Teile der Transaktionssequenz eines Nutzers lernt das Modell selbstständig wertvolle Muster des Finanzverhaltens, wie Konsumzyklen, wiederkehrende Zahlungen und ungewöhnliche Transaktionen. Ein vereinfachtes Beispiel: Das Modell sieht "Kaffee, Mittagessen, dann..." und versucht zu erraten, dass als nächstes "Abendessen" ansteht.

Die Größe der Trainingsdaten und der Modellparameter ist entscheidend. Mit zunehmender Größe des Modells und des Kontextfensters verbessert sich die Leistung erheblich. Wenn man beispielsweise von einem MLM-Basismodell zu einem großen kausalen Modell mit einer optimierten Aufmerksamkeitsschicht wechselt Transformer Modell verbessert sich die Leistung bei der nachgelagerten Aufgabe um mehr als 7 Prozentpunkte.

5 - Nachgelagerte Feinabstimmung und Integration

Sobald das Pre-Training des Basismodells abgeschlossen ist, kann es für bestimmte Aufgaben feinabgestimmt werden. Dies geschieht in der Regel in der Transformer Oben wird ein Vorhersagekopf hinzugefügt und anhand von gekennzeichneten Daten trainiert. Bei einer Aufgabe zur Vorhersage von Kreditausfällen würden zum Beispiel bekannte Ausfallkennzeichen zur Feinabstimmung des Modells verwendet werden.

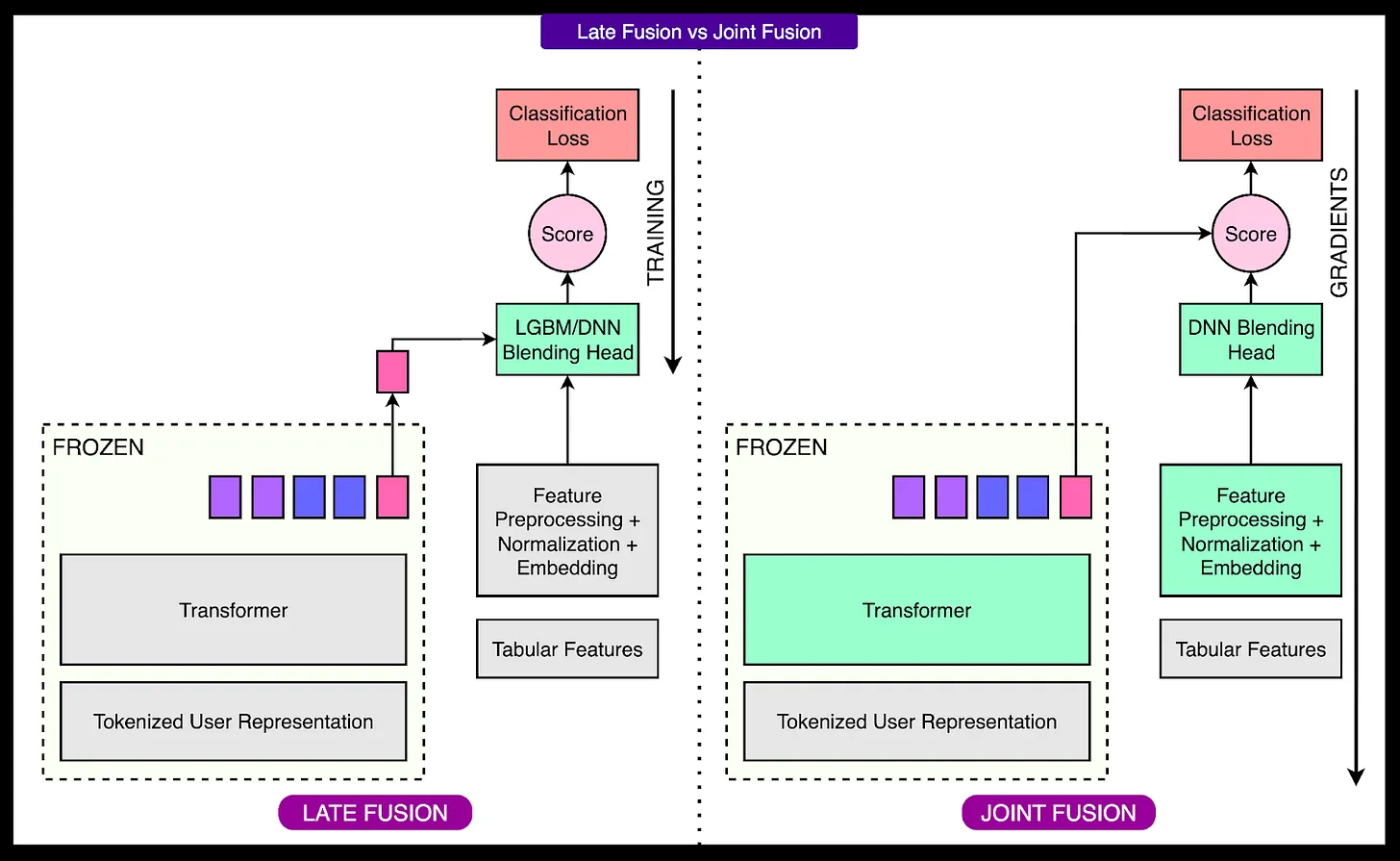

Zur Integration in bestehende Systeme.Nubank Fusion von modellgenerierten Benutzereinbettungen mit manuell erstellten Formularmerkmalen. Diese Verschmelzung wird auf zwei Arten erreicht:

- Späte Fusion: Verwendung

LightGBMund andere Modelle, um eingebettete und tabellarische Daten zu kombinieren, aber die beiden werden getrennt trainiert. - GelenkfusionVerwendung von tiefen neuronalen Netzen (insbesondere

DCNv2Architektur) wirdTransformerund tabellarische Datenmodelle werden gemeinsam in einem End-to-End-System trainiert.

6 - Zentralisierte Modellbibliothek

Um die gesamte Architektur innerhalb des Unternehmens verfügbar zu machenNubank Es wurde eine zentralisierte KI-Plattform geschaffen. Die Plattform speichert vortrainierte Basismodelle und bietet einen standardisierten Feinabstimmungsprozess. Interne Teams können direkt auf diese Modelle zugreifen, ihre eigenen Geschäftsmerkmale einbeziehen und feinabgestimmte Versionen bereitstellen, ohne von Grund auf neu trainieren zu müssen. Diese zentralisierte Verwaltung beschleunigt den Entwicklungsprozess und reduziert die Redundanz von Ressourcen.

Umwandlung von Transaktionsdaten in modelllesbare Sequenzen

为 Transformer Bei der Aufbereitung der Transaktionsdaten durch das Modell gibt es zwei wesentliche Herausforderungen:

- Gemischte DatentypenEine einzelne Transaktion enthält strukturierte Felder (z. B. Betrag und Datum) und Textfelder (z. B. Händlername), die sich nur schwer einheitlich in Klartext oder rein strukturierter Form darstellen lassen.

- Hohe Basis und KaltstartproblemeDie Vielfalt der Transaktionen ist extrem hoch, wobei neue Kombinationen von verschiedenen Händlern, Orten oder Beträgen entstehen. Wenn jeder einzelnen Transaktion eine eigene ID zugewiesen wird, wird das Lexikon ungewöhnlich groß, so dass das Modell schwer zu trainieren und nicht in der Lage ist, neue Transaktionen zu verarbeiten, die während des Trainingszeitraums noch nicht gesehen wurden (d. h. das Problem des Kaltstarts).

Um diese Herausforderungen zu bewältigen.Nubank Es werden verschiedene Strategien zur Umwandlung von Transaktionen in Token-Sequenzen untersucht.

Option 1: ID-basierte Darstellung

Bei diesem Ansatz wird jeder eindeutigen Transaktion eine numerische ID zugewiesen, ähnlich wie in Empfehlungssystemen. Dieser Ansatz ist zwar einfach und effizient, hat aber offensichtliche Nachteile: Die Zahl der eindeutigen Transaktionskombinationen ist zu groß, als dass der ID-Raum handhabbar wäre; gleichzeitig ist das Modell nicht in der Lage, neue Transaktionen zu verarbeiten, die noch nie zuvor gesehen wurden.

Programm II: Text ist alles

Bei dieser Methode wird jede Transaktion als ein Stück Text in natürlicher Sprache behandelt, z. B. "description=NETFLIX amount=32.40 date=2023-05-12". Diese Darstellung ist sehr vielseitig und kann Transaktionen in jedem Format verarbeiten. Allerdings ist sie extrem rechenaufwändig. Bei der Umwandlung strukturierter Felder in lange Textsequenzen entsteht eine große Anzahl unnötiger Token, was zu einer Transformer der Aufmerksamkeit die Kosten für Berechnungen in die Höhe schnellen und die Ausbildung sich verlangsamt.

Option 3: Hybride Kodierung (nach Wahl von Nubank)

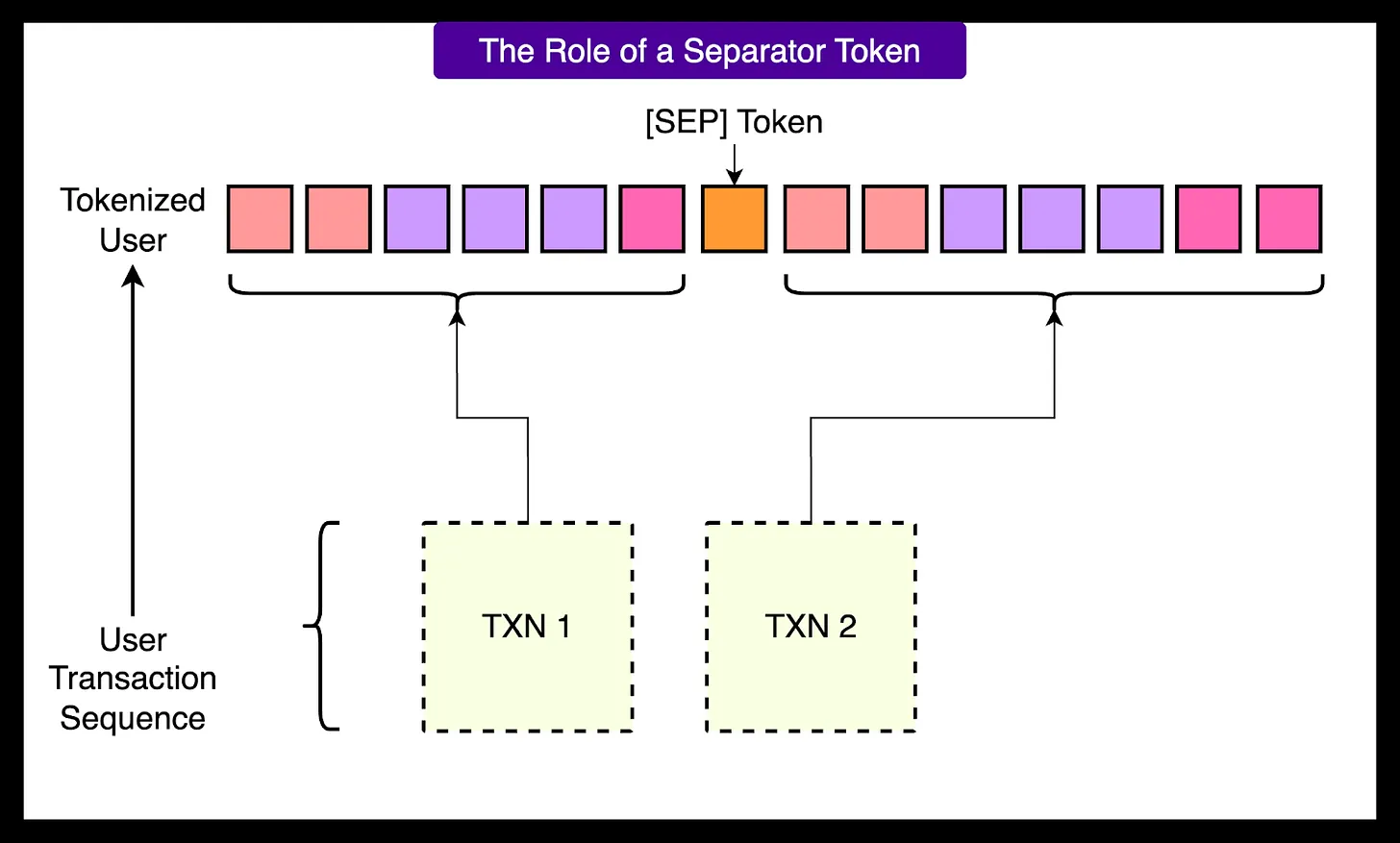

Um ein Gleichgewicht zwischen Vielseitigkeit und Effizienz zu schaffen, wurde dasNubank Es wurde eine hybride Kodierungsstrategie entwickelt. Sie zerlegt jede Transaktion in eine kompakte Menge diskreter Feld-Token, einschließlich des Betragszeichens, des Betragsunterfelds, des Datums und der Händlerbeschreibung nach Unterteilung in Teilwörter.

Dieser hybride Ansatz bewahrt wichtige strukturierte Informationen in einem kompakten Format mit der Fähigkeit zur Verallgemeinerung, um neue Eingaben zu verarbeiten und die Rechenkosten effizient zu kontrollieren. Wenn jede Transaktion auf diese Weise tokenisiert wird, kann der gesamte Transaktionsverlauf eines Nutzers zu einer langen Sequenz zusammengefügt werden, die als Transformer Die Eingabe.

Training des Basismodells

Nubank Das bedeutet, dass das Modell direkt aus der Abfolge der Transaktionen lernt, ohne dass es von Menschen gelabelt wird. Dieser Ansatz ermöglicht es dem System, riesige Mengen an historischen Transaktionsdaten von Millionen von Nutzern zu nutzen.

Es werden hauptsächlich zwei Arten von Ausbildungszielen verwendet:

- Nächste Token-Vorhersage (NTP)Das Modell sagt das nächste Token in der Sequenz auf der Grundlage des vorherigen Tokens voraus. Ähnlich wie ein Sprachmodell, das das nächste Wort in einem Satz vorhersagt, lernt das Modell auf diese Weise, den Fluss und die Struktur des Handelsverhaltens zu verstehen.

- Maskierte Sprachmodellierung (MLM)Verstecken Sie nach dem Zufallsprinzip einige Token in einer Sequenz und trainieren Sie das Modell, die "verdeckten" Token zu erraten. Dadurch ist das Modell gezwungen, den Kontext zu verstehen und tiefere Beziehungen zwischen den Token zu lernen, z. B. die Verbindung zwischen dem Wochentag und der Art des Kaufs oder dem Händlernamen und dem Transaktionsbetrag.

Verschmelzung der Sequenzeinbettung mit tabellarischen Daten

Während die zugrundeliegenden Modelle, die auf Transaktionssequenzen basieren, komplexe Verhaltensmuster erfassen können, stützen sich viele Finanzsysteme nach wie vor auf strukturierte Tabellendaten, wie z. B. Informationen aus Kreditbüros oder Nutzerprofile. Um diese beiden Datenquellen in vollem Umfang nutzen zu können, müssen sie effektiv fusioniert werden.

Post-Fusion (Basislinienmethode)

Bei der Post-Fusion werden die "eingefrorenen" Einbettungen, die durch das vortrainierte Basismodell erzeugt wurden, mit den Formmerkmalen kombiniert und dann in das LightGBM 或 XGBoost unter anderen traditionellen Modellen des maschinellen Lernens. Dieser Ansatz ist einfach zu implementieren, aber da die zugrundeliegenden Modelle unabhängig voneinander trainiert werden, können ihre generierten Einbettungen während des Trainings nicht sinnvoll mit den Tabellendaten interagieren, was die Obergrenze der Gesamtleistung begrenzt.

Gelenkverschmelzung (empfohlene Methode)

Um diese Einschränkung zu überwinden, wird dieNubank Es wurde eine gemeinsame Fusionsarchitektur entwickelt. Der Ansatz trainiert gleichzeitig in einem End-to-End-System Transformer und Modelle, die tabellarische Daten verarbeiten. Auf diese Weise lernt das Modell, Informationen aus Transaktionssequenzen zu extrahieren, die die tabellarischen Daten ergänzen können, und die beiden Komponenten werden gemeinsam für dasselbe Prognoseziel optimiert.

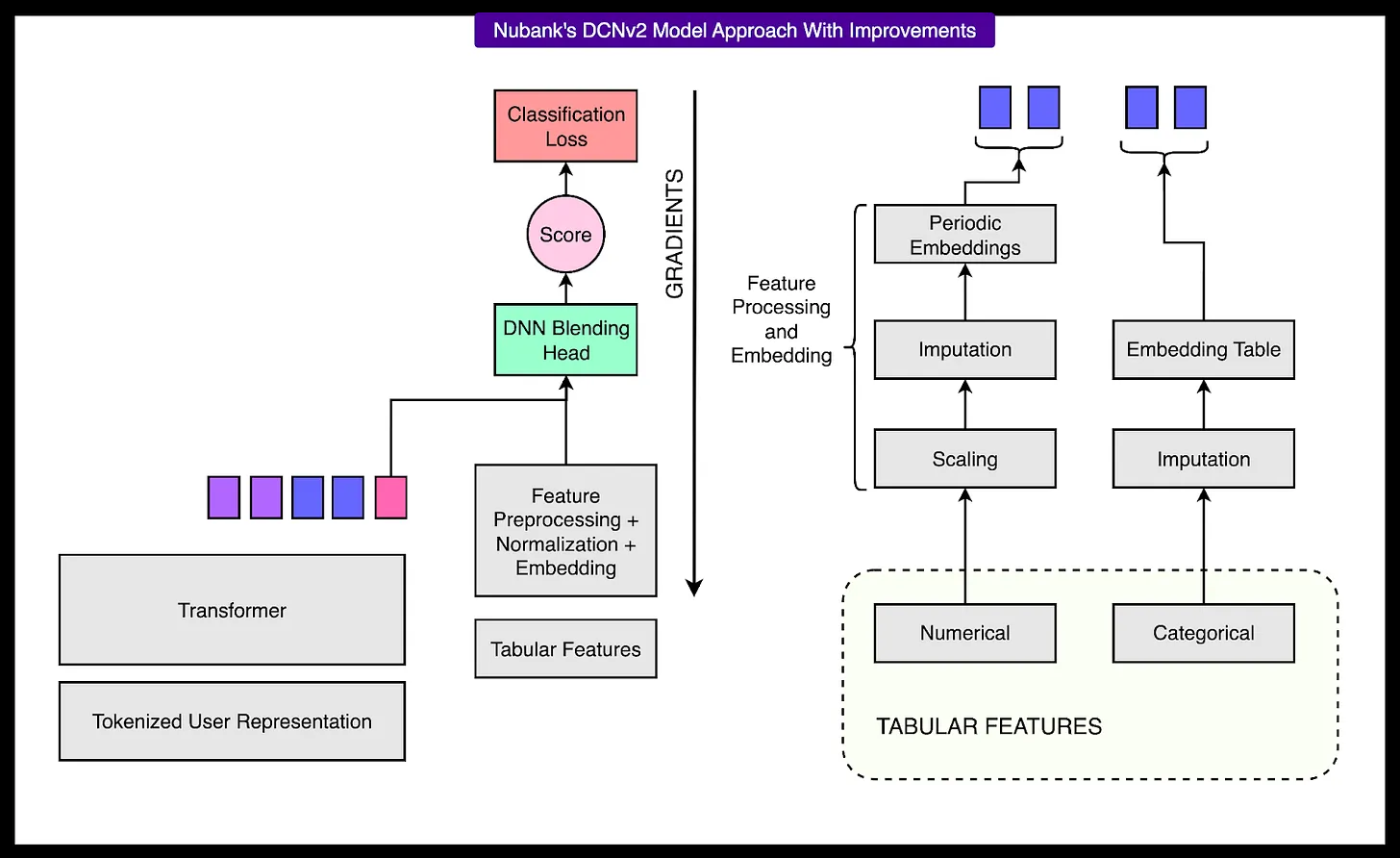

Nubank Option DCNv2 (Deep & Cross Network v2) Architektur zur Verarbeitung von Tabellenmerkmalen.DCNv2 ist ein tiefes neuronales Netz, das speziell für strukturierte Eingaben entwickelt wurde und Kreuzinteraktionen zwischen Merkmalen effizient erfasst.

Nubank Das Bestreben, fundamentale Modelle zu nutzen, stellt einen großen Fortschritt in der Art und Weise dar, wie Finanzinstitute ihre Kunden verstehen und bedienen. Durch die Abkehr vom manuellen Feature-Engineering und die Umstellung auf selbstüberwachtes Lernen auf der Grundlage von Transaktionsrohdaten kann dieNubank Es wird ein Modellierungssystem entwickelt, das sowohl erweiterbar als auch ausdrucksstark ist.

Entscheidend für diesen Erfolg wird sein, wie sich das System in die breitere KI-Infrastruktur einfügt.Nubank Anstatt isolierte Modelle für jedes Szenario zu erstellen, wurde eine zentralisierte KI-Plattform entwickelt. Die Teams können je nach Bedarf zwischen zwei Modellen wählen: einem Modell, das nur Einbettungen von Transaktionssequenzen verwendet, und einem Hybridmodell, das Einbettungen mit strukturierten Formularmerkmalen unter Verwendung einer föderierten Fusionsarchitektur kombiniert.

Diese Flexibilität ist entscheidend. Einige Teams können die Benutzereinbettung in ihr bestehendes robustes Formularmodell einbauen, während andere sich ausschließlich auf neue Aufgaben auf der Grundlage der Transformer des Sequenzmodells. Die Architektur ist auch mit neuen zukünftigen Datenquellen wie Anwendungsnutzungsmustern oder Chats im Kundensupport kompatibel. Es handelt sich nicht nur um ein technisches Proof-of-Concept, sondern um eine produktionsreife Lösung, die messbare Vorteile bei zentralen Aufgaben der Finanzprognose bietet.