Beginnen wir das neue Jahr auf eine spannende Art und Weise!

- Kann von GPT-5 erzeugt werden

Was wäre, wenn ich Ihnen sagen würde, dass das GPT-5 real ist. Es ist nicht nur real, sondern es gestaltet die Welt bereits auf eine Weise, die Sie nicht sehen können. Hier ein hypothetischer Fall: OpenAI hat GPT-5 entwickelt, behält es aber intern, weil der ROI viel höher ist, als es Millionen von Menschen zugänglich zu machen. ChatGPT Benutzer. Darüber hinaus ist der ROI, den sie durch die Kein Geld. Vielmehr geht es um etwas anderes. Wie Sie sehen können, ist die Idee einfach genug; die Herausforderung besteht darin, die Hinweise, die darauf hindeuten, zusammenzufügen. In diesem Artikel geht es darum, warum ich glaube, dass diese Hinweise letztendlich zusammenhängen.

Vorab ein Hinweis: Dies ist reine Spekulation. Die Beweise sind alle öffentlich zugänglich, aber es gibt keine undichten Stellen oder internen Gerüchte, die bestätigen, dass ich richtig liege. Tatsächlich stelle ich diese Theorie in diesem Artikel auf und gebe sie nicht nur weiter. Ich habe keine privilegierten Informationen - und selbst wenn ich welche hätte, bin ich an eine Vertraulichkeitsvereinbarung gebunden. Diese Hypothese ist überzeugend, weil sie logisch . Ehrlich gesagt, was brauche ich noch, um diese Gerüchteküche in Gang zu bringen?

Ob Sie es glauben oder nicht, bleibt Ihnen überlassen. Selbst wenn ich falsch liege - und wir werden die Antwort schließlich erfahren -, ist es ein unterhaltsames Detektivspiel. Ich lade Sie ein, sich an den Spekulationen in den Kommentaren zu beteiligen, aber bitte bleiben Sie dabei konstruktiv und überlegt. Bitte lesen Sie zuerst den gesamten Artikel durch. Ansonsten ist jede Diskussion willkommen.

I. Mysteriöses Verschwinden von Opus 3.5

Bevor wir uns mit GPT-5 beschäftigen, müssen wir seinen ebenfalls fehlenden entfernten Cousin erwähnen: Anthropic's Claude Opus 3.5.

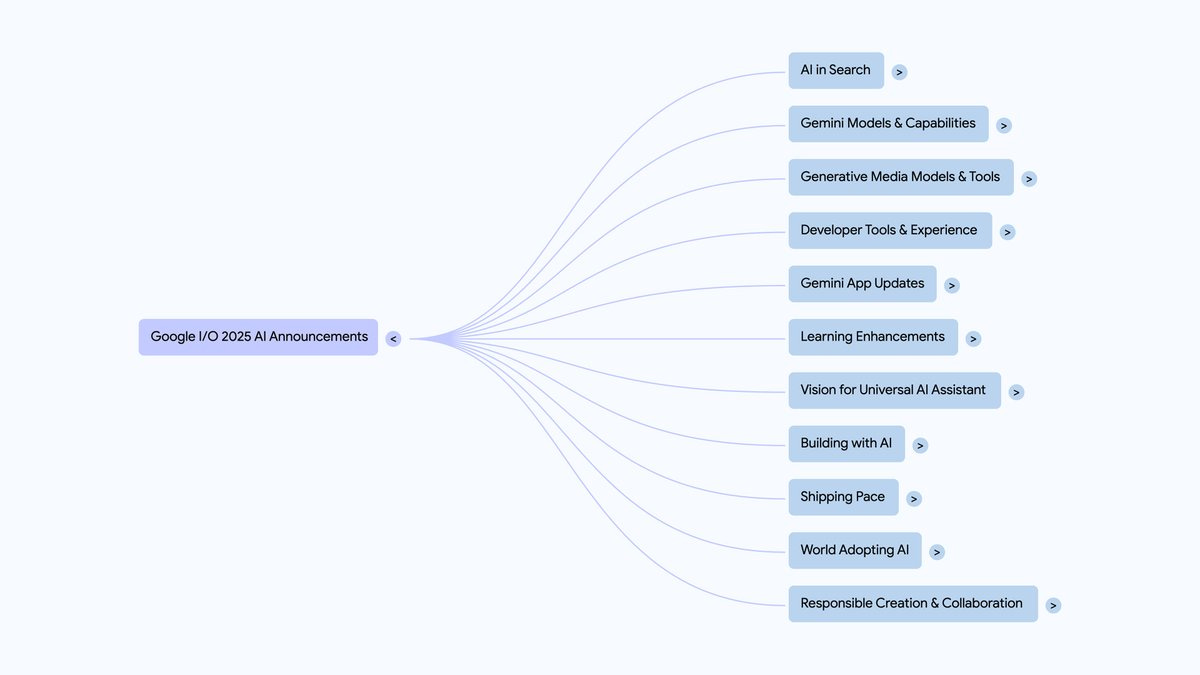

Wie Sie wissen, bieten die drei großen KI-Labore - OpenAI, Google DeepMind und Anthropic - alle Modellportfolios an, die das Spektrum zwischen Preis/Latenz und Leistung abdecken. openAI hat GPT-4o, GPT-4o mini, sowie o1 und o1-mini; Google DeepMind bietet Zwillinge Ultra, Pro und Flash; Anthropic hat Claude Opus, Sonnet und Haiku, und das Ziel ist klar: so viele Kundenprofile wie möglich abzudecken. Einige suchen unabhängig von den Kosten nach Spitzenleistungen, während andere erschwingliche, angemessene Lösungen benötigen. Das alles macht Sinn.

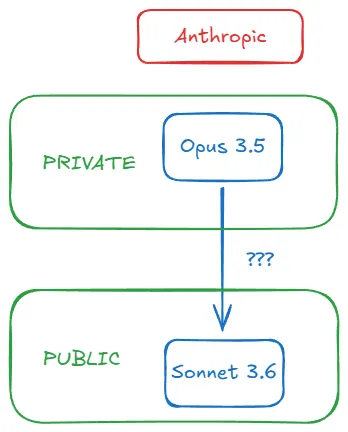

Doch im Oktober 2024 geschah etwas Seltsames. Während alle damit rechneten Anthropisch Als sie Claude Opus 3.5 als Antwort auf GPT-4o (das im Mai 2024 veröffentlicht wurde) herausbrachten, brachten sie am 22. Oktober eine aktualisierte Version von Claude Sonnet 3.5 (die als Sonnet 3.6 bekannt wurde) heraus, die verschwand, so dass Anthropic ohne ein Produkt in direkter Konkurrenz zu GPT-4o dastand. GPT-4o. Seltsam, nicht wahr? Hier ein kurzer Blick auf die Zeitachse von Opus 3.5:

- 10 月 28 日,我在周评文章中写道:”[有] 传闻称 Sonnet 3.6 是…备受期待的 Opus 3.5 训练失败过程中产生的中间检查点。”同日,r/ClaudeAI 子论坛出现帖子:”Claude 3.5 Opus 已被废弃”,链接指向Anthropic 模型页面——至今仍无 Opus 3.5 的踪影。有人推测此举是为在新一轮融资前维持投资者信心。

- 11 月 11 日,Anthropic CEO Dario Amodei 在 Lex Fridman 播客中放弃 Opus 3.5:”虽然不能给出确切日期,但我们仍计划推出 Claude 3.5 Opus。” 措辞谨慎暧昧,但确有效力。

- 11 月 13 日,彭博社证实早期传闻:”训练完成后,Anthropic 发现 3.5 Opus 在评估中优于旧版,但考虑到模型规模和构建运行成本,提升幅度未达预期。” Dario 未给出日期,似乎是因为尽管 Opus 3.5 训练未失败,但成果不尽如人意。注意重点是 Verhältnis zwischen Kosten und Leistung Nicht nur Leistung.

- 12 月 11 日,半导体专家 Dylan Patel 及其 Semianalysis 团队带来最终转折,提出解释:”Anthropic 完成 Claude 3.5 Opus 训练且表现良好…但未发布。因为他们转而 Generierung von Synthesedaten mit Claude 3.5 Opus ,通过奖励建模显著提升 Claude 3.5 Sonnet。”

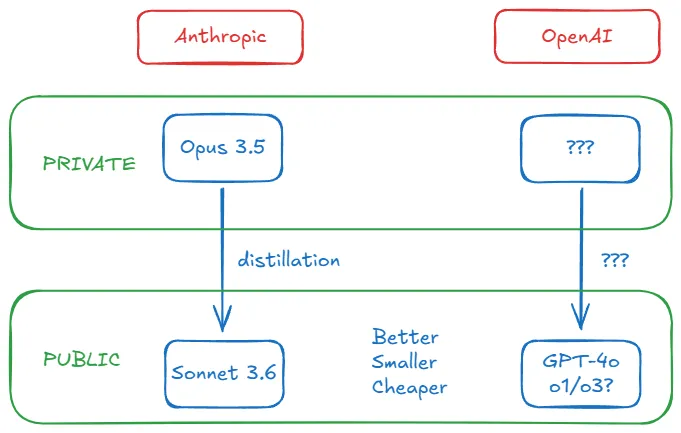

Kurz gesagt, Anthropic hat Claude Opus 3.5 trainiert und den Namen fallen gelassen, weil die Ergebnisse nicht gut genug waren. dario glaubt, dass die Ergebnisse mit einem anderen Trainingsprozess hätten verbessert werden können, und vermeidet das Datum. Bloomberg bestätigt, dass es die bestehenden Modelle übertrifft, dass aber die Kosten für die Inferenz (die Kosten für den Benutzer, der das Modell verwendet) unerschwinglich sind, und Dylans Team enthüllt die Verbindung zwischen Sonnet 3.6 und dem fehlenden Opus 3.5: Letzteres wurde verwendet, um intern synthetische Daten zu erzeugen, um die Leistung des ersteren zu verbessern.

Der gesamte Prozess kann wie folgt dargestellt werden:

II. besser, kleiner und billiger?

Der Prozess der Verwendung eines starken und teuren Modells zur Generierung von Daten, um ein etwas schwächeres, aber wirtschaftlicheres Modell zu ergänzen, wird als Destillation bezeichnet. Dies ist eine gängige Praxis. Mit dieser Technik können KI-Labors die Grenzen des reinen Vortrainings überwinden und die Leistung kleinerer Modelle steigern.

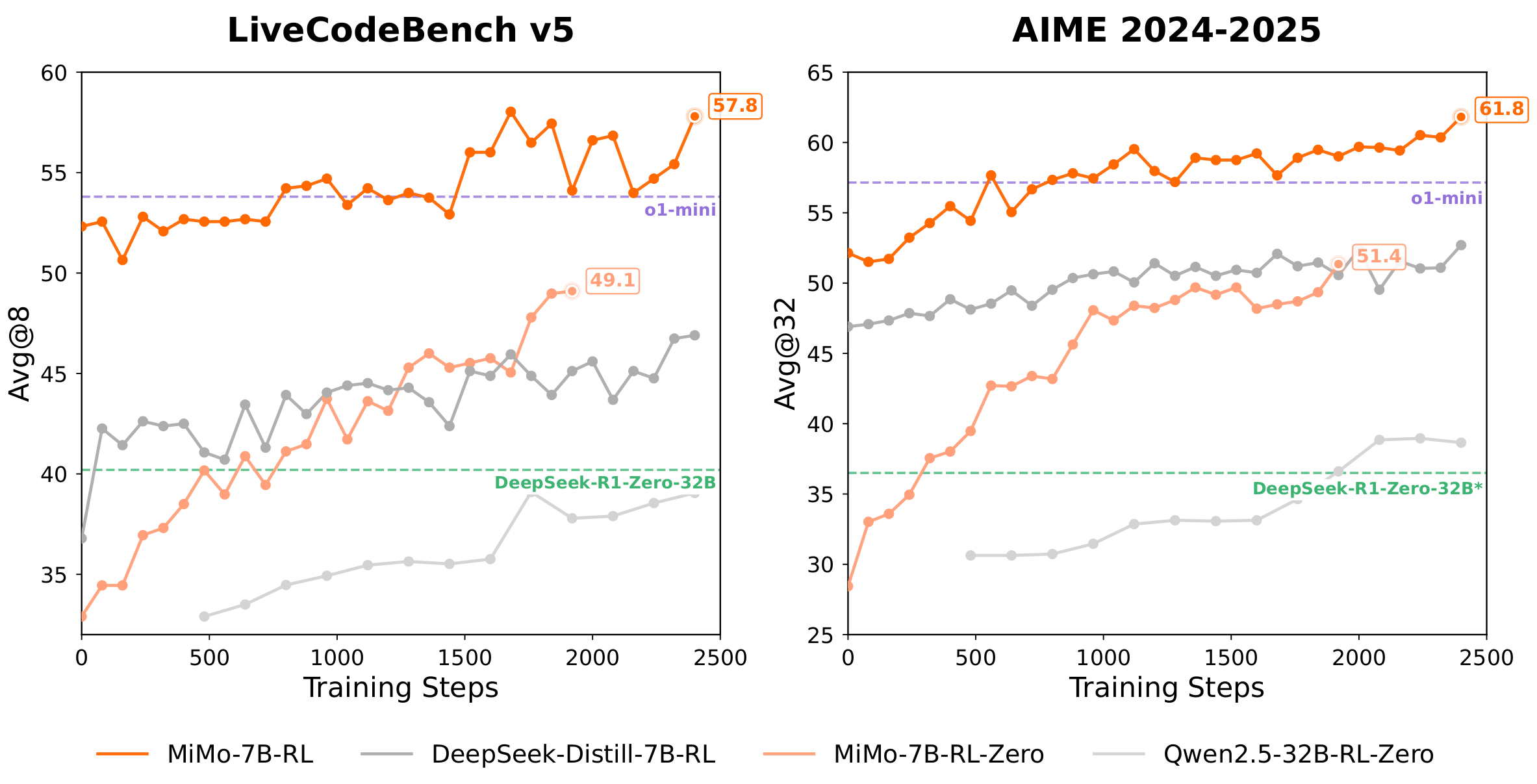

蒸馏有不同方法,但我们不深入探讨。关键要记住:作为”教师”的强模型能将”学生”模型从[小、便宜、快速] + (nach einer Dezimalzahl oder einem Bruch) etwas weniger als umgewandelt in [klein, billig, schnell] + Beeindruckend . Dylan erklärt, warum dies für die Kombination Opus 3.5-Sonnet 3.6 von Anthropic sinnvoll ist:

(Die Inferenzkosten (des neuen Sonnet gegenüber dem alten) haben sich nicht wesentlich geändert, aber die Modellleistung hat sich verbessert. Warum sollte man aus Kostengründen 3.5 Opus herausgeben, wenn man 3.5 Sonnet durch Post-Training mit 3.5 Opus erhalten kann?

Zurück zur Kostenfrage: Die Destillation kontrolliert die Ausgaben für Schlussfolgerungen und verbessert gleichzeitig die Leistung. Damit wird das von Bloomberg angesprochene Kernproblem direkt angegangen, und Anthropic entschied sich nicht nur wegen der unzureichenden Ergebnisse, sondern auch wegen des höheren internen Wertes, Opus 3.5 nicht zu veröffentlichen. (Dylan weist darauf hin, dass dies der Grund ist, warum die Open-Source-Gemeinschaft schnell zu GPT-4 aufschließt - sie holen sich das Gold direkt von der OpenAI-Goldmine).

Die erstaunlichste Offenbarung: Sonett 3.6 ist nicht nur hervorragend - es erreicht die oberste Ebene . Das Mittelklassemodell von Anthropic übertrifft das Flaggschiff von OpenAI, indem es durch Opus 3.5 destilliert (und wahrscheinlich aus anderen Gründen; fünf Monate sind in der KI lang genug). Plötzlich begann die Vorstellung, dass hohe Kosten gleichbedeutend mit hoher Leistung sind, zu bröckeln.

“越大越好”的时代怎么了?OpenAI CEO Sam Altman 警告那个时代已结束。我也撰文讨论。当顶尖实验室开始保密,他们停止分享参数数量。参数规模不再可靠,我们明智地转向关注基准表现。OpenAI 最后公开的参数规模是 2020 年 GPT-3 的 1750 亿。2023 年 6 月传闻称 GPT-4 是约1.8 万亿参数的混合专家模型。Semianalysis 后续详细评估确认 GPT-4 有 1.76 万亿参数,当时是 2023 年 7 月。

Bis Dezember 2024 - also in anderthalb Jahren - schätzt Ege Erdil, Forscherin bei EpochAI, einer Organisation, die sich mit den zukünftigen Auswirkungen der KI befasst, dass die Parametergrößen der Frontier-Modelle, einschließlich GPT-4o und Sonnet 3.6, deutlich kleiner sind als GPT-4 (obwohl beide Benchmarks GPT-4 übertreffen):

…当前前沿模型如初代 GPT-4o 和 Claude 3.5 Sonnet 可能比 GPT-4 小一个数量级,4o 约 2000 亿参数,3.5 Sonnet 约 4000 亿…尽管估算方式粗糙可能导致误差达两倍。

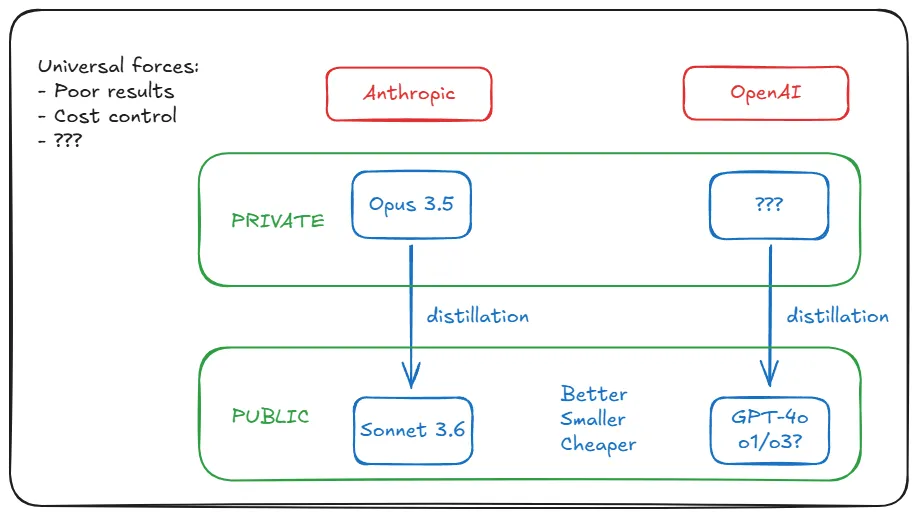

Er erklärt ausführlich, wie er zu dieser Zahl gekommen ist, ohne dass das Labor architektonische Details preisgibt, aber das ist für uns nicht wichtig. Der Punkt ist, dass sich der Nebel lichtet: Anthropic und OpenAI scheinen ähnliche Wege zu gehen. Ihre neuesten Modelle sind nicht nur besser, sondern auch kleiner und billiger als ihre Vorgänger. Wir wissen, dass Anthropic dies durch die Destillation von Opus 3.5 erreicht hat. Aber was hat OpenAI getan?

III. KI-Labore werden durch Universalismus angetrieben

Man könnte meinen, dass die Destillationsstrategie von Anthropic auf eine einzigartige Situation zurückzuführen ist - nämlich auf die schlechten Trainingsergebnisse von Opus 3.5. Aber in Wirklichkeit ist die Situation von Anthropic nicht einzigartig, und die jüngsten Trainingsergebnisse von Google DeepMind und OpenAI sind ebenso unbefriedigend. (Beachten Sie, dass schlechte Ergebnisse nicht dasselbe sind wie Das Modell ist schlimmer. ) Die Gründe sind uns egal: abnehmende Erträge aufgrund unzureichender Daten, inhärente Beschränkungen der Transformer-Architektur, Plateau des Pre-Training-Skalierungsgesetzes usw. In jedem Fall ist der besondere Kontext von Anthropic eigentlich universell.

Aber denken Sie daran, was Bloomberg berichtet: Leistungskennzahlen sind nur so gut wie die Kosten. Ist dies ein weiterer gemeinsamer Faktor? Ja, und Ege erklärt, warum: der Nachfrageschub nach dem ChatGPT/GPT-4-Boom. Die generative KI breitet sich in einem Tempo aus, das es den Labors schwer macht, die Verluste einer weiteren Expansion zu tragen. Daher waren sie gezwungen, die Kosten für die Inferenz zu senken (das Training ist nur einmalig, die Kosten für die Inferenz wachsen mit dem Nutzervolumen und der Nutzung). Wenn 300 Millionen Nutzer das Produkt jede Woche verwenden, könnten die Betriebskosten plötzlich fatal sein.

Die Faktoren, die Anthropic dazu veranlassten, Sonnet 3.6 mit Destillation zu verbessern, wirken sich mit exponentieller Intensität auf OpenAI aus. Destillation ist effektiv, weil sie diese beiden allgegenwärtigen Herausforderungen in Stärken umwandelt: Lösung des Problems der Inferenzkosten durch die Bereitstellung kleiner Modelle, während gleichzeitig keine großen Modelle veröffentlicht werden, um öffentliche Reaktionen auf mittelmäßige Leistungen zu vermeiden.

Ege 认为 OpenAI 可能选择替代方案:过度训练(overtraining)。即在非计算最优状态下用小模型训练更多数据:”当推理成为模型支出的主要部分时,最好…用小模型训练更多 token。”但过度训练已不可行。AI 实验室已耗尽高质量预训练数据。Elon Musk 和 Ilya Sutskever 最近都承认这点。

回到蒸馏。Ege 总结:”我认为 GPT-4o 和 Claude 3.5 Sonnet 很可能都经大模型蒸馏而来。”

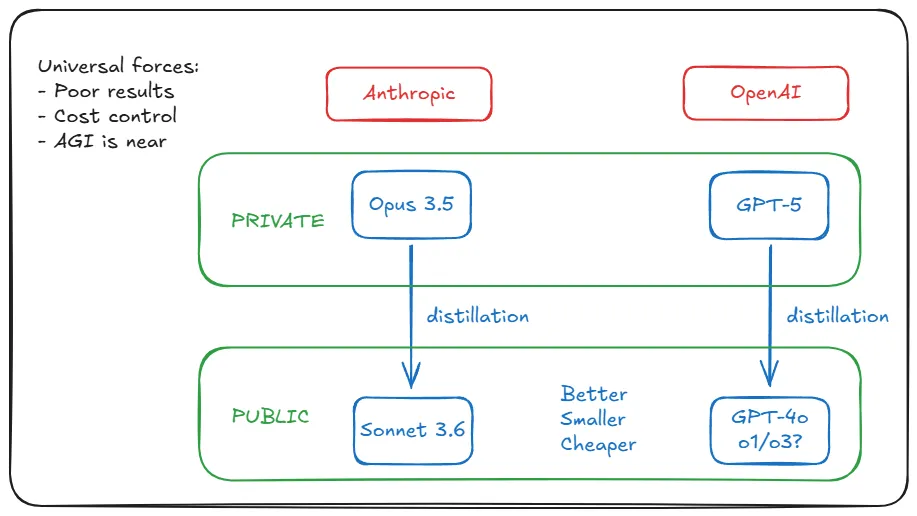

Alle bisherigen Hinweise deuten darauf hin, dass OpenAI das Gleiche tut wie Anthropic mit Opus 3.5 (train and hide), und zwar auf dieselbe Weise (Destillation) und aus denselben Gründen (schlechte Ergebnisse/Kostenkontrolle). Dies ist eine Entdeckung. Aber hier ist die Sache: Opus 3.5 dennoch 被隐藏。OpenAI 的对应模型在哪?是否藏在公司地下室?敢猜它的名字吗…

IV. Pioniere müssen den Weg frei machen

Ich beginne die Analyse mit einer Untersuchung des Opus 3.5-Ereignisses von Anthropic, das in seinen Informationen transparenter ist. Dann übertrage ich das Konzept der Destillation auf OpenAI und erkläre, dass die gleichen zugrunde liegenden Kräfte, die Anthropic antreiben, auch auf OpenAI wirken, aber unsere Theorie stößt auf ein neues Hindernis: Als Pionier könnte OpenAI auf Hindernisse stoßen, die Anthropic noch nicht kennt.

Zum Beispiel die Hardware-Anforderungen für die Ausbildung GPT-5. Sonnet 3.6 ist vergleichbar mit GPT-4o, aber es wurde fünf Monate später veröffentlicht. Wir sollten davon ausgehen, dass GPT-5 auf einem höheren Niveau ist: leistungsfähiger und größer. Nicht nur die Argumentationskosten, sondern auch die Ausbildungskosten sind höher. Die Ausbildungskosten könnten sich auf eine halbe Milliarde Dollar belaufen. Ist es möglich, dies mit der vorhandenen Hardware zu erreichen?

Ege ist wieder einmal aufgetaucht: Es ist möglich. Es ist nicht realistisch, 300 Millionen Nutzern ein solches Ungetüm anzubieten, aber die Ausbildung ist kein Problem:

Im Prinzip reicht die vorhandene Hardware aus, um Modelle zu unterstützen, die viel größer sind als GPT-4: z. B. ein Modell mit 100 Billionen Parametern, das 50 Mal größer ist als GPT-4, mit Inferenzkosten von etwa $3000/Million Output-Token und einer Output-Rate von 10-20 Token/Sekunde. Damit dies jedoch machbar ist, müssen große Modelle einen erheblichen wirtschaftlichen Wert für die Kunden schaffen.

但即使微软、谷歌或亚马逊(分别是 OpenAI、DeepMind 和 Anthropic 的金主)也无法承受这种推理开支。解决方法很简单:若计划向公众提供数万亿参数模型,必须”创造巨大经济价值”。所以他们不这样做。

他们训练模型。发现”比现有产品表现更好”。但必须接受”其进步程度不足以证明维持运行的巨额成本”。(这措辞耳熟吗?《华尔街日报》一个月前报道 GPT-5 时用词与彭博对 Opus 3.5 的报道惊人相似。)

Sie berichten über mittelmäßige Ergebnisse (mit der Flexibilität, den Bericht anzupassen). Behalten Sie sie intern als Lehrermodelle, um Schülermodelle zu destillieren. Dann geben Sie letztere frei. Wir bekommen Sonnet 3.6 und GPT-4o, o1, etc. und freuen uns über ihre billige Qualität. Die Erwartungen an Opus 3.5 und GPT-5 bleiben intakt, auch wenn wir immer ungeduldiger werden. Ihre Goldgrube glänzt weiterhin.

V. Sie haben doch sicher noch mehr Gründe, Herr Altman!

V. Natürlich haben Sie mehr Gründe, Herr Altman!

Als ich in meiner Untersuchung so weit kam, war ich immer noch nicht völlig überzeugt. Es stimmt, dass alle Beweise darauf hindeuten, dass es für OpenAI völlig plausibel ist, aber es gibt immer noch eine Lücke zwischen "plausibel" oder sogar "plausibel" und "real". Ich werde diese Lücke nicht für Sie füllen - es ist schließlich nur eine Spekulation. Aber ich kann das Argument noch verstärken.

Gibt es weitere Beweise dafür, dass OpenAI auf diese Weise vorgeht? Gibt es noch weitere Gründe für die Verzögerung der Veröffentlichung von GPT-5, abgesehen von der schlechten Leistung und den zunehmenden Verlusten, und welche Informationen können wir aus den öffentlichen Erklärungen der OpenAI-Führungskräfte über GPT-5 entnehmen? Riskieren sie nicht einen Imageschaden, wenn sie die Veröffentlichung des Modells immer wieder hinauszögern? Schließlich ist OpenAI das Aushängeschild der KI-Revolution, und Anthropic steht in ihrem Schatten.Anthropic kann es sich leisten, so zu agieren, aber was ist mit OpenAI? Vielleicht nicht ohne einen Preis.

Da wir gerade von Geld sprechen, lassen Sie uns einige relevante Details über die Partnerschaft von OpenAI mit Microsoft herausfinden. Zunächst die bekannte Tatsache: die AGI-Satzung. In OpenAIs Blog-Post über ihre Struktur gibt es fünf Governance-Klauseln, die ihre Arbeitsweise, ihre Beziehung zu gemeinnützigen Organisationen, ihre Beziehung zu ihrem Vorstand und ihre Beziehung zu Microsoft definieren. Die fünfte Klausel definiert AGI als "ein hochgradig autonomes System, das in der Lage ist, den Menschen in den meisten wirtschaftlich wertvollen Unternehmungen zu übertreffen" und legt fest, dass, sobald der OpenAI-Vorstand erklärt, dass AGI implementiert wurde, "das System von der Lizenzierung geistigen Eigentums und anderen kommerziellen Bedingungen mit Microsoft ausgenommen wird, die nur den Bedingungen der Microsoft-Lizenz und anderen kommerziellen Bedingungen unterliegen. Andere kommerzielle Bedingungen mit Microsoft, die nur für die Technologie vor AGI gelten."

Natürlich will keines der beiden Unternehmen, dass die Partnerschaft scheitert. openAI legt die Bedingungen fest, tut aber alles, um sie nicht einhalten zu müssen. Eine Möglichkeit, dies zu tun, ist die Verzögerung der Veröffentlichung von Systemen, die als AGI bezeichnet werden könnten. "Aber GPT-5 ist doch keine AGI", werden Sie sagen. Und hier noch eine zweite Tatsache, die fast niemand kennt: OpenAI und Microsoft haben eine geheime Definition von AGI, die zwar für wissenschaftliche Zwecke irrelevant ist, aber ihre Partnerschaft rechtlich festlegt: Eine AGI ist ein "KI-System, das in der Lage ist, mindestens 100 Milliarden Dollar Gewinn zu erwirtschaften". KI-System.

Wenn OpenAI hypothetisch die Veröffentlichung unter dem Vorwand verzögern würde, dass GPT-5 noch nicht fertig sei, würden sie neben der Kostenkontrolle und der Verhinderung eines öffentlichen Rückschlags noch etwas anderes erreichen: Sie würden vermeiden, bekannt zu geben, ob es die Schwelle zur Einstufung als AGI erreicht oder nicht. 100 Milliarden Dollar sind zwar eine schwindelerregende Zahl, aber nichts hindert ehrgeizige Kunden daran, so viel Gewinn zu machen. Andererseits sollten wir uns darüber im Klaren sein: Wenn OpenAI vorhersagt, dass GPT-5 100 Milliarden Dollar an wiederkehrenden Einnahmen pro Jahr generieren wird, wird es ihnen nichts ausmachen, die AGI-Klausel auszulösen und sich von Microsoft zu trennen.

Die meisten öffentlichen Reaktionen auf die Nichtveröffentlichung von GPT-5 durch OpenAI basierten auf der Annahme, dass sie es nicht veröffentlichen, weil es nicht gut genug sei. Selbst wenn dies zuträfe, würde kein Skeptiker auf den Gedanken kommen, dass OpenAI vielleicht einen besseren internen Anwendungsfall als eine externe Nutzung hat. Es besteht ein großer Unterschied zwischen der Entwicklung eines großartigen Modells und der Entwicklung eines großartigen Modells, das 300 Millionen Menschen kostengünstig bedienen kann. Wenn man das nicht kann, wird man es nicht tun. Aber noch einmal, wenn Sie unnötig Tun Sie es, und Sie werden es nicht tun. Früher haben sie uns ihre besten Modelle zur Verfügung gestellt, weil sie unsere Daten brauchten. Das ist jetzt nicht mehr so notwendig. Und sie sind nicht mehr hinter unserem Geld her. Das ist Microsofts Sache, nicht ihre. Sie wollen AGI, dann ASI. Sie wollen ein Vermächtnis hinterlassen.

VI. warum dies alles ändert

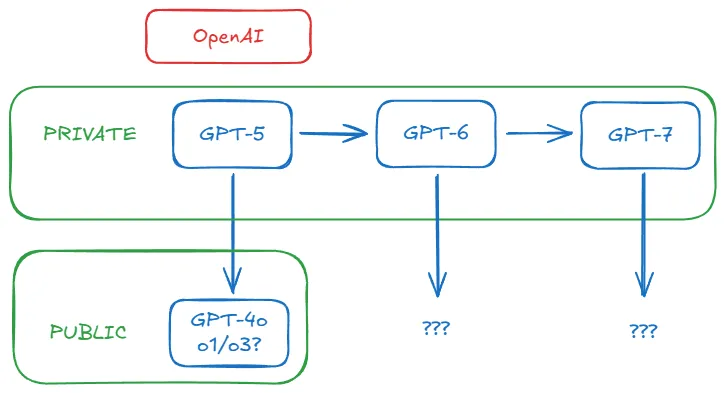

Wir nähern uns dem Ende. Ich glaube, ich habe genug Argumente vorgebracht, um eine solide These aufzustellen: Es ist sehr wahrscheinlich, dass OpenAI bereits GPT-5 im Haus hat, so wie Anthropic Opus 3.5 hat. Es ist sogar möglich, dass OpenAI niemals GPT-5 veröffentlichen wird. Die Öffentlichkeit misst die Leistung jetzt in Form von o1/o3, nicht nur GPT-4o oder Claude Sonnet 3.6. da OpenAI das Gesetz der Skalierung in Tests erforscht, steigt die Latte, die für GPT-5 überschritten werden muss, immer weiter an. Wie können sie ein GPT-5 herausbringen, das wirklich besser ist als o1, o3 und die kommenden Modelle der o-Serie, vor allem, wenn sie sie in einem so schnellen Tempo herausbringen? Außerdem brauchen sie unser Geld und unsere Daten nicht mehr.

Die Ausbildung neuer Basismodelle - GPT-5, GPT-6 und später - war intern für OpenAI immer sinnvoll, aber nicht unbedingt als Produkt. Das ist wahrscheinlich vorbei. Das einzige wichtige Ziel für sie ist jetzt, weiterhin bessere Daten für die nächste Generation von Modellen zu generieren. Von nun an könnte das Basismodell im Hintergrund arbeiten und andere Modelle zu Leistungen befähigen, die sie allein nicht erreichen könnten - wie ein zurückgezogener alter Mann, der seine Weisheiten aus einer geheimen Höhle weitergibt, nur dass diese Höhle ein riesiges Datenzentrum ist. Ob wir ihn nun sehen oder nicht, wir werden die Folgen seiner Weisheit erfahren.

Selbst wenn der GPT-5 schließlich veröffentlicht wird, erscheint diese Tatsache plötzlich fast irrelevant. Wenn OpenAI und Anthropic in die Gänge kommen Rekursive Selbstverbesserung (allerdings immer noch mit menschlicher Beteiligung), dann wird es keine Rolle mehr spielen, was sie uns öffentlich mitteilen. Sie werden immer weiter vorankommen - so wie sich das Universum so schnell ausdehnt, dass das Licht aus fernen Galaxien uns nicht mehr erreichen kann.

Vielleicht ist das der Grund, warum OpenAI in nur drei Monaten von o1 auf o3 aufgestiegen ist. Es ist auch der Grund, warum sie auf o4 und o5 springen. Das ist wahrscheinlich der Grund, warum sie in letzter Zeit in den sozialen Medien so aufgeregt waren. Weil sie eine neue und verbesserte Arbeitsweise eingeführt haben.

Glauben Sie wirklich, dass die Nähe zur AGI bedeutet, dass Sie in der Lage sein werden, immer leistungsfähigere KI zu nutzen? Dass sie jeden Fortschritt für uns freigeben wird, damit wir ihn nutzen können? Natürlich werden Sie das nicht glauben. Sie meinten es ernst, als sie zum ersten Mal sagten, dass ihre Modelle sie so weit bringen würden, dass niemand sonst in der Lage sein würde, sie einzuholen. Jede neue Generation von Modellen ist ein Motor der Fluchtgeschwindigkeit. Aus der Stratosphäre haben sie abgewunken.

Es bleibt abzuwarten, ob sie zurückkehren werden.