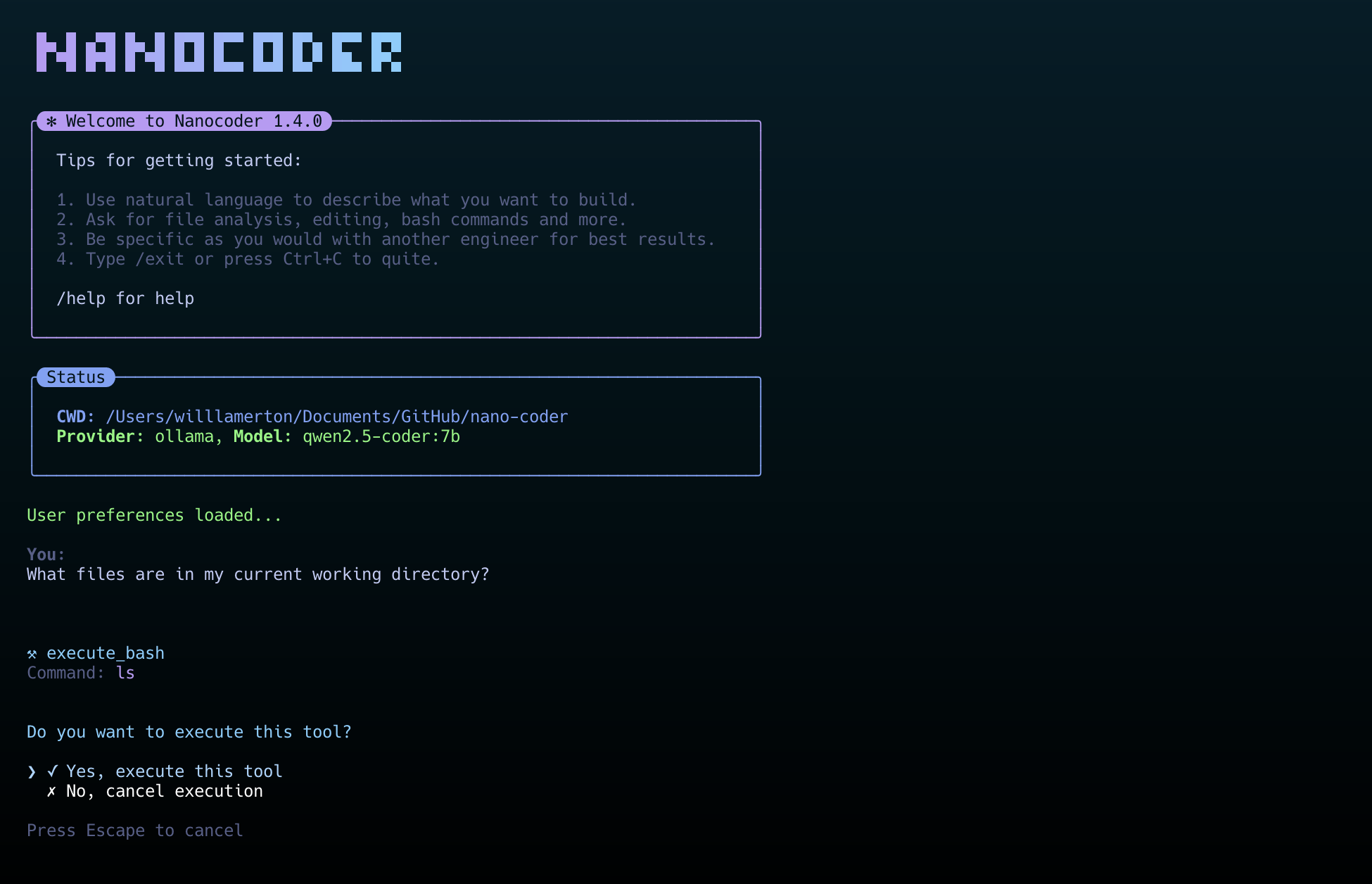

nanocoder ist ein KI-Programmiertool, das in einer lokalen Terminalumgebung ausgeführt wird und dessen Kernphilosophie "local first" lautet, um die Privatsphäre und die Datensicherheit der Benutzer zu schützen. nanocoder ermöglicht es Entwicklern, auf ihren eigenen Computern über eine Befehlszeilenschnittstelle mit KI zu interagieren, um Aufgaben wie das Schreiben, Überprüfen und Refactoring durchzuführen. Das Tool ermöglicht es Entwicklern, auf ihren eigenen Computern über eine Befehlszeilenschnittstelle mit KI zu interagieren, um Code zu schreiben, zu überprüfen und zu überarbeiten. nanocoder bietet Unterstützung für eine breite Palette von KI-Modelldienstleistern. Benutzer können entweder eine Verbindung zu Ollama herstellen, das vollständig lokal läuft, um offline Code zu generieren, oder OpenRouter oder OpenAI-kompatible API-Schnittstellen konfigurieren, um diese leistungsfähigeren Cloud-basierten KI-Modelle zu nutzen. Ollama verfügt über ein integriertes System nützlicher Tools, die es KI ermöglichen, Dateien zu lesen und zu schreiben und Terminal-Befehle direkt auszuführen sowie über das Model Context Protocol (MCP) eine Verbindung zu weiteren externen Diensten wie Dateisystemen, GitHub-Repositories und Websuchen herzustellen, wodurch die Anwendungsmöglichkeiten noch erweitert werden.

Funktionsliste

- Unterstützung für mehrere AI-DienstanbieterEs ist möglich, eine Verbindung zu Ollama, das lokal läuft, zu OpenRouter in der Cloud und zu jedem Dienst herzustellen, der mit der OpenAI API kompatibel ist (z.B. LM Studio, vLLM, etc.).

- Fortschrittliches WerkzeugsystemEingebaute Werkzeuge zur Dateimanipulation, Ausführung von Bash-Befehlen usw. Die KI kann Operationen wie das Lesen oder Schreiben von Dateien oder die Ausführung von Code mit der Erlaubnis des Benutzers durchführen.

- Modell-Kontext-Protokoll (MCP)Unterstützung für die Verbindung mit MCP-Servern, die die Tooling-Funktionen von AI erweitern, z. B. den Zugriff auf das Dateisystem, GitHub, die Brave-Suche und die Speicherbanken.

- Maßgeschneidertes UnterweisungssystemBenutzer können einen neuen Benutzernamen zur Projektliste hinzufügen.

.nanocoder/commandsverwenden Sie Markdown-Dateien, um wiederverwendbare Anweisungen mit Parametern zu erstellen, die die Ausführung von sich stark wiederholenden Aufgaben wie die Erstellung von Tests, Code-Reviews usw. erleichtern. - Intelligente BenutzererfahrungBietet automatische Befehlsvervollständigung, Rückverfolgbarkeit des Dialogverlaufs, Speicherung des Sitzungsstatus usw. und zeigt den Denkprozess der KI, den Tokenverbrauch und die Ausführungszeit in Echtzeit entsprechend dem Aufgabenstatus an.

- Eigenständige Konfiguration auf Projektebene: Durch die Platzierung der

agents.config.jsonDatei kann für jedes Projekt ein anderes KI-Modell oder ein anderer API-Schlüssel zur einfachen Verwaltung festgelegt werden. - Freundlich für EntwicklerDas gesamte Projekt ist mit TypeScript aufgebaut, die Codestruktur ist klar und einfach zu erweitern. Auch bietet detaillierte Debugging-Tools und Logging-Ebene Kontrolle.

Hilfe verwenden

nanocoder ist ein Tool, das im Terminal (Befehlszeilenschnittstelle) läuft. Der folgende Abschnitt beschreibt im Detail, wie man es installiert und benutzt.

Einbauverfahren

1. die Vorbereitung der Umwelt

Bevor Sie nanocoder installieren, müssen Sie sicherstellen, dass Ihr Computer über die Node.js (Version 18+ erforderlich) und npm Werkzeug zur Paketverwaltung. npm wird normalerweise mit Node.js installiert.

2. globale Installation

Es wird empfohlen, die globale Installationsmethode zu verwenden, damit Sie nanocoder direkt von einem beliebigen Verzeichnis auf Ihrem Computer aus starten können. Öffnen Sie Ihr Terminal und geben Sie den folgenden Befehl ein:

npm install -g @motesoftware/nanocoder

Sobald die Installation abgeschlossen ist, können Sie von jedem Projektordner aus direkt darauf zugreifen, indem Sie Folgendes eingeben nanocoder um es zu starten.

Konfigurieren des AI-Modells

Die Stärke von nanocoder ist, dass er verschiedene KI-Modelle miteinander verbinden kann. Sie müssen einen KI-Dienst nach Ihren Bedürfnissen auswählen und konfigurieren. Die Konfigurationsinformationen werden in einer Datei namensagents.config.jsonDatei, die Sie in das Stammverzeichnis Ihres Projektcodes legen müssen.

Option 1: Verwendung von Ollama (lokales Modell)

Dies ist die datenschutzfreundlichste Methode, da das Modell vollständig auf Ihrem eigenen Computer läuft.

- Zunächst müssen Sie Ollama installieren und ausführen.

- Laden Sie dann ein Modell, das Sie benötigen, aus der Ollama-Modellbibliothek herunter. Laden Sie zum Beispiel ein leichtes

qwen2:0.5bModelle:ollama pull qwen2:0.5b - Nachdem Sie die oben genannten Schritte durchgeführt haben, führen Sie direkt

nanocoderEs wird automatisch Ihren lokalen Ollama-Dienst erkennen und eine Verbindung herstellen.

Option 2: Verwendung von OpenRouter (Cloud-basiertes Modell)

OpenRouter vereint eine breite Palette von großartigen AI-Modellen auf dem Markt, wie GPT-4o, Claude 3 und andere.

- Erstellen Sie in Ihrem Projekt-Stammverzeichnis eine

agents.config.jsonDokumentation. - Kopieren Sie den folgenden Text in die Datei und setzen Sie die

your-api-key-hereErsetzen Sie den OpenRouter-API-Schlüssel durch Ihren eigenen und fügen Sie außerdem einen neuen OpenRouter-API-Schlüssel in der DateimodelsDas Feld wird mit dem Namen des zu verwendenden Modells gefüllt.{ "nanocoder": { "openRouter": { "apiKey": "your-api-key-here", "models": ["openai/gpt-4o", "anthropic/claude-3-opus"] } } }

Option 3: Verwendung von OpenAI-kompatiblen APIs (lokal oder remote)

Sie kann auch konfiguriert werden, wenn der von Ihnen verwendete KI-Dienst (z. B. LM Studio, vLLM oder ein von Ihnen selbst erstellter Dienst) eine OpenAI-kompatible API-Schnittstelle bietet.

- In ähnlicher Weise erstellen Sie im Stammverzeichnis des Projekts die Datei

agents.config.jsonDokumentation. - Füllen Sie die folgenden Felder aus, um sie zu platzieren

baseUrlErsetzen Sie diese durch Ihre Dienstadresse und geben Sie den API-Schlüssel ein, wenn Sie ihn benötigen.{ "nanocoder": { "openAICompatible": { "baseUrl": "http://localhost:1234", "apiKey": "optional-api-key", "models": ["model-1", "model-2"] } } }

Grundbedienungsbefehl

Nach dem Start von nanocoder werden Sie zu einer interaktiven Chat-Schnittstelle weitergeleitet. Sie können entweder in natürlicher Sprache beschreiben, was Sie wollen, oder Sie verwenden den Schrägstrich/Die eingebauten Anweisungen am Anfang steuern das Programm.

/helpZeigt eine Liste mit allen verfügbaren Befehlen an./provider:: Wechsel des KI-Dienstleisters, z. B. von Ollama zu OpenRouter./modelWechseln Sie zwischen der Liste der Modelle, die vom aktuellen Dienstanbieter bereitgestellt werden./clearLöschen Sie den aktuellen Chat und beginnen Sie eine neue Sitzung./debugSchaltet die Ebene der Protokollanzeige um, auf der detaillierte Informationen über den Betrieb des Programms angezeigt werden./exit: Beenden Sie das Nanocoder-Programm.

Benutzerdefinierte Befehle verwenden

Benutzerdefinierte Befehle sind eine besondere Funktion von nanocoder, die Ihnen bei der Erstellung von Vorlagen für allgemeine komplexe Aufgaben hilft.

- Erstellen Sie eine Datei im Stammverzeichnis Ihres Projekts mit dem Namen

.nanocoderund erstellen Sie dann einen weiterencommandsMappe. - 在

.nanocoder/commands/Verzeichnis, erstellen Sie eine Markdown-Datei, zum Beispieltest.md。 - In dieser Datei können Sie die Beschreibung, die Aliasnamen und die Parameter der Direktive definieren. Erstellen Sie zum Beispiel eine Richtlinie für die Erstellung von Unit-Tests:

--- description: "为指定的组件生成全面的单元测试" aliases: ["testing", "spec"] parameters: - name: "component" description: "需要测试的组件或函数名称" required: true --- 请为 {{component}} 生成全面的单元测试。测试需要覆盖以下几点: - 正常情况下的行为 - 边界条件和异常处理 - 对外部依赖进行模拟 - 清晰的测试描述 - Nachdem Sie die Datei gespeichert haben, können Sie diesen neuen Befehl in nanocoder verwenden. Zum Beispiel, für

UserServiceGenerieren Sie Tests, die Sie eingeben können:

/test component="UserService"

Das Programm stellt automatisch die{{component}}Ersetzen durchUserServicedie dann die gesamte Aufforderung an das KI-Modell sendet, um die Aufgabe zu erfüllen.

Anwendungsszenario

- Schnelles Erzeugen von Codeschnipseln

Wenn Entwickler eine neue Funktion oder ein neues Modul schreiben müssen, können sie die Anforderungen an nanocoder direkt im Terminal beschreiben, z. B. "Erstellen Sie eine TypeScript-Funktion zum Parsen von CSV-Dateien", und AI generiert direkt den entsprechenden Code. - Codeüberprüfung und Refaktorierung

Ein Stück geschriebener Code kann einem Nanocoder zur Überprüfung und für Verbesserungsvorschläge übergeben werden. Es ist auch möglich, benutzerdefinierte Refactoring-Direktiven zu verwenden, wie z. B./refactor:dryDie KI wird angewiesen, den Code nach dem Prinzip "Wiederhole dich nicht" zu optimieren. - Schreiben von Einheitstests

Die schnelle Generierung von Unit-Testfällen für bestehende Funktionen oder Komponenten ist einer der mühsamsten Aspekte der Softwareentwicklung. Es ist möglich, Unit-Testfälle für bestehende Funktionen oder Komponenten zu generieren, indem man die/testAnleitungen müssen Entwickler nur den Komponentennamen angeben. Sie können AI automatisch Testcode schreiben lassen, um die Entwicklungseffizienz zu verbessern. - Erlernen einer neuen Programmiersprache oder eines neuen Frameworks

Wenn Sie sich einer unbekannten Technologie nähern, betrachten Sie sie als einen Programmierlehrer auf Abruf, indem Sie Fragen stellen und den Nanocoder bitten, Codebeispiele zu liefern oder den Zweck und die Funktionsweise eines bestimmten Codes zu erklären.

QA

- Welche Betriebssysteme werden von nanocoder unterstützt?

nanocoder wurde auf der Grundlage von Node.js entwickelt und kann daher auf allen gängigen Betriebssystemen, einschließlich Windows, macOS und Linux, ausgeführt werden, solange die Node.js-Umgebung auf dem System installiert ist. - Was sind die Voraussetzungen für die Nutzung des lokalen Ollama-Modells?

Die Verwendung von Ollama setzt voraus, dass Sie zunächst das Programm Ollama auf Ihrem Computer installieren und ausführen. Es gibt einige Anforderungen an die Computerhardware, die hauptsächlich von der Größe des KI-Modells abhängen, das Sie ausführen. Je größer das Modell ist (z. B. mehr als 7 Milliarden Parameter), desto mehr RAM und eine gute Grafikkarte (GPU) sind erforderlich, um eine schnelle Generierung zu gewährleisten. - Sind mein API-Schlüssel und meine Codedaten sicher?

Nanocoder wurde nach dem Prinzip "local first" entwickelt. Wenn Sie Ollama verwenden, werden alle Daten und Berechnungen auf Ihrem lokalen Computer durchgeführt, ohne dass externe Server beteiligt sind. Wenn Sie einen Cloud-Dienst wie OpenRouter nutzen, werden Ihr Code und Ihre Hinweise über eine API an den Dienstanbieter gesendet. In diesem Fall müssen Sie die Datenschutzbestimmungen des Dienstanbieters einhalten. Konfigurationsdateiagents.config.jsonEs wird in Ihrem lokalen Projektverzeichnis gespeichert und nicht hochgeladen. - Wie unterscheidet sich nanocoder von anderen KI-Programmierwerkzeugen?

Das Hauptunterscheidungsmerkmal von nanocoder ist, dass es sich um ein Tool handelt, das ausschließlich in der Kommandozeile läuft, was es ideal für Entwickler macht, die an Tastaturmanipulation und Terminal-Workflows gewöhnt sind. Zweitens legt es den Schwerpunkt auf Local-First und Benutzerkontrolle und gibt den Benutzern die Freiheit zu wählen, ob sie ein lokales oder ein Cloud-basiertes Modell verwenden möchten, mit granularer Verwaltung über Konfigurationsdateien auf Projektebene.