Mit der kontinuierlichen Weiterentwicklung der KI-Technologien ist die personalisierte und sehr natürliche Sprachinteraktion zu einer Schlüsselanforderung für viele intelligente Anwendungen geworden. Bestehende Text-to-Speech (TTS)-Technologien stehen jedoch immer noch vor der Herausforderung, personalisierte Töne in großem Umfang, eine mehrsprachige Abdeckung und äußerst realistische emotionale Ausdrücke zu erreichen. Um diese Probleme der Industrie zu lösen, hat dieMiniMax Speech 02 Als AR-basierte Transformer Das hochwertige TTS-System wurde mit dem Ziel auf den Markt gebracht, durch seine einzigartigen technologischen Innovationen neue Durchbrüche im Bereich der personalisierten Sprachsynthese zu erzielen.

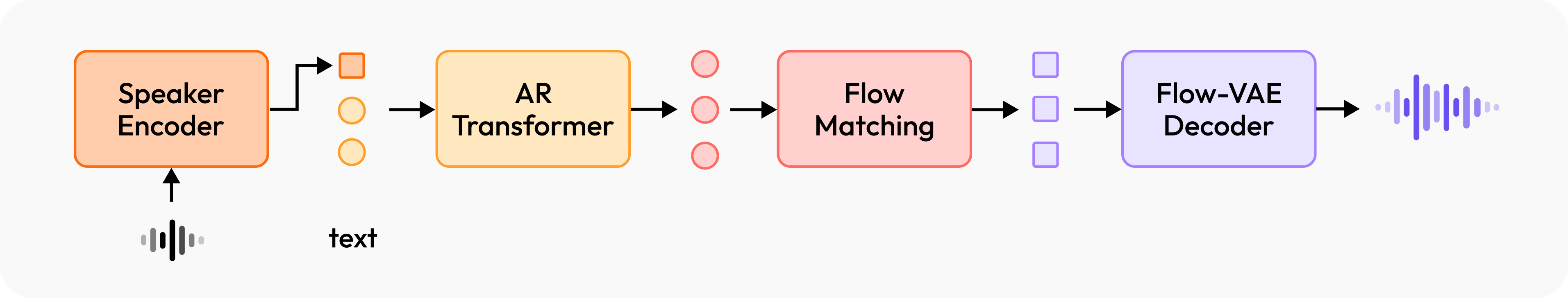

Das System behauptet, über starke Generalisierungsfähigkeiten zu verfügen, bis zu 32 Sprachen zu beherrschen und Vokalsynthese mit verschiedenen Akzenten und emotionalen Stilen zu unterstützen. Das zentrale Highlight ist die Einführung eines Mechanismus, der als "lernfähiger Sprechercodierer" bezeichnet wird und zusammen mit dem AR-Transformer-Modell trainiert wird. Diese Konstruktion ermöglicht MiniMax Speech 02 Ermöglicht effiziente Zero-shot Klonen von Sprache, wobei Sprache mit den klanglichen Merkmalen eines Zielsprechers allein aus einem kurzen Referenzton erzeugt werden kann, ohne dass umfangreiche Trainingsdaten von diesem Sprecher erforderlich sind.

Leistung und Marktanerkennung: Doppelte Spitzenwerte und Kosteneffizienz

Auf der Grundlage von öffentlich zugänglichen Benchmarking-Ergebnissen ist dieMiniMax Speech 02 (in der Liste als Speech-02-HD aufgeführt) in Artificial Analysis Speech Arena und Hugging Face TTS Arena, zwei globale Sprachsynthese-Arenen, haben beide vor OpenAI abgeschlossen, ElevenLabs Die Ergebnisse von bekannten Modellen wie Diese Plattformen verwenden häufig ein ELO-Bewertungssystem mit blinder Benutzerbewertung, und die Ergebnisse spiegeln bis zu einem gewissen Grad die Überlegenheit des Modells in Bezug auf die tatsächliche Hörerfahrung wider.

Zusätzlich zu den Leistungsindikatoren werden dieMiniMax Speech 02 Auch die Kosten für den kommerziellen Einsatz wurden berücksichtigt. Der Preis des Dienstes soll etwa 50% bzw. 75% unter dem der Angebote Flash V2.5 und Mutilingual V2 von ElevenLabs liegen, was ihn für eine größere Anzahl von Entwicklern und Unternehmensanwendungen attraktiver macht.

Kerntechnologie-Architektur: Lernender Tone Encoder mit Zero-Shot-Fähigkeit

MiniMax Speech 02 Im Mittelpunkt der technologischen Innovation steht der "lernfähige Timbre-Extraktor". Der Extraktor ist im Wesentlichen ein Sprecher-Encoder, der einen Referenz-Audioclip beliebiger Länge in eine Sprechereinbettung fester Größe kodiert. Dieser Vektor erfasst die wichtigsten Klangfarbenmerkmale des Referenzaudios und wird zur Steuerung des nachfolgenden Sprachsyntheseprozesses verwendet.

Zu den wichtigsten Merkmalen der Architektur gehören:

- Effizientes Zero-Shot-KlonenDas System benötigt lediglich ein Referenz-Audiomaterial (ohne Texttranskription), aus dem die Klangfarbeninformationen extrahiert und für die Generierung neuer Textinhalte verwendet werden können. Dieser Ansatz konzentriert sich auf die Erfassung der wesentlichen Klangmerkmale wie Klangfarbe, Grundfrequenz und Rhythmik und bildet damit die Grundlage für die Erzeugung von Sprache mit einem hohen Maß an Natürlichkeit und Ausdruckskraft. Die ausgegebene Sprache ist nicht nur in Bezug auf die Klangfarbe dem Referenzton sehr ähnlich, sondern zeichnet sich auch durch eine hohe artikulatorische Stabilität aus.

- Umfassende mehrsprachige Unterstützung (32 Sprachen)Der Timbre-Extraktor trennt bei der Verarbeitung von Referenz-Audiodaten die klanglichen Merkmale vom semantischen Inhalt. Da der Encoder "lernfähig" ist, kann er auf großen Datensätzen mit mehreren Sprachen trainiert werden. Diese Funktion ermöglicht MiniMax Speech 02 Unterstützt von Haus aus die Sprachsynthese in bis zu 32 Sprachen und gewährleistet eine gute Konsistenz der Klangfarbe und Natürlichkeit bei sprachübergreifenden Syntheseaufgaben.

- Flexible funktionale ErweiterbarkeitDie vom Timbre-Encoder erzeugten bedingten Vektoren haben gute Entkopplungseigenschaften, was die Erweiterung nachgelagerter Anwendungen erleichtert. Zu den derzeit implementierten Funktionen gehören die flexible Steuerung von Emotionen für synthetisierte Sprache, die Erzeugung spezifischer Klangfarben auf der Grundlage von Textbeschreibungen (Text-to-Voice, T2V) und die Feinabstimmung mit einer kleinen Menge von Zielsprecherdaten für professionelleres Stimmenklonen (Professional Voice Cloning, PVC).

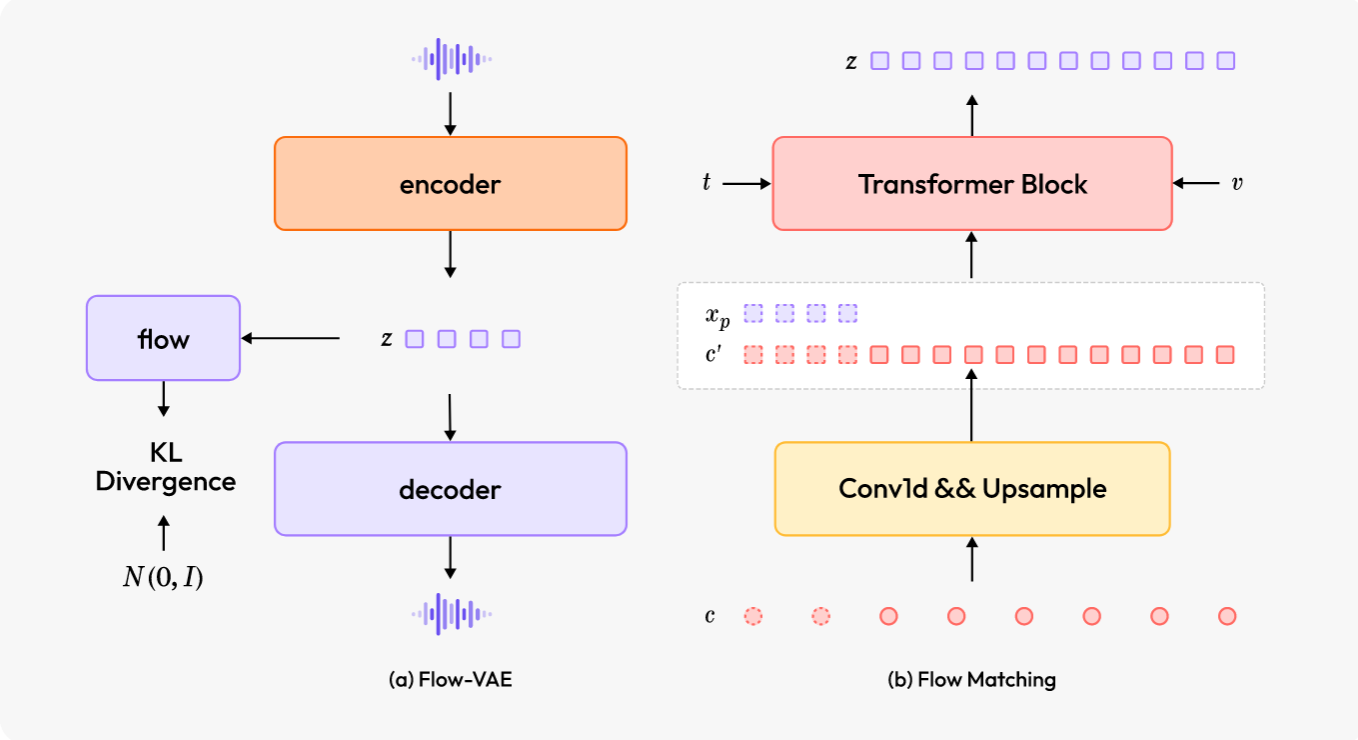

Technologie zur Verbesserung der Klangqualität: Anwendung von Flow-VAE

Um die Klangqualität und den Realismus der erzeugten Sprache weiter zu verbessern, wird dieMiniMax Speech 02 Flow-VAE wird eingeführt. Herkömmliche Variations-Autokodierer (VAEs) gehen in der Regel davon aus, dass der latente Raum einer Standard-Gauß-Verteilung gehorcht, was ihre Fähigkeit, komplexe Audiomerkmale auszudrücken, einschränken kann. Flow-VAE optimiert die Verteilung des latenten Raums durch die Einführung eines Flussmodells, das es dem Kodierer ermöglicht, eine flexiblere Normalverteilung auszugeben und damit die Fähigkeit des Kodierers, Informationen auszudrücken, zu verbessern. Die Website

Flow-VAE komprimiert zunächst die Audiowellenform in verborgene Merkmale, die reichere Informationen enthalten als das traditionelle Mayer-Spektrogramm. Das Flow-Matching-Modell wird dann verwendet, um die Verteilung dieser verborgenen Merkmale genau zu modellieren. Auf diese Weise ist das System in der Lage, mehr akustische Details während der Sprachsynthese zu rekonstruieren, wodurch eine höhere akustische Wiedergabetreue und Klangfarbenähnlichkeit beim Hörerlebnis erreicht wird.

Mehrdimensionale Leistungsbewertung

Laut dem veröffentlichten technischen Bericht (Links zu technischen Berichten) und Präsentationsfälle (Links erleben),MiniMax Speech 02 Es stellt seine Leistungsfähigkeit auf verschiedene Weise unter Beweis:

- Vielfalt des klanglichen AusdrucksDas System ist in der Lage, eine breite Palette von Sprachstilen zu erzeugen, einschließlich ansteckender Sprache, sanftem Flüstern (ASMR) usw., wodurch eine breite Palette von Emotionen und Stilen abgedeckt werden kann.

- Mehrsprachigkeit und sprachenübergreifende KompetenzZero-shot hat auch seine Fähigkeit zur sprachübergreifenden Synthese unter Beweis gestellt, indem es beispielsweise englische Referenztöne für die Synthese chinesischer oder spanischer Inhalte verwendet und dabei die tonale Konsistenz beibehält, zusätzlich zur direkten Synthese von Thai, Polnisch, Japanisch und anderen Sprachen.

- Vinh Sheng Stimme (T2V)Unterstützung für Textbeschreibungen (z. B. "heisere männliche Stimme mittleren Alters, mittlere bis langsame Sprechgeschwindigkeit, niedrige Tonhöhe"), um Sprache zu erzeugen, die der Beschreibung entspricht.

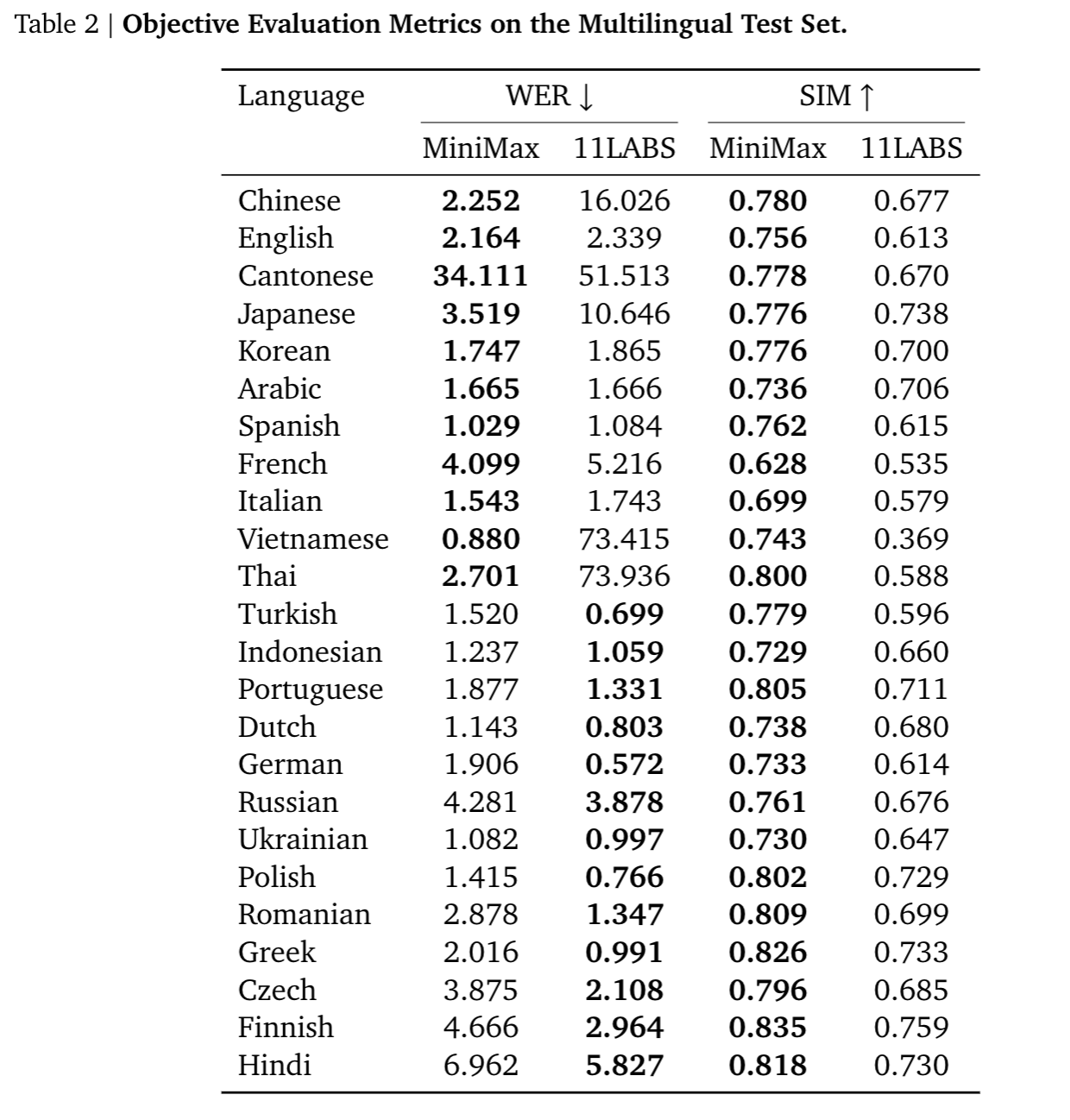

In einem vergleichenden Test der mehrsprachigen Zero-Shot-Leistung hat die MiniMax Speech 02 Es wurden Vergleiche mit dem Modell ElevenLabs multilingual_V2 angestellt. Die Bewertungsmetriken umfassen:

- Sprachliche Ähnlichkeit (SIM)Dies wird durch die Berechnung der Kosinus-Ähnlichkeit zwischen der Einbettung der Sprecher gemessen. Die Ergebnisse zeigen, dassMiniMax Speech 02 übertraf das Vergleichsmodell bei den SIM-Metriken in allen getesteten Sprachen.

- Wortfehlerrate (WER)Whisper-large-v3 oder Paraformer-ZM für Berechnungen zur Spracherkennung nach der Transkription verwenden.MiniMax Speech 02 Es zeigt eine hohe Genauigkeit bei den wichtigsten europäischen und amerikanischen Sprachen wie Englisch, Französisch, Italienisch und Portugiesisch. Bei einigen asiatischen Sprachen (z. B. Kantonesisch, Thailändisch, Vietnamesisch, Japanisch) übersteigt der WER des Vergleichsmodells 10%.

Diese Daten zeigen, dass MiniMax Speech 02 Wettbewerbsfähig in Bezug auf die mehrsprachige Anpassungsfähigkeit und die Genauigkeit des Tonklonens.

Technische Anwendungen und Perspektiven

MiniMax Speech 02 Der technologische Fortschritt hat neue Möglichkeiten in den Bereichen der personalisierten Inhaltserstellung, der sprachübergreifenden Kommunikation und der Mensch-Computer-Interaktion eröffnet. So können die Ersteller von Inhalten die Technologie beispielsweise nutzen, um mehrsprachige und mehrsprachige Audioinhalte zu geringeren Kosten zu produzieren. Darüber hinaus trägt die Unterstützung seltener Sprachen zur Erhaltung und Verbreitung der sprachlichen Vielfalt im digitalen Zeitalter bei.

Die weitere Entwicklung des Systems wird sich darauf konzentrieren, die Kontrollierbarkeit und Effizienz des Modells weiter zu verbessern. Seine kombinierte Leistung in Bezug auf das Klonen von Klangfarben, die Unterstützung mehrerer Sprachen und die Klangqualität macht es zu einem bemerkenswerten Fortschritt auf dem aktuellen Gebiet der TTS-Technologie.