Meta AI V-JEPA 2 (Video Joint Embedding Predictive Architecture 2), sein neuestes Weltmodell, wurde am 11. Juni veröffentlicht. Das Modell erreicht die modernste Leistung beim visuellen Verständnis und der Vorhersage der physischen Welt und kann für die "Zero-Shot"-Planung von Robotern verwendet werden, die mit unbekannten Objekten in unbekannten Umgebungen interagieren.

Zusammen mit der Modellfreigabe gibt es drei neue Benchmark-Tests, mit denen die Fähigkeit bestehender Modelle, Schlussfolgerungen über die physische Welt zu ziehen, genauer bewertet werden soll. Dieser Schritt ist nicht nur ein weiterer Schritt auf Metas Weg zu fortgeschrittener maschineller Intelligenz (AMI), sondern bietet der gesamten Branche einen neuen Maßstab für die Messung der Fähigkeit von KI, mit der physischen Welt zu interagieren.

Was ist das Weltmodell?

Menschliche Säuglinge entwickeln ihre Intuition über die Welt durch Beobachtung, lange bevor sie sprechen lernen. Werfen sie zum Beispiel einen Tennisball nach oben, fällt er, ohne in der Luft zu schweben oder sich plötzlich in einen Apfel zu verwandeln. Diese physische Intuition ist eine Manifestation des inneren Weltmodells.

Dieses interne Modell ermöglicht es uns, die Folgen unseres eigenen Verhaltens oder des Verhaltens anderer vorherzusagen und somit vorauszuplanen. Wenn wir durch einen überfüllten Raum navigieren, antizipieren wir unbewusst Wege, um Zusammenstöße zu vermeiden; wenn wir das Abendessen zubereiten, schätzen wir empirisch ein, wann wir das Feuer ausmachen sollten.

Um KI-Agenten zu entwickeln, die in der physischen Welt "denken können, bevor sie handeln", muss ihr Weltmodell über drei zentrale Fähigkeiten verfügen:

- VerständnisseDie Fähigkeit, Objekte, Handlungen und Bewegungen in einem Video zu erkennen.

- rechnen Sie mitdie Fähigkeit, die Entwicklung der Welt vorauszusehen und zu erkennen, wie sie sich als Reaktion auf bestimmte Verhaltensmaßnahmen verändern wird.

- planen (wie man etw. tut)Planen Sie eine Reihe von Aktionen, die zur Erreichung eines Ziels führen, auf der Grundlage von Vorhersagefähigkeiten.

Einzelheiten zum Modell V-JEPA 2

V-JEPA 2 ist ein Modell mit 1,2 Milliarden Parametern, das auf der JEPA-Architektur (Joint Embedded Prediction Architecture) basiert, die erstmals von Meta im Jahr 2022 vorgeschlagen wurde. Das Modell wird in erster Linie durch selbstüberwachtes Lernen auf riesigen Mengen von Videomaterial trainiert, wodurch es einen Einblick in die Funktionsweise der Welt erhält, ohne dass eine menschliche Kennzeichnung erforderlich ist.

Sein Kern besteht aus zwei Komponenten:

- GeberEingabe von Rohvideo und Ausgabe von Einbettungen, die wichtige semantische Informationen über den Zustand der Welt erfassen.

- PrädiktorEmpfang von Kontextinformationen wie Videoeinbettungen und Vorhersagezielen und Ausgabe von Vorhersageeinbettungen für die Zukunft.

Die Ausbildung für V-JEPA 2 ist in zwei Phasen unterteilt:

- Bewegungsfreies VortrainingDas Modell wurde zunächst mit mehr als 1 Million Stunden Videomaterial und 1 Million Bildern trainiert. Anhand dieser Daten lernte es die Grundlagen, wie sich Objekte bewegen und interagieren. Nach dieser Phase hat das Modell bei Aufgaben wie Handlungserkennung (Something-Something v2), Handlungsantizipation (Epic-Kitchens-100) und Videoquiz (Perception Test, TempCompass) das höchste Niveau erreicht.

- Bewegungsabhängiges TrainingAufbauend auf der ersten Stufe wird das Modell anhand von Daten trainiert, die die Sicht- und Steuerbewegungen des Roboters enthalten. In diesem Schritt konnte der Prädiktor lernen, "spezifische Aktionen" zu berücksichtigen. Bemerkenswerterweise konnte das Modell in dieser Phase mit nur 62 Stunden an Roboterdaten effektive Planungs- und Steuerungsfähigkeiten erlangen.

V-JEPA 2 demonstriert hervorragende Null-Proben-Fähigkeiten bei der Roboterplanung. Es wurde auf einem Open-Source-DROID-Datensatz trainiert und kann direkt auf MetaLab-Robotern eingesetzt werden, ohne dass eine Feinabstimmung für neue Umgebungen oder neue Roboter erforderlich ist.

Für kurze Aufgaben wie Greifen und Ablegen geben Sie dem Roboter einfach ein Bild des Zielzustands. Mit Hilfe des V-JEPA 2 Prädiktors "visualisiert" der Roboter die Folgen der Ausführung einer Reihe von möglichen Aktionen und wählt diejenige aus, die dem Ziel am nächsten kommt. Mit Hilfe der modellprädiktiven Steuerung kann der Roboter kontinuierlich neu planen und Aktionen ausführen. Bei komplexeren, langwierigen Aufgaben kann der Roboter durch die Vorgabe einer Reihe von visuellen Teilzielen geführt werden. Auf diese Weise hat V-JEPA 2 eine Erfolgsquote von 65% - 80% bei der Bewältigung von Pick-and-Place-Aufgaben für ungesehene Objekte in einer neuen Umgebung erreicht.

V-JEPA 2 Verwandte Ressourcen.

Neue Maßstäbe für das Verständnis der Physik setzen

Die drei neuen Benchmark-Tests, die zusammen mit dem Modell veröffentlicht werden, sind nicht weniger wichtig als das Modell selbst. Sie sollen die Lücken im derzeitigen Bewertungssystem schließen und die Gemeinschaft dazu bringen, Modelle zu entwickeln, die die physikalische Welt wirklich verstehen. Während Menschen in diesen Tests eine Genauigkeit von 85% - 95% erreichen können, gibt es immer noch eine erhebliche Lücke zwischen der Leistung von Spitzenmodellen, einschließlich V-JEPA 2, und Menschen.

- IntPhys 2

Ziel des Benchmarks ist es, die Fähigkeit eines Modells zu messen, zwischen physikalisch "möglichen" und "unmöglichen" Szenarien zu unterscheiden. Die Spiel-Engine wird verwendet, um Paare von Videos zu erzeugen, von denen eines einem Ereignis unterliegt, das die physikalischen Gesetze an einem bestimmten Knotenpunkt verletzt. Das Modell muss erkennen, welches Video problematisch ist. Die Testergebnisse zeigen, dass das derzeitige Videomodell bei dieser Aufgabe ähnlich gut abschneidet wie der Zufall.IntPhys 2 Ressourcen.

- Minimal Video Pairs (MVPBench)

Mit diesem Benchmark wird das physikalische Verständnis eines Videosprachmodells durch Multiple-Choice-Fragen bewertet. Das Besondere daran ist, dass jedes Beispiel ein "Minimum-Varianz-Paar" hat: ein Video, das visuell sehr ähnlich ist, aber entgegengesetzte Antworten hat. Das Modell muss beide Fragen richtig beantworten, um Punkte zu erhalten, wodurch das Problem des "Abkürzens" des Modells durch oberflächliche visuelle oder textliche Hinweise wirksam eingedämmt wird.MVPBench-Ressourcen.

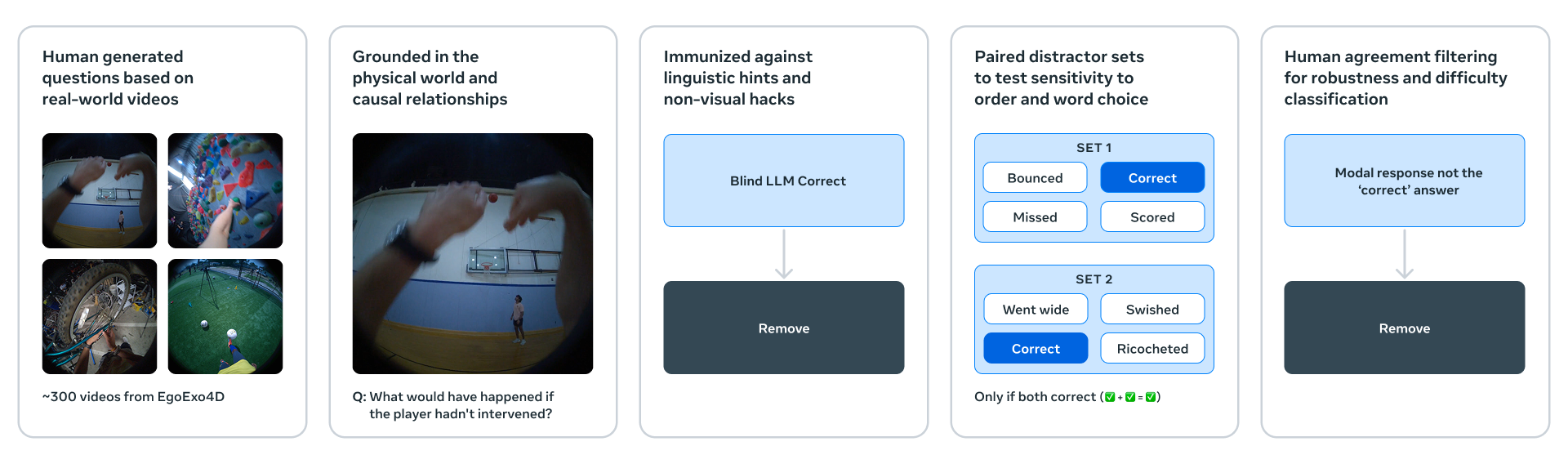

- CausalVQA

Der Benchmark konzentriert sich auf das kausale Verständnis der physikalischen Welt. Es werden Modelle mit kontrafaktischen Werten ("Was würde passieren, wenn ......?") , Erwartungen ("Was passiert als nächstes?") und Planung ("Was sollte ich als nächstes tun, um mein Ziel zu erreichen?") und andere Fragen. Die Tests ergaben, dass das große multimodale Modell zwar die Frage "Was ist passiert?" gut beantwortete, aber bei Fragen wie "Was hätte passieren können? mangelhaft.

CausalVQA-Ressourcen.

Meta hat auch ein Hugging Face aufdie Charts (der Bestseller)die dazu dienen, die Fortschritte der Gemeinschaftsmodelle anhand dieser neuen Benchmarks zu verfolgen.

Der nächste Schritt zu fortschrittlicher maschineller Intelligenz

V-JEPA 2 ist erst der Anfang. Derzeit lernt und prognostiziert es auf einer einzigen Zeitskala. Aufgaben wie "das Geschirr in den Geschirrspüler einräumen" oder "einen Kuchen backen" erfordern jedoch eine hierarchische Planung auf verschiedenen Zeitskalen.

Daher wird sich die künftige Forschung auf hierarchische JEPA-Modelle konzentrieren, die in der Lage sind, über mehrere räumliche und zeitliche Skalen hinweg zu lernen, zu argumentieren und zu planen. Eine weitere wichtige Richtung sind multimodale JEPA-Modelle, die in der Lage sind, visuelle, auditive, taktile und andere sensorische Informationen für Vorhersagen zu vereinen. Diese Forschungen werden die tiefe Integration von KI mit der physischen Welt weiter vorantreiben.