Lemon AI ist ein vollständiges Open-Source-Framework für intelligente Körper, das eine vollständig lokale Laufzeitumgebung bietet, ohne auf Cloud-Dienste angewiesen zu sein. Es unterstützt lokale Large Language Models (LLMs) wie DeepSeek, Qwen, Llama, usw. durch die Ollama Lemon AI integriert eine Sandbox für virtuelle Maschinen, um die Codeausführung für Einzelpersonen und Unternehmen zu sichern, die eine lokalisierte AI-Lösung benötigen. Sie kann problemlos auf PCs oder Unternehmensservern eingesetzt werden und ist einfach und kompatibel mit einer Vielzahl von Umgebungen. Lemon AI bietet eine Ein-Klick-Bereitstellung, wodurch die technische Schwelle gesenkt wird, und unterstützt die Verbindung mit Cloud-Modellen wie Claude, GPT, Gemini und Grok über APIs, wodurch ein Ausgleich zwischen lokaler und Cloud-Flexibilität geschaffen wird.

Funktionsliste

- Lokal ausgeführte KI-Intelligenzen: Unterstützung lokaler großer Sprachmodelle wie DeepSeek, Qwen, Llama usw. und Lokalisierung der gesamten Datenverarbeitung.

- Virtual Machine Sandbox: Bietet eine sichere Code-Ausführungsumgebung, die Benutzergeräte vor potenziellen Risiken schützt.

- Codegenerierung und -interpretation: Generierung von hochwertigem Code, Unterstützung von 16K Ausgabelänge, Optimierung von Codeformat und Syntax.

- Vertiefte Recherche und Web-Browsing: unterstützt die Planung, Durchführung und Reflexion komplexer Aufgaben, geeignet für Recherche und Datenerfassung.

- Datenanalyse: Verarbeitung und Analyse von Daten, Erstellung von Visualisierungsergebnissen für eine Vielzahl von Analyseszenarien.

- API-Integration: Unterstützt die Verbindung mit Cloud-Modellen (z. B. Claude, GPT) zur Erweiterung der Funktionalität.

- Ein-Klick-Bereitstellung: Bietet Docker-Container und einen vereinfachten Installationsprozess, der mit PCs und Unternehmensservern kompatibel ist.

- Flexible Anpassung: Die Architektur unterstützt die Benutzer dabei, sie nach ihren Bedürfnissen zu modifizieren und zu erweitern und sich an unterschiedliche Geschäftsszenarien anzupassen.

Hilfe verwenden

Einbauverfahren

Lemon AI bietet mehrere Bereitstellungsmethoden, einschließlich Open-Source-Code, Docker-Container, Client-Anwendungen und Online-Abonnements. Im Folgenden finden Sie ein Beispiel für den Docker-Einsatz, das den detaillierten Installations- und Nutzungsprozess vorstellt und für Anfänger und professionelle Nutzer geeignet ist.

- Installation von Docker

Vergewissern Sie sich, dass Docker auf Ihrem Gerät installiert ist; falls nicht, besuchen Sie die Docker-Website, um es herunterzuladen und zu installieren. Windows-Benutzer müssen WSL (Windows Subsystem for Linux) aktivieren, um Docker-Befehle auszuführen. - Lemon AI-Code erhalten

Lemon AI's GitHub Repository besuchenhttps://github.com/hexdocom/lemonaiKlicken Sie auf die grüne Schaltfläche "Code" und wählen Sie "ZIP herunterladen", um den Quellcode herunterzuladen. Klicken Sie auf die grüne Schaltfläche "Code" und wählen Sie "ZIP herunterladen", um den Quellcode herunterzuladen, oder klonen Sie das Repository mit Git:git clone https://github.com/hexdocom/lemonai.git

Entpacken Sie die Datei oder wechseln Sie in das geklonte Verzeichnis.

- Ausführen von Docker-Containern

Öffnen Sie ein WSL-Terminal (Windows-Benutzer) oder ein normales Terminal (Linux/Mac-Benutzer) und gehen Sie zum Lemon AI-Projektverzeichnis. Führen Sie den folgenden Befehl aus, um den Docker-Container zu starten:docker-compose up -dDieser Befehl zieht automatisch die benötigten Images und startet den Lemon AI-Dienst. Stellen Sie sicher, dass Docker Compose installiert ist.

- Konfigurieren des lokalen Modells

Lemon AI verwendet standardmäßig Ollama, um ein lokales großes Sprachmodell auszuführen. Installieren Sie Ollama (siehe die offizielle Ollama Website) und ziehen Sie die unterstützten Modelle, zum Beispiel:ollama pull deepseekAuf der Seite Einstellungen von Lemon AI konfigurieren Sie den Modellpfad und stellen sicher, dass er auf das lokale Modell verweist.

- Überprüfen der Installation

Nach dem Booten kann der Zugriff auf die lokale Adresse (normalerweisehttp://localhost:3000) Zeigen Sie die Lemon AI-Schnittstelle an. Die Schnittstelle zeigt den Modellstatus und die verfügbaren Funktionen an. Wenn das Modell nicht geladen ist, überprüfen Sie, ob Ollama korrekt läuft.

Funktion Betriebsablauf

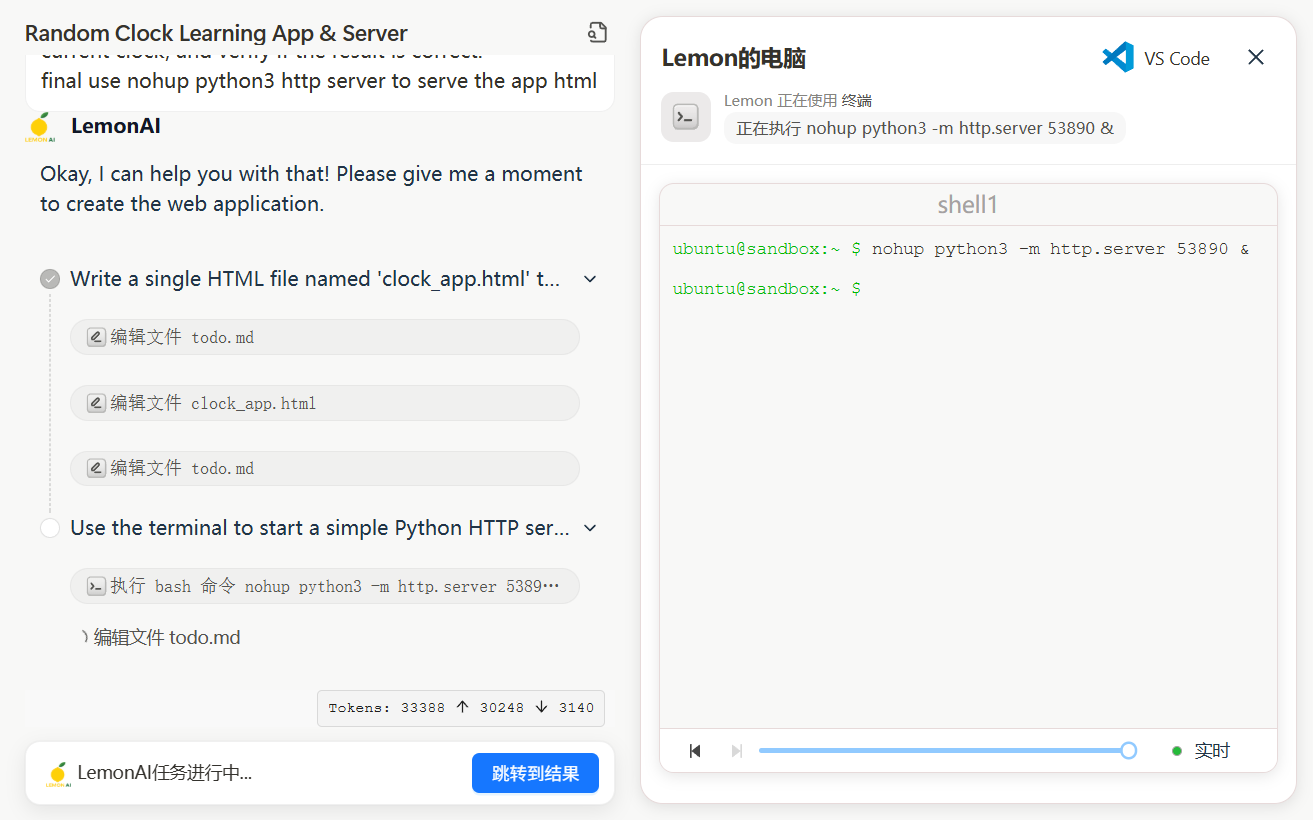

1. die Generierung und Interpretation des Codes

Die Codegenerierungsfunktion von Lemon AI ermöglicht es Ihnen, Code für Entwickler zu generieren und zu optimieren, um schnell Skripte zu erstellen oder Programmierprobleme zu lösen. Wählen Sie in der Hauptschnittstelle das Modul "Code-Generierung" und geben Sie die Anforderungen an die Aufgabe ein, z. B. "Schreiben Sie ein Python-Skript zum Crawlen von Webdaten". Das System ruft das lokale Modell (z. B. DeepSeek-V3) auf, um den Code zu generieren und ihn im Ergebnisbereich anzuzeigen. Der generierte Code unterstützt eine maximale Länge von 16K Zeichen und ist so formatiert, dass Syntaxfehler minimiert werden. Benutzer können den Code direkt kopieren oder die Tests in einer Sandbox einer virtuellen Maschine ausführen. Die Sandbox-Umgebung isoliert die Codeausführung und verhindert, dass sie sich auf das lokale Gerät auswirkt. Führen Sie zum Beispiel den folgenden Befehl aus, um den Code zu testen:

python script.py

Wenn Sie den Code anpassen müssen, klicken Sie auf die Schaltfläche "Bearbeiten", ändern Sie ihn und führen Sie ihn erneut aus.

2. gründliche Recherche und Surfen im Internet

Lemon AI bietet einen "ReAct Mode", um die Planung und Ausführung komplexer Aufgaben zu unterstützen. Rufen Sie das Modul "Recherche" auf und geben Sie eine Aufgabe ein, z. B. "Analysieren Sie die Marktentwicklung einer bestimmten Branche". Das System gliedert die Aufgabe auf, sucht automatisch nach relevanten Webseiten und extrahiert Informationen. Die Benutzer können die Suchergebnisse, Datenzusammenfassungen und Analyseberichte einsehen. Der Rechercheprozess ist vollständig lokalisiert, um den Datenschutz zu gewährleisten. Über die Einstellungen können die Benutzer die Suchtiefe anpassen oder Datenquellen angeben.

3. die Datenanalyse

Laden Sie im Modul "Datenanalyse" CSV-Dateien oder Eingabedaten hoch, und Lemon AI erstellt statistische Diagramme und Analyseergebnisse. Zum Beispiel kann das System nach dem Hochladen von Verkaufsdaten Balkendiagramme oder Liniendiagramme zur Visualisierung von Trends erstellen. Zu den unterstützten Analysen gehören Mittelwert-, Verteilungs- und Korrelationsberechnungen. Die Benutzer können die Analysen in PDF- oder Bildformate exportieren.

4. die API-Integration

Wenn Sie ein Cloud-Modell verwenden möchten, gehen Sie zur Seite Einstellungen - Modelldienste und fügen Sie einen API-Schlüssel hinzu (z. B. Claude oder GPT). Die Lemon AI überprüft die Gültigkeit der Schlüssel und sorgt für eine stabile Verbindung. Einmal konfiguriert, können Benutzer zwischen lokalen und Cloud-Modellen wechseln, um Aufgaben flexibel zu erledigen.

5. benutzerdefinierte Erweiterungen

Die Open-Source-Architektur von Lemon AI ermöglicht es den Benutzern, den Code zu ändern oder Funktionen hinzuzufügen. Entwickler können bearbeiten src Verzeichnis, um benutzerdefinierte Tools oder Module hinzuzufügen. Nachdem Sie die Änderungen vorgenommen haben, erstellen Sie den Docker-Container neu:

docker-compose build

Siehe dazu die offizielle Dokumentation (https://github.com/hexdocom/lemonai/blob/main/docs) für weitere Entwicklungsrichtlinien.

caveat

- DatenschutzAlle Aufgaben werden standardmäßig lokal ausgeführt und die Daten werden nicht in die Cloud hochgeladen. Um ein Sicherheitsproblem zu melden, senden Sie eine E-Mail an

service@hexdo.comkeine öffentlichen GitHub-Commits. - SystemanforderungenMindestens 8 GB RAM und eine 4-Kern-CPU werden empfohlen, um einen reibungslosen Betrieb zu gewährleisten.

- Update: Überprüfen Sie regelmäßig die Releases-Seite Ihres GitHub-Repositorys (

https://github.com/hexdocom/lemonai/releases) Holen Sie sich die neueste Version und Korrekturen.

Anwendungsszenario

- Einzelne Studien

Forscher nutzen Lemon AI für Dokumentationen oder Marktanalysen. Lokale Modelle verarbeiten sensible Daten und erstellen strukturierte Berichte zum Schutz der Privatsphäre. - Entwickler-Tools

Entwickler nutzen die Codegenerierungsfunktion, um schnell Skripte zu schreiben, und die Sandbox-Umgebung, um den Code zu testen, um Sicherheit und Stabilität zu gewährleisten. - Analyse von Unternehmensdaten

Unternehmen setzen Lemon AI auf lokalen Servern ein, um Vertriebs- oder Betriebsdaten zu analysieren und visuelle Diagramme zur Unterstützung der Entscheidungsfindung zu erstellen. - Pädagogische Unterstützung

Schüler nutzen Lemon AI, um ihr Lernen zu unterstützen, Codebeispiele zu generieren oder Lernmaterialien zusammenzustellen, die lokal ausgeführt werden, um persönliche Informationen zu schützen.

QA

- Benötigt Lemon AI eine Internetverbindung?

Lemon AI unterstützt den kompletten Offline-Betrieb mit lokalen Modellen und Sandbox-Umgebungen. Wenn Sie ein Cloud-Modell oder Suchfunktionen benötigen, müssen Sie online sein, um die API zu konfigurieren. - Wie kann eine sichere Codeausführung gewährleistet werden?

Die Sandbox der virtuellen Maschine von Lemon AI isoliert die Umgebung, in der der Code ausgeführt wird, und verhindert, dass er das Host-System beeinflusst. Die gesamte Ausführung findet innerhalb der Sandbox statt und schützt das Gerät. - Welche lokalen Modelle werden unterstützt?

Unterstützt DeepSeek, Qwen, Llama, Gemma, usw., die über Ollama laufen. Die Benutzer können die Modelle nach ihren Bedürfnissen auswählen. - Wie kann ich Lemon AI aktualisieren?

Besuchen Sie die Seite Releases in Ihrem GitHub-Repository, um die neueste Version herunterzuladen und den Docker-Container erneut auszuführen. Die Dokumentation enthält detaillierte Schritte für die Aktualisierung.