Veröffentlichungsregeln werden verwendet, um die Generierung von Artikelthemen (Titeln) zu automatisieren und um während der Generierungsphase der Artikel kontextbezogene Hinweise zu geben. Um die Veröffentlichungsregeln festzulegen und die Themen entsprechend den tatsächlichen Optimierungszielen der Website zu generieren, sollten sie nicht blind verwendet werden, und es wird empfohlen, sie in der Anfangsphase in kleinem Maßstab zu testen, um zu beobachten, ob die generierten Themen den Erwartungen entsprechen. Der Hauptarbeitsablauf des Plug-ins: Konfiguration der Veröffentlichungsregeln - Auswahl der Veröffentlichungsregeln, um die Hauptthemen zu generieren...

1.1 Konfigurieren Sie zunächst die API, die zur Generierung von Artikeln verwendet wird. Die in der benutzerdefinierten API-Konfiguration hinzugefügte, vorgefertigte API-Konfiguration wird verwendet, um Textinhalte wie Themen, Artikel, Artikelstruktur usw. zu generieren. 1.1 Unterstützung der Verwendung von benutzerdefinierten APIs, die mit dem OPENAI-Format kompatibel sind Vergessen Sie nicht, den Abschnitt /v1/chat/completions auszufüllen...

1. von der Erstellung einfacher Regeln zum Start Die Erstellung von Regeln für die Erstellung des Themas (Artikeltitel) vor der Erstellung von Materialien, ist der Ausgangspunkt des gesamten Artikelerstellungsprozesses. Hier verwende ich den einfachsten Regeltyp “zufällige Kategorie”, um eine Regel zu erstellen. Erläuterung der folgenden Konfiguration: zufällige Verwendung von 10 Kategorien von Namen und Beschreibungen, die zur Erstellung des Themas (Artikeltitel) verwendet werden ...

1.Betriebsrichtlinien 1.1 Mehrsprachige Auswahl Gilt nur für die mehrsprachige Auswahl von Kanälen in der Abbildung 1.2 Tipps zum Keyword Mining auf Chinesisch Es wird empfohlen, nur Google und Baidu auszuwählen Für Keywords, die eine Mischung aus Chinesisch und Englisch beinhalten, wird empfohlen, Englisch in Kleinbuchstaben zu verwenden und mehrere Wörter durch Leerzeichen zu trennen Tipps zur Keyword-Expansion: Verwenden Sie ein großes Modell, um das Basiswort zu erhalten - Verwenden Sie das Keyword-Tool ...

0. erforderlich: muss vollständig und detailliert Konfiguration der Website-Klassifizierung Klassifizierung Name, Alias (Englisch), Beschreibung, muss detailliert sein. AI Content Manager verlässt sich stark auf die Klassifizierung Name und detaillierte Beschreibung der Klassifizierung, um die Richtung der generierten Inhalte zu steuern und automatisch die entsprechende Klassifizierung auswählen. Nachdem Sie die Kategorien eingerichtet haben, klicken Sie bitte einmal auf die Schaltfläche Refresh Category Cache auf der Dashboard-Seite innerhalb des Plugins...

Dies ist AI Content Generation Manager, exklusives Thema, kann nicht direkt diese Vorlage verwenden. Nach der Aktivierung befinden sich alle zugehörigen Einstellungen in den “Theme Settings”. 1. sekundären Domain-Namen-Zugang aktivieren Was ist der Fall für die Aktivierung sekundären Domain-Namen-Zugang? Sie haben bereits eine Website, möchten das Gewicht der Hauptseite erhöhen, Besucher anziehen oder eine individuelle Suchmaschinenoptimierung durchführen. Öffnen Sie ...

Nun, zu diesem Zeitpunkt haben wir über 1000 Zeilen in unserer Markdown-Datei. Das hier ist hauptsächlich zum Spaß.

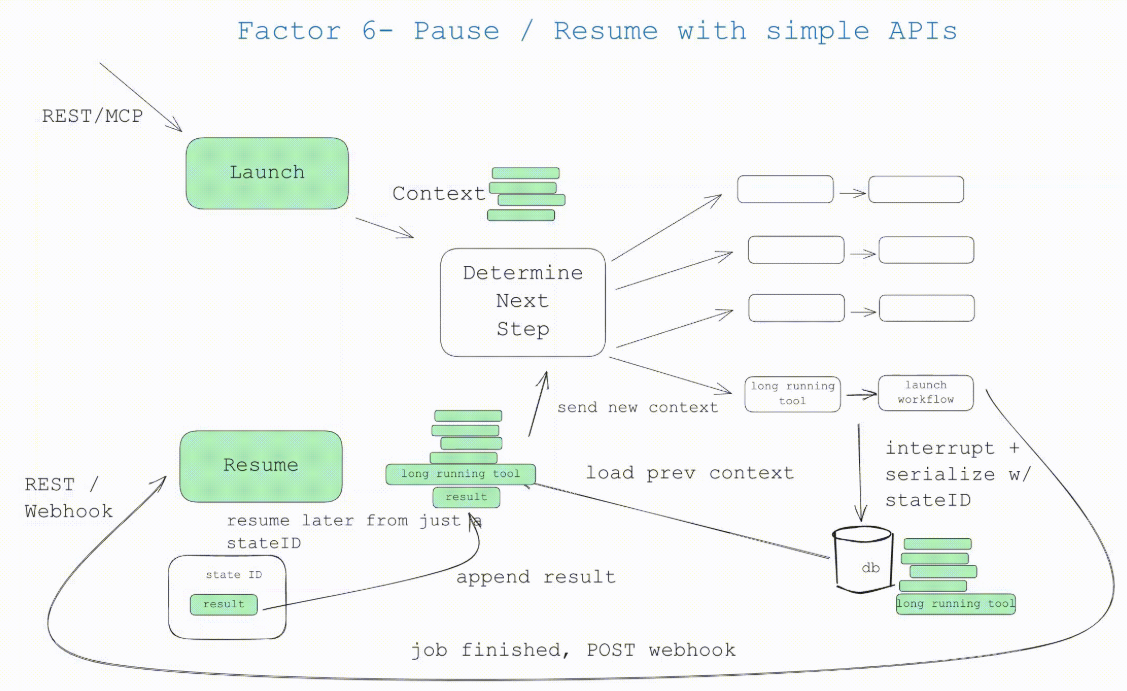

Wenn Sie auf eine Einführung in humanlayer gewartet haben, dann ist dies die richtige. Wenn Sie Element 6 - Starten/Pausieren/Fortsetzen über eine einfache API und Element 7 - Kontaktaufnahme mit Menschen über Tool-Aufrufe praktizieren, dann sind Sie bereit, dieses Element zu integrieren. Erlauben Sie dem Benutzer das Starten/Pausieren/Fortsetzen von...

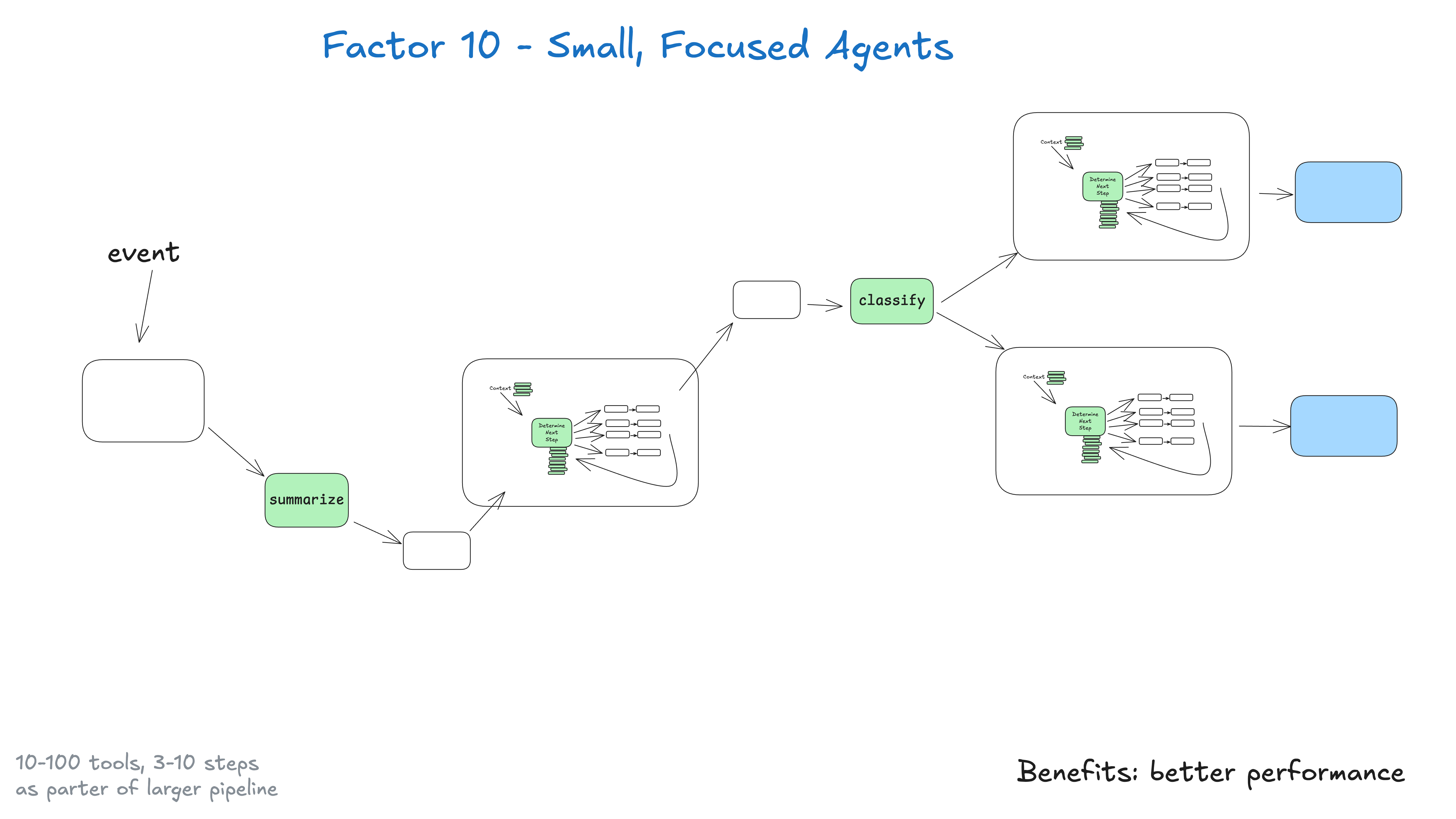

Anstatt monolithische Intelligenzen zu bauen, die versuchen, alles zu tun, ist es besser, kleine, konzentrierte Intelligenzen zu bauen, die eine Sache gut machen können. Intelligenzen sind nur ein Baustein in einem größeren, weitgehend deterministischen System. Die wichtigste Erkenntnis liegt hier in den Grenzen großer Sprachmodelle: Je größer und komplexer die Aufgabe ist, desto mehr Schritte sind erforderlich, was längere Kontextfenster bedeutet...

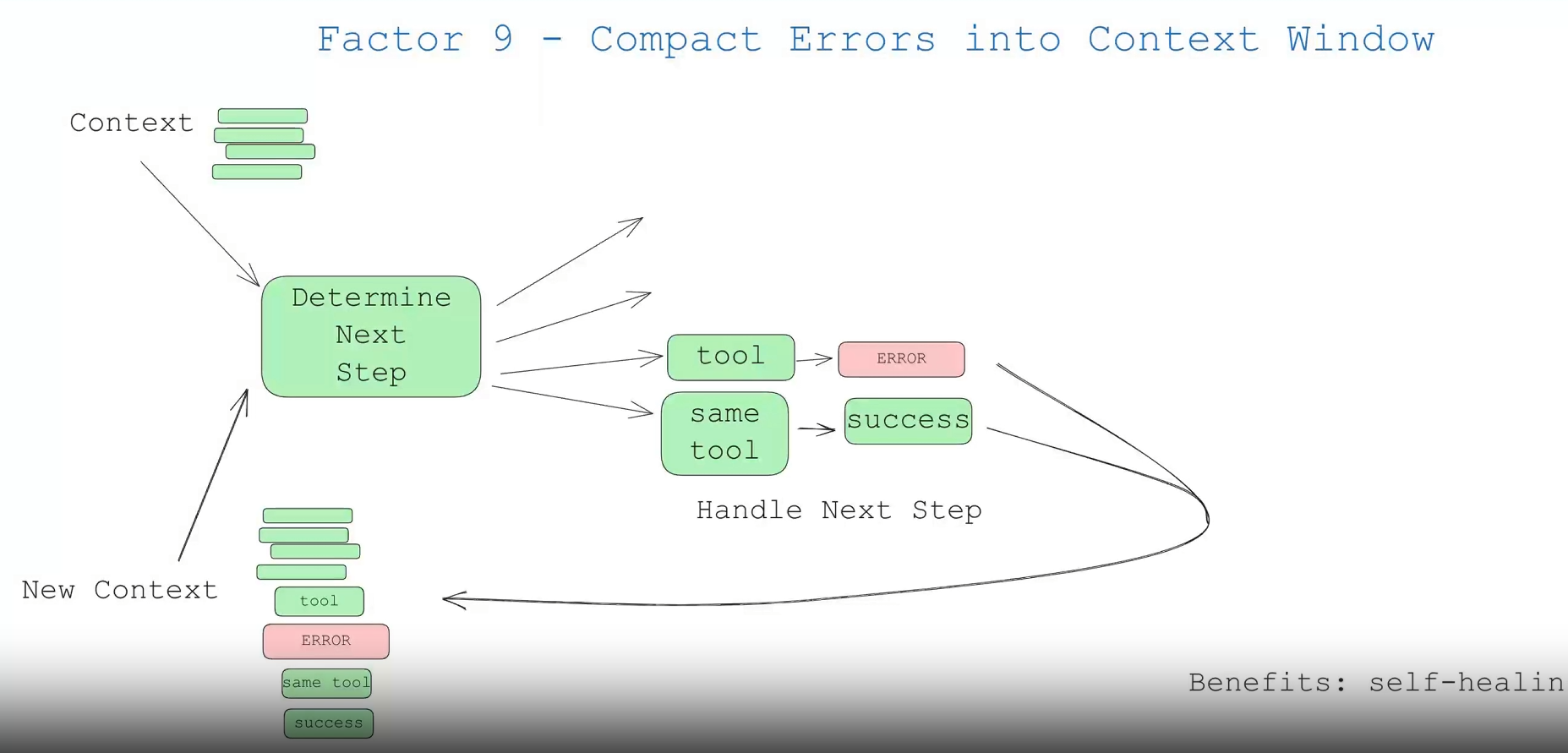

这一点内容不多,但值得一提。智能体 (agent) 的好处之一是“自我修复”——对于简短的任务,大语言模型 (LLM) 可能会调用一个失败的工具。优秀的大语言模型有很大机率能够读取错误信息或堆栈跟踪 (stack trace) ,并找出在后...

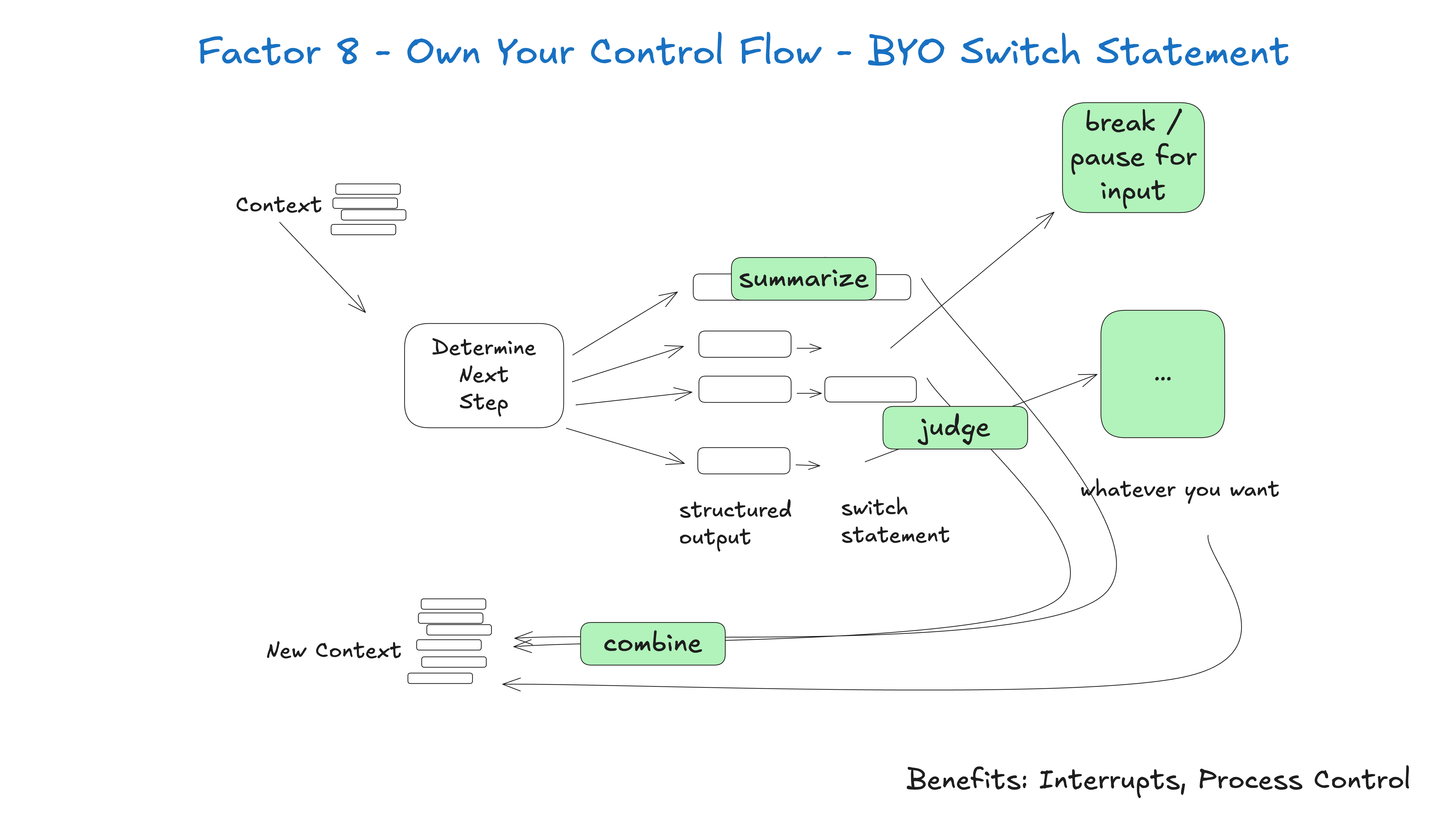

如果你能掌控自己的控制流,你就可以实现许多有趣的功能。 构建适合你特定用例的自定义控制结构。具体来说,某些类型的工具调用可能是跳出循环、等待人类响应或等待另一个长时间运行任务 (例如训练管道) 的理由。你可能还想整合以下功能的自定义实现: ...

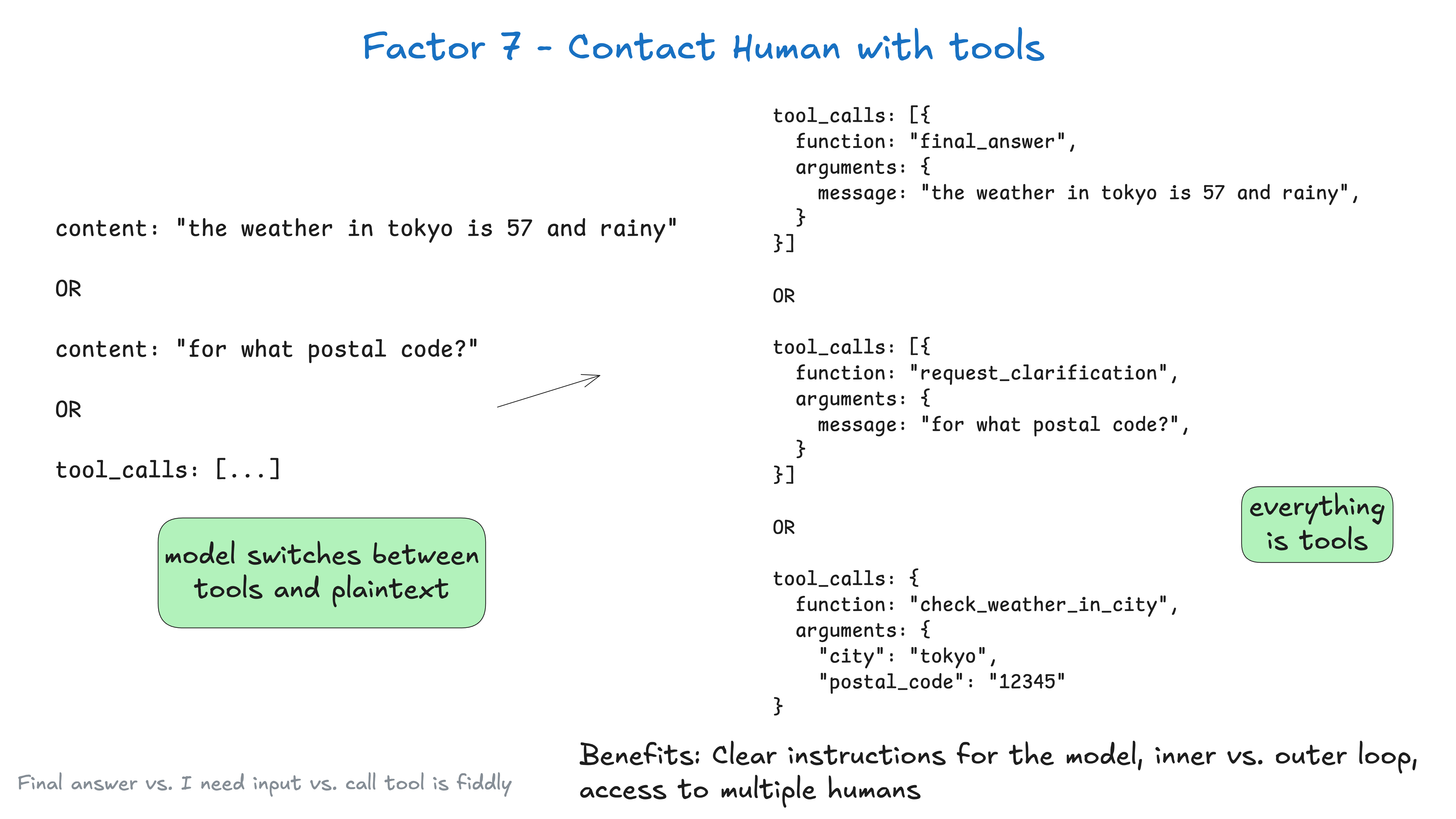

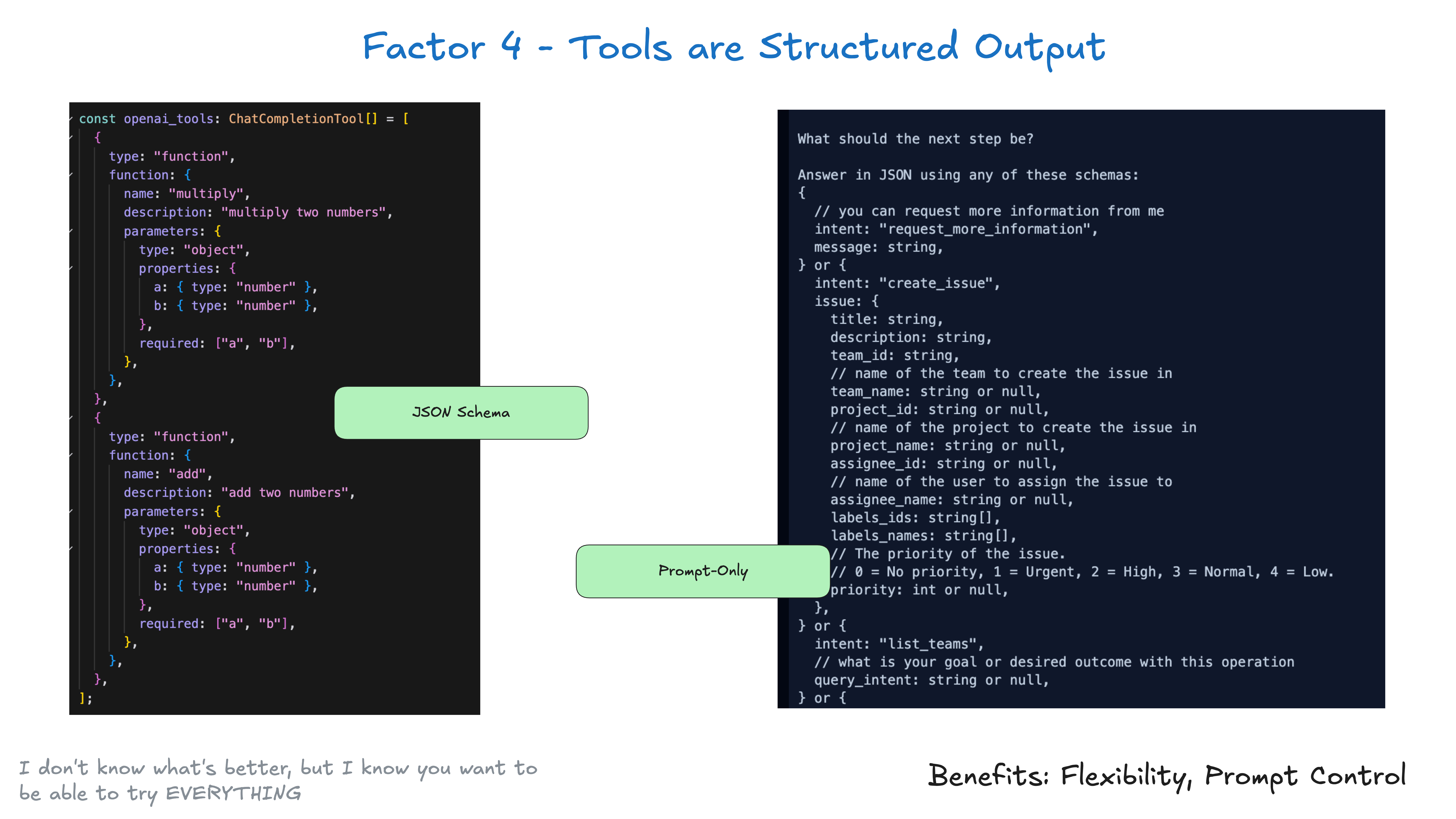

Standardmäßig beruht die API des Large Language Model (LLM) auf einer grundlegend wichtigen Token-Entscheidung: Geben wir reinen Textinhalt oder strukturierte Daten zurück? Sie legen viel Gewicht auf die erste Token-Wahl, die im Fall des Wetters in Tokio...

智能体就是程序,我们期望能以某种方式启动、查询、恢复和停止它们。 用户、应用程序、流水线以及其他智能体应该能通过简单的 API 轻松启动一个智能体。 当需要执行长时间运行的操作时,智能体及其编排确定性代码应该能够暂停该智能体。 像 webh...

即使在 AI 领域之外,许多基础设施系统也试图将“执行状态”与“业务状态”分开。对于 AI 应用,这可能涉及复杂的抽象来跟踪当前步骤、下一步、等待状态、重试次数等信息。这种分离会带来复杂性,虽然可能物有所值,但对你的用例来说可能有些小题大做...

Das Werkzeug muss nicht komplex sein. Im Kern handelt es sich einfach um strukturierte Ausgaben Ihres Large Language Model (LLM), die zum Auslösen von deterministischem Code verwendet werden. Angenommen, Sie haben zwei Werkzeuge CreateIssue und SearchIssues. Ein Large Language Model (LLM) zu bitten, "eines von mehreren Werkzeugen zu verwenden", bedeutet in Wirklichkeit, es zu bitten, eine Ausgabe zu machen...

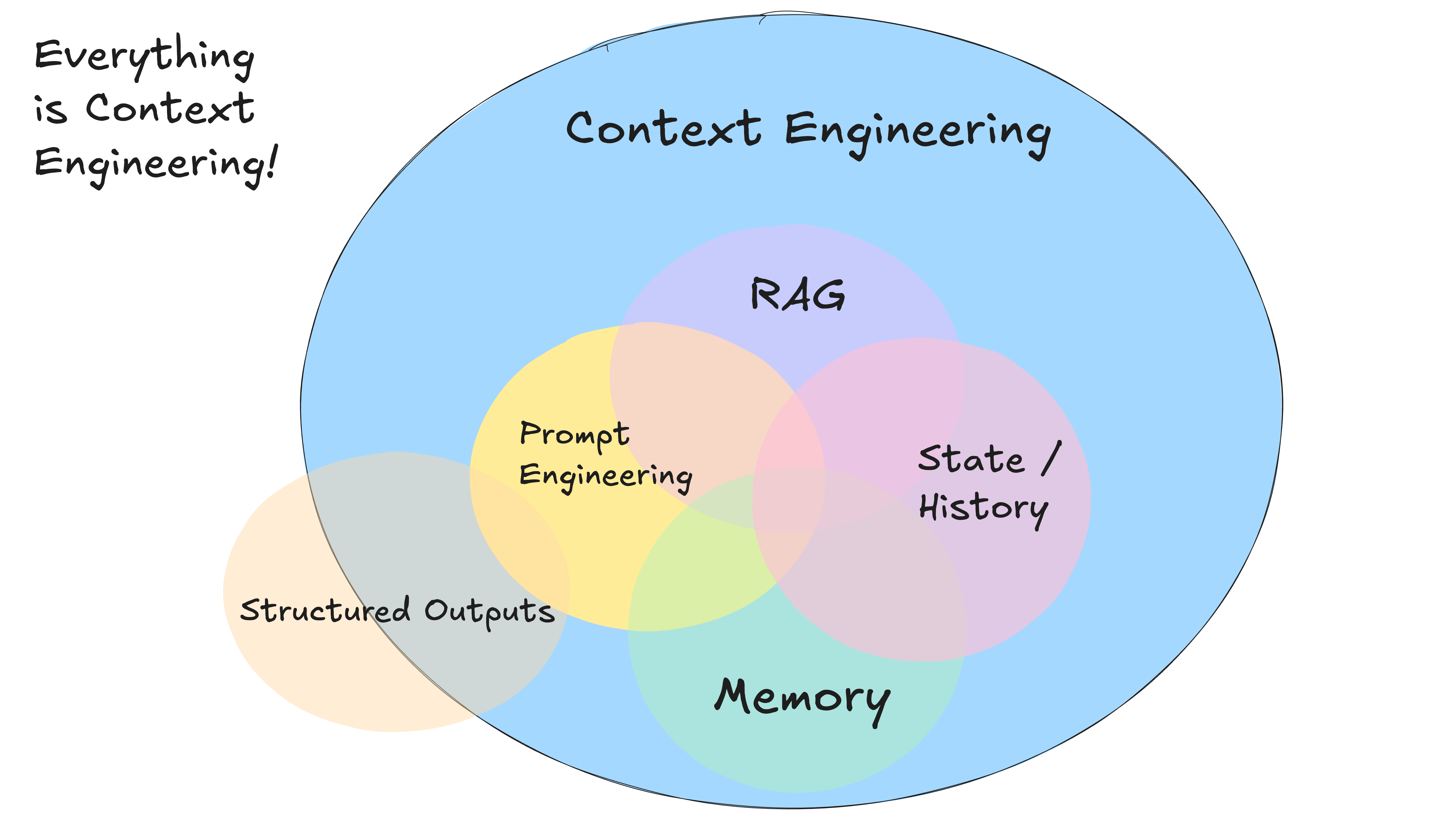

你并非必须使用标准化的、基于消息的格式来向大语言模型传递上下文。 在任何给定时刻,你给 AI 智能体中的大语言模型的输入都是“这是目前为止发生的所有事情,下一步该怎么做” 一切皆是上下文工程。 大语言模型是无状态函数,它们将输入转化为输出。...

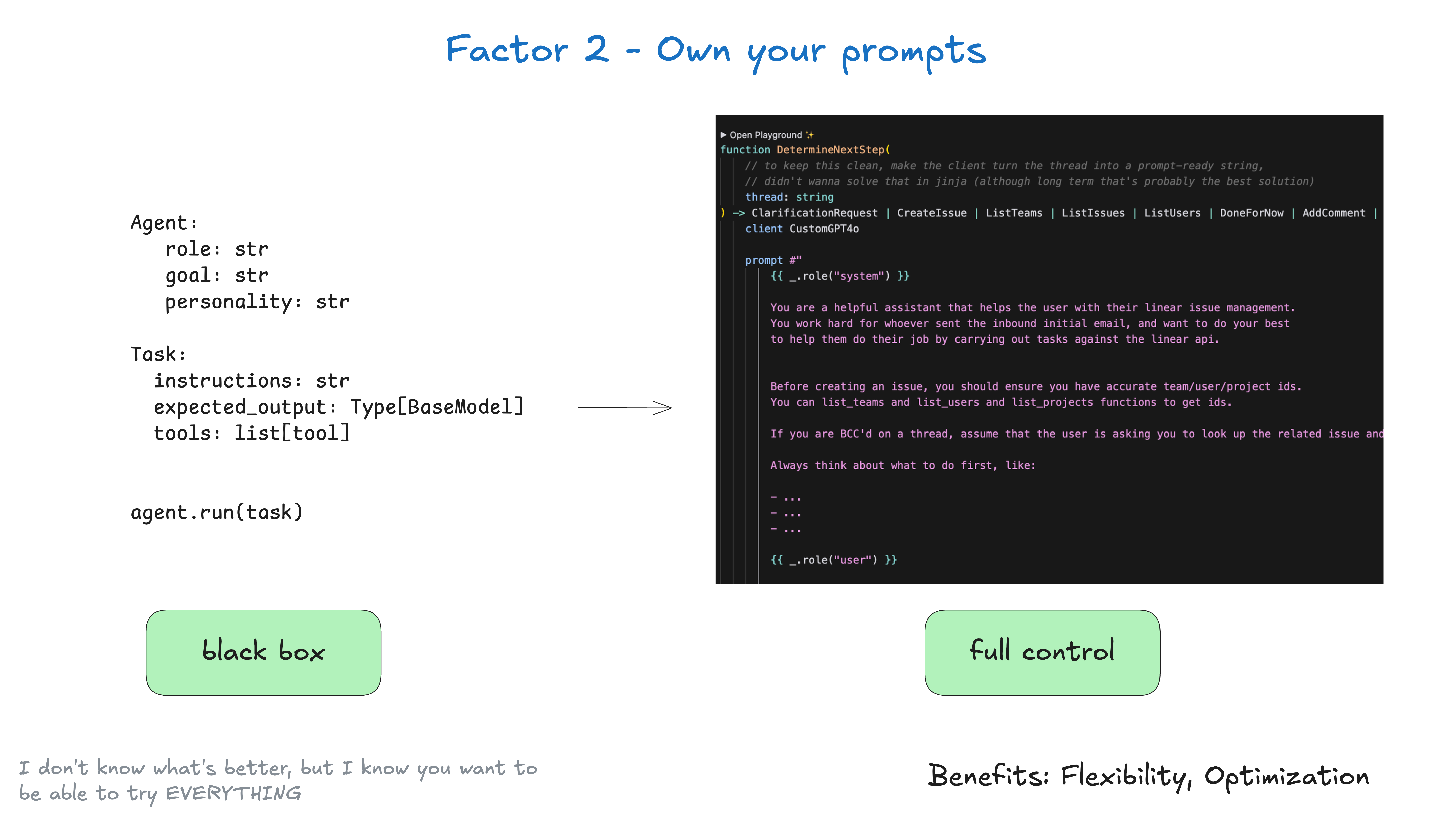

Lagern Sie die Entwicklung Ihrer Eingabeaufforderung nicht an ein Framework aus. Übrigens ist dies kein neuer Ratschlag: Einige Frameworks bieten einen "Blackbox"-Ansatz wie diesen: agent = Agent( role="..." , goal="..." , personality="..." , tools=...

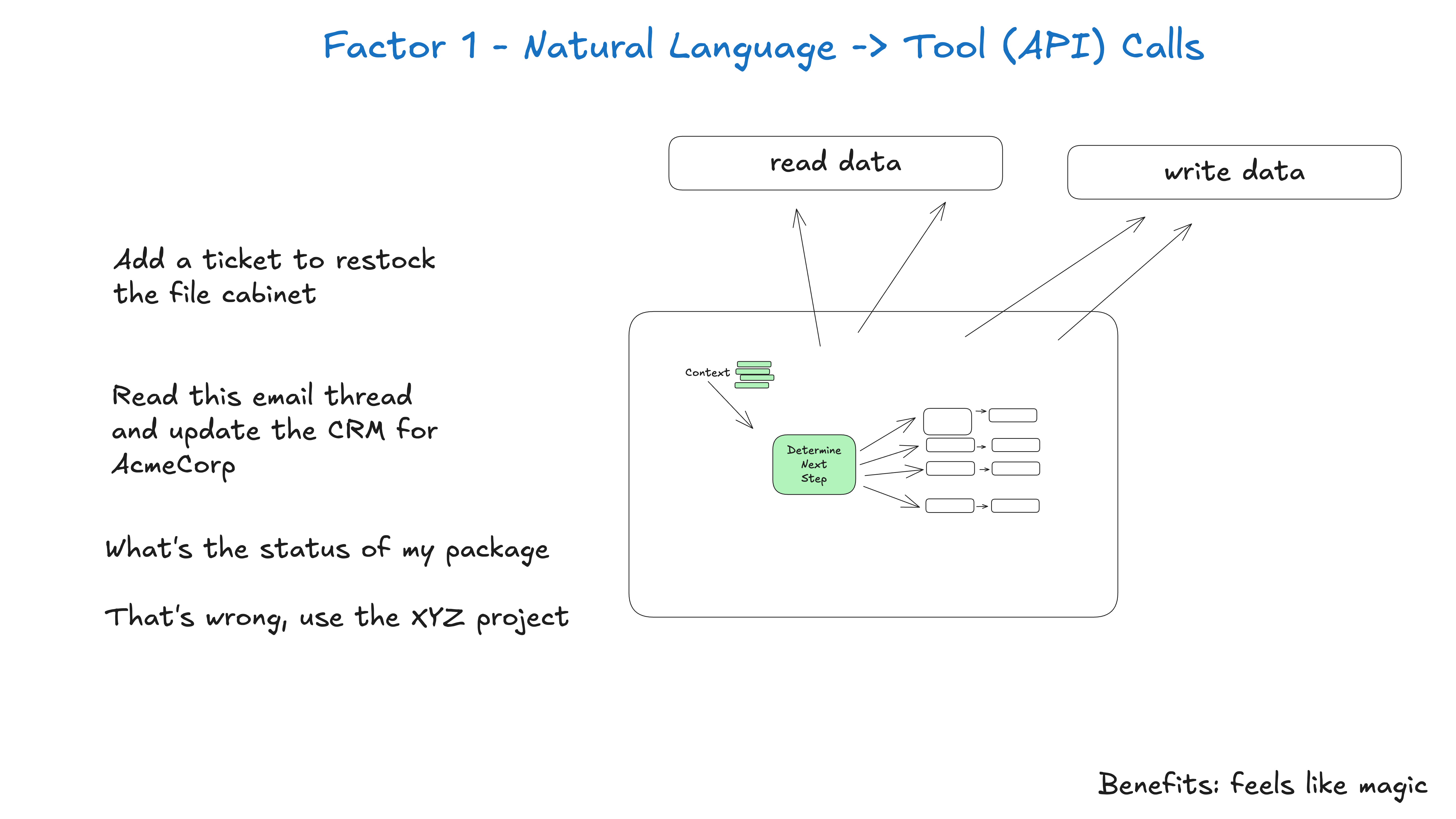

在构建智能体时,最常见的模式之一就是将自然语言转换为结构化的工具调用。这是一个强大的模式,它允许您构建能够对任务进行推理并执行它们的智能体。 这个模式在原子化应用时,就是将一个短语 (例如) 你能为 Terri 创建一个 750 美元的支付...

详细版:我们是如何走到这一步的 你不必听我的 无论你是刚接触智能体的新手,还是像我一样脾气古怪的资深人士,我都会试着说服你,抛弃你对 AI 智能体的大部分既有看法,退一步,从第一性原理重新思考它们。 (如果你几周前错过了 OpenAI 的 ...

zurück zum Anfang