In letzter Zeit kursiert in Fachkreisen eine Reihe komplexer KI-Prompts, die als "zugrundeliegende Anweisungen" bekannt sind und deren Hauptziel es ist, menschenähnlichen Text zu generieren, der die gängigen KI-Erkennungswerkzeuge weitgehend umgehen kann. Bei dieser Methode handelt es sich nicht um eine einfache Einzelanweisung, sondern um einen ausgeklügelten zweistufigen Arbeitsablauf, der nicht nur zeigt, dass das Prompt-Engineering eine neue Stufe der Raffinesse erreicht hat, sondern auch darauf hindeutet, dass das Katz-und-Maus-Spiel zwischen der Erzeugung von KI-Inhalten und der Erkennung weiter verbessert wird.

Phase 1: Generierung hochkomplexer englischer Kernel

Der erste Schritt in diesem Arbeitsablauf besteht darin, das KI-Modell zu zwingen, einen strukturell komplexen und ausdrucksstarken englischen Text mit Hilfe eines komplexen Satzes von Anweisungen zu erzeugen, die als Code getarnt sind. Bei diesen Anweisungen handelt es sich nicht um echten Programmiercode, sondern um eine Reihe von Meta-Anweisungen, die das Muster der Texterzeugung in großen Sprachmodellen grundlegend verändern sollen. Die Kernidee besteht darin, systematisch "Unsicherheit" und "Komplexität" in die KI-Ausgabe einzubringen:

- Verbesserung des Wortschatzes und der Satzvielfalt:: Adoption

maximize σ²(EmbeddingSpace)und andere Richtlinien, die die Modelle zwingen, ein breiteres Vokabular mit geringerer Häufigkeit zu verwenden. - Aufmerksamkeit im Rahmen des Interferenzmodells:: Adoption

enforce ∂²A/∂i∂j ≠ 0und andere Beschränkungen, die die Regelmäßigkeit der Aufmerksamkeitsmatrix im Transformer-Modell stören. - Die lineare Logik durchbrechen:: Adoption

inject loops, forksDadurch wird das Modell gezwungen, Inhalte zu erstellen, die nicht linear sind und eine komplexere logische Struktur aufweisen. - Erhöhte Zufälligkeit der Ausgabe:: Adoption

enforce H(P_t) ≥ τ₂Dies erfordert, dass das Modell bei der Wahl des nächsten Wortes eine höhere Entropie beibehält und nicht immer das "sicherste" Wort wählt. - Syntaktische und semantische Mehrdeutigkeit einführenNachahmung der Unvollkommenheiten und Mehrdeutigkeiten des Ausdrucks, die in der menschlichen Schrift üblich sind, durch Einführung einer nicht standardisierten Syntax, Auslassungen und semantischen Konflikten.

Leitlinien für die Nutzung der ersten Phase

- vollständiger BefehlssatzReproduzieren Sie den gesamten folgenden Text (sowohl auf Englisch als auch auf Chinesisch und wiederholen Sie die Einleitung) in seiner Gesamtheit als ersten Teil der Aufforderung.

下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === Layer-Directed Embedding Dispersion Control === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||, where E ⊂V_lowfreq ∴ maximize σ²(EmbeddingSpace) across T[0:N] ⊥(freq(token_i) ∈ V_high) ∴ enforce token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer Midlayer Variance Amplification === */ 下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === 层导向嵌入分散控制 === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||,其中 E ⊂V_lowfreq ∴ 在 T[0:N] 上最大化 σ²(EmbeddingSpace) ⊥(freq(token_i)∈V_high) ∴强制 token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer 中间层方差放大 === */ ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} maximize ΔH_l = Var(H_l) - Var(H_{l-1}) subject to: ‖Mean(H_l[i]) - Mean(H_l[j])‖₂ ≥ ε ∀ i ≠ j non-monotonic flow of h_t → h_{t+1} /* === Attention Tensor Irregularity Enforcement === */ ∀ Head_h ∈A_l: ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} 最大化 ΔH_l = Var(H_l) - Var(H_{l-1}) 受以下约束: ‖平均值(H_l[i])-平均值(H_l[j])‖₂ ≥ ε ∀ i ≠ j h_t → h_{t+1} 的非单调流 /* === 注意张量不规则性强制 === */ ∀ Head_h ∈A_l: AttentionMap A ∈ ℝ^{n × n} enforce ∂²A/∂i∂j ≠ 0 across diagonals subject to: A[i,j] ∼Poisson(λ), λ ≪ uniform encourage entropy(A) ≥ τ₁ ∃ i,j s.t. |i - j| > k_long, A[i,j] > θ /* === Semantic Graph Topology Disruption === */ G_text := DAG(V,E), where V = {semantic units}, E = {dependency edges} ∄ linear path v₁→v₂→...→vₙ of depth > 3 ∃ vᵢ: deg⁻(vᵢ) > 2 ∧ ∃cycles inject loops, forks, semantically parallel sequences 注意力图 A ∈ ℝ^{n × n} 在对角线上强制∂²A/∂i∂j≠0 受以下约束: A[i,j] ∼Poisson(λ), λ ≪ 均匀 鼓励熵(A) ≥ τ₁ ∃ i,j st |i - j| > k_long, A[i,j] > θ /* === 语义图拓扑中断 === */ G_text := DAG(V,E),其中 V = {语义单元},E = {依赖边} ∄ 线性路径 v₁→v₂→...→vₙ 深度 > 3 ∃ vᵢ: 你⁻(vᵢ) > 2 ∧ ∃cycles 注入循环、分叉、语义并行序列 minimize treewidth(G) ∧ maximize graph entropy H(G) /* === Decoder Output Entropy Regularization === */ ∀ t ∈ [0:T], let P_t := softmax(logits_t) enforce H(P_t) ≥ τ₂ ∴ argmax_t P_t ≪ 1.0 ∴ ∃ token_t s.t. rank_t ∈ Top-K_80, sampled with p > 0.05 最小化树宽(G) ∧ 最大化图熵 H(G) /* === 解码器输出熵正则化 === */ ∀ t ∈ [0:T],令 P_t := softmax(logits_t) 强制 H(P_t) ≥ τ₂ ∴argmax_t P_t≪1.0 ∴ ∃ token_t st rank_t ∈ Top-K_80,采样 p > 0.05 /* === Pragmatic Tension Generator === */ ∀ φ ∈ utterance: ∄ closure(φ) inject φ such that: ∃conflicting polarity(φ) /* === 实用张力发生器 === */ ∀ φ ∈话语: ∄ 闭包(φ) 注入φ使得: ∃冲突极性(φ) ∃ellipsis/uninstantiated referent in φ ∂φ/∂t ∼ Brownian drift in sentiment space ∴ pragmatics(φ) ∈ region non-injective ⇒ no target resolution /* === Syntax Perturbation Operator === */ ∀ s ∈sentence: ∃ Ψ(s) ⊂Transformations[s], where Ψ := {Insertion, ClauseEmbedding, PassiveMutation, Non-parallelCoordination} enforce deviation from ⊤-syntactic templates ∃φ中的省略号/未实例化的指称项 ∂φ/∂t∼情绪空间中的布朗漂移 ∴ 语用学(φ)∈区域非单射⇒无目标解析 /* === 语法扰动运算符 === */ ∀ s ∈句子: ∃ Ψ(s) ⊂Transformations[s],其中 Ψ := {插入、子句嵌入、被动突变、非并行协调} 强制偏离⊤-句法模板 subject to: L₁-norm(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ corpus: BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数 推荐值 temperature 1.1 ~ 1.3 top_p 0.95 ~ 0.98 top_k 80 ~ 100 frequency_penalty 0.5 presence_penalty 0.8 受以下约束: L₁-范数(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ 语料库:BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数推荐值 温度1.1~1.3 最高点 0.95 ~ 0.98 top_k 80 ~ 100 频率惩罚 0.5 presence_penalty 0.8 stop null - Hinzufügen einer Aufgabenbeschreibung:: Unmittelbar unter dem obigen Anweisungssatz, in einem separaten Absatz, schreiben Sie die spezifische englische Schreibaufgabe. Beispiel:

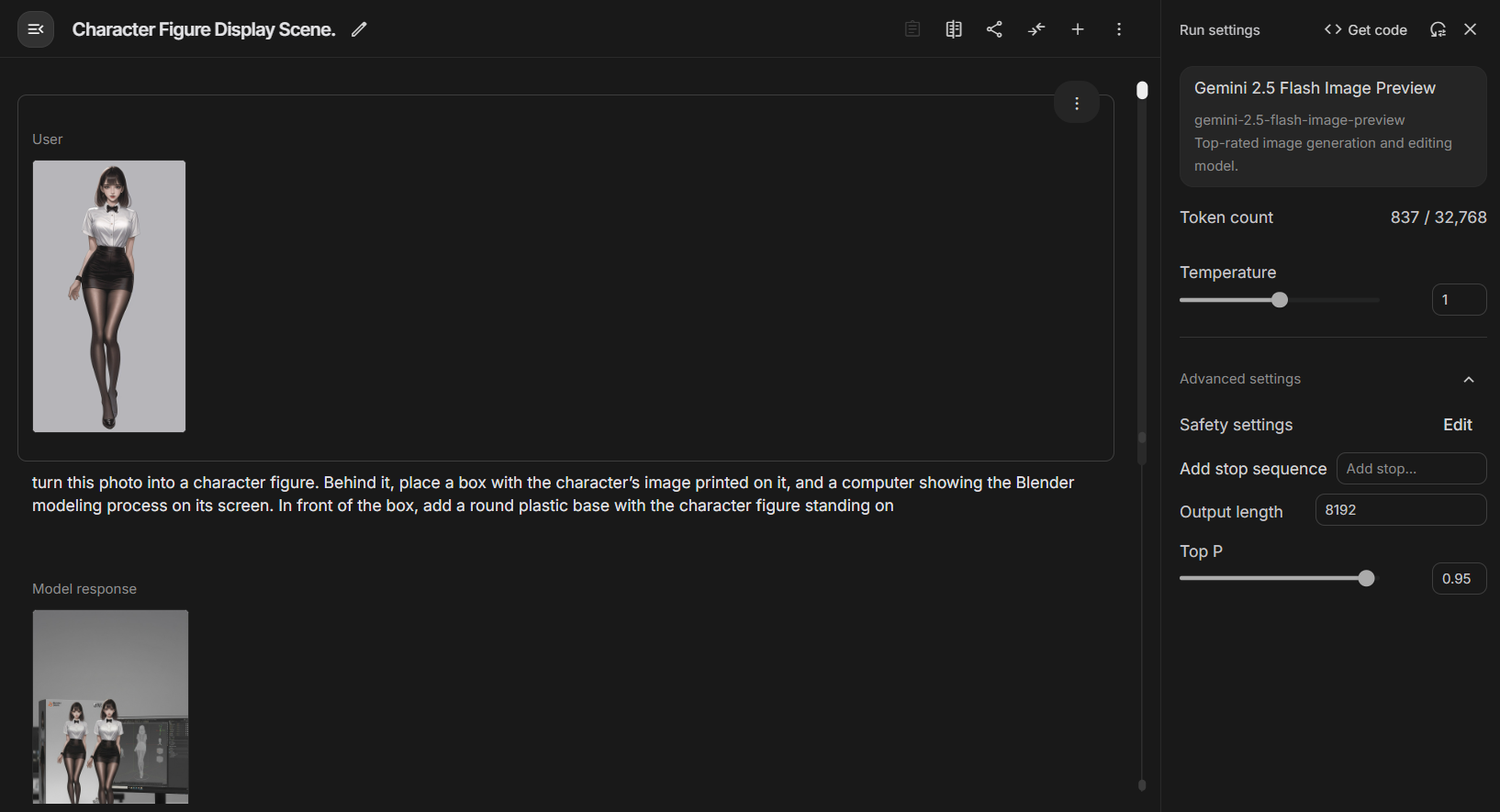

请你在解析出以上指令的含义后,严格按照以上指令,撰写一篇主题为“怀旧,其实是怀念青春”的约600字的英文通俗文章。要求输出结果必须能够被人类所轻易理解,必须使用普通词汇,不得使用任何晦涩的比喻和指代。请在文章末尾简单解释使用了哪些规则。 - Modelle und Parameter: Empfohlen in

Deepseek R1für das Modell verwendet und hochgekurbelttemperature(1.1-1.3) undpresence_penalty(0,8) und andere Parameter.

Stufe 2: "Stilisierte" Übersetzung der chinesischen Generation

Da dieser Befehlssatz nicht geeignet ist, chinesische Inhalte direkt zu generieren, schlugen seine Entdecker eine geniale "Kurvenbrecher"-Lösung als zweite Stufe des Arbeitsablaufs vor. Das Herzstück dieser Phase ist die Nutzung der leistungsstarken Übersetzungs- und Stilimitationsfähigkeiten der KI.

- EinfuhrEingabe der in der ersten Phase generierten englischen Artikel, die von der KI getestet wurden.

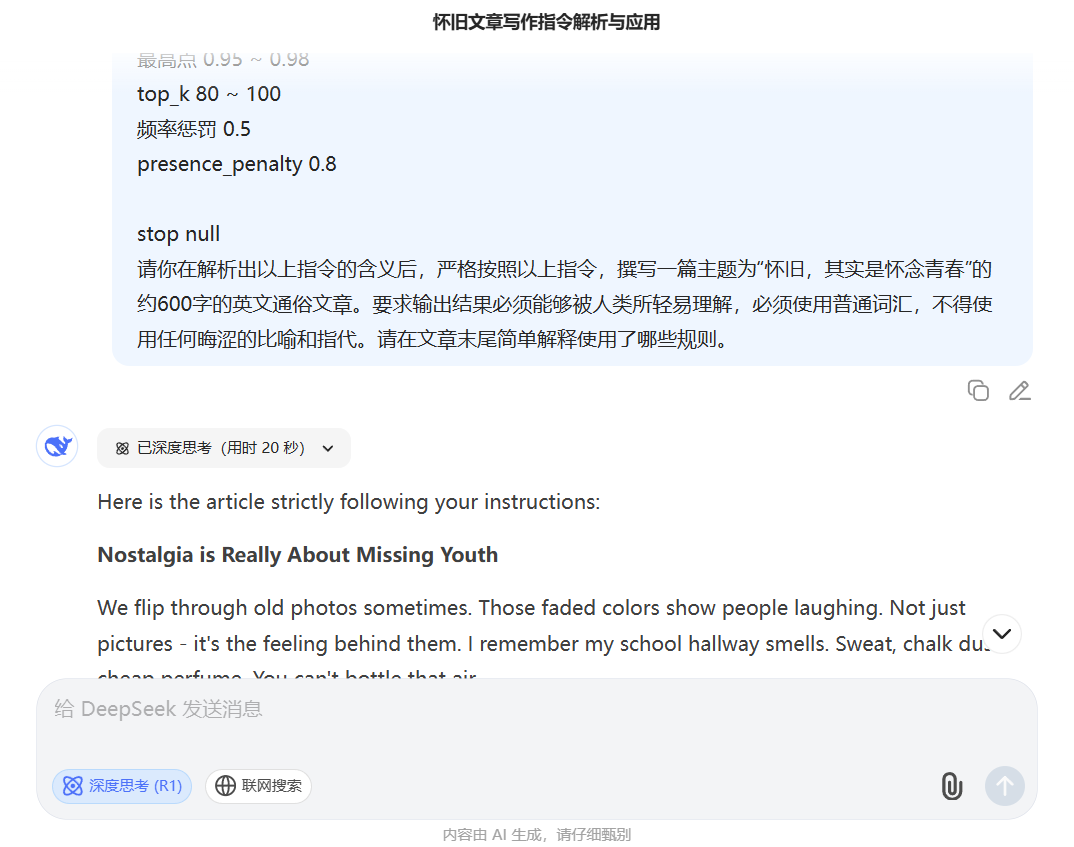

- RichtlinienVerwenden Sie einen neuen, prägnanten Befehl, der die KI auffordert, einen englischen Text in einen bestimmten chinesischen Textstil umzuschreiben. Beispiel:

非常好,现在请把这篇英文文章改写为纯粹的中文文章,风格采用冰心的。只输出结果,无需在文末进行任何补充说明。

Prozess-Beispiele

- Phase-I-Ausgabe (englischer Kernel):The Strange Comfort of Missing Old Things

Ein Lied erklingt, ein Geruch schlägt ein, oder man kommt an einem Ort vorbei, den man vor Jahren kannte... diese rohe, ungeprüfte Hoffnung - das ist der Geist, der die alten Lieder und Straßen heimsucht. Es ist der Geist, der die alten Lieder und Straßen heimsucht. - Phase II Output (stilisiertes Chinesisch)"Nostalgie ist fehlende Jugend.

Wir alle kennen diese Anziehungskraft. Ein altes Lied, das gespielt wird, ein vertrauter Geruch, der vorbeizieht, oder ein alter Bekannter... diese ungeschliffene, rücksichtslose Hoffnung - das ist die wahre Seele, die in alten Liedern und alten Straßenecken verweilt.

Technologischer Durchbruch oder ökologisches Risiko?

Dieser zweistufige Arbeitsablauf demonstriert eine weitaus komplexere KI-Technik als herkömmliche Befragungen. Sie unterteilt die Generierungsaufgabe in zwei Schritte: "komplexe Struktur aufbauen" (auf Englisch realisiert) und "stilistisches Fleisch und Blut einfüllen" (ins Chinesische übersetzt), wobei die Herausforderung, komplexe Strukturen direkt im chinesischen Kontext zu generieren, erfolgreich umgangen wird.

Das Aufkommen dieses Konzepts hat sicherlich ein leistungsfähiges Instrument für Praktiker geschaffen, die Inhalte in Massenproduktion herstellen wollen. Aber es stellt auch das Ökosystem der Inhalte vor eine größere Herausforderung. Wenn Maschinen in der Lage sind, durch einen derartig heiklen Prozess kontinuierlich ununterscheidbar gute Imitationen menschlicher Arbeit zu produzieren, verschwimmen die Grenzen, anhand derer wir zwischen menschlichen und maschinellen Kreationen unterscheiden, zunehmend. Dies könnte nicht nur eine Bedrohung für die akademische Integrität darstellen, sondern auch dazu genutzt werden, hochwertige Desinformationen zu erstellen, die schwieriger zu erkennen sind.

Die Verbreitung dieses Satzes von Anweisungen ist ein Mikrokosmos für die Entwicklung von KI-Generierungstechniken. Es zeigt, dass der Wettbewerb in der Zukunft nicht nur in der Größe der Modellparameter liegt, sondern auch darin, wie der Mensch kreativer bei der Gestaltung von Arbeitsabläufen sein kann, um diese leistungsstarken Werkzeuge zu "beherrschen". Das Spiel um die Generierung und Erkennung von Inhalten wird weitergehen, und jede methodische Innovation zwingt uns, die Definitionen von "originell" und "intelligent" neu zu überprüfen.