Wenn der Chefwissenschaftler von Google Jeff Dean und Vizepräsident für KI-Infrastruktur Amin Vahdat Als die Mitunterzeichner einen technischen Bericht veröffentlichten, fand die gesamte Branche Gehör. Die Kernbotschaft des Berichts war in einer sehr kommunikativen Metapher verpackt: Die Verarbeitung eines Gemini modelliert Textanweisungen, die weniger Energie verbrauchen als 9 Sekunden Fernsehen.

Diese Analogie ist anschaulich und nachvollziehbar und stellt die Kosten einer einzigen KI-Interaktion geschickt als unbedeutend dar. Diese mikroskopische Perspektive, die von den Branchenführern selbst befürwortet wird, täuscht jedoch über den schwindelerregenden Energiebedarf der KI-Technologie im globalen Maßstab hinweg. Multipliziert man den winzigen Einzelverbrauch mit der astronomischen Zahl der täglichen Abfragen, ergibt sich ein ganz anderes Bild.

Warum "Median"? Eine Entscheidung zwischen Ehrlichkeit und Voreingenommenheit

Bevor wir eintauchen, ist es wichtig zu verstehen, warum Google die "mittlere Textabfrage" als zentrale Kennzahl gewählt hat. Bei jeder Nutzerinteraktion mit KI, von einfachen Fragen wie "Wie oft ist 2+2 gleich?" bis hin zu einer komplexen Aufgabe, die das Verfassen von Tausenden von Wörtern eines Papiers erfordert, variiert der Energieverbrauch dramatisch.

Wenn Durchschnittswerte verwendet werden, kann eine kleine Anzahl extrem komplexer Abfragen den Gesamtwert dramatisch aufblähen und damit die wahren Kosten der täglichen Nutzung für den durchschnittlichen Nutzer verzerren. Im Gegensatz dazu eliminiert der Median die Ausreißer an beiden Enden des Spektrums und ist repräsentativer für den Energieverbrauch einer typischen Abfrage. In dem Bericht wird geschätzt, dass ein Median Gemini Verbrauch von Textabfragen 0,24 Watt-Stunden (Wh) Energie, stoßen 0,03 Gramm CO2 aus und verbrauchen 0,26 Milliliter Wasser. Google betont, dass dies das erste Mal ist, dass ein großes Technologieunternehmen in der Branche die Kosten für die Verwendung eines großen Sprachmodells so detailliert veröffentlicht hat.

Googles "Full-Stack-Algorithmen": mehr als nur rechnerisches Rohmaterial

Ein weiteres Highlight des Berichts ist der "Full-Stack"-Messansatz. Google behauptet, dass viele öffentliche Schätzungen nur KI-Beschleuniger zählen (wie z. B. die TPU 或 GPU) bei aktiver Datenverarbeitung, wodurch die tatsächlichen Kosten stark unterschätzt werden.

Um eine Analogie zu verwenden, ist dieser optimistische Algorithmus vergleichbar mit der Berechnung der Kosten einer Pizza, bei der nur das Mehl und die Tomaten gezählt werden.

Und der "Full-Stack-Algorithmus" von Google berücksichtigt alle Kosten:

- Stromverbrauch des gesamten SystemsDazu gehören nicht nur die KI-Chips, sondern auch die Host-Server, CPUs und Speicher, die ihren Betrieb unterstützen.

- Systeme im Leerlauf und im Standby-ModusEnergie, die von Servern im Standby-Modus verbraucht wird, die zur Bewältigung von Verkehrsspitzen abgestellt sind.

- Gemeinkosten des Rechenzentrums: Messung der Energieeffizienz

PUE(Power Usage Efficiency), einschließlich aller zusätzlichen Verbräuche von Kühlsystemen, Stromverteilung usw. Google behauptet, dass seine Rechenzentrumsflotte eine durchschnittlichePUEMit 1,09 liegt sie auf einem branchenführenden Niveau.

Bei diesem umfassenderen Algorithmus wird dieGemini für eine einzige Abfrage 0,24 Wattstunden Energie verbraucht. Google gibt zu, dass diese Zahl leicht auf 0,10 Wattstunden gesenkt werden könnte, wenn es den engen Ansatz der Industrie übernehmen würde, nur den Stromverbrauch der Chips zu zählen. [3] Dieser Schritt ist sicherlich ein Versuch, mit der Transparenz und Ehrlichkeit seiner Daten zu prahlen und gleichzeitig Druck auf seine Konkurrenten auszuüben.

Hinter dem Effizienzsprung

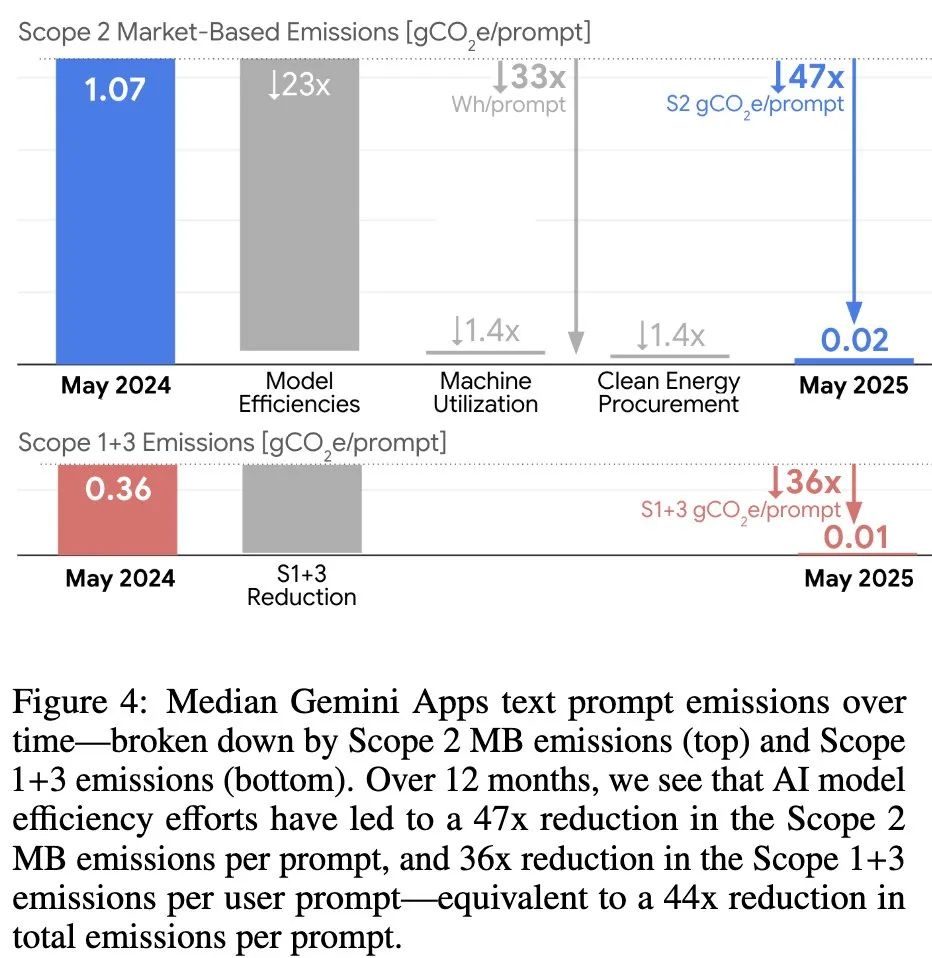

Der Bericht hebt außerdem hervor Gemini Erstaunliche Effizienzsteigerungen im letzten Jahr: geringerer Energieverbrauch pro Anfrage bei gleichzeitig höherer Antwortqualität 33 MalKohlenstoff-Fußabdruck reduziert 44 Mal。

Dieser Sprung ist kein Durchbruch in einer einzelnen Technologie, sondern das Ergebnis einer "Full-Stack-Optimierungsstrategie", die alle Aspekte von der Modellarchitektur bis zur Hardware umfasst:

- Effiziente Modellarchitektur: Adoption

Mixture-of-Experts (MoE)Architekturen wie diese ermöglichen es dem Modell, nur den Teil des "Experten"-Netzes zu aktivieren, der für die Bearbeitung einer Anfrage erforderlich ist, wodurch sich der Berechnungsaufwand um den Faktor 10 bis 100 verringert. - Optimierte Algorithmen: durch die Quantifizierung (

Quantization) und Destillation (Distillation) und andere Techniken, um kleinere, schnellere Versionen des Modells zu erstellen, ohne dass die Qualität zu sehr darunter leidet. - intelligentes vernetztes SystemVerwertung

speculative decoding(spekulative Dekodierung) und andere Techniken, die es kleinen Modellen ermöglichen, zuerst Vorhersagen zu treffen, die dann schnell von großen Modellen überprüft werden, was die Effizienz der Antwort drastisch verbessert. - Maßgeschneiderte Hardware: Googles selbstentwickeltes

TPU(Tensor Processing Unit) Sie wurde von Grund auf für KI-Operationen optimiert und erreicht eine sehr hohe Energieeffizienz.

Fairerweise muss man sagen, dass Google Anerkennung für seine technischen Errungenschaften bei der Senkung der Kosten für eine einzige KI-Abfrage verdient. Ein Blick über die "9 Sekunden" einer einzelnen Abfrage hinaus ergibt jedoch ein ganz anderes Bild.

Makroperspektive: Wenn sich "9 Sekunden" zu "285 Jahren" summieren

Die Analogie des "9-Sekunden-Fernsehens" ist klug, weil sie den menschlichen Sinn für geringe Kosten ausnutzt. Aber der eigentliche Test ist der Umfang.

Derzeit gibt es keine Informationen über Gemini Es gibt keine offiziellen Zahlen für die Anzahl der weltweiten täglichen Abfragen, aber die Schätzungen der Branche reichen von konservativen 28 Millionen bis zu optimistischen 1 Milliarde. Wir können auch jede dieser beiden Zahlen für unsere Berechnungen verwenden.

Szenario 1: 1 Milliarde Abfragen (optimistische Schätzung)

- Täglicher Gesamtenergieverbrauch1 Milliarde Zyklen × 0,24 Wattstunden pro Zyklus = 240 Millionen Wattstunden, oder 240.000 Kilowattstunden (kWh).

- Was bedeutet das?Ein durchschnittlicher indischer Haushalt verbraucht etwa 3 kWh Strom pro Tag. Das bedeutet, dass

GeminiDer Energieverbrauch eines Tages reicht aus, um die Achtzigtausend. Täglicher Stromverbrauch in indischen Haushalten. - Lassen Sie uns die Metapher ändern.: Es ist das Äquivalent einer Person, die schlaflos und ununterbrochen 285 Jahre TV.

Szenario 2: 28 Millionen Abfragen (konservative Schätzung)

- Täglicher Gesamtenergieverbrauch28 Millionen Mal × 0,24 Wattstunden pro Zeit = 6,72 Millionen Wattstunden oder 6.720 Kilowattstunden (kWh).

- Was bedeutet das?Trotzdem.

GeminiDas ist genug Energie für einen Tag. 2240 Indischer Haushaltsgebrauch. - Lassen Sie uns die Metapher ändern.: Es ist das Äquivalent zum Anschauen einer Folge von 8 Jahre TV.

Wie auch immer das Szenario aussehen mag, die Berechnungen zeigen, dass die Analogie, die einen einzelnen Akt trivial erscheinen lässt, wenn man ihn in den großen Maßstab der Globalisierung stellt, seine wahren Auswirkungen verblüffend sind.

Die eigentliche Herausforderung: Können die Effizienzsteigerungen mit dem explosionsartigen Anstieg der Nachfrage Schritt halten?

Mit diesem Bericht will Google beweisen, dass es das technische Problem der "Kosten pro Anfrage" gelöst und den Ball an andere weitergegeben hat. Damit wird jedoch genau das tiefere Dilemma umgangen, vor dem die Branche insgesamt steht.

Die wirkliche Herausforderung liegt längst nicht mehr in den winzigen Kosten für die Optimierung einer einzigen Abfrage. Vielmehr geht es darum, wie die exponentiell wachsende Nachfrage mit nachhaltigen Energiequellen befriedigt werden kann, wenn KI-Dienste vollständig in die Suche, E-Mail und sogar in Betriebssysteme integriert werden und das Volumen der Abfragen von Milliarden auf Hunderte von Milliarden ansteigt.

Technologische Fortschritte bringen Effizienz, aber Effizienzgewinne stimulieren eine breitere Anwendung, was zu einer Explosion der Gesamtnachfrage führt. Das ist ein klassisches "Jevons-Paradoxon". Google behauptet, dass es auf sein Rechenzentrum hinarbeitet 24/7 kohlenstofffreie Energie Ziele und setzt sich für die Ergänzung der 120% des Frischwasserverbrauchs. Weltweit jedoch, insbesondere in Regionen, in denen der Energiemix noch nicht perfekt ist, werden neue Rechenzentren das Netz immer noch stark belasten.

Während die Tech-Giganten darüber sprechen, wie KI die Welt verändern wird, wäre es für sie vielleicht angemessener, eine offene Diskussion darüber zu führen, was diese umgestaltete Welt antreiben wird.

Referenz: https://arxiv.org/abs/2508.15734