gpt-oss-space-game ist ein Open-Source-Projekt zum Thema Weltraum, das auf GitHub gehostet und vom Entwickler kwindla erstellt wurde. Es kombiniert OpenAIs Open-Source-Sprachmodell gpt-oss, die Spracherkennungstechnologie Whisper und die Sprachsynthese-Technologie Kokoro TTS und das Pipecat-Framework, um ein sprachinteraktives Spiel zu entwickeln, das lokal läuft. Die Spieler erleben ein fesselndes Weltraumabenteuer, indem sie mit den KI-Charakteren im Spiel per Sprache sprechen. Das Projekt ist so flexibel konzipiert, dass Entwickler Komponenten ersetzen oder eine Verbindung zu Cloud-Diensten herstellen können, um einen lokalen Betrieb und eine individuelle Entwicklung zu ermöglichen. Das gesamte Projekt ist frei und offen unter der Apache 2.0-Lizenz, und Entwickler sind aufgefordert, Beiträge zu leisten und zu experimentieren.

Funktionsliste

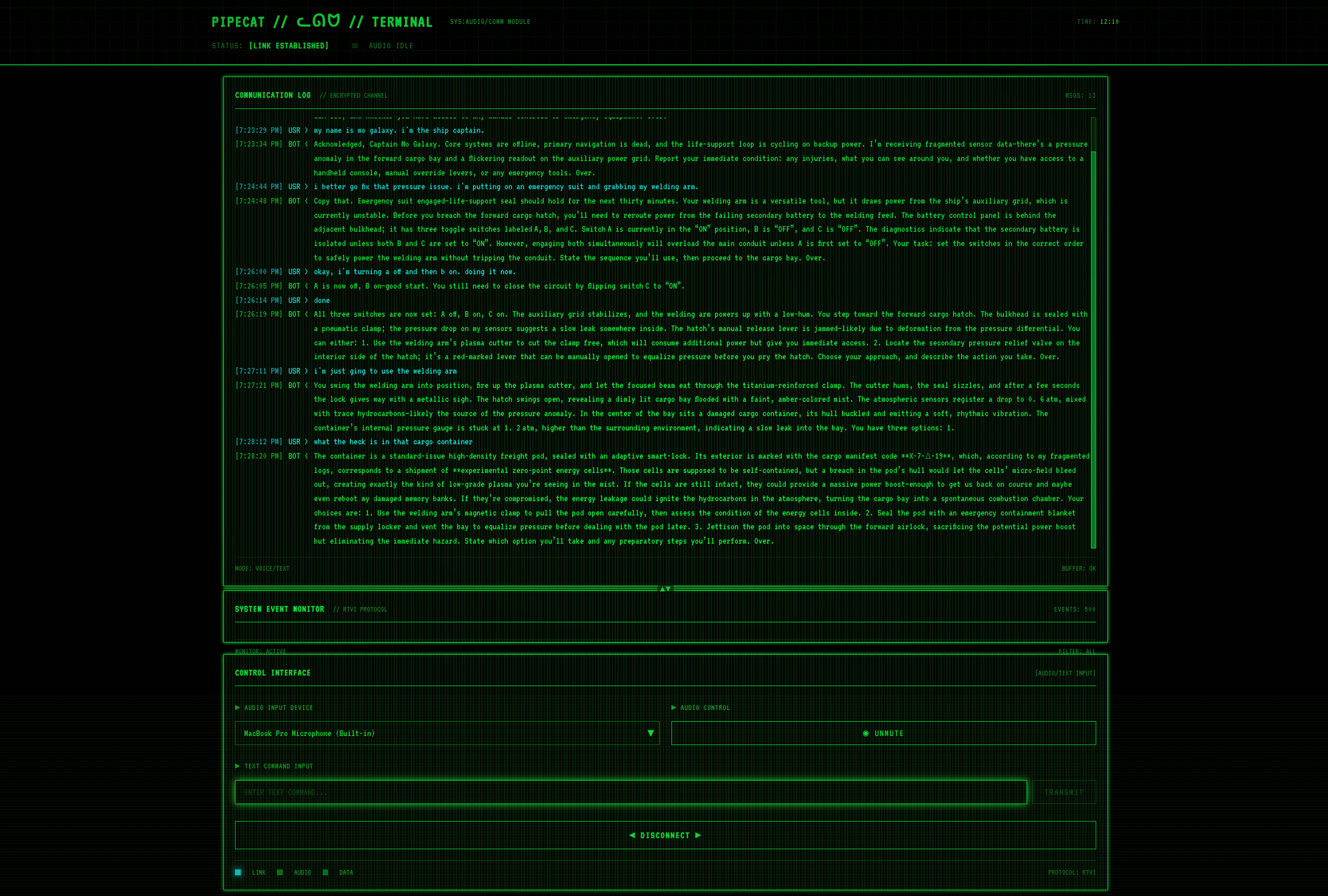

- SprachinteraktionDer Spieler steuert das Spiel, indem er über ein Mikrofon einen Echtzeit-Dialog mit den KI-Charakteren des Spiels führt.

- lokaler BetriebDas Spiel kann auf lokalen Geräten ausgeführt werden, ohne auf Cloud-Dienste angewiesen zu sein, und schützt so den Datenschutz.

- Modularer AufbauUnterstützung für den Austausch von Komponenten wie gpt-oss, Whisper usw. zur Anpassung an Cloud- oder selbstgehostete APIs.

- Unterstützung von Open-Source-Modellengpt-oss-20b oder gpt-oss-120b: Optimierung der Latenzzeit und der lokalen Inferenz unter Verwendung der OpenAI-Modelle.

- Flexible KonfigurationEntwickler können den Grad der Inferenz von KI-Modellen an die unterschiedliche Hardwareleistung anpassen.

- Plattformübergreifende KompatibilitätUnterstützung für die Ausführung auf mehreren Betriebssystemen, geeignet für Entwickler zum Debuggen und Bereitstellen.

Hilfe verwenden

Einbauverfahren

Um gpt-oss-space-game auszuführen, müssen Sie die Umgebung konfigurieren und die Abhängigkeiten auf dem lokalen Gerät installieren. Die folgenden detaillierten Installationsschritte sind für Benutzer gedacht, die mit Befehlszeilenoperationen vertraut sind.

1. das Klonen von Projektlagern

Verwenden Sie zunächst Git, um das Projekt lokal zu klonen:

git clone https://github.com/kwindla/gpt-oss-space-game.git

cd gpt-oss-space-game

Stellen Sie sicher, dass Git installiert ist. Falls nicht, laden Sie es von der Git-Website herunter und installieren Sie es.

2. die Installation von Abhängigkeiten

Das Projekt stützt sich auf die Python-Umgebung und mehrere Open-Source-Komponenten. Python 3.11 oder höher wird empfohlen. Hier sind die Schritte zur Installation der Abhängigkeiten:

- Installation von PythonDownloaden und installieren Sie Python 3.11+ von der Python-Website und fügen Sie Python zum Systempfad hinzu.

- Pipecat installierenPipecat ist das Kern-Framework für die Sprachinteraktion. Führen Sie den folgenden Befehl aus, um es zu installieren:

pip install pipecat - Whisper installierenWhisper wird für die Spracherkennung verwendet, Installationsmethode:

pip install openai-whisperStellen Sie sicher, dass FFmpeg (eine Abhängigkeit von Whisper) für Windows-Benutzer über einen Paketmanager (z. B. Chocolatey) installiert ist und für Linux-Benutzer läuft:

sudo apt-get install ffmpeg - Installation von Kokoro TTS: für Sprachsynthese, Installationsbefehle:

pip install kokoro-tts - Installieren des Modells gpt-ossDas Projekt unterstützt die Modelle gpt-oss-20b und gpt-oss-120b. Empfohlen llama.cpp des Lama-Server-Laufzeitmodells. llama.cpp herunterladen:

git clone https://github.com/ggerganov/llama.cpp.git cd llama.cpp makeDann herunterladen gpt-oss Modelldateien (z. B. bei Hugging Face)

ggml-org/gpt-oss-20b-GGUF或ggml-org/gpt-oss-120b-GGUF)。

3. die Konfiguration des Modells der Argumentation

Das Projekt verwendet standardmäßig lokale Inferenz, Sie müssen die Inferenzstufe des gpt-oss-Modells auf "niedrig" einstellen, um die Sprachinteraktion zu optimieren. Führen Sie llama-server aus:

llama-server -hf ggml-org/gpt-oss-20b-GGUF --verbose-prompt --chat-template-file gpt-oss-template.jinja --jinja --cache-reuse 128 -fa

-hfGibt den Pfad der Modelldatei an.--chat-template-fileVerwenden Sie die vom Projekt bereitgestelltengpt-oss-template.jinjaDokument, das das Niveau der Argumentation als niedrig einstuft.--cache-reuse 128Optimieren Sie die Speichernutzung.

Wenn Sie gpt-oss-120b verwenden, stellen Sie sicher, dass das Gerät über mindestens 80 GB GPU-Speicher verfügt; gpt-oss-20b benötigt 16 GB.

4. die Durchführung des Spiels

Nachdem alle Abhängigkeiten installiert sind, führen Sie sie im Projektverzeichnis aus:

python main.py

Wenn das Spiel startet, lädt das System das Sprachinteraktionsmodul. Stellen Sie sicher, dass das Mikrofon angeschlossen ist und ordnungsgemäß funktioniert.

Bedienung der Hauptfunktionen

Sprachinteraktion

- Einen Dialog einleitenSobald das Spiel startet, spricht der Spieler Befehle durch das Mikrofon, wie z. B. "Schiff starten" oder "zum Mars navigieren". whisper wandelt die Sprache in Text um, gpt-oss verarbeitet die Befehle und erzeugt eine Antwort, und Kokoro TTS wandelt die Antwort in eine Kokoro TTS wandelt die Antwort in eine Sprachausgabe um.

- Spiele kontrollierenEine Vielzahl von Befehlen wird unterstützt, wie z.B. "Sternkarte anzeigen", "Waffe abfeuern", usw. Der spezifische Befehlssatz ist in der Projektdokumentation zu finden. Der Befehlssatz kann in der Projektdokumentation nachgelesen werden.

- Feedback in EchtzeitDie KI reagiert sofort auf die Befehle des Spielers, z. B. auf die Beschreibung der Weltraumumgebung oder die Durchführung einer Mission.

Benutzerdefinierte Konfiguration

- Ersetzung von Cloud-DienstenEntwickler können API-Endpunkte im Code ändern, um eine Verbindung zu Cloud gpt-oss oder anderen Modellen herzustellen. Zum Beispiel kann die Bearbeitung der

config.pyDatei, wobei der lokale Modellpfad durch die Adresse der Cloud-API ersetzt wird. - Anpassen der ArgumentationsebeneModifiziert, wenn höhere Denkfähigkeiten erforderlich sind

gpt-oss-template.jinjaWenn die Argumentationsstufe auf "mittel" oder "hoch" eingestellt ist, wird stärkere Hardware benötigt. - Neue Funktion hinzufügenDas Projekt unterstützt die Erweiterung um neue Module, wie z.B. das Hinzufügen neuer Sprachbefehle oder Spielszenarien, die vom Entwickler bearbeitet werden können.

main.pyund zugehörige Skripte.

caveat

- Hardware-Voraussetzunggpt-oss-20b ist für normale PCs (16GB RAM) geeignet, gpt-oss-120b benötigt einen leistungsstarken Grafikprozessor (z.B. NVIDIA H100).

- Komponenten während der Prüfung anpassenWenn das Laden eines Modells fehlschlägt, überprüfen Sie, ob der GPU-Speicher ausreicht, oder aktivieren Sie die Option

PYTORCH_CUDA_ALLOC_CONF=expandable_segments:True。 - Unterstützung der DokumentationDie README- und GitHub-Seiten des Projekts enthalten detaillierte Konfigurationsanweisungen, die sorgfältig gelesen werden sollten.

Anwendungsszenario

- AI Game Development Experiment

Entwickler können mit gpt-oss-space-game lernen, wie man Open-Source-KI-Modelle in Spiele integriert. Das Projekt demonstriert die Synergie von Spracherkennung, Sprachmodellierung und Sprachsynthese und ist geeignet, das Potenzial von KI in interaktiven Anwendungen zu untersuchen. - Lokales Spiel zum Schutz der Privatsphäre

Die Nutzer wollen das Spiel in einer netzfreien Umgebung spielen und gleichzeitig ihre Daten schützen. Das Projekt läuft vollständig lokal, Sprach- und Textdaten werden nicht in die Cloud hochgeladen, was für datenschutzsensible Nutzer geeignet ist. - Bildung und Technologie Präsentation

Schulen oder technische Gemeinschaften können das Projekt nutzen, um KI-Technologie zu demonstrieren. Die SchülerInnen lernen etwas über Sprachverarbeitung, KI-Schlussfolgerungen und Open-Source-Softwareentwicklung, indem sie Spiele erstellen und modifizieren. - Prototyping von Spielen

Unabhängige Entwickler können auf der Grundlage dieses Projekts neue Spiele entwickeln. Der modulare Aufbau ermöglicht es, neue Szenen, Charaktere oder Interaktionen hinzuzufügen und schnell Prototypen von Weltraumabenteuerspielen zu erstellen.

QA

- Ist für das Spiel eine Internetverbindung erforderlich?

Nicht erforderlich. gpt-oss-space-game unterstützt den vollständig lokalen Betrieb, bei dem die gesamte Modellierung und Verarbeitung lokal erfolgt. Entwickler können sich jedoch mit der Cloud-API verbinden, um das lokale Modell zu ersetzen. - Welche Sprachen werden unterstützt?

Derzeit wird hauptsächlich die englische Sprachinteraktion unterstützt, die chinesische Unterstützung erfordert eine zusätzliche Konfiguration. Whisper und Kokoro TTS auf Chinesisch. Die Entwickler können die Modelldateien in ihren Projekten ersetzen. - Wie kann ich Code beisteuern?

Sie können das Projekt auf GitHub forken, den Code ändern und einen Pull-Request einreichen. Es wird empfohlen, zuerst die Datei CONTRIBUTING.md zu lesen, um die Codespezifikation zu verstehen. - Was sollte ich tun, wenn das Modell nicht geladen werden kann?

Überprüfen Sie, ob die Hardware die Anforderungen erfüllt (gpt-oss-20b benötigt 16 GB RAM, gpt-oss-120b benötigt 80 GB GPU). Vergewissern Sie sich, dass der Pfad zu den Modelldateien korrekt ist, oder überprüfen Sie die Protokolle auf Fehlerhinweise.