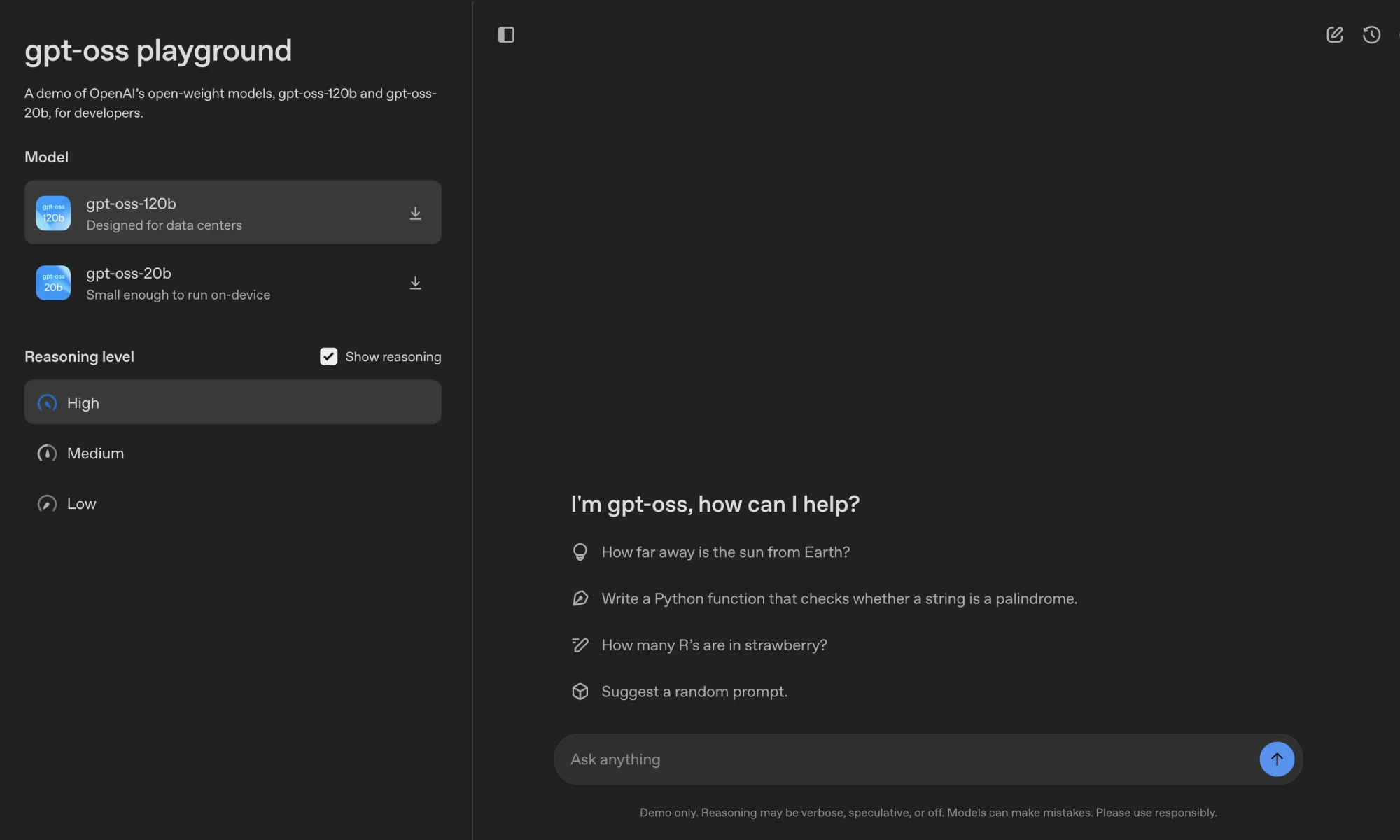

GPT-OSS ist eine Familie von Open-Source-Sprachmodellen von OpenAI, darunter gpt-oss-120b 和 gpt-oss-20bDie neueste Version der Software mit 117 Milliarden bzw. 21 Milliarden Parametern steht unter der Apache-2.0-Lizenz, die es Entwicklern erlaubt, die Software kostenlos herunterzuladen, zu verändern und einzusetzen.gpt-oss-120b Ideal für Rechenzentren oder High-End-Geräte, die auf einer einzigen Nvidia H100 GPU laufen;gpt-oss-20b Für Szenarien mit geringer Latenz läuft es auf Geräten mit 16 GB RAM. Modelle unterstützen verkettete Inferenz, Tool-Aufrufe und strukturierte Ausgaben für Smart-Body-Aufgaben und lokalisierte Anwendungen. OpenAI gewährleistet Modellsicherheit durch sicheres Training und externes Auditing und ist damit für Unternehmen, Forschung und individuelle Entwickler geeignet.

Funktionsliste

- Open-Source-Modelle herunterladen: Vorausgesetzt

gpt-oss-120b和gpt-oss-20bModellgewichte, frei verfügbar auf der Plattform Hugging Face. - Effizientes Reasoning: quantifiziert mit MXFP4.

gpt-oss-120bdie auf einer einzigen GPU laufen.gpt-oss-20bKompatibel mit Geräten mit 16 GB RAM. - logische SchlussfolgerungenUnterstützt niedrige, mittlere und hohe Inferenzstärken, und Entwickler können Leistung und Latenzzeit je nach Aufgabe anpassen.

- Werkzeug AufrufIntegration von Websuche, Python-Codeausführung und Dateimanipulationstools zur Verbesserung der Interaktivität.

- Format HarmonyDie Verwendung des proprietären Harmony-Antwortformats stellt sicher, dass die Ausgabe für eine einfache Fehlersuche strukturiert ist.

- Unterstützung mehrerer PlattformenKompatibel mit Transformers, vLLM, Ollama, LM Studio und anderen Frameworks, angepasst an eine Vielzahl von Hardware.

- SicherheitsmechanismusVerringerung der Risiken, wie z. B. die Injektion von Spitzen, durch eine umsichtige Ausrichtung und ein System zur Priorisierung von Anweisungen.

- trimmbarUnterstützung einer umfassenden Feinabstimmung der Parameter zur Anpassung an spezifische Aufgabenszenarien.

- Lange KontextunterstützungNative Unterstützung für 128k Kontextlänge für komplexe Aufgaben.

Hilfe verwenden

Einbauverfahren

Um das GPT-OSS-Modell zu verwenden, laden Sie die Modellgewichte herunter und konfigurieren Sie die Umgebung. Im Folgenden werden die einzelnen Schritte beschrieben:

- Download Modellgewichte

Holen Sie sich Modellgewichte von Hugging Face:huggingface-cli download openai/gpt-oss-120b --include "original/*" --local-dir gpt-oss-120b/ huggingface-cli download openai/gpt-oss-20b --include "original/*" --local-dir gpt-oss-20b/Sicherstellung der Installation

huggingface-cli:pip install huggingface_hub。 - Konfigurieren der Python-Umgebung

Erstellen einer virtuellen Umgebung mit Python 3.12:uv venv gpt-oss --python 3.12 source gpt-oss/bin/activate pip install --upgrade pipInstallieren Sie die Abhängigkeit:

pip install transformers accelerate torch pip install gpt-ossFür Triton-Implementierungen ist eine zusätzliche Installation erforderlich:

git clone https://github.com/triton-lang/triton cd triton pip install -r python/requirements.txt pip install -e . pip install gpt-oss[triton] - Betriebsmodell

- Transformers VerwirklichungLaden und ausführen

gpt-oss-20b:from transformers import pipeline import torch model_id = "openai/gpt-oss-20b" pipe = pipeline("text-generation", model=model_id, torch_dtype="auto", device_map="auto") messages = [{"role": "user", "content": "量子力学是什么?"}] outputs = pipe(messages, max_new_tokens=256) print(outputs[0]["generated_text"][-1])Stellen Sie sicher, dass Sie das Harmony-Format verwenden, sonst funktioniert das Modell nicht richtig.

- vLLM-Implementierung: Starten Sie einen OpenAI-kompatiblen Server:

uv pip install --pre vllm==0.10.1+gptoss --extra-index-url https://wheels.vllm.ai/gpt-oss/ vllm serve openai/gpt-oss-20b - Ollama Verwirklichung(Hardware für Verbraucher):

ollama pull gpt-oss:20b ollama run gpt-oss:20b - LM Studio Implementierung:

lms get openai/gpt-oss-20b - Apple Silizium RealisationUmrechnung von Gewichten in das Metallformat:

pip install -e .[metal] python gpt_oss/metal/scripts/create-local-model.py -s gpt-oss-20b/metal/ -d model.bin python gpt_oss/metal/examples/generate.py gpt-oss-20b/metal/model.bin -p "为什么鸡过马路?"

- Transformers VerwirklichungLaden und ausführen

Betriebsfunktion

- logische SchlussfolgerungenDas Modell unterstützt drei Inferenzstärken (niedrig, mittel und hoch). Entwickler können dies z. B. über eine Systemmeldung einstellen:

system_message_content = SystemContent.new().with_reasoning_effort("high")Hohe Intensität ist gut für komplexe Aufgaben wie mathematisches Denken, niedrige Intensität ist gut für schnelle Antworten.

- Format HarmonyDie Modellergebnisse sind unterteilt in

analysis(Argumentationsprozess) undfinal(Endgültige Antwort). Geparst mit der Harmony-Bibliothek:from openai_harmony import load_harmony_encoding, HarmonyEncodingName, Conversation, Message, Role, SystemContent encoding = load_harmony_encoding(HarmonyEncodingName.HARMONY_GPT_OSS) messages = [Message.from_role_and_content(Role.USER, "旧金山天气如何?")] conversation = Conversation.from_messages(messages) token_ids = encoding.render_conversation_for_completion(conversation, Role.ASSISTANT)Nur für Benutzer anzeigen

finalInhalt des Kanals. - Werkzeug Aufruf:

- Suche im Internet: durch

browserTools zum Suchen, Öffnen oder Finden von Webinhalten. Aktivieren Sie das Werkzeug:from gpt_oss.tools.simple_browser import SimpleBrowserTool, ExaBackend backend = ExaBackend(source="web") browser_tool = SimpleBrowserTool(backend=backend) system_message_content = SystemContent.new().with_tools(browser_tool.tool_config)eine Einstellung erfordern

EXA_API_KEYUmgebungsvariablen. - Ausführung von Python-CodeAusführen von Datenverarbeitungsaufgaben, zum Beispiel:

from gpt_oss.tools.python_docker.docker_tool import PythonTool python_tool = PythonTool() system_message_content = SystemContent.new().with_tools(python_tool.tool_config)Hinweis: Python-Tools verwenden Docker-Container und müssen das Risiko der Prompt-Injection mit Vorsicht behandeln.

- Dateioperation: durch

apply_patchum Dateien zu erstellen, zu aktualisieren oder zu löschen.

- Suche im Internet: durch

- Strukturierte AusgabeUnterstützt das Format Responses API, um eine konsistente Ausgabe zu gewährleisten, die sich für intelligente Body-Workflows eignet.

caveat

- Hardware-Voraussetzung:

gpt-oss-120b80GB GPU erforderlich (z.B. Nvidia H100).gpt-oss-20b16 GB RAM erforderlich. Apple Silicon erfordert Gewichte im Metal-Format. - Länge des Kontexts: unterstützt 128k Kontexte, muss angepasst werden

max_context_lengthParameter. - Sichere NutzungVermeiden Sie die direkte Anzeige von verketteten Argumentationsinhalten, um die Offenlegung von schädlichen Informationen zu verhindern.

- Parameter der Probenahme: Empfehlungen

temperature=1.0和top_p=1.0für eine optimale Leistung.

Anwendungsszenario

- Einsatz der Unternehmenslokalisierung

Unternehmen können GPT-OSS auf lokalen Servern betreiben, um sensible Daten zu verwalten, die für den Kundenservice, interne Wissensdatenbanken oder Compliance-kritische Szenarien geeignet sind. - Anpassung für Entwickler

Die Entwickler können das Modell auf der Grundlage der Apache 2.0-Lizenz fein abstimmen, um bestimmte Aufgaben wie die Analyse von Rechtsdokumenten oder die Codegenerierung zu optimieren. - akademische Forschung

Forscher können die Modelle nutzen, um mit KI-Algorithmen zu experimentieren, das Denkverhalten zu analysieren oder Sicherheitsüberwachungssysteme zu entwickeln. - Anwendungen für Verbrauchergeräte

gpt-oss-20bAnpassbar an Laptops oder Edge-Geräte, geeignet für die Entwicklung persönlicher Assistenten oder Offline-Schreibwerkzeuge.

QA

- Welche Hardware wird von GPT-OSS unterstützt?

gpt-oss-120b80GB GPU erforderlich (z.B. Nvidia H100).gpt-oss-20bLäuft auf Geräten mit 16 GB RAM, wie High-End-Laptops oder dem Apple Silicon. - Wie kann ich mein Modell sichern?

OpenAI veranstaltet die $500.000 Red Team Challenge, um die Community zu ermutigen, Sicherheitslücken zu entdecken. - Wird Multimodalität unterstützt?

Es werden nur Texteingabe und -ausgabe unterstützt, keine Bilder oder andere Modalitäten. - Wie kann ich das Modell feinabstimmen?

Vollständige Feinabstimmung der Parameter auf einem benutzerdefinierten Datensatz nach dem Laden von Modellgewichten, unter Verwendung von Transformers oder anderen Frameworks. - Wie funktioniert das Harmony-Format?

Das Harmony-Format sorgt für eine strukturierte Ausgabe, die die Fehlersuche erleichtert und Vertrauen schafft. Es muss verwendet werden, sonst funktioniert das Modell nicht richtig.