Google führte nacheinander Open-Source-Modelle für den Betrieb auf einer einzigen Cloud oder einem Desktop-Beschleuniger ein Gemma 3 Nach QAT mit Gemma 3 erweitert das Unternehmen seinen Fußabdruck für allgegenwärtige KI. Wenn Gemma 3 den Entwicklern leistungsstarke Cloud- und Desktop-Funktionen bot, so zeigt diese Vorabversion von Gemma 3n am 20. Mai 2025 deutlich die Ambitionen für Echtzeit-KI auf der Seite der Mobilgeräte - mit dem Ziel, die Telefone, Tablets und Laptops, die wir jeden Tag benutzen, direkt mit Hochleistungs-KI direkt auf den Mobiltelefonen, Tablets und Laptops, die wir täglich benutzen, laufen zu lassen.

Um die nächste Generation der KI auf der Endseite voranzutreiben und verschiedene Anwendungsszenarien zu unterstützen, einschließlich weiterer Verbesserungen der Zwillinge Nano zu verbessern, hat das Google-Entwicklungsteam eine neue, hochmoderne Architektur entwickelt. Diese neue Architektur, die das Ergebnis einer engen Zusammenarbeit mit führenden Anbietern mobiler Hardware wie Qualcomm, MediaTek und Samsungs System LSI Business sein soll, ist für blitzschnelle Reaktionen und multimodale KI-Verarbeitung optimiert und soll ein wirklich personalisiertes und privates intelligentes Erlebnis direkt auf dem Gerät ermöglichen.

Gemma 3n ist das erste offene Modell, das auf dieser bahnbrechenden gemeinsamen Architektur aufbaut und es Entwicklern ermöglicht, die Technologie ab heute in einer frühen Vorschau zu erleben. Die gleiche fortschrittliche Architektur wird auch die nächste Generation von Gemini Nano unterstützen, die Verbesserungen für eine Vielzahl von Funktionen in Google Apps und dem endseitigen Ökosystem mit sich bringt und noch in diesem Jahr in Betrieb genommen werden soll. Das bedeutet, dass Entwickler, die mit Gemma 3n beginnen, sich auf eine zugrunde liegende Technologie vorbereiten, die bald auf Mainstream-Plattformen wie Android (Android) und Chrome verfügbar sein wird.

Hinweis: Diese Grafik zeigt die Rangfolge der KI-Modelle auf der Grundlage des Chatbot Arena Elo-Scores; höhere Werte (obere Zahlen) weisen auf eine höhere Benutzerpräferenz hin. Gemma 3n gehört zu den führenden proprietären und Open-Source-Modellen.

Eine Kerninnovation von Gemma 3n ist die Verwendung der Per-Layer Embeddings (PLE)-Technologie von Google DeepMind, die den Speicherbedarf (RAM) der Modelle erheblich reduziert. Während die ursprüngliche Parameteranzahl der Modelle 5 Milliarden (5B) und 8 Milliarden (8B) beträgt, ermöglicht PLE die Ausführung der Modelle mit einem Speicher-Overhead, der mit dem der 2 Milliarden (2B) und 4 Milliarden (4B) Parametergrößen vergleichbar ist. Insbesondere können sie mit einem dynamischen Speicherbedarf von nur 2 GB und 3 GB ausgeführt werden. Dieser Durchbruch ist ein großer Segen für mobile Geräte mit begrenztem Speicherplatz. Weitere technische Einzelheiten sind in der offiziellen Dokumentation zu finden.

Durch die Erkundung von Gemma 3n können Entwickler einen ersten Blick auf die Kernfunktionen dieses Open-Source-Modells und die Innovationen der Mobile-First-Architektur werfen, die mit Gemini Nano auf die Plattformen Android und Chrome kommen.

Gemma 3n Key Capabilities Profiling

Gemma 3n wurde für eine schnelle, ressourcenschonende KI-Erfahrung entwickelt, die lokal ausgeführt wird und die folgenden Hauptmerkmale aufweist:

- Optimierte Leistung und Effizienz auf der EndseiteGemma 3n: Im Vergleich zum Modell Gemma 3 4B bietet Gemma 3n eine etwa 1,5-mal schnellere Reaktionszeit auf mobilen Geräten sowie eine deutliche Verbesserung der Qualität der Modellausgabe. Ermöglicht wird dies durch Innovationen wie die schichtweise Einbettung (PLE), die gemeinsame Nutzung des Key-Value-Cache (KVC-Sharing) und die fortschrittliche Aktivierungsquantisierung, die zusammen einen geringeren Speicherbedarf ermöglichen.

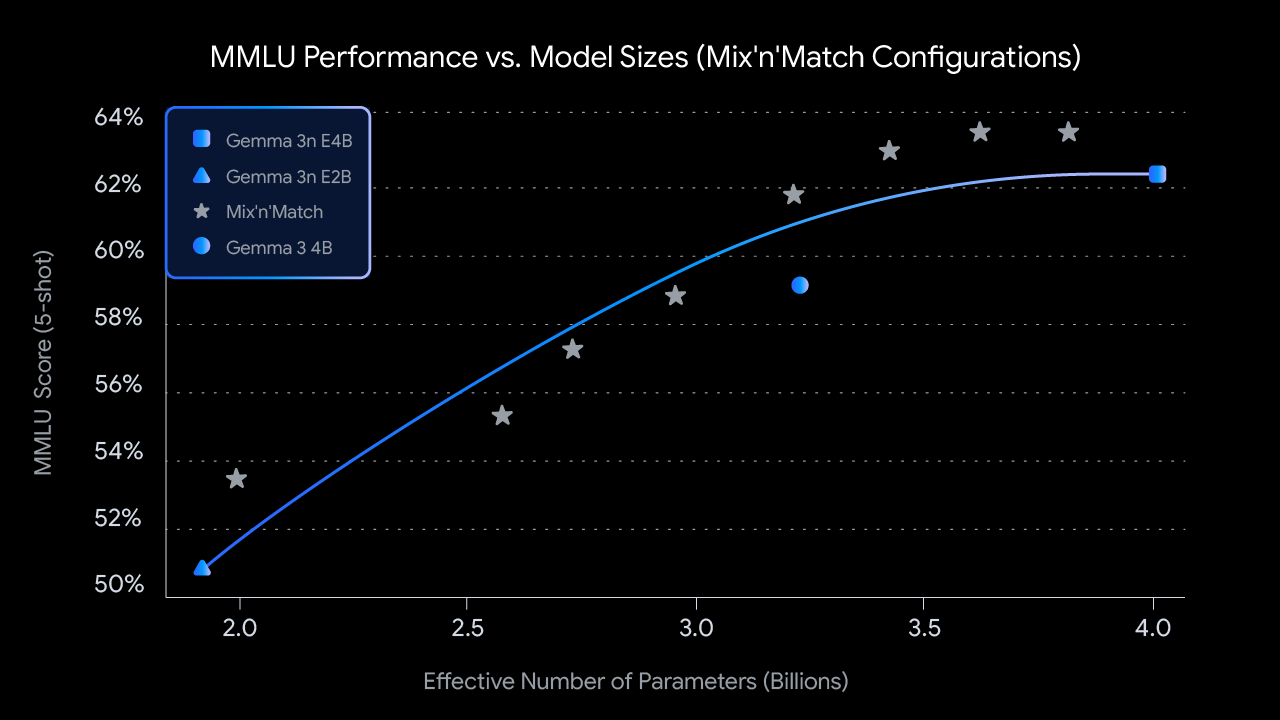

- "Viele-in-1-FlexibilitätDie 4B Active Memory Footprint Version von Gemma 3n beinhaltet natürlich ein verschachteltes, branchenführendes 2B Active Memory Footprint Submodell innerhalb der MatFormer Trainingstechnologie. Dieses Design gibt dem Modell die Flexibilität, einen dynamischen Kompromiss zwischen Leistung und Qualität zu finden, ohne mehrere unabhängige Modelle hosten zu müssen. Noch interessanter ist, dass Gemma 3n eine "Mix'n'Match"-Fähigkeit einführt, die es ermöglicht, dynamisch Untermodelle aus dem 4B-Modell zu erstellen, um einen bestimmten Anwendungsfall und die damit verbundenen Qualitäts-/Latenzanforderungen optimal zu erfüllen. Weitere Einzelheiten zu dieser Forschung werden in einem demnächst erscheinenden technischen Bericht bekannt gegeben.

- Datenschutz zuerst und Offline-VerfügbarkeitDie lokale Ausführung stellt sicher, dass die Funktion die Privatsphäre des Benutzers respektiert und auch dann zuverlässig funktioniert, wenn keine Netzverbindung besteht.

- Erweitertes multimodales Audio-VerständnisGemma 3n versteht und verarbeitet nicht nur Audio, Text und Bilder, sondern verbessert auch das Videoverständnis erheblich. Dank seiner Audiofunktionen kann das Modell eine hochwertige automatische Spracherkennung (Transkription) und Übersetzung (Sprache in übersetzten Text) durchführen. Darüber hinaus akzeptiert das Modell modalitätsübergreifende Eingaben, so dass es komplexe multimodale Interaktionen verstehen kann. (Öffentliche Implementierung in Vorbereitung)

- Verbesserte mehrsprachige FunktionenGemma 3n hat die mehrsprachige Leistung verbessert, insbesondere in Japanisch, Deutsch, Koreanisch, Spanisch und Französisch. Es hat erreicht

50.1%WMT (Workshop on Machine Translation) ist eine wichtige Bewertung im Bereich der maschinellen Übersetzung, und ChrF ist ein häufig verwendeter Bewertungsindex für maschinelle Übersetzung.

Anmerkung: Dieses Diagramm zeigt die MMLU-Leistung von Gemma 3n's "mix-n-match" (pre-training) Fähigkeit für verschiedene Modellgrößen. MMLU (Massive Multitask Language Understanding) ist ein umfassender Benchmark-Test des Sprachverständnisses.

Erschließung des Potenzials für neue mobile Erlebnisse

Gemma 3n wird voraussichtlich eine neue Welle intelligenter mobiler Anwendungen ermöglichen, indem es

- Aufbau interaktiver Echtzeit-ErlebnisseDie Fähigkeit, visuelle und auditive Hinweise aus der Umgebung des Benutzers in Echtzeit zu verstehen und darauf zu reagieren.

- Tieferes Verständnis fördernDie Kombination von Audio-, Bild-, Video- und Texteingaben wird geräteseitig privat verarbeitet, um eine kontextbezogenere Texterstellung zu ermöglichen.

- Entwicklung fortschrittlicher Audio-Center-AnwendungenUmfasst Sprachtranskription in Echtzeit, Übersetzung und umfangreiche sprachgesteuerte Interaktion.

Im folgenden Video werden die verschiedenen Arten von Erlebnissen beschrieben, die Sie aufbauen können:

Verantwortungsvolle Ko-Konstruktion

Die Verpflichtung zu einer verantwortungsvollen KI-Entwicklung ist unerlässlich. Wie alle Modelle der Gemma-Familie wurde auch Gemma 3n strengen Sicherheitsbewertungen, einer Datenverwaltung und einer Feinabstimmung der Kalibrierung gemäß den Sicherheitsrichtlinien unterzogen. Google seinerseits sagt, dass sie offene Modelle mit einer sorgfältigen Risikobewertung angehen und ihre Praktiken weiter verfeinern, während sich die KI-Landschaft weiterentwickelt.

Eingehende Analyse der Parameter des Modells Gemma 3n

Gemma 3n ist ein generatives KI-Modell, das für den Einsatz auf Alltagsgeräten wie Mobiltelefonen, Laptops und Tablets optimiert wurde. Das Modell umfasst Innovationen im Bereich der parametereffizienten Verarbeitung, wie das bereits erwähnte Layer-by-Layer-Embedding (PLE) Parameter-Caching, sowie die MatFormer-Modellarchitektur, die die Flexibilität bietet, den Rechen- und Speicherbedarf zu reduzieren. Die Modelle sind in der Lage, Audioeingaben sowie textuelle und visuelle Daten zu verarbeiten.

Vorschauphase und LizenzierungGemma 3n: Gemma 3n befindet sich derzeit in einer frühen Vorabversion. Weitere Informationen über Gemma 3n finden Sie in der Google AI Studio und Google AI Edge, um es auszuprobieren. Wie andere Gemma-Modelle bietet Gemma 3n offene Gewichte und ist für eine verantwortungsvolle kommerzielle Nutzung lizenziert, so dass Entwickler es feinabstimmen und in ihren eigenen Projekten und Anwendungen einsetzen können.

Die wichtigsten Merkmale des Gemma 3n lassen sich auf technischer Ebene wie folgt weiter verfeinern:

- AudioeingangVerarbeitung von Tondaten für Spracherkennung, Übersetzung und Audiodatenanalyse.

- Visuelle und TexteingabeMultimodale Fähigkeiten ermöglichen es, visuelle, akustische und textuelle Informationen zu verarbeiten, um die Welt um sich herum zu verstehen und zu analysieren.

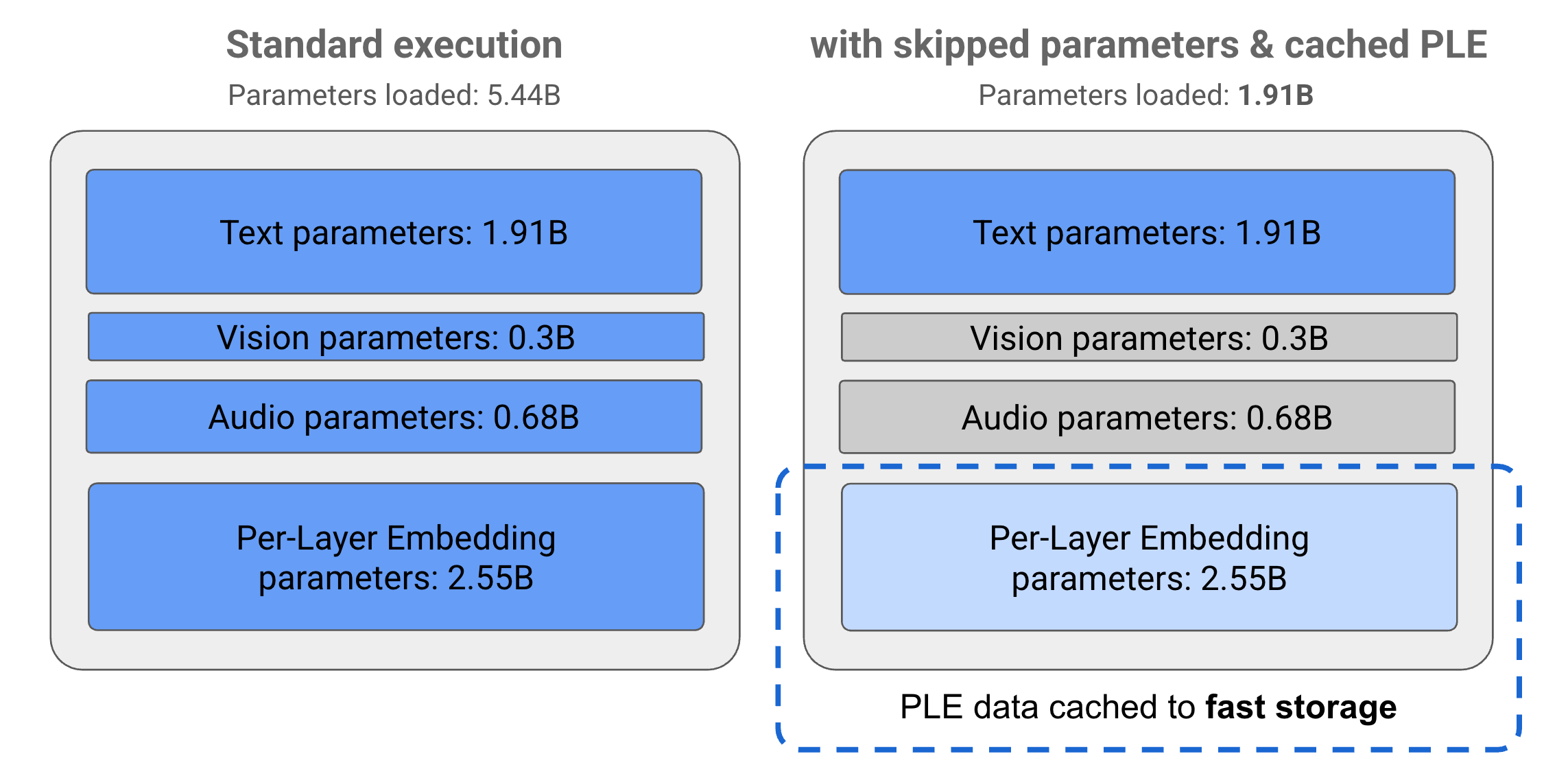

- PLE-CachingLayer-by-Layer Embedding (PLE) Parameter, die im Modell enthalten sind, können in einem schnellen lokalen Speicher zwischengespeichert werden, um die Speicherkosten zur Modelllaufzeit zu reduzieren. Diese PLE-Daten werden während der Modellausführung verwendet, um Daten zu erstellen, die die Leistung jeder Modellschicht verbessern, den Ressourcenverbrauch reduzieren und gleichzeitig die Qualität der Modellreaktion verbessern, indem PLE-Parameter aus dem Hauptspeicher des Modells ausgeschlossen werden.

- MatFormer Architektur:: "Kondom-Stil" Transformator (Matroschka-Transformator)-Architektur mit kleineren Modellen, die in einem größeren Modell verschachtelt sind. Diese verschachtelten Untermodelle können als Reaktion auf eine Anfrage aufgerufen werden, ohne die vollständigen Parameter des äußeren Modells zu aktivieren. Diese Möglichkeit, nur die kleineren Kernmodelle innerhalb eines MatFormer-Modells auszuführen, kann die Rechenkosten, die Reaktionszeit und den Energieverbrauch des Modells erheblich reduzieren. Im Fall von Gemma 3n enthält allein das E4B-Modell E2B Parameter des Modells. Die Architektur ermöglicht es den Entwicklern auch, Parameter auszuwählen und Modelle mit Zwischengrößen zwischen 2B und 4B zusammenzustellen. Weitere Einzelheiten finden Sie im MatFormer-Forschungspapier.

- Bedingtes Laden von ParameternÄhnlich wie bei den PLE-Parametern können bestimmte Parameter im Modell (z. B. Audio- oder visuelle Parameter) selektiv nicht in den Speicher geladen werden, um die Speicherbelastung zu verringern. Diese Parameter können zur Laufzeit dynamisch geladen werden, wenn das Gerät über die erforderlichen Ressourcen verfügt. Insgesamt kann durch das Überspringen von Parametern der von Gemma 3n-Modellen benötigte Laufzeitspeicher weiter reduziert werden, so dass sie auf einer größeren Anzahl von Geräten laufen können und die Entwickler bei weniger anspruchsvollen Aufgaben ressourceneffizienter arbeiten können.

- Umfassende SprachunterstützungUmfassende Sprachkenntnisse mit einer Ausbildung in über 140 Sprachen.

- 32K Token-KontextBietet eine ausreichende Länge des Eingabekontexts für die Analyse von Daten und Verarbeitungsaufgaben.

auf etw. aufmerksam machenWeitere Informationen finden Sie in der Gemini Nano Entwicklerdokumentation für Android (Android).

Das Geheimnis der Modellparameter und der "effektiven Parameter"

Das Modell Gemma 3n wird mit einem Namen wie E2B im Gesang antworten E4B Solche Parameter, die weniger als die Gesamtzahl der im Modell enthaltenen Parameter zählen. Präfixe E Dies zeigt, dass die Modelle mit einem vereinfachten Satz von effektiven Parametern arbeiten können. Diese vereinfachte Parametermanipulation wird durch die in die Gemma 3n-Modelle eingebauten flexiblen Parametrisierungstechniken ermöglicht, die dazu beitragen, dass die Modelle effizient auf ressourcenarmen Geräten laufen.

Die Parameter des Gemma 3n-Modells sind in 4 Hauptgruppen unterteilt: textuelle, visuelle, Audio- und Layer-by-Layer-Einbettungsparameter (PLE). Im Standardausführungsmodus des E2B-Modells werden über 5 Milliarden Parameter zur Laufzeit geladen. Durch den Einsatz von Techniken zum Überspringen von Parametern und zur Zwischenspeicherung von PLE-Parametern kann das Modell jedoch mit einer effektiven Speicherbelastung von knapp 2 Milliarden (1,91 B) Parametern ausgeführt werden, wie in der nachstehenden Abbildung dargestellt.

Abbildung 1. Gemma 3n E2B-Modellparameter im Standardausführungsmodus im Vergleich zur Verwendung von PLE-Zwischenspeicher- und Parameter-Skipping-Techniken, um effektiv niedrigere Parameterlasten zu erreichen.

Mit Hilfe dieser Techniken zur Auslagerung von Parametern und zur selektiven Aktivierung ist es möglich, das Modell mit einem sehr komprimierten Satz von Parametern auszuführen oder zusätzliche Parameter zu aktivieren, um andere Datentypen wie visuelle und Audio-Daten zu verarbeiten. Diese Funktionen geben dem Benutzer die Flexibilität, die Modellfunktionalität an die Fähigkeiten des Geräts oder die Anforderungen der Aufgabe anzupassen.

Erste Schritte: Vorschau auf die Gemma 3n

Ein vorgezogener Versuch mit Gemma 3n ist jetzt eröffnet:

- Cloud-Erkundung mit Google AI StudioZugriff auf Google direkt in Ihrem Browser, keine Einrichtung erforderlich! AI-Studio Probieren Sie das Gemma 3n jetzt aus und entdecken Sie sofort seine Texteingabefunktionen.

- Endseitenentwicklung mit Google AI EdgeFür Entwickler, die Gemma 3n lokal integrieren möchten, stellt Google AI Edge die entsprechenden Werkzeuge und Bibliotheken zur Verfügung. Derzeit ist es möglich, die Funktionen zum Verstehen/Erzeugen von Text und Bildern zu nutzen.

Gemma 3n markiert einen neuen Schritt in der Verbreitung von hochmoderner, effizienter KI. Es ist spannend zu sehen, welche Innovationen die Technologie für die Entwicklergemeinschaft bringen wird, beginnend mit der heutigen Vorschau.

Sie können diese Ankündigung und ihren gesamten Inhalt ab dem 22. Mai auf io.google einsehen. Google I/O 2025 Die Aktualisierung.

Sind Sie daran interessiert, mit dem Bauen zu beginnen? Beginnen Sie mit dem Getting Started Guide für Gemma Models.