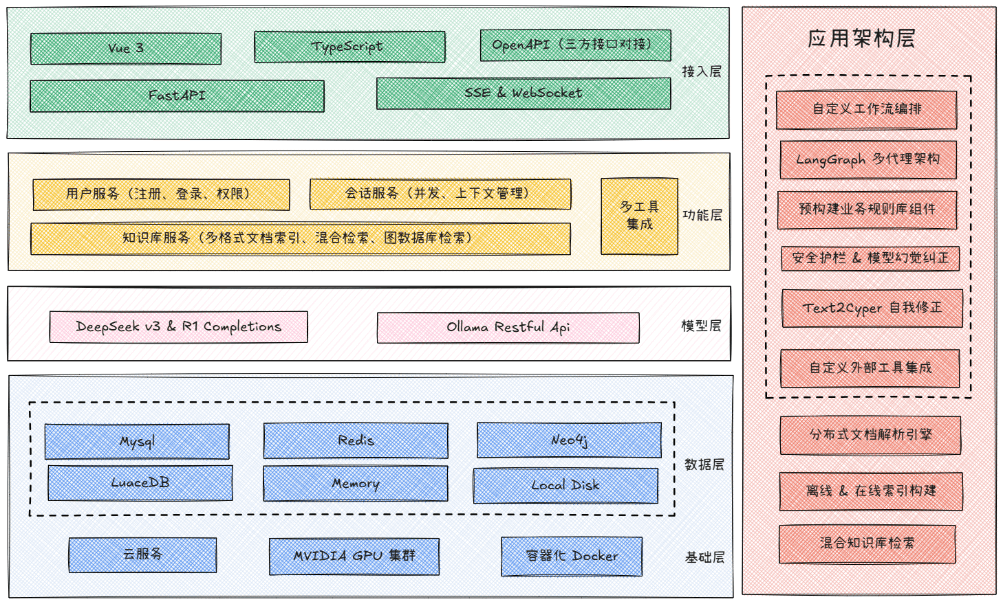

GBC MedAI ist ein quelloffenes intelligentes medizinisches Assistenzsystem. Es verwendet FastAPI als Back-End-Framework und Vue 3 als Front-End-Technologie-Stack. Die Kernfähigkeit dieses Systems liegt in der Fähigkeit, mehrere große KI-Sprachmodelle gleichzeitig zu integrieren, wie z. B. DeepSeek, lokal eingesetztes Ollama und andere Modelle, die mit der OpenAI-Schnittstelle kompatibel sind. Es integriert auch eine Vielzahl von Suchmaschinendiensten, um den Nutzern intelligente Dialog- und Suchfunktionen zu bieten, die Echtzeitinformationen einbeziehen. Mit einer modularen Architektur und einem fortschrittlichen und vollständigen Technologiepaket zielt das Projekt darauf ab, eine KI-Assistentenlösung bereitzustellen, die schnell eingesetzt und in zweiter Linie für den medizinischen Bereich oder andere professionelle Szenarien entwickelt werden kann.

Funktionsliste

- KI-FähigkeitenUnterstützung des Zugangs zu DeepSeek, lokalen Modellen von Ollama und einer Vielzahl von KI-Modellen, die mit OpenAI kompatibel sind. Das System ist in der Lage, komplexe logische Aufgaben und visuelles Verständnis zu bewältigen und kann hochgeladene Bilder analysieren.

- Intelligente SucheIntegration von Boca AI, Baidu AI Search und SerpAPI ermöglicht die automatische Auswahl der am besten geeigneten Suchmaschine auf der Grundlage der Fragestellung und den Zugang zu den neuesten medizinischen Informationen und Forschungsergebnissen.

- Dialogsystem:: Bietet reibungslose Streaming-Antworten und kontextbezogene Speicherfunktionen. Das System verfügt über eine vollständige integrierte Benutzerauthentifizierung und einen Multi-Session-V-Session-Management-Mechanismus zum Speichern der Historie.

- Modernes FrontendDie mit Vue 3 und TypeScript erstellte Website bietet ein responsives Layout und unterstützt sowohl Desktop- als auch Mobilgeräte. Die Schnittstelle ist in einem schönen sekundären Anime-Stil gestaltet und enthält reiche interaktive Animationen.

- Leistungsstarkes Back-EndEntwickelt auf der Grundlage des asynchronen FastAPI-Frameworks, gewährleistet es eine effiziente Verarbeitung von Anfragen.

- Daten und CacheDie Verwendung von Redis als semantischer Cache kann die Antwortleistung bei wiederholten Abfragen effektiv verbessern und die Kosten für KI-Modellaufrufe reduzieren.

- Fortgeschrittenes AI-Framework:: Angewandt LangGraph und Technologien wie GraphRag für den Aufbau komplexerer KI-Prozesse und Wissensgraphenanwendungen.

Hilfe verwenden

In diesem Abschnitt erfahren Sie, wie Sie das GBC MedAI-System installieren, konfigurieren und erfolgreich betreiben. Bitte folgen Sie den nachstehenden Schritten, um Ihre Einrichtung abzuschließen.

Anforderungen an die Umwelt

Bevor Sie beginnen, stellen Sie sicher, dass Ihre Systemumgebung die folgenden Bedingungen erfüllt:

- Python: 3,8 oder höher

- Node.js: 16 oder höher (nur erforderlich, wenn Front-End-Entwicklung erforderlich ist)

- umfassende DatenbankMySQL 8.0 oder höher, Redis 6.0 oder höher

- Knowledge Graph (optional)Neo4j 4.0 oder höher

Prefile Download

Das Projekt benötigt einige vorkonfigurierte Dateien. Bitte laden Sie diese von der folgenden Adresse herunter und entpacken Sie sie zuerst in das angegebene Verzeichnis:

- Front-End-Dokumentation: Link von Baidu.com

https://pan.baidu.com/s/1KTROmn78XhhcuYBOfk0iUQ?pwd=wi8k(Extract code: wi8k) Laden Sie die Front-End-Paketdatei herunter und entpacken Sie sie in das Verzeichnisllm_backend/static/Katalog. - GraphRag-Dateien: Link von Baidu.com

https://pan.baidu.com/s/1dg6YxN_a4wZCXrmHBPGj_Q?pwd=hppu(Code extrahieren: hppu) Laden Sie die GraphRag-bezogenen Dateien herunter und legen Sie sie in das Hauptverzeichnis des Projekts.

Installations- und Konfigurationsschritte

1. das Klonen von Projektcodes

Verwenden Sie zunächst die git Befehl, um den Projektcode von GitHub auf Ihren lokalen Computer zu klonen.

git clone https://github.com/zhanlangerba/gbc-madai.git

cd gbc-madai

2. die Einrichtung des Backend-Dienstes

Wechseln Sie in das Backend-Codeverzeichnis und verwenden Sie die pip Installieren Sie alle Python-Abhängigkeiten.

cd llm_backend

pip install -r requirements.txt

3. die Umgebungsvariablen konfigurieren

Die Konfigurationsdatei ist der Schlüssel für den Betrieb des Systems. Sie müssen die Vorlagedatei kopieren und Ihre persönlichen Konfigurationsdaten eingeben.

# 复制环境变量模板文件

cp .env.example .env

# 使用文本编辑器(如 nano 或 vim)打开并编辑 .env 文件

nano .env

在 .env müssen Sie die folgenden Informationen ausfüllen:

DEEPSEEK_API_KEY: Ihr DeepSeek API-Schlüssel.BOCHA_AI_API_KEY/BAIDU_AI_SEARCH_API_KEY/SERPAPI_KEY: Geben Sie den entsprechenden API-Schlüssel für die von Ihnen gewählte Suchmaschine ein.DB_HOST,DB_USER,DB_PASSWORD,DB_NAMEIhre MySQL-Datenbankverbindungsinformationen.REDIS_HOST,REDIS_PORTIhre Redis-Dienst-Verbindungsinformationen.NEO4J_URL,NEO4J_USERNAME,NEO4J_PASSWORDIhre Neo4j-Datenbankverbindungsinformationen (falls verwendet).

4. die Initialisierung der Datenbank

Bevor Sie den Dienst starten, müssen Sie die für das Projekt erforderliche Datenbank in MySQL erstellen.

# 使用您的 MySQL root 用户登录并执行以下命令

mysql -u root -p -e "CREATE DATABASE assist_gen CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci;"

5. die Systemdienste starten

Nachdem Sie alle oben genannten Schritte durchgeführt haben, führen Sie run.py Skript, um das gesamte System zu starten.

# 启动后端服务

python run.py

Nachdem der Dienst erfolgreich gestartet wurde, können Sie die folgende Adresse über Ihren Browser aufrufen:

- Front-End-Zugangsadresse:

http://localhost:8000/ - API-Dokumentation (Swagger UI):

http://localhost:8000/docs

Methode des Einsatzes

Neben der direkten Ausführung des Quellcodes unterstützt das Projekt auch die stabilere und bequemere Docker-Bereitstellungsmethode.

Bereitstellen mit Docker (empfohlen)

Stellen Sie sicher, dass Sie Docker installiert haben. Führen Sie den folgenden Befehl im Stammverzeichnis des Projekts aus:

# 1. 构建 Docker 镜像,将其命名为 gbc-madai

docker build -t gbc-madai .

# 2. 以后台模式运行容器,并将本地的 .env 文件作为环境变量传入

docker run -d -p 8000:8000 --env-file .env gbc-madai

Unabhängige Front-End-Entwicklung

Wenn Sie die Front-End-Oberfläche ändern und entwickeln müssen, können Sie auf der Seite gbc_madai_web Verzeichnis, um den Front-End-Entwicklungsdienst unabhängig auszuführen. "`shell

Wechseln Sie in das Front-End-Code-Verzeichnis

cd ../gbc_madai_web

Installation von Front-End-Abhängigkeiten

npm install

Starten Sie den Front-End-Entwicklungsserver

npm run dev

Front-End-Entwicklungsdienste werden verfügbar sein in http://localhost:3000 startet und automatisch API-Anfragen an die http://localhost:8000。

Anwendungsszenario

- Intelligente Beratung im Gesundheitswesen

Als virtuelle Arzthelferin kann sie rund um die Uhr online genutzt werden, um Fragen von Patienten zu häufigen Krankheiten, Medikamentenempfehlungen und gesunder Lebensweise zu beantworten und eine erste medizinische Beratung anzubieten. - Unterstützung klinischer Entscheidungen

Unterstützung von Ärzten beim schnellen Auffinden und Analysieren der neuesten medizinischen Literatur, klinischer Studienberichte und Behandlungsrichtlinien, um die Entwicklung genauerer Diagnose- und Behandlungspläne zu unterstützen. - Plattform für die Suche nach medizinischen Informationen

Sie kann als intelligente Wissensdatenbank innerhalb eines Krankenhauses oder einer Forschungseinrichtung genutzt werden, die den Mitarbeitern hilft, interne Vorschriften, Betriebsabläufe, Fallakten und Forschungsmaterialien schnell zu finden. - Andere spezialisierte Anwendungsbereiche

Der modulare Aufbau des Systems ermöglicht eine einfache Erweiterung auf andere Berufsfelder wie E-Commerce, Finanzen, Recht usw., um als intelligenter Kundenservice oder Expertenassistent eingesetzt zu werden.

QA

- Ist dieses Projekt kostenlos und quelloffen?

Ja, das Projekt ist vollständig quelloffen und basiert auf der MIT-Lizenz. Es steht Ihnen frei, es in Ihren persönlichen oder kommerziellen Projekten zu verwenden, zu verändern und weiterzugeben. - Welcher technische Hintergrund ist für den Einsatz dieses Systems erforderlich?

Sie benötigen ein grundlegendes Verständnis der Sprache Python und des FastAPI-Frameworks sowie Kenntnisse über die Installation von MySQL- und Redis-Datenbanken und grundlegende Operationen. Wenn Sie sich für die Bereitstellung mit Docker entscheiden, müssen Sie auch mit den gängigen Docker-Befehlen vertraut sein. - Kann ich auf meine eigenen KI-Modelle zugreifen?

Kann. Die Systemarchitektur unterstützt den Zugriff auf jedes Modell, das mit dem OpenAI-API-Standard kompatibel ist. Alles, was Sie tun müssen, ist das Hinzufügen der.envÄndern Sie die API-Adresse des Modells in der Konfigurationsdatei (OLLAMA_BASE_URL(oder ähnliche Variablen) und ein Schlüssel sind ausreichend. Das System selbst bietet native Unterstützung für DeepSeek und Ollama. - Kann die Front-End-Schnittstelle ersetzt werden?

Das System-Backend bietet einen vollständigen Satz von REST-APIs. Das System-Backend bietet einen vollständigen Satz von REST-APIs. Sie können das Frontend, das mit Ihrem Projekt geliefert wird, ganz weglassen und der API-Dokumentation folgen (http://localhost:8000/docs) Entwickeln Sie Ihre eigenen Client-Anwendungen, z. B. Desktop-Anwendungen, mobile Anwendungen oder Applets.