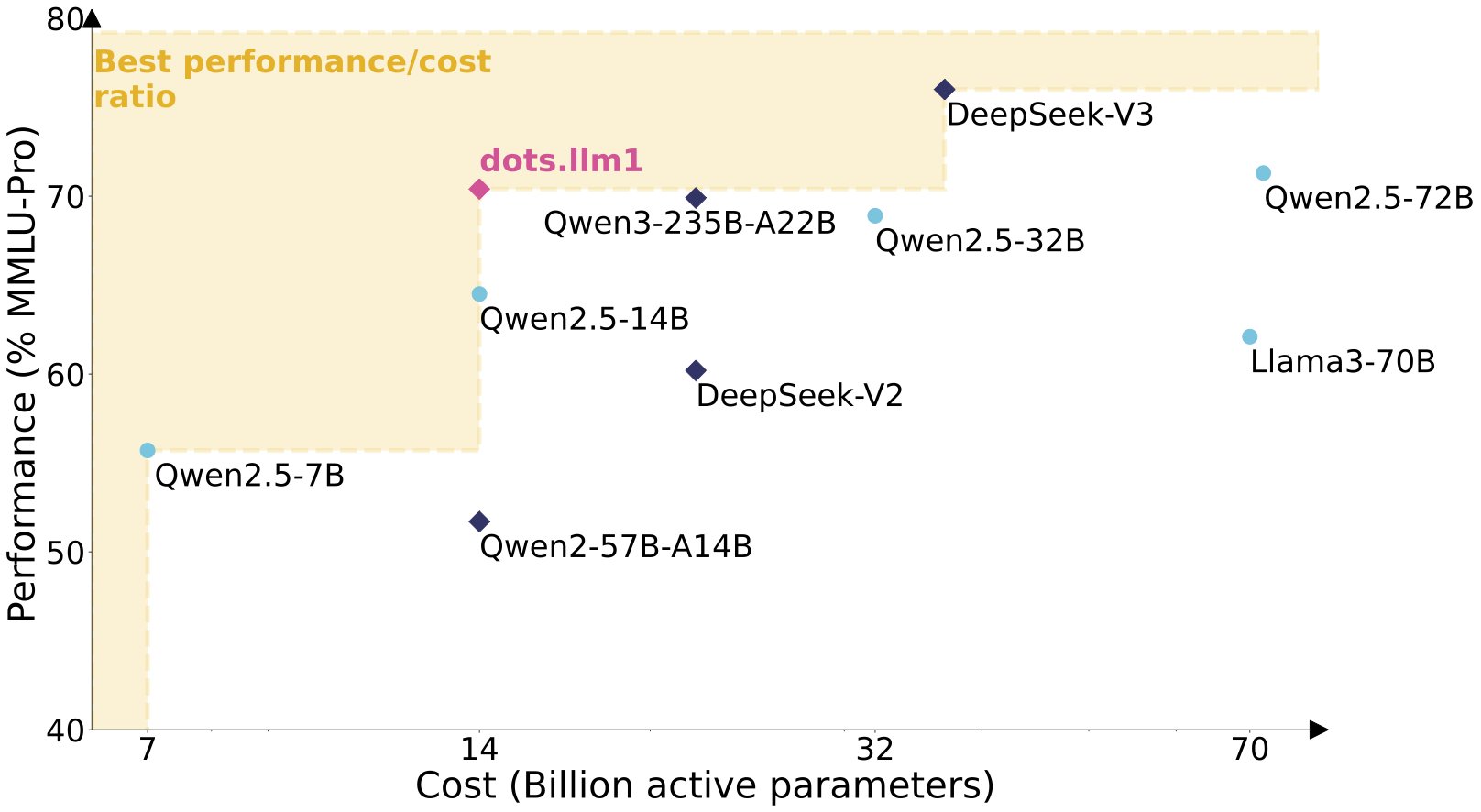

rednote-hilab/dots.llm1.baseist das erste große Sprachmodell dots.llm1 von Xiaohongshu, das auf der Plattform Hugging Face gehostet wird. Das Modell verwendet die Mixed Expert (MoE)-Architektur mit 142 Milliarden Parametern, wobei nur 14 Milliarden Parameter während der Inferenz aktiviert werden, um hohe Leistung und niedrige Kosten zu berücksichtigen. dots.llm1 wurde mit 11,2 Billionen nicht-synthetischer, hochwertiger Korpusse trainiert und erzielte im chinesischen Sprachtest einen Durchschnitt von 91,3 und übertraf damit DeepSeek V2, V3 und die Ali Qwen2.5-Serie. Unterstützt 32.768 Token von ultralangen Kontexten, geeignet für Aufgaben wie Textgenerierung und Dialog. Die Seite bietet Modellgewichte, Konfigurationsdateien und Anwendungsbeispiele für Entwickler zur Integration und Forschung.

Funktionsliste

- Generieren Sie hochwertige Texte für Dialoge, Artikelfortsetzungen und Codegenerierung.

- Mit der MoE-Architektur werden bei der Inferenz nur 14 Milliarden Parameter aktiviert, was die Rechenkosten reduziert.

- Unterstützt 32.768 Token mit sehr langen Kontexten, geeignet für die Verarbeitung langer Dokumente oder komplexer Aufgaben.

- Bietet Trainingskontrollpunkte pro 1 Billion Token, um die Trainingsdynamik des Modells zu untersuchen.

- Unterstützt Docker- und vLLM-Bereitstellungen zur Optimierung von Inferenzszenarien mit hohem Durchsatz.

- Integriert Hugging Face Transformers und bietet Python-Code-Beispiele.

- Optimierte chinesische Verarbeitungskapazität, mit Testergebnissen, die über denen einiger gängiger Open-Source-Modelle liegen.

Hilfe verwenden

Installation und Einsatz

Für die Verwendung von dots.llm1.base muss eine GPU-fähige Rechenumgebung (mindestens 8 GB Videospeicher werden empfohlen) vorbereitet werden. Nachfolgend finden Sie die detaillierten Schritte zur Bereitstellung:

1. die Bereitstellung über Docker

Docker ist die offiziell empfohlene Bereitstellungsmethode mit Unterstützung für GPU-Beschleunigung und hohe Durchsatzraten. Die Schritte sind wie folgt:

- Stellen Sie sicher, dass Docker und NVIDIA Container Toolkit installiert sind.

- Ziehen Sie das Docker-Image und führen Sie es aus:

docker run --gpus all \

-v ~/.cache/huggingface:/root/.cache/huggingface \

-p 8000:8000 \

--ipc=host \

rednotehilab/dots1:vllm-openai-v0.9.0.1 \

--model rednote-hilab/dots.llm1.base \

--tensor-parallel-size 8 \

--trust-remote-code \

--served-model-name dots1

- Testen Sie, ob der Dienst funktioniert:

curl http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "dots1",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "What is MoE in AI?"}

],

"max_tokens": 32,

"temperature": 0

}'

Eine erfolgreiche Rückkehr zeigt an, dass der Dienst normal läuft.

2. die Verwendung von Umarmungsgesichtstransformatoren

Wenn Docker nicht verwendet wird, können die Modelle über Python geladen werden:

- Installieren Sie die Abhängigkeit:

pip install transformers torch

- Modelle und Splitter laden:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM, GenerationConfig

model_name = "rednote-hilab/dots.llm1.base"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto", torch_dtype=torch.bfloat16)

- Textgenerierung durchführen:

text = "人工智能中的MoE架构是什么?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model.generate(**inputs.to(model.device), max_new_tokens=100)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

3. hoher Durchsatz bei der Argumentation mit vLLM

vLLM eignet sich für groß angelegte Argumentationsszenarien. Installieren Sie vLLM und führen Sie es aus:

vllm serve rednote-hilab/dots.llm1.base --port 8000 --tensor-parallel-size 8

Hauptfunktionen

Textgenerierung

dots.llm1.base ist gut geeignet, um zusammenhängende Texte zu erstellen, die sich für akademisches Schreiben, die Fortsetzung von Artikeln und so weiter eignen. Arbeitsschritte:

- Vorbereiten von Eingabetexten, wie z. B. technischen Unterlagen oder Problembeschreibungen.

- Verwenden Sie Python-Code oder einen Docker-Dienst, setzen Sie die

max_new_tokensSteuert die Länge der Ausgabe. - Überprüfen Sie den Inhalt der Ausgabe, um sicherzustellen, dass er logisch kohärent ist.

Missionen des Dialogs

Durch die Aufforderung an das Projekt kann das Modell die Dialogfunktion umsetzen. Beispiel:

messages = [{"role": "user", "content": "讲解MoE架构的核心原理。"}]

input_tensor = tokenizer.apply_chat_template(messages, add_generation_prompt=True, return_tensors="pt")

outputs = model.generate(input_tensor.to(model.device), max_new_tokens=200)

result = tokenizer.decode(outputs[0][input_tensor.shape[1]:], skip_special_tokens=True)

print(result)

Entwicklungen in Forschung und Ausbildung

Das Modell liefert Zwischenkontrollpunkte für jeweils 1 Billion Token, die Forscher aus dem Hugging Face's Project extrahieren können.dots1Sammeldownloads zur Analyse des MoE-Modelltrainingsverfahrens.

Merkmale der Modellarchitektur

dots.llm1 verwendet eine unidirektionale Decoder-Transformer-Architektur, die das Feedforward-Netz als MoE ersetzt und 128 Routing-Experten und 2 gemeinsame Experten enthält. Sechs Routing-Experten und zwei geteilte Experten werden dynamisch pro Eingabemarke ausgewählt, wodurch insgesamt acht Expertennetzwerke aktiviert werden. Das Modell verwendet die SwiGLU-Aktivierungsfunktion, um die Erfassung von Datenbeziehungen zu optimieren. Die Aufmerksamkeitsschicht verwendet einen Multi-Head-Attention-Mechanismus (MHA) in Kombination mit einer RMSNorm-Normalisierung zur Verbesserung der numerischen Stabilität. Die Lastausgleichsstrategie optimiert die Nutzung des Expertennetzes durch dynamische Bias-Terme.

caveat

- Es wird ein Grafikprozessor mit mindestens 8 GB Videospeicher empfohlen.

- Das Modell hat eine Größe von ca. 4 GB und erfordert ein stabiles Netz zum Herunterladen.

- ausnutzen

torch.bfloat16Optimieren Sie die Leistung und prüfen Sie die Hardwarekompatibilität. - Die chinesischen Sprachaufgaben sind hervorragend, aber die Aufforderungen müssen angepasst werden, um den Dialog zu optimieren.

Anwendungsszenario

- akademische Forschung

Forscher können Zwischenprüfpunkte analysieren, um die Trainingsdynamik und Parametereffizienz der MoE-Architektur zu untersuchen. - Erstellung von Inhalten

Integrieren Sie Modelle in Schreibwerkzeuge, um Entwürfe für Artikel, Berichte oder technische Unterlagen zu erstellen. - Dialogsystem

Entwicklung von Kundendienstrobotern oder Bildungsassistenten, die lange kontextbezogene Dialoge unterstützen. - Code Assist

Generieren Sie Codeschnipsel, um Entwickler beim schnellen Schreiben von Algorithmen oder Skripten zu unterstützen.

QA

- Unterschied zwischen dots.llm1.base und der inst-Version?

Die BASE-Version ist für die Textvervollständigung geeignet, und die INST-Version wurde mit Befehlen zur Optimierung der Dialogfähigkeit verfeinert. - Wie können wir die Kosten der Argumentation senken?

Die MoE-Architektur aktiviert nur 14 Milliarden Parameter und kombiniert vLLM und Docker, um den Ressourcenverbrauch zu optimieren. - Welche Sprachen werden unterstützt?

Unterstützt vor allem Chinesisch und Englisch mit einer Kontextlänge von 32.768 Token. - Wie kann die Qualität der Trainingsdaten gewährleistet werden?

Unter Verwendung eines nicht-synthetischen Korpus von 11,2 Billionen werden hochwertige Inhalte durch eine dreistufige Verarbeitungspipeline gefiltert.