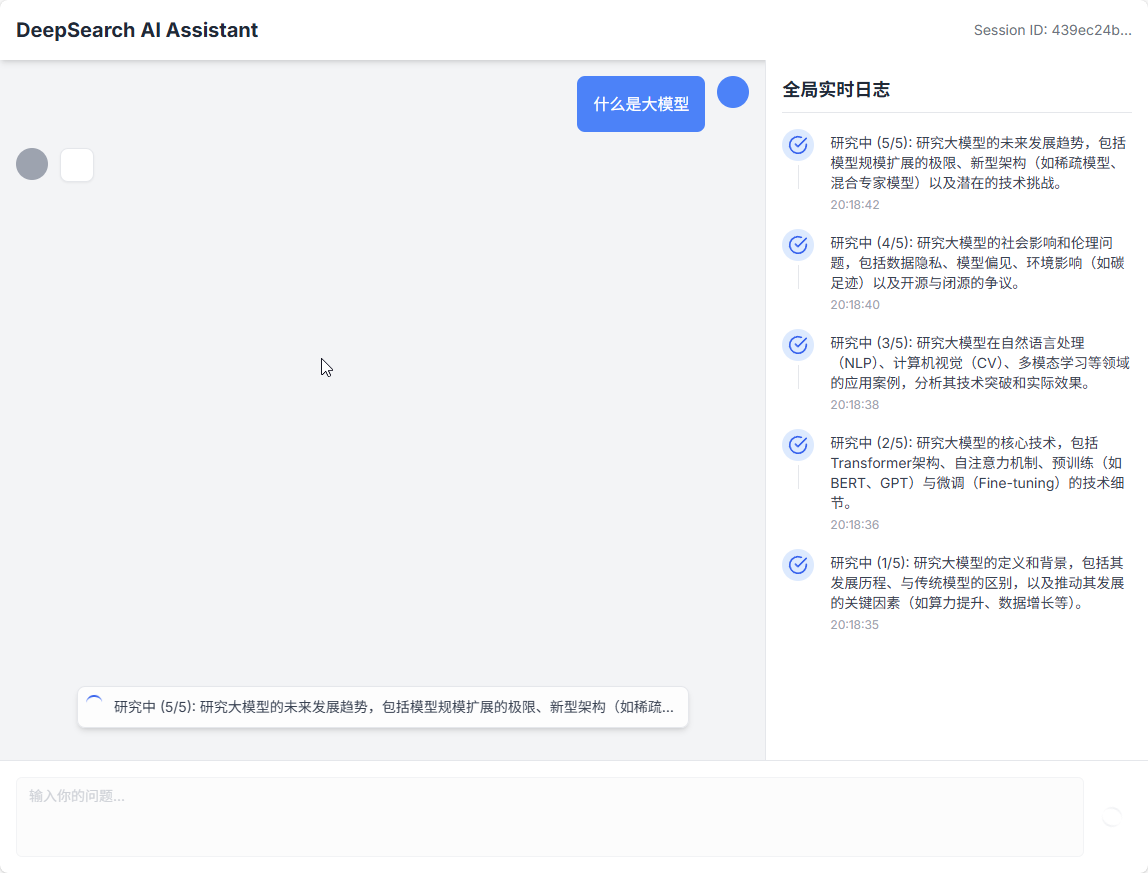

DeepSearch AI Agent ist ein fortschrittlicher KI-Assistent zur Erstellung von Inhalten. Er wurde mit LangGraph- und FastAPI-Technologien entwickelt. Dieses Tool ist nicht wie ein typischer Q&A-Bot. Es ahmt den Arbeitsablauf eines Expertenteams nach und kann durch den Zyklus "Denken-Planen-Recherchieren-Schreiben" eine einfache Anfrage eines Nutzers in einen professionellen Artikel, ein Tutorial oder einen technischen Blog mit vollständiger Struktur und tiefgründigem Inhalt verwandeln. Das gesamte System ist aus dem Front-End und Back-End getrennt, das Back-End durch FastAPI Verarbeitungslogik, das Front-End mit React, um die Schnittstelle anzuzeigen, die beiden durch Echtzeit-Streaming-Technologie für die Kommunikation, kann der Benutzer den Prozess der Artikel Generation in Echtzeit zu sehen. Das Design dieses Projekts ist hoch skalierbar, und es ist einfach, neue funktionale Knoten hinzuzufügen, wie z.B. das Hinzufügen von manueller Überprüfung oder Auto-Korrektur-Links, um eine komplexere intelligente Agentenlogik zu erreichen.

Funktionsliste

- Dynamische Planung von ErzählungenBevor die KI den Stift zu Papier bringt, analysiert sie das Thema, bestimmt die Art des Inhalts (z. B. ob es sich um einen technischen oder historischen Text handelt) und entwirft dann eine optimale Erzählstruktur, ohne dabei starre Vorlagen zu verwenden.

- Fachkundige GliederungserstellungDas Tool generiert Gliederungen von Artikeln mit natürlichen, ansprechenden Kapitelüberschriften, die aussehen, als wären sie von einem Experten aus dem wirklichen Leben geschrieben worden, und nicht von kalten Aufgabenbeschreibungen.

- Arbeitsablauf zwischen Vorgesetztem und AusführendemEs gibt zwei Hauptfunktionen innerhalb des Systems, den "Forschungsdirektor" und den "Schreibdirektor". Sie beauftragen Führungskräfte mit der Durchführung bestimmter Forschungs- bzw. Schreibaufgaben, wodurch der gesamte Prozess klar und einfach zu kontrollieren ist.

- Genaue Zitierung und Abruf von InformationenDas heißt, dass nur die für das aktuelle Kapitel relevantesten Forschungsmaterialien abgefragt werden, um die Richtigkeit der Informationen zu gewährleisten.

- Zitierweise auf akademischem NiveauDas System übernimmt automatisch das Zitieren von Quellen. Es erzeugt anklickbare Zitiermarken im Text des Artikels (z.B.

[1]), und am Ende des Artikels wird eine einheitlich formatierte Liste der Referenzen erstellt. - Fortschrittsaktualisierungen in EchtzeitDas Back-End wird Informationen über den Fortschritt der Aufgabe, den Inhalt neu geschriebener Kapitel und Verweise in Echtzeit über die Server-Sent Events (SSE) Technologie an die Front-End-Schnittstelle weiterleiten.

- modernes TechnologiepaketDas Projekt verwendet aktuelle und beliebte Front-End- und Back-End-Technologien, wobei das Back-End stark auf Pythons FastAPI und LangGraph basiert und das Front-End React und TypeScript verwendet.

Hilfe verwenden

DeepSearch AI Agent ist ein separates Front-End- und Back-End-Projekt. Sie müssen das Back-End und das Front-End separat einrichten und starten. Hier sind die detaillierten Schritte, die zu befolgen sind, damit Sie es erfolgreich von Grund auf ausführen können.

Schritt 1: Vorbereitung

Bevor Sie beginnen, vergewissern Sie sich, dass Sie die folgende Software auf Ihrem Computer installiert haben:

Python(Version 3.9 oder höher)Node.js和npm(für den Betrieb des Frontends)Git(zum Klonen von Code-Repositorien)

Schritt 2: Abrufen des Projektcodes

Öffnen Sie Ihr Terminal (Command Prompt oder PowerShell unter Windows, Terminal unter macOS oder Linux) und klonen Sie das Code-Repository auf Ihren lokalen Computer.

git clone https://github.com/LordFoxFairy/deepseek_deepsearch_quickstart.git

Sobald das Klonen abgeschlossen ist, wechseln Sie in das Projektverzeichnis:

cd deepseek_deepsearch_quickstart

Schritt 3: Backend-Einrichtung

Das Back-End ist für die gesamte Verarbeitung der KI-Logik zuständig, einschließlich Planung, Recherche und Schreiben.

- Wechseln Sie in das Backend-Verzeichnis

Im Stammverzeichnis des Projekts (deepseek_deepsearch_quickstart), geben Sie zunächst diebackendKatalog.cd backend - Erstellen und Aktivieren einer virtuellen Python-Umgebung

Um die globale Python-Umgebung auf Ihrem Computer nicht zu verschmutzen, empfehlen wir dringend, eine virtuelle Umgebung zu erstellen.python -m venv venvDieser Befehl erstellt eine Datei namens

venvOrdner. Als nächstes müssen Sie es aktivieren:- 在 Windows Führen Sie auf dem System aus:

.\venv\Scripts\activate - 在 macOS 或 Linux Führen Sie auf dem System aus:

source venv/bin/activate

Nach erfolgreicher Aktivierung sehen Sie vor der Eingabeaufforderung im Terminal die

(venv)Die Worte. - 在 Windows Führen Sie auf dem System aus:

- Installation von Paketen mit Abhängigkeiten

Alle Python-Bibliotheken, die für das Backend benötigt werden, sind in derrequirements.txtDatei. Führen Sie den folgenden Befehl aus, um sie zu installieren:pip install -r requirements.txt - Konfigurieren des API-Schlüssels

Dieses Projekt benötigt die API-Schlüssel, damit das KI-Modell funktioniert. Sie müssen zwei wichtige API-Schlüssel konfigurieren.

Erstens, inbackend/src/finden Sie eine Datei namens.env.exampleder Datei. Sie müssen sie kopieren und umbenennen.env。- 在 Windows Auf:

copy .\src\.env.example .\src\.env - 在 macOS 或 Linux Auf:

cp src/.env.example src/.env

Öffnen Sie dann mit Ihrem Code-Editor diese neue

.envDatei sehen Sie Folgendes:# backend/src/.env # 用于 RAG 嵌入 DASH_SCOPE_API_KEY=sk-your-dashscope-api-key # 用于 LLM 推理 DEEPSEEK_API_KEY=sk-your-deepseek-api-key DEEPSEEK_BASE_URL=https://api.deepseek.comSie müssen die

sk-your-dashscope-api-key和sk-your-deepseek-api-keyErsetzen Sie ihn durch Ihren eigenen echten Schlüssel.DASH_SCOPE_API_KEYfür die Texteinbettung (RAG-Funktion).DEEPSEEK_API_KEYReasoning für große Sprachmodelle. - 在 Windows Auf:

Schritt 4: Frontend-Einrichtung

Das Front-End ist für die Bereitstellung der Schnittstelle für die Benutzerinteraktion verantwortlich.

- Wechseln Sie in das Front-End-Verzeichnis

Öffnen Sie ein neues Terminal-Fenster, oder kehren Sie zunächst im vorherigen Terminal zum Stammverzeichnis des Projekts zurück (cd ..), und gehen Sie dann zumfrontendKatalog.cd frontend - Installation von Paketen mit Abhängigkeiten

Das Frontend verwendet eine Node.js-Umgebung und die erforderlichen Abhängigkeiten sind in derpackage.jsonDatei. Führen Sie den folgenden Befehl zur Installation aus:npm installDieser Vorgang kann einige Minuten dauern.

Schritt 5: Starten Sie die Anwendung

Nun, da die Vorbereitungen für das Front- und Backend abgeschlossen sind, können wir die Anwendung starten. Sie müssen beide Terminalfenster gleichzeitig laufen lassen.

- Starten Sie den Backend-Dienst (im ersten Terminal)

Vergewissern Sie sich, dass Sie sich derzeit in derbackendund die virtuelle Python-Umgebung ist aktiviert. Führen Sie dann den folgenden Befehl aus:uvicorn src.api.main:app --host 0.0.0.0 --port 8000 --reloaduvicornist ein ASGI-Server zur Ausführung von FastAPI-Anwendungen.--host 0.0.0.0Machen Sie den Dienst in Ihrem LAN zugänglich.--port 8000Gibt die Portnummer des Dienstes an.--reloadgibt an, dass der Dienst automatisch neu gestartet wird, wenn sich die Codedatei ändert, was ideal für Entwicklungsumgebungen ist.

- Starten Sie den Front-End-Dienst (in einem zweiten Terminal)

Vergewissern Sie sich, dass Sie sich derzeit in derfrontendVerzeichnis. Führen Sie dann den folgenden Befehl aus:npm run devDieser Befehl startet einen lokalen Entwicklungsserver, der normalerweise auf die

5173Häfen.

Schritt 6: Das Erlebnis beginnen

Wenn beide Dienste erfolgreich gestartet wurden, öffnen Sie Ihren Browser und besuchen Sie die folgende Adresse:

http://localhost:5173

Jetzt sollten Sie die Schnittstelle des DeepSearch AI Agent sehen können. Geben Sie in das Eingabefeld ein Thema ein, zu dem Sie einen Artikel erstellen möchten, und klicken Sie auf "Senden". Die KI startet ihren "Think-Plan-Research-Write"-Prozess und zeigt ihren Arbeitsfortschritt und den fertigen Artikel in Echtzeit auf der Benutzeroberfläche an.

Anwendungsszenario

- Ersteller von Inhalten

Für Einzelpersonen oder Teams, die ausführliche Artikel, Anleitungen oder Blogs schreiben müssen, kann dieses Tool als leistungsstarker Ausgangspunkt dienen. Die Benutzer müssen nur ein Kernthema angeben, und die KI recherchiert automatisch die Informationen, plant die Struktur und schreibt den ersten Entwurf, was die Effizienz und Qualität der Inhaltserstellung erheblich verbessert. - Technische Dokumentation

Softwareentwickler oder technische Redakteure können damit schnell erste Entwürfe für technische Dokumentationen erstellen. Geben Sie beispielsweise eine Anfrage zur Verwendung einer bestimmten API ein, und das System kann automatisch eine vollständige Anleitung mit Hintergrundinformationen, Installationsschritten, Funktionsdetails und Codebeispielen erstellen. - Bildung und Ausbildung

Lehrkräfte oder Ausbilder können mit diesem Tool schnell Lernmaterialien für ihre Kurse erstellen. Ob es sich um eine detaillierte Darstellung eines historischen Ereignisses oder eine laienhafte Erklärung eines komplexen wissenschaftlichen Konzepts handelt, AI erstellt klar strukturierte und informative Artikel, die als Lehrmaterial oder ergänzende Lektüre verwendet werden können.

QA

- Ist dieses Programm kostenpflichtig?

Das Projekt selbst ist quelloffen und kann kostenlos genutzt werden. Es stützt sich jedoch auf KI-Modellierungsdienste von Drittanbietern (wie DeepSeek und DashScope). Sie benötigen API-Schlüssel für diese Dienste und müssen für API-Aufrufe auf der Grundlage der Preisstrategie dieser Dienstanbieter bezahlen. - Kann ich es durch ein anderes großes Sprachmodell ersetzen?

können. Die Architektur dieses Projekts ist so konzipiert, dass sie flexibel und mit allen Arten von großen Sprachmodellen kompatibel ist. Sie können den Teil des Codes im Backend modifizieren, der das Modell aufruft, um es durch Ihr bevorzugtes Modell zu ersetzen, z. B. die GPT-Familie von OpenAI oder andere Modelle. - Wie wird die Qualität der generierten Artikel sichergestellt?

Das System gewährleistet die Qualität durch ein "Supervisor-Performer"-Modell. Es beginnt mit einer gründlichen Rechercheplanung und nutzt dann die RAG-Technologie (Retrieval Augmentation Generation), um sicherzustellen, dass die Inhalte auf genauen Quellen beruhen. Gleichzeitig werden Zitate und Verweise automatisch verarbeitet, um die Nachvollziehbarkeit der Inhalte zu gewährleisten.