DeepInfra ist eine Cloud-Plattform, die KI-Modellabrufdienste für Entwickler bereitstellt. Sie ermöglicht es den Nutzern, über eine einfache API-Schnittstelle auf eine Vielzahl gängiger Open-Source-KI-Modelle zuzugreifen und diese auszuführen, darunter Meta Llama 3, Mistral AI und Google Gemma. Das wichtigste Merkmal dieser Plattform ist "Serverless", was bedeutet, dass Benutzer keine komplexe Server-Hardware bereitstellen und warten müssen und direkt für die Menge der Nutzung bezahlen können, was die Schwelle für die Entwicklung, den Betrieb und die Wartung von KI-Anwendungen erheblich reduziert. DeepInfra Chat ist eine von der Plattform bereitgestellte intuitive Demoseite, auf der die Nutzer direkt mit den verschiedenen großen Sprachmodellen auf der Plattform sprechen und die Leistung und Eigenschaften der verschiedenen Modelle erleben können. Sie zeigt Entwicklern auch die realen Ergebnisse ihrer API-Dienste, so dass sie Modelle für die Integration in ihre eigenen Anwendungen schnell testen und bewerten können.

Funktionsliste

- Unterstützung mehrerer Modelle:: Die Plattform bietet eine Fülle von Open-Source-Modellen für große Sprachen, aus denen die Benutzer wählen können, wie z. B. Llama, Mistral, Gemma und andere Modellfamilien.

- Online-Chat-SchnittstelleBietet ein übersichtliches Web-Chat-Fenster, in dem Benutzer direkt mit ausgewählten KI-Modellen zu Testzwecken interagieren können - ohne Registrierung oder Konfiguration.

- API-AufrufdienstDie Kernfunktion besteht darin, Entwicklern eine stabile und skalierbare API-Schnittstelle zur Verfügung zu stellen, mit der sie die Fähigkeiten von KI-Modellen einfach in ihre eigene Software oder Dienste integrieren können.

- nach Bedarf zahlenAbrechnungsmodell pro Nutzung (in der Regel pro Tokenanzahl): Die Nutzer zahlen nur für die tatsächlich verbrauchten Rechenressourcen, was kostengünstig ist.

- Sofort einsatzbereit für Produktionsumgebungen: bietet eine skalierbare, produktionsreife Infrastruktur mit niedriger Latenz, in der sich die Entwickler nicht mit der Komplexität von Machine Learning Operations (ML Ops) befassen müssen.

- Integration von Entwickler-ToolsUnterstützt die Integration in gängige KI-Entwicklungsframeworks wie LangChain und LlamaIndex und vereinfacht so die Erstellung komplexer KI-Anwendungen.

Hilfe verwenden

DeepInfra Chat richtet sich an zwei Arten von Nutzern: allgemeine Nutzer, die schnell verschiedene große Sprachmodelle kennenlernen und überprüfen möchten, und Entwickler, die KI-Modellfunktionen in ihre Produkte integrieren müssen. Im Folgenden wird beschrieben, wie die beiden Typen zu verwenden sind.

1. webbasierte Chat-Funktion (schnelle Erfahrung)

Für diejenigen, die die Dialogfähigkeiten des KI-Modells direkt erleben wollen, ist es sehr einfach zu bedienen:

- Zugang zur WebsiteÖffnen Sie die Website im Browser.

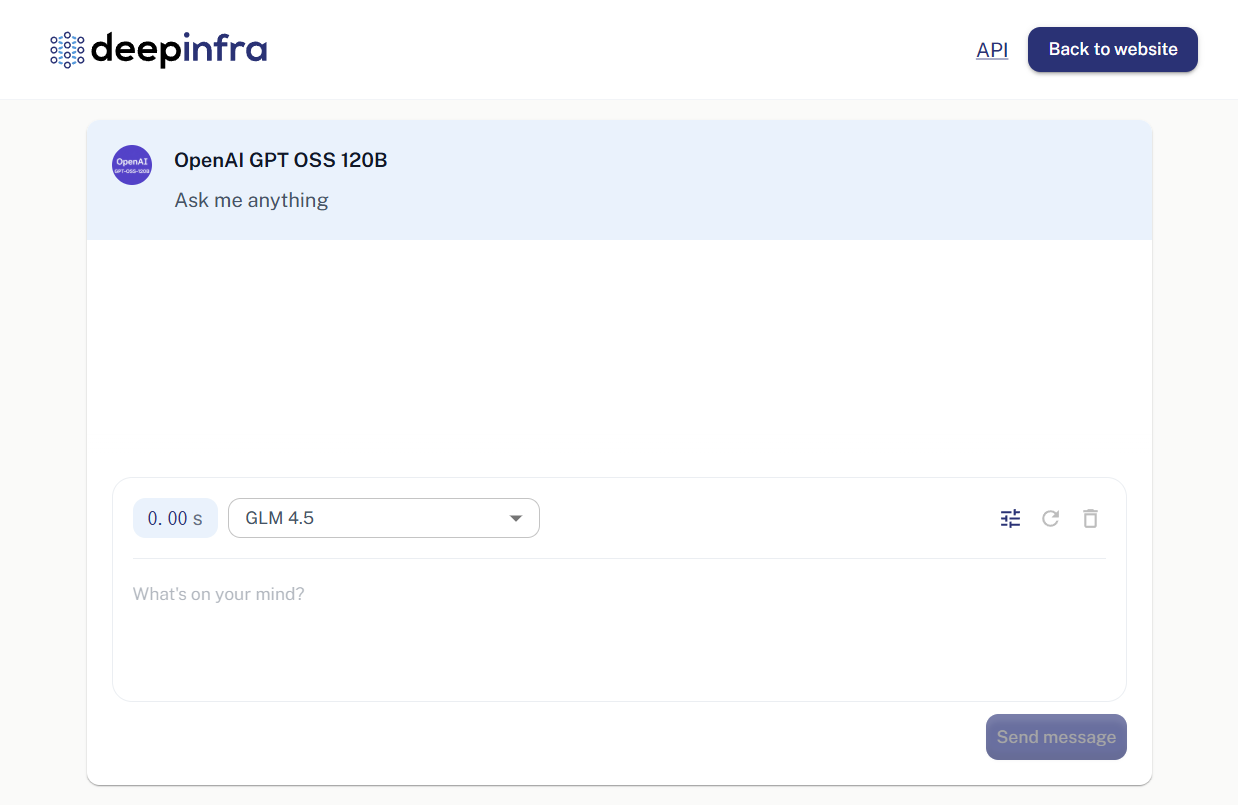

https://deepinfra.com/chat。 - Modell auswählenWenn die Seite geladen ist, sehen Sie ein Chat-Interface. Oben auf der Oberfläche wird normalerweise der Name des aktuell verwendeten Modells angezeigt (z. B. "OpenAI GPT OSS 120B"). Sie können auf den Modellnamen klicken, um zwischen anderen Modellen zu wechseln, die Sie interessieren, z. B. die Llama 3 oder Mistral-Serie, indem Sie sie aus der Dropdown-Liste auswählen.

- Aufnahme eines Dialogs: Geben Sie in das Eingabefeld unten auf der Seite die Fragen ein, die Sie stellen möchten, oder die Dinge, die Sie sagen möchten, und drücken Sie dann die Eingabetaste oder klicken Sie auf die Schaltfläche Senden.

- Antwort anzeigenDie Antworten des KI-Modells werden direkt im Chatfenster angezeigt. Sie können weiterhin Fragen stellen und mehrere Dialogrunden durchführen, um die logischen, sprachlichen und intellektuellen Fähigkeiten des Modells zu testen.

Dieser Prozess erfordert keine Anmeldung oder Konfiguration und eignet sich hervorragend für die schnelle Überprüfung von Modellen.

2. der API-Aufrufdienst (von Entwicklern genutzt)

Der Kernwert von DeepInfra für Entwickler sind seine leistungsstarken API-Dienste. Sie können die Fähigkeiten dieser KI-Modelle über die API in Ihre Website, App oder Ihren Back-End-Dienst integrieren.

Schritt 1: Erstellen Sie ein Konto und erhalten Sie einen API-Schlüssel

- Registrieren/LoginDeepInfra-Website besuchen

https://deepinfra.com/können Sie sich normalerweise direkt mit Ihrem GitHub-Konto anmelden. - API-Schlüssel generierenNachdem Sie sich angemeldet haben, gehen Sie zu Ihrem Konto-Dashboard und suchen Sie die Seite zur Verwaltung der API-Schlüssel (normalerweise der Pfad zum

https://deepinfra.com/dash/api_keys)。 - Erstellen eines neuen SchlüsselsKlicken Sie auf die Schaltfläche "Neuer API-Schlüssel", geben Sie Ihrem Schlüssel einen Namen (z. B. "MyTestApp") und klicken Sie auf Generieren.

- Speichern Sie den SchlüsselDas System erzeugt eine Zeichenkette, die mit

di-Zeichen am Anfang, das Ihren API-Schlüssel darstellt.Bitte kopieren Sie es sofort und bewahren Sie es sicher auf.Aus Sicherheitsgründen wird dieser vollständige Schlüssel nur einmal angezeigt.

Schritt 2: Aufrufen der API

Die API-Endpunkte von DeepInfra sind mit dem Format von OpenAI kompatibel, was die Migration und Nutzung vereinfacht. Der Haupt-Chat-API-Endpunkt ist:

https://api.deepinfra.com/v1/openai/chat/completions

Sie können es mit jedem Tool oder jeder Programmiersprache aufrufen, die HTTP-Anfragen unterstützt.

ausnutzen curl Ein einfaches Beispiel für diesen Befehl:

Öffnen Sie Ihr Terminal, und ersetzen Sie die {YOUR_API_KEY} und ersetzen ihn durch den Schlüssel, den Sie gerade erzeugt haben.{MODEL_ID} Ersetzen Sie sie durch die ID des Modells, das Sie aufrufen möchten (z. B. meta-llama/Meta-Llama-3-8B-Instruct)。

curl -X POST https://api.deepinfra.com/v1/openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer {YOUR_API_KEY}" \

-d '{

"model": "{MODEL_ID}",

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

]

}'

Beispiel für die Verwendung von Python:

Sie müssen die requests Bibliothek ( pip install requests )。

import requests

import json

# 替换成你的API密钥

api_key = "{YOUR_API_KEY}"

# 替换成你想使用的模型ID

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

url = "https://api.deepinfra.com/v1/openai/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": model_id,

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

],

"stream": False # 如果需要流式输出,可以设置为True

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

# 打印出模型返回的内容

print(result['choices'][0]['message']['content'])

else:

print(f"请求失败,状态码: {response.status_code}")

print(response.text)

Sie finden die offizielle DeepInfra-Dokumentation für alle unterstütztenModell-ID-Liste。

Anwendungsszenario

- AI Chatbot Entwicklung

Erstellen Sie Kundenservice-Bots, intelligente Assistenten oder domänenspezifische Q&A-Bots für Websites, Apps oder interne Systeme. Entwickler haben die Möglichkeit, je nach Kosten- und Leistungsanforderungen verschiedene Modelle zu wählen. - Unterstützung bei der Erstellung von Inhalten

Nutzen Sie die Texterstellungsfunktionen des Modells, um das Schreiben von Marketingtexten, Blogbeiträgen, Code, E-Mails oder Textverbesserungen zu unterstützen. - Bildung und Forschung

Forscher und Studenten können die Plattform nutzen, um auf einfache Weise eine breite Palette modernster Open-Source-KI-Modelle aufzurufen und zu testen, ohne dass hohe Hardwarekosten anfallen. - Schnelle Überprüfung von Prototypen

Produktmanager und Entwickler können DeepInfra in den frühen Phasen der Produktentwicklung nutzen, um schnell einen Prototyp zu erstellen, der KI-Funktionen zur Validierung von Funktionen und zur Demonstration von Ergebnissen enthält.

QA

- Ist der DeepInfra Chat kostenlos?

Die Webversion des Chats ist kostenlos, unterliegt jedoch gewissen Nutzungsbeschränkungen und wird hauptsächlich für Funktionsdemonstrationen und Modellüberprüfungen verwendet. Wenn der Anruf über die API erfolgt, müssen Sie je nach ausgewähltem Modell und der Anzahl der angeforderten Token zahlen, und die Plattform stellt eine bestimmte Menge an kostenlosen Test-Rechenressourcen zur Verfügung. - Welche AI-Modelle kann ich verwenden?

DeepInfra unterstützt eine breite Palette von Mainstream-Open-Source-Modellen für große Sprachen, einschließlich, aber nicht beschränkt auf die Llama-Serie von Meta (z. B. Llama 3), die Modelle von Mistral AI, Gemma von Google und CodeLlama sowie andere Modelle, die sich auf die Codegenerierung konzentrieren. Die spezifische Liste der unterstützten Modelle kann auf der offiziellen Website eingesehen werden. - Wer sind die Hauptnutzer dieser Plattform?

Es richtet sich an Entwickler von KI-Anwendungen, Technologieforscher und Unternehmen, die KI-Funktionen in ihr bestehendes Geschäft integrieren möchten. Außerdem eignet sich die Web-Chat-Funktion für jeden normalen Nutzer, der sich für KI-Technologie interessiert und verschiedene Modellfunktionen kennenlernen möchte. - Muss ich meinen eigenen Server für die Nutzung der API konfigurieren?

DeepInfra ist eine "serverlose" Plattform, die alle Modelle hostet, ausführt und elastisch skaliert. Die Entwickler müssen lediglich Anfragen über API-Schlüssel initiieren und sich nicht um die zugrunde liegende Hardware und den Betrieb kümmern.