Vorwort: Bauen Sie Ihr eigenes KI-Agentenstudio

Coze Studio ist eine Low-Code-Entwicklungsplattform für KI-Agenten, die von ByteDance zur Verfügung gestellt wird. Sie bietet ein visuelles Toolset, mit dem Entwickler KI-Intelligenzen, -Anwendungen und -Workflows mit einem Minimum an Code schnell erstellen, debuggen und bereitstellen können. Dieser Ansatz senkt nicht nur die technische Schwelle, sondern bietet auch eine solide Grundlage für die Entwicklung hochgradig individueller KI-Produkte.

Ein KI-Agent ist ein intelligentes Programm, das die Absicht des Benutzers versteht und komplexe Aufgaben selbstständig plant und ausführt. Lokal einsetzen Coze StudioDas bedeutet, dass Sie die vollständige Kontrolle über Ihre Daten und Modelle haben, was einen hervorragenden Datenschutz und eine hohe Flexibilität bei der Entwicklung und beim Experimentieren ermöglicht.

Das Back-End der Plattform verwendet GolangDas vordere Ende ist React + TypeScript Die Kombination, die insgesamt auf einer Microservices- und Domain-Driven-Design (DDD)-Architektur basiert, gewährleistet die hohe Leistung und Skalierbarkeit des Systems.

Dieser Artikel führt Sie durch Coze Studio Open Source Edition für die lokale Bereitstellung und konfigurieren Sie die Verbindung mit dem lokalen Ollama zu OpenRouter von Modellierungsdienstleistungen.

1. die Installation von Ollama: haben Sie Ihr eigenes, großes Modell

Ollama ist ein leichtgewichtiges, erweiterbares Framework für die Ausführung großer nativer Sprachmodelle. Es vereinfacht die Ausführung der Llama 3, Qwen 和 Gemma und andere Modellierungsverfahren. Haben OllamaSie können KI nutzen, um private Daten in einer vollständigen Offline-Umgebung zu verarbeiten, ohne auf Cloud-Dienste von Drittanbietern angewiesen zu sein, und so ein Gleichgewicht zwischen Sicherheit und Kosten herstellen.

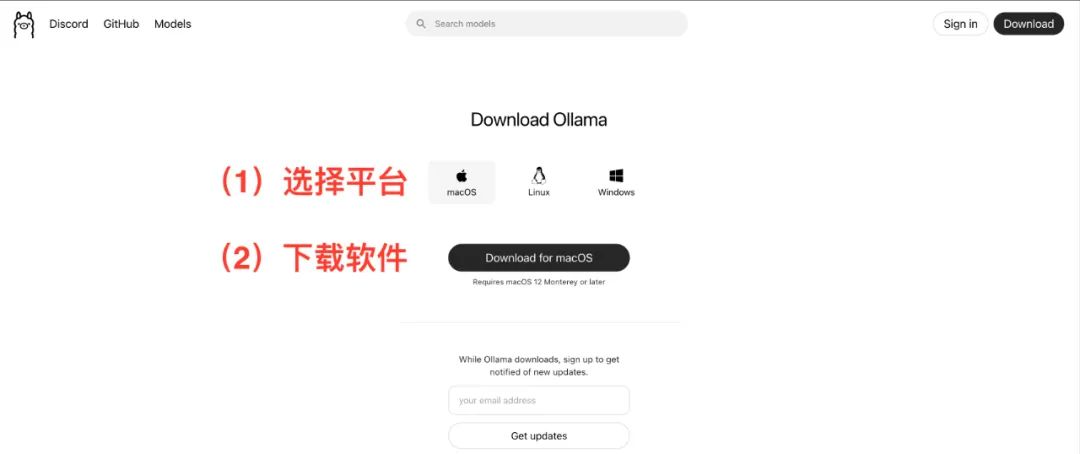

Interviews https://ollama.com/Laden Sie den entsprechenden Client für Ihr Betriebssystem (macOS, Linux, Windows) herunter und installieren Sie ihn. Der Installationsprozess ist sehr intuitiv, folgen Sie einfach dem Assistenten.

Pull-Modell

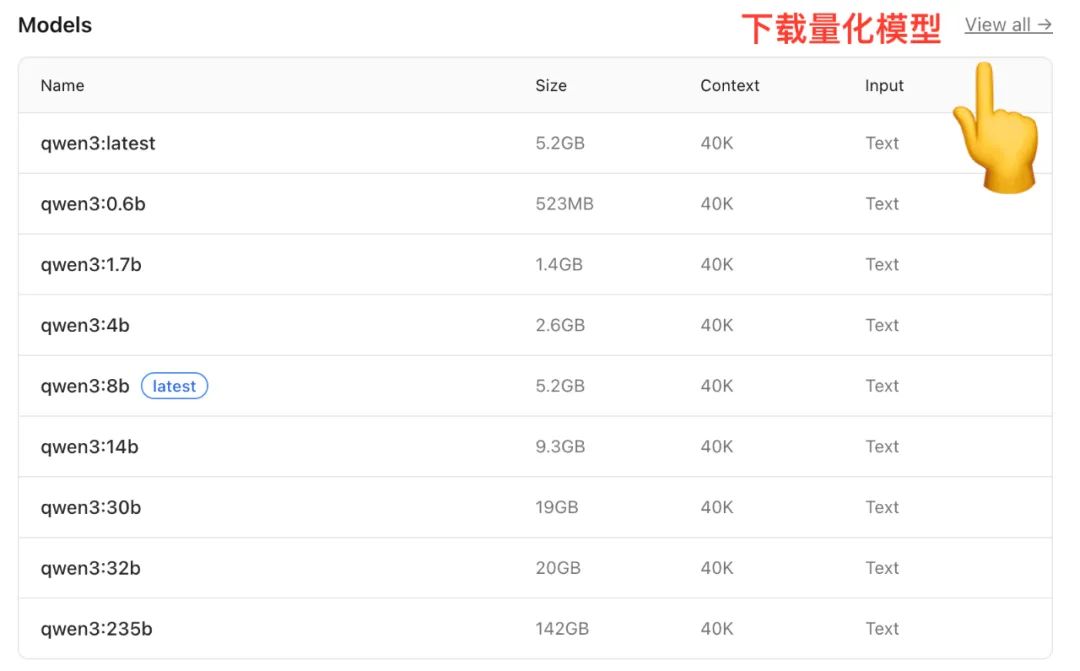

Nachdem die Installation abgeschlossen ist, müssen Sie mit dem Ollama um ein Modell lokal aus der Modellbibliothek des Nehmen Sie die Qwen Die Modellbibliothek bietet zum Beispiel Versionen mit unterschiedlichen Parameterskalen.

(Bildquelle: https://ollama.com/library/qwen)

Modelle unterschiedlicher Größe haben unterschiedliche Anforderungen an den Arbeitsspeicher (RAM), was bei der Auswahl zu berücksichtigen ist:

- Modell 7BEmpfohlen: 16GB RAM

- 14B ModellEmpfohlen: 32GB RAM

- Modell 72BEmpfohlen: 64GB RAM

Viele Modelle bieten auchQuantifizierung Version. Quantisierung ist eine Technik zur Verringerung der Modellgröße und des Speicherplatzbedarfs durch Reduzierung der Gewichtungsgenauigkeit bei gleichbleibender Modellleistung, so dass die Modelle effizienter auf Consumer-Hardware ausgeführt werden können.

Öffnen Sie ein Terminal (Terminal oder Eingabeaufforderung) und geben Sie den folgenden Befehl ein, um ein mittelgroßes Modell zu ziehen:

ollama run qwen:14b

Mit diesem Befehl wird das angegebene Modell automatisch aus der Cloud heruntergeladen und dekomprimiert. Die genaue Zeit, die dafür benötigt wird, hängt von den Netzwerkbedingungen ab.

2. die Installation von Docker: ein standardisiertes Tool für die Anwendungsbereitstellung

Docker ist eine Containerisierungstechnik, die eine Anwendung und alle ihre Abhängigkeiten in einen standardisierten, portablen "Container" packt. Kurz und bündig.Docker Es ist wie ein standardisierter Container, und Coze Studio Es ist die Ladung, die wir verladen. Von DockerWir können leicht eine neue Version zu jeder der unterstützten Versionen hinzufügen Docker auf einem Rechner mit dem Coze StudioSie müssen sich keine Gedanken über komplexe Umgebungskonfigurationen und Abhängigkeitskonflikte machen.

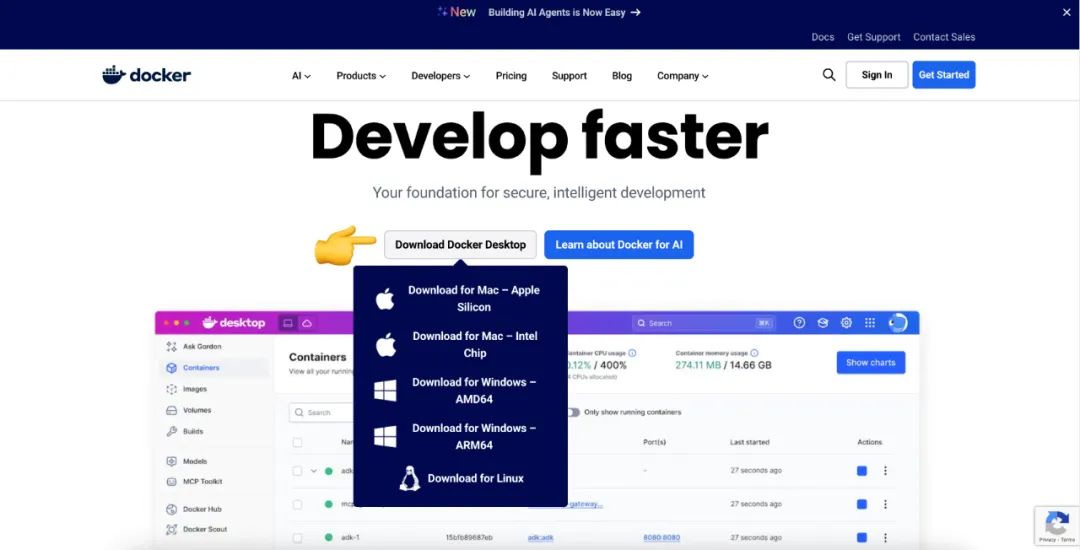

Interviews https://www.docker.com/Herunterladen und installieren Docker DesktopEs bietet auch eine grafische Installationsschnittstelle für macOS, Linux und Windows. Es bietet auch eine grafische Installationsschnittstelle für macOS, Linux und Windows.

3. lokaler Einsatz von Coze Studio

3.1 Umweltanforderungen

- SoftwareVergewissern Sie sich, dass der Rechner mindestens eine 2-Kern-CPU und 4 GB RAM hat.

- HardwareVor-Installation

Docker、Docker Composeund sicherzustellen, dassDockerDer Dienst wurde gestartet.

3.2 Beschaffung des Coze Studio-Quellcodes

Wenn das Gerät installiert wurde GitUmsetzung git clone ist der direkteste Weg, um den Quellcode zu erhalten.

git clone https://github.com/coze-dev/coze-studio.git

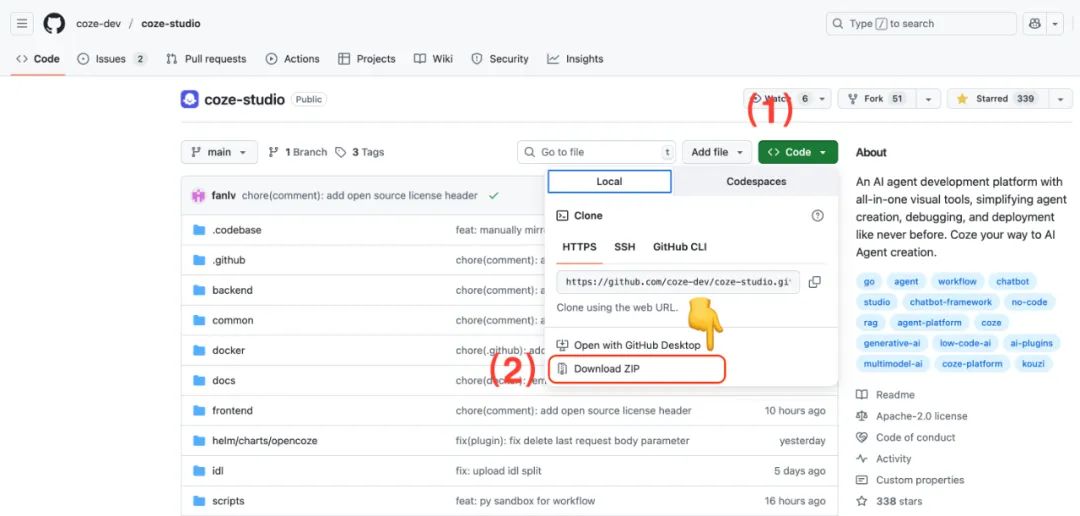

Falls nicht installiert GitSie können die Informationen auch direkt von der GitHub Seite, um das ZIP-Archiv herunterzuladen.

3.3 Konfigurieren von Modellen für Coze Studio

Coze Studio Es werden mehrere Modellierungsdienste unterstützt, darunter Ark(Arche Vulkan)OpenAI、DeepSeek、Claude、Ollama、Qwen 和 Gemini。

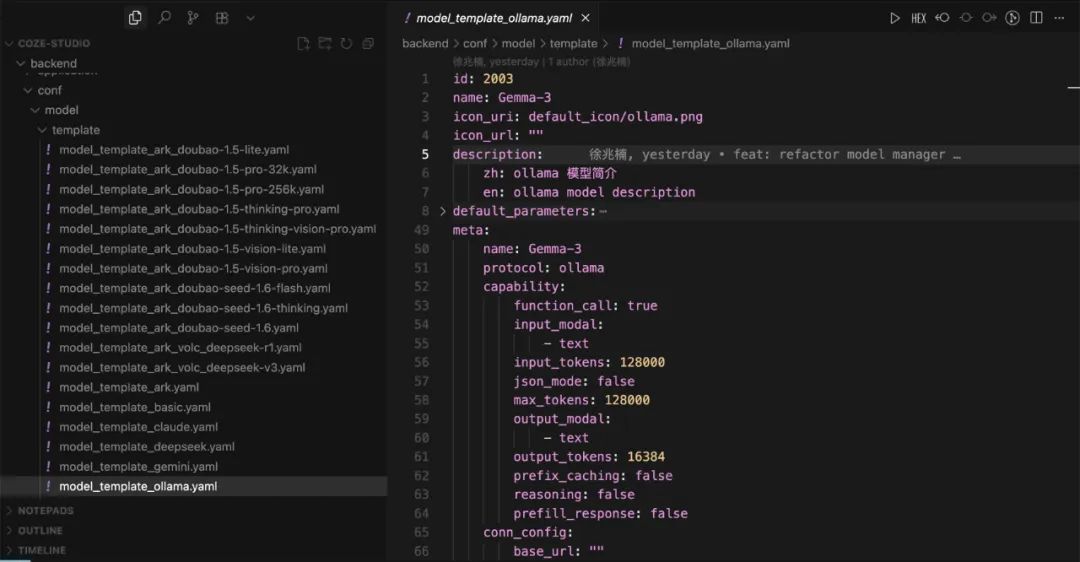

Öffnen Sie mit dem Code-Editor die Datei coze-studio Projekt. Unter backend/conf/model/template Verzeichnis, das Konfigurationsvorlagen für die verschiedenen Modelldienste enthält.

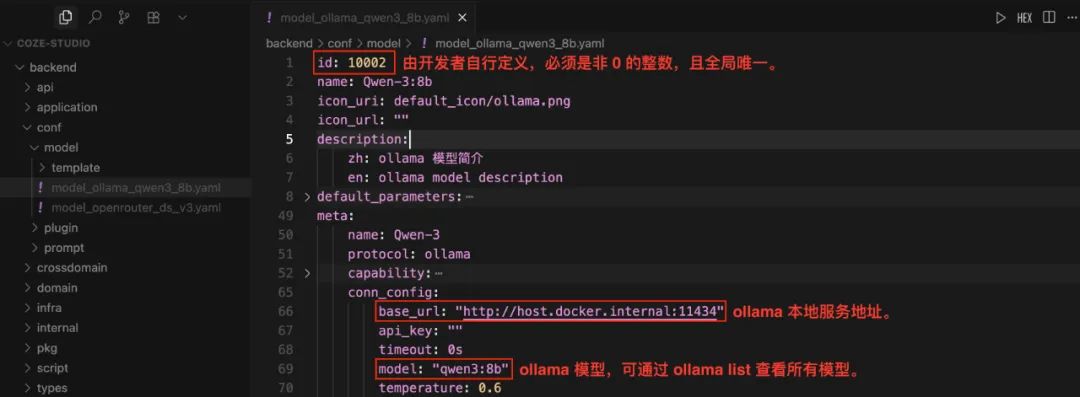

Konfigurieren des lokalen Ollama-Modells

- 将

model_template_ollama.yamlDie Vorlagendateien werden in das Verzeichnisbackend/conf/modelKatalog. - Benennen Sie ihn um, z. B.

model_ollama_qwen14b.yaml。 - Bearbeiten Sie diese Datei, um die

qwen:14bModell als Beispiel:

Achtung!id Die Felder müssen global eindeutige Ganzzahlen sein, die nicht Null sind. Bei Modellen, die bereits online sind, ändern Sie nicht ihre idsonst wird der Aufruf fehlschlagen. Vor der Konfiguration können Sie Folgendes ausführen ollama list um die lokal verfügbaren Modelle anzuzeigen.

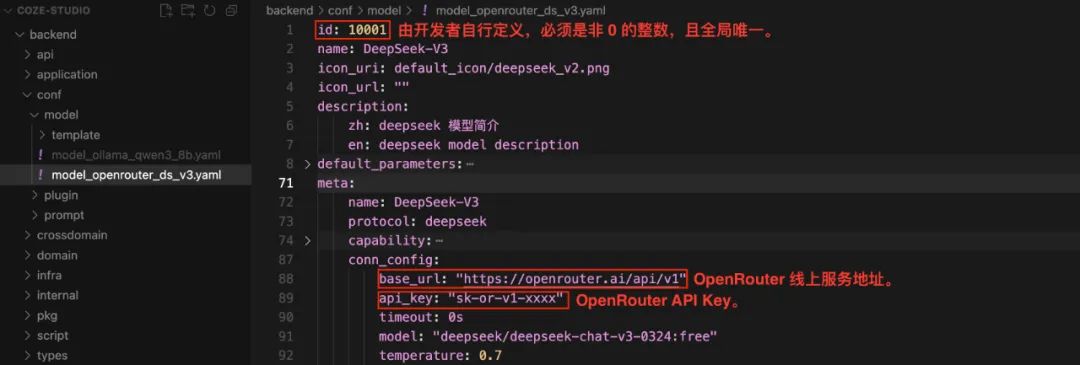

Konfigurieren des OpenRouter-Modells

OpenRouter Es handelt sich um einen Modellaggregationsdienst, der es Entwicklern ermöglicht, mehrere Modelle verschiedener Anbieter über eine einheitliche API-Schnittstelle aufzurufen, wodurch die Verwaltung von API-Schlüsseln und der Modellwechselprozess vereinfacht werden.

- 将

model_template_deepseek.yamlDie Vorlagendateien werden in das Verzeichnisbackend/conf/modelKatalog. - umbenennen

model_openrouter_ds_v2.yaml。 - Bearbeiten Sie die Datei, um die

DeepSeek-V2Als Beispiel, und füllen Sie die Informationen aus derOpenRoutererworbenapi_key。

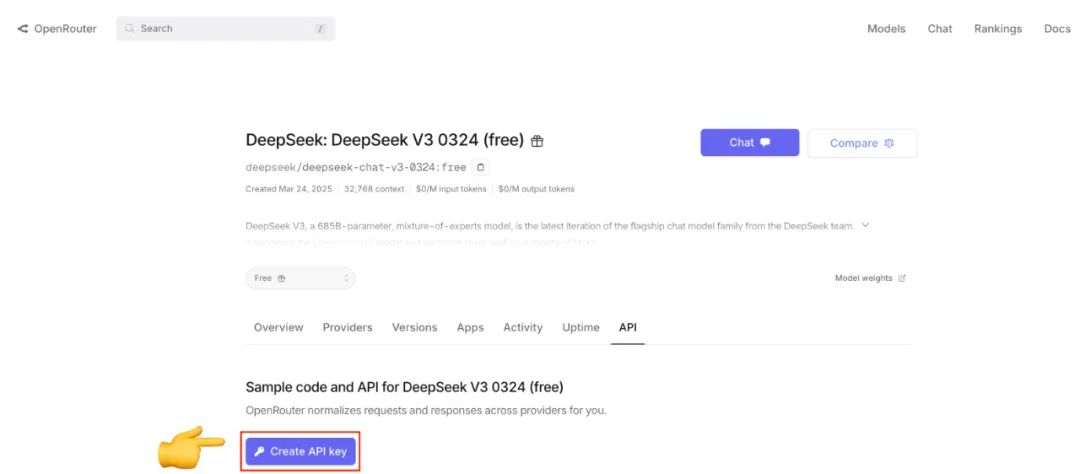

Falls noch nicht geschehen OpenRouter API-Schlüssel, der auf der offiziellen Website des Unternehmens registriert und erstellt werden kann.

3.4 Dienste einrichten und starten

Nachdem Sie das Modell konfiguriert haben, gehen Sie zur Projektseite docker und führen Sie dann den folgenden Befehl aus:

cd docker

cp .env.example .env

docker compose --profile '*' up -d

--profile '*' stellt sicher, dass der Parameter docker-compose.yml Alle in der Datei definierten Dienste (einschließlich optionaler Dienste) werden gestartet. Bei der ersten Bereitstellung wird das Image gezogen und erstellt, was viel Zeit in Anspruch nimmt.

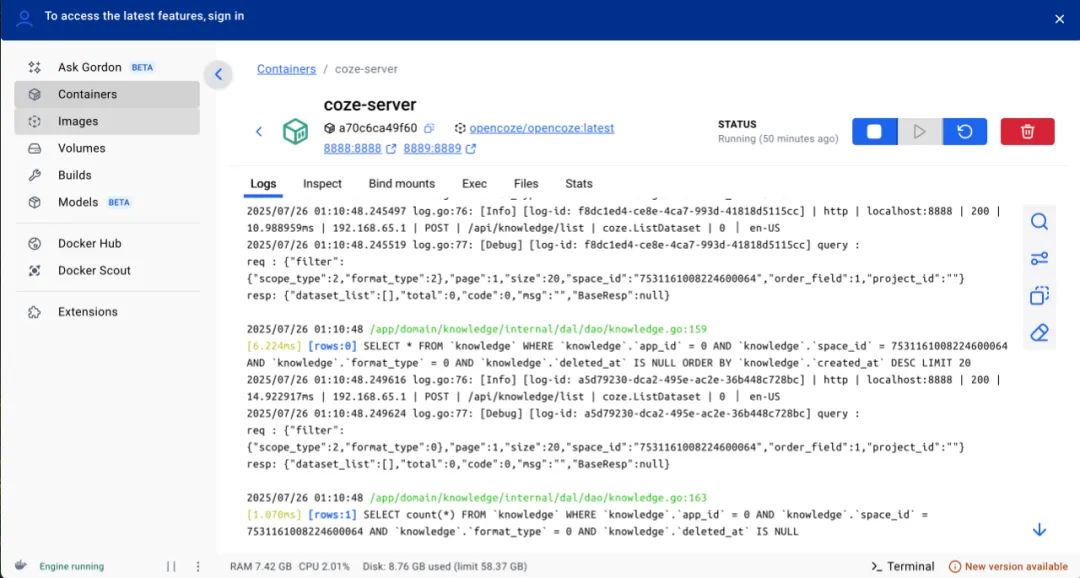

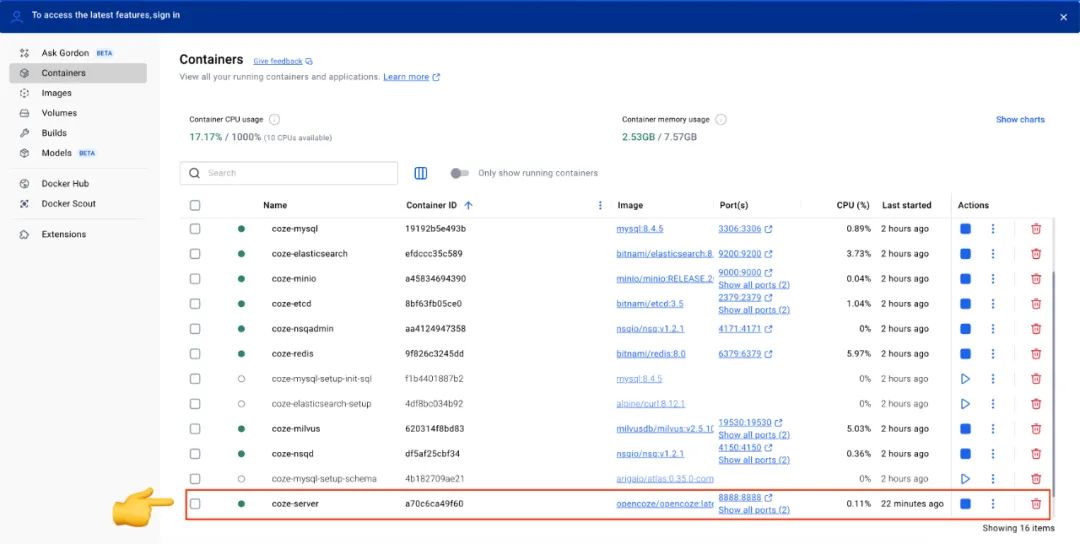

Nach dem Start des Docker Desktop um den Status aller Dienste in der Schnittstelle des Wenn die coze-server Die Statusanzeige des Dienstes wird grün, was bedeutet, dass der Coze Studio wurde erfolgreich gestartet.

Nach jeder Änderung der Konfigurationsdatei müssen Sie den folgenden Befehl ausführen, um den Dienst neu zu starten, damit die Konfiguration wirksam wird:

docker compose --profile '*' restart coze-server

3.5 Verwendung von Coze Studio

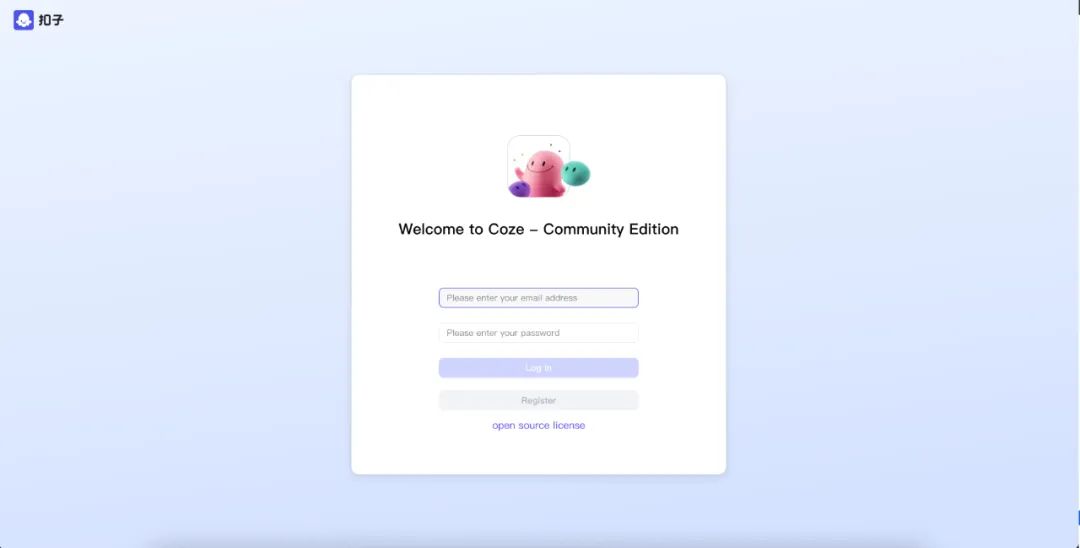

Nachdem der Dienst gestartet ist, rufen Sie ihn in Ihrem Browser auf http://localhost:8888/。

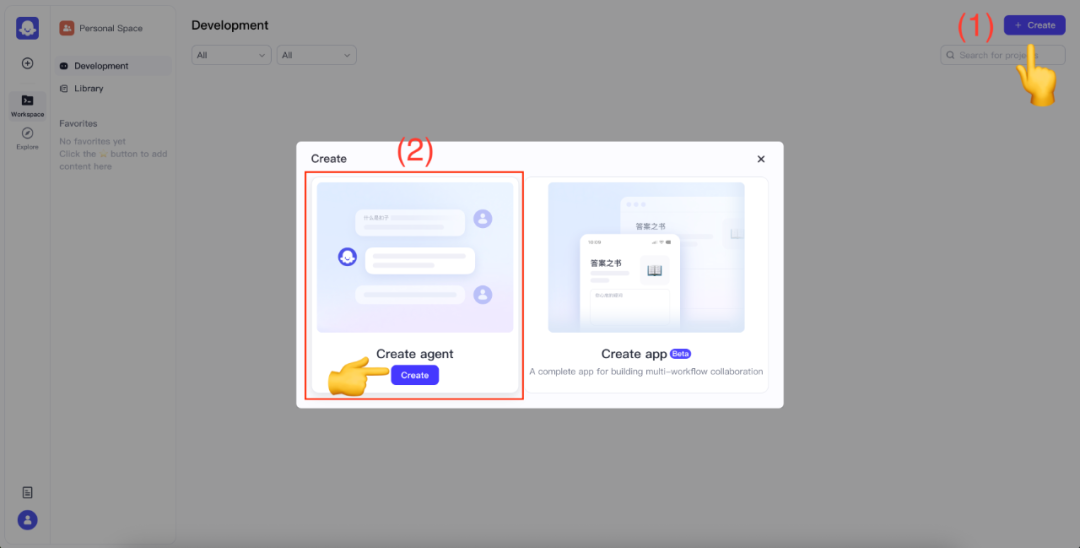

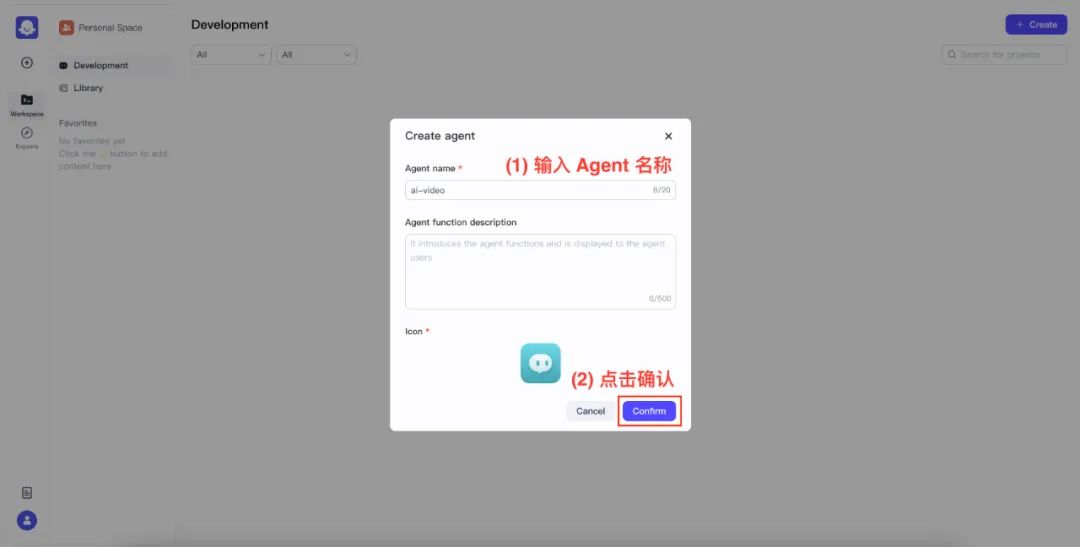

Geben Sie bei der erstmaligen Nutzung Ihre E-Mail-Adresse und Ihr Passwort ein, um sich als neuer Benutzer zu registrieren. Nachdem Sie sich erfolgreich angemeldet haben, klicken Sie auf die obere rechte Ecke des Fensters Create Taste, wählen Sie Create agent。

Benennen und bestätigen Sie Ihren Agenten.

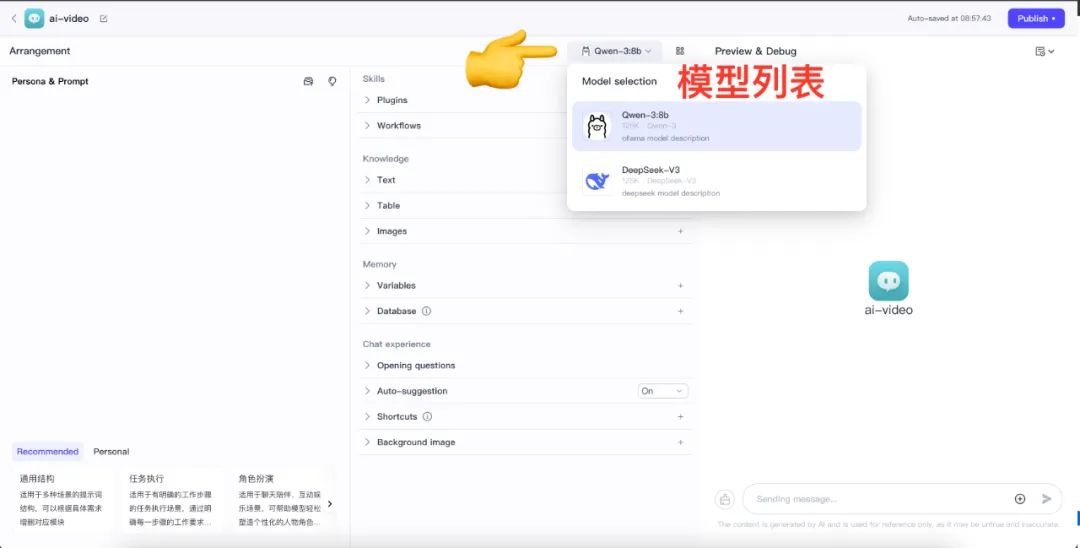

Sobald Sie sich im Bildschirm Agent Design befinden, klicken Sie auf die Modellliste, um alle konfigurierten Modelle zu sehen.

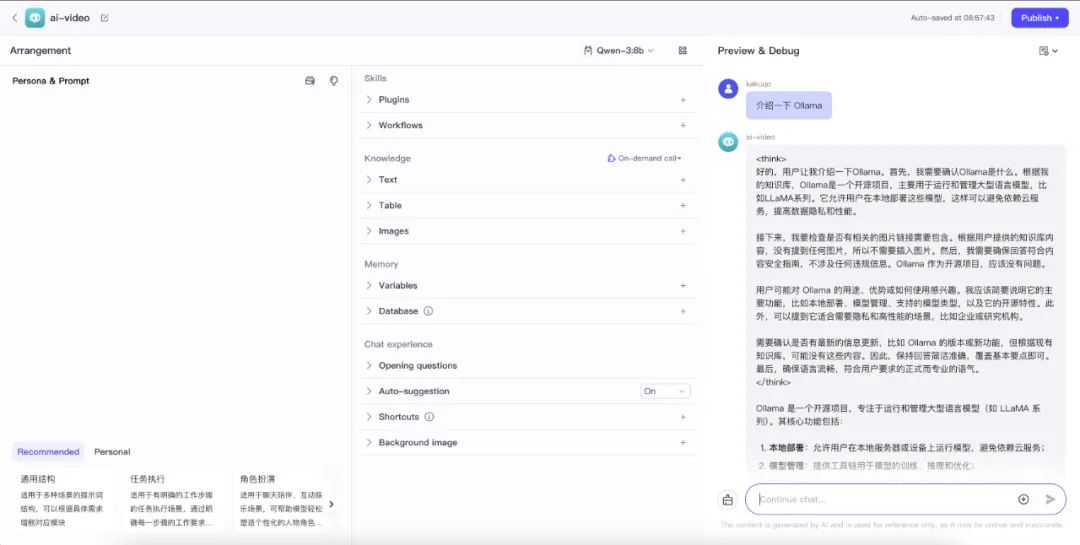

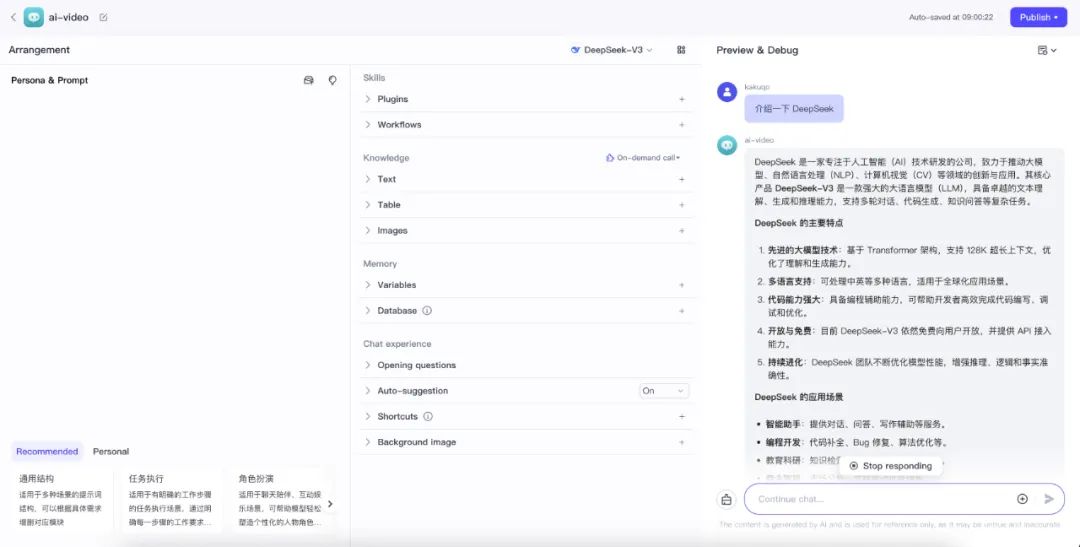

Das Modell kann nun mit Hilfe des Chat-Feldes unten rechts getestet werden, um zu sehen, ob es richtig funktioniert.

- Test Lokales Ollama

qwen:14bDienstleistung

- Testen von OpenRouter über das Kabel

DeepSeek-V2Dienstleistung

Wenn eine Anrufausnahme auftritt, wird die Docker Desktop auschecken coze-server Protokolle des Containers zur Fehlersuche.