Core ist ein von RedPlanetHQ entwickeltes Open-Source-Tool, das personalisierte Speichermöglichkeiten für große Modelle (LLMs) bieten soll. Mit Core können Benutzer ihre eigenen Memory Maps erstellen und verwalten und Text, Dialoge oder andere Daten in einer privaten Wissensdatenbank speichern. Das Tool unterstützt die Speicherung von Aufzeichnungen über Benutzerinteraktionen mit dem großen Modell, um strukturierte Speicherknoten zu bilden, die später einfach abgefragt oder mit anderen Tools verbunden werden können.Core wurde mit Blick auf die Einfachheit sowohl für Entwickler als auch für Gelegenheitsnutzer entwickelt. Es wird über ein intuitives Dashboard bedient und unterstützt sowohl die lokale Bereitstellung als auch Cloud-Dienste, um den Anforderungen verschiedener Nutzer gerecht zu werden. Das Projekt befindet sich derzeit in einer aktiven Entwicklungsphase mit kontinuierlichen Verbesserungen, insbesondere im Hinblick auf die Speicheroptimierung von großen Modellen.

Funktionsliste

- SpeicherplatzSpeichern eines vom Benutzer eingegebenen Textes oder Dialogs in einem privaten Wissensgraphen.

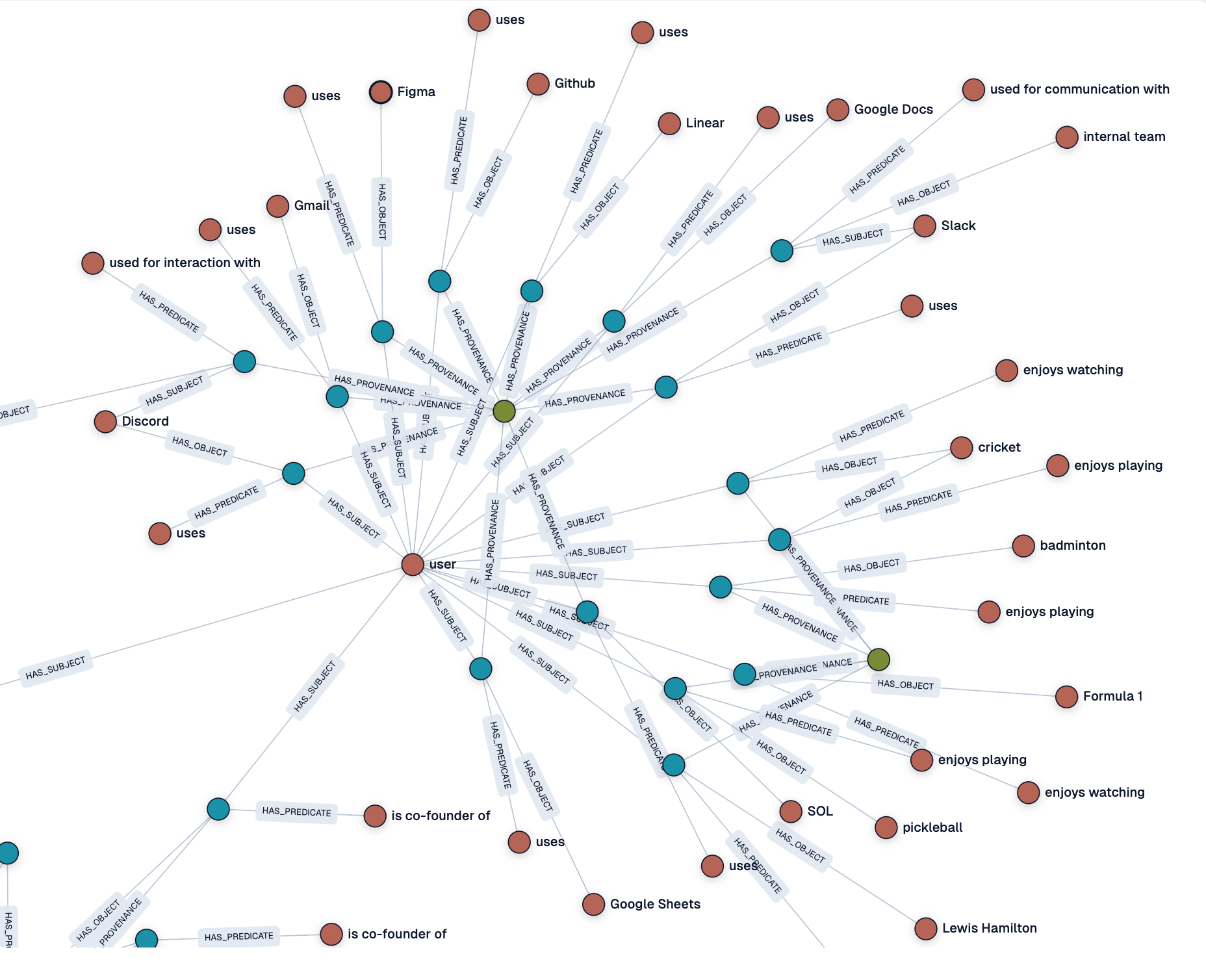

- Generierung von WissensgraphenAutomatisches Umwandeln von Eingaben in strukturierte Speicherknoten zum einfachen Abruf.

- Dashboard-VerwaltungBietet eine visuelle Schnittstelle zur Anzeige und Verwaltung der Knoten und des Zustands der Memory Map.

- Unterstützt lokale und Cloud-BereitstellungBenutzer können wählen, ob sie lokal arbeiten oder den Core Cloud Service nutzen möchten.

- Integration mit großen ModellenInteraktionsdatensätze: Unterstützt die Verbindung mit einer Vielzahl großer Modelle zur Speicherung von Interaktionsdatensätzen.

- Log-ÜberwachungAnzeige von Protokollen der Speicherverarbeitung in Echtzeit, um den Status der Datenverarbeitung zu verstehen.

- Open-Source-ProjektBenutzer haben freien Zugang zum Code und können sich an der Entwicklung oder Anpassung von Funktionen beteiligen.

Hilfe verwenden

Einbauverfahren

Um Core zu verwenden, müssen Sie zunächst Ihre Umgebung installieren und konfigurieren. Im Folgenden werden die einzelnen Schritte zur Installation und Verwendung beschrieben:

- Klon-Lager:

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um das Core-Repository zu klonen:

git clone https://github.com/RedPlanetHQ/core.git - Rufen Sie den Projektkatalog auf:

cd core

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um das Core-Repository zu klonen:

- Installation von Abhängigkeiten:

- Core verwendet eine Node.js-Umgebung, und es wird empfohlen, die neueste Version von Node.js zu installieren (empfohlen 16.x oder höher).

- Installieren Sie die Abhängigkeitspakete:

npm install

- Umgebungsvariablen konfigurieren:

- Erstellen Sie im Stammverzeichnis des Projekts eine

.envfügen Sie Folgendes hinzu:API_TOKEN=YOUR_API_TOKEN_HERE API_BASE_URL=https://core.heysol.ai SOURCE=cursor API_TOKENSie erhalten es nach der Registrierung eines Kontos auf der offiziellen Website von Core Cloud (https://core.heysol.ai).

- Erstellen Sie im Stammverzeichnis des Projekts eine

- Lokale Dienste betreiben:

- Starten Sie das Memory Control Panel (MCP) von Core:

npx -y @redplanethq/core-mcp - Sobald der Dienst gestartet ist, öffnen Sie Ihren Browser und besuchen Sie

http://localhost:3000。

- Starten Sie das Memory Control Panel (MCP) von Core:

- Verwendung von Core Cloud (optional):

- Wenn Sie sich für einen Cloud-Dienst entscheiden, besuchen Sie https://core.heysol.ai, um sich zu registrieren und bei Ihrem Konto anzumelden.

- Verwalten Sie Speicher direkt im Cloud-Dashboard ohne lokale Bereitstellung.

Hauptfunktionen

1) Hinzufügen von Erinnerungen

- Verfahren:

- Anmeldung Dashboard (lokal oder Cloud).

- Geben Sie in das Eingabefeld oben rechts den Text ein, den Sie speichern möchten, z.B. "Ich spiele gerne Badminton".

- Klicken Sie auf die Schaltfläche "+Hinzufügen" und der Text wird an die Bearbeitungswarteschlange gesendet.

- Überprüfen Sie den Verarbeitungsstatus auf dem Bildschirm "Protokolle". Wenn die Verarbeitung abgeschlossen ist, wird der Speicherknoten auf dem Dashboard angezeigt.

- Funktionelle Beschreibung:

- Für jeden hinzugefügten Text wird automatisch ein Speicherknoten erzeugt, der den Textinhalt und Metadaten (z. B. Zeitstempel) enthält.

- Diese Knoten können miteinander verbunden werden, um einen Wissensgraphen für spätere Abfragen oder Analysen zu erstellen.

2. die Anzeige und Verwaltung des Speichers

- Verfahren:

- Öffnen Sie die Seite "Graph" des Dashboards, um alle Speicherknoten zu sehen.

- Klicken Sie auf einen Knoten, um die Details anzuzeigen oder ihn zu bearbeiten.

- Unterstützung der Suchfunktion, Eingabe von Schlüsselwörtern zum schnellen Auffinden verwandter Erinnerungen.

- Funktionelle Beschreibung:

- Das Dashboard bietet einen visuellen Wissensgraphen, der die Beziehungen zwischen den einzelnen Knoten auf einen Blick zeigt.

- Benutzer können Knotenverbindungen manuell anpassen oder unerwünschte Speicher löschen.

3. die Integration in größere Modelle

- Verfahren:

- Fügen Sie auf der Seite Einstellungen eine Regel zum automatischen Speichern des Makromodell-Dialogs hinzu:

- Öffnen Sie "Einstellungen" -> "Benutzerregeln" -> "Neue Regel".

- Fügen Sie Regeln hinzu, um sicherzustellen, dass die Anfrage des Benutzers und die Antwort des Modells nach jedem Dialog im Kernspeicher gespeichert werden.

- aufstellen

sessionIdist der eindeutige Bezeichner (UUID) des Dialogs.

- Beispiel für eine Regelkonfiguration:

{ "mcpServers": { "memory": { "command": "npx", "args": ["-y", "@redplanethq/core-mcp"], "env": { "API_TOKEN": "YOUR_API_TOKEN_HERE", "API_BASE_URL": "https://core.heysol.ai", "SOURCE": "cursor" } } } }

- Fügen Sie auf der Seite Einstellungen eine Regel zum automatischen Speichern des Makromodell-Dialogs hinzu:

- Funktionelle Beschreibung:

- Core erfasst automatisch die Benutzerinteraktionen mit großen Modellen und speichert sie als strukturierte Daten.

- Eine breite Palette großer Modelle wird unterstützt, aber die Unterstützung für das Llama-Modell wird derzeit optimiert, um die Kompatibilität in Zukunft zu verbessern.

4. die Protokollüberwachung

- Verfahren:

- Öffnen Sie die Seite "Protokolle" des Dashboards.

- Anzeige von Echtzeit-Verarbeitungsprotokollen, einschließlich Speicherzugänge, Verarbeitungsstatus und Fehlermeldungen.

- Funktionelle Beschreibung:

- Die Protokollierungsfunktion hilft den Benutzern, den Datenverarbeitungsfluss zu überwachen und die Zuverlässigkeit der Datenspeicherung zu gewährleisten.

- Wenn die Verarbeitung fehlschlägt, enthält das Protokoll Fehlerdetails für eine einfache Fehlersuche.

caveat

- lokaler EinsatzVergewissern Sie sich, dass das Netzwerk stabil ist und der Port 3000 nicht belegt ist.

- Cloud-DienstStabile API-Schlüssel sind erforderlich, und die Gültigkeit der Schlüssel wird regelmäßig überprüft.

- Unterstützung für das Lama-ModellDerzeit ist Core nur begrenzt mit dem Llama-Modell kompatibel, daher wird empfohlen, für beste Ergebnisse andere Hauptmodelle zu verwenden.

- Unterstützung der Gemeinschaft: Core ist ein Open-Source-Projekt. Wenn Sie auf Probleme stoßen, können Sie einen Fehler auf GitHub melden oder sich an der Community-Diskussion beteiligen.

Anwendungsszenario

- Persönliches Wissensmanagement

- Mit Core können Nutzer tägliche Lernnotizen, Inspirationen oder wichtige Gespräche speichern und so eine persönliche Wissensdatenbank aufbauen. Studenten können zum Beispiel Unterrichtsnotizen als Gedächtnisknoten speichern, um sie leicht wiederholen zu können.

- Entwickler-Debugging großer Modelle

- Entwickler können Interaktionen mit großen Modellen aufzeichnen, die Modellausgabe analysieren und das Design der Eingabeaufforderung optimieren. Bei der Fehlersuche in einem Chatbot kann Core zum Beispiel alle Testkonversationen speichern.

- Teamarbeit

- Teammitglieder können Memory Maps gemeinsam nutzen und über Core Cloud an der Erstellung von Projekt-Wissensdatenbanken mitarbeiten. Zum Beispiel kann ein Produktteam Benutzerfeedback in Core hinterlegen, um eine Anforderungsanalyse-Map zu erstellen.

- Unterstützung bei der Forschung

- Forscher können Literaturzusammenfassungen oder experimentelle Daten in Core speichern, um einen strukturierten Forschungsspeicher für spätere Analysen und Zitate zu erstellen.

QA

- Welche großen Modelle werden von Core unterstützt?

- Core unterstützt derzeit viele der wichtigsten großen Modelle, aber die Kompatibilität mit dem Llama-Modell wird noch optimiert. Es wird empfohlen, für beste Ergebnisse andere Modelle zu verwenden.

- Was ist der Unterschied zwischen lokaler Bereitstellung und Cloud-Diensten?

- Die lokale Bereitstellung erfordert eine manuelle Konfiguration der Umgebung, was sich für Szenarien eignet, bei denen es auf den Schutz der Privatsphäre ankommt; Cloud-Dienste erfordern keine Installation und sind sofort einsatzbereit, was sich für einen schnellen Einstieg eignet.

- Wie kann ich die Sicherheit meiner Speicherdaten gewährleisten?

- Lokal bereitgestellte Speicherdaten werden auf dem Gerät des Nutzers gespeichert, wobei die Sicherheit vom Nutzer kontrolliert wird; Cloud-Dienste verwenden eine verschlüsselte Übertragung mit API-Schlüsseln, um einen sicheren Datenzugriff zu gewährleisten.

- Ist Core völlig kostenlos?

- Core ist ein Open-Source-Projekt und für den lokalen Einsatz kostenlos; für Cloud-Dienste können Abonnementgebühren anfallen, daher sollten Sie sich auf der offiziellen Website über die Preise informieren.