Bei der Herstellung von Produkten wie RAG 或 AI Beim Agenteneinsatz dieser Art von KI-Systemen ist die Qualität der Suche der Schlüssel zur Bestimmung der Obergrenze des Systems. Die Entwickler verlassen sich in der Regel auf zwei vorherrschende Suchtechniken: die Stichwortsuche und die semantische Suche.

- Schlagwortsuche (z.B. BM25). Sie ist schnell und gut im exakten Abgleich. Aber sobald sich der Wortlaut der Frage eines Nutzers ändert, sinkt die Trefferquote.

- Semantische Suche. Die Erfassung der tieferen Bedeutung eines Textes durch Vektoreinbettung ermöglicht das Verständnis von konzeptionellen Fragen.

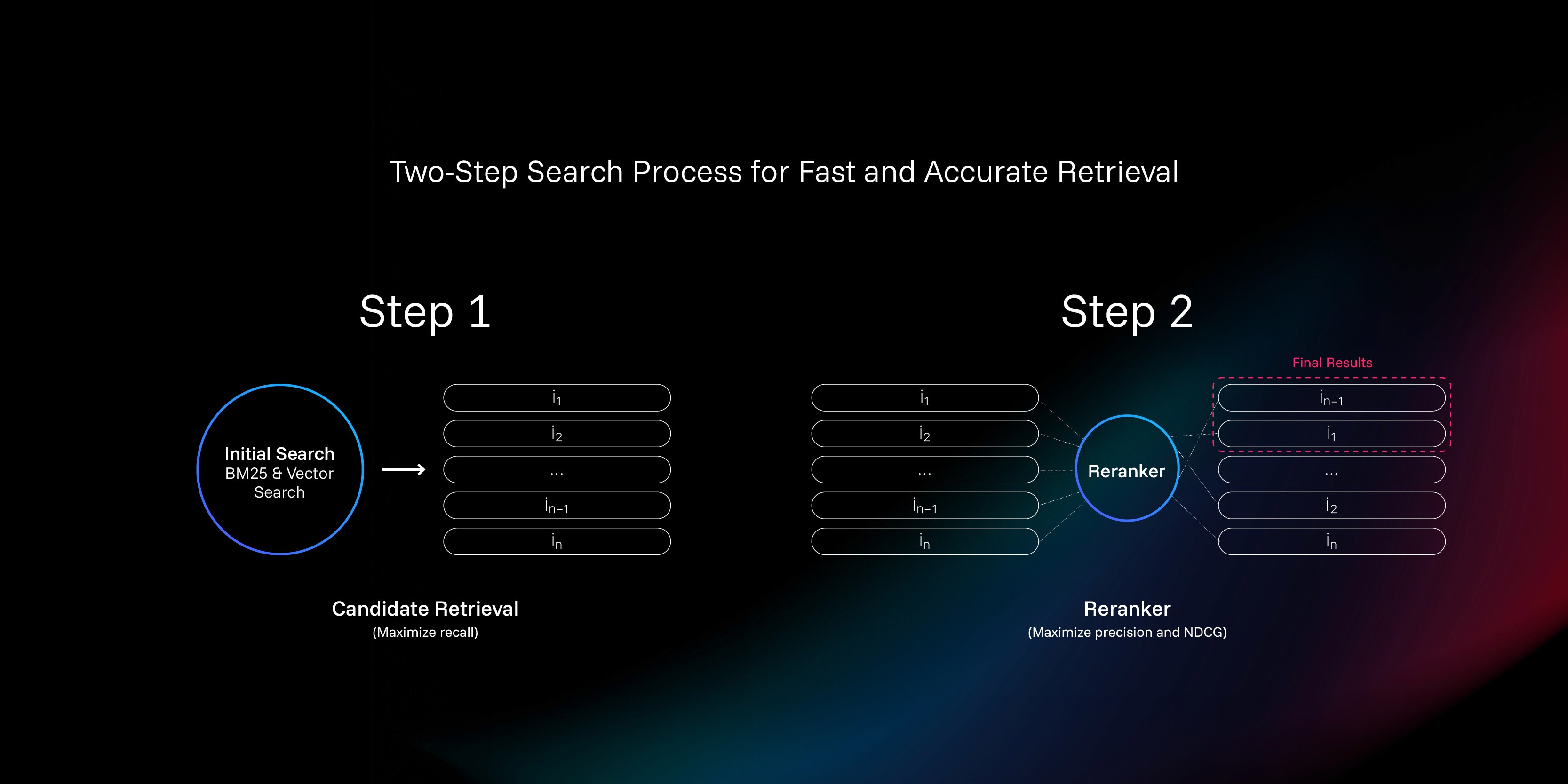

Eine gängige Praxis ist es, die beiden zu kombinieren, um die Auffindbarkeit zu maximieren. Eine hohe Auffindbarkeit ist jedoch nicht dasselbe wie eine hohe Präzision. Selbst wenn die richtige Antwort in einer großen Anzahl von abgerufenen Dokumenten enthalten ist, ist es für ein großes Sprachmodell oder einen Benutzer praktisch unmöglich, sie zu sehen, wenn sie auf Platz 67 steht. Um das Problem des "Fingerhuts im Meer" zu lösen.reranker (Resequencer) wurde zu diesem Zweck entwickelt.

Was ist Reranker?

Sie können reranker Verstanden als "Wiederholungsprüfung" im Prozess der Informationsbeschaffung.

Eine rudimentäre Stichwort- oder semantische Suche ist wie eine "Seeumfrage", bei der aus einer großen Anzahl von Dokumenten schnell Hunderte von relevanten Kandidaten herausgefiltert werden. Der Auswahlprozess ist jedoch relativ grob, und die Dokumente werden unabhängig von der Anfrage kodiert. Im Gegensatz dazu ist die reranker Als Prüfer erhält er die "Anfrage" des Benutzers und den vollständigen Text jedes "Kandidatendokuments", führt einen verfeinerten Vergleich und eine Bewertung durch und gibt schließlich eine verbindlichere Bewertung ab, die der tatsächlichen Absicht des Benutzers bei der Erstellung der Rangliste besser entspricht. Da sowohl die Anfrage als auch das Dokument berücksichtigt werden, ist das Verständnis des Kontextes viel besser als in der Auswahlphase.

In diesem Papier werden wir ein neues reranker Trainingsmethodik, die auf die traditionelle Punktevergabe verzichtet und stattdessen auf die im Schach und im eSport weit verbreitete Methode setzt ELO Teilsystem Bewertung.

Der Kern des Problems: Unzuverlässigkeit der Punktevergabe

Zug reranker Das Ziel ist es, eine Funktion zu schaffen f(q, d)Sie kann für jede "Abfrage" verwendet werden q"und "Dokumentation d"Eine genaue Relevanzbewertung erstellen s. Theoretisch kann man, solange es ein Meer von (q, d, s) Daten, kann ein neuronales Netz durch überwachtes Lernen trainiert werden.

Das Problem ist jedoch, dass dieses "Ergebnis s"Äußerst schwierig zu beschaffen.

Das Dilemma der bestehenden Programme: binäre Kennzeichnung und die "falsch-negative" Katastrophe

Der derzeit gängige Ansatz besteht darin, manuell gekennzeichnete Paare von "positiven" (relevanten) und "negativen" (irrelevanten) Daten zu verwenden. Positive Beispiele sind leicht zu finden, aber die Konstruktion von negativen Beispielen ist ein großes Problem.

Ein Ansatz besteht darin, eine Zufallsstichprobe aus allen Dokumenten zu nehmen und davon auszugehen, dass sie wahrscheinlich nicht relevant ist. Aber das ist so, als würde man einen Boxchampion bitten, einen gewöhnlichen Menschen zu verprügeln, und das trainierte Modell kann nicht mit diesen subtilen Situationen umgehen, die "scheinbar zusammenhängen, aber eigentlich nutzlos sind".

Ein anderer Ansatz ist die Verwendung der BM25 oder die Ergebnisse einer Vektorsuche als Quelle für Negativbeispiele. Dies führt jedoch zu einer "Falsch-Negativ"-Katastrophe: Woher weiß man, dass ein als "Negativbeispiel" gekennzeichnetes Dokument wirklich nicht relevant ist? Die Antwort lautet: Man weiß es nicht. In vielen Fällen ist ein als "Negativbeispiel" gekennzeichnetes Dokument tatsächlich relevanter als ein so genanntes "Positivbeispiel".

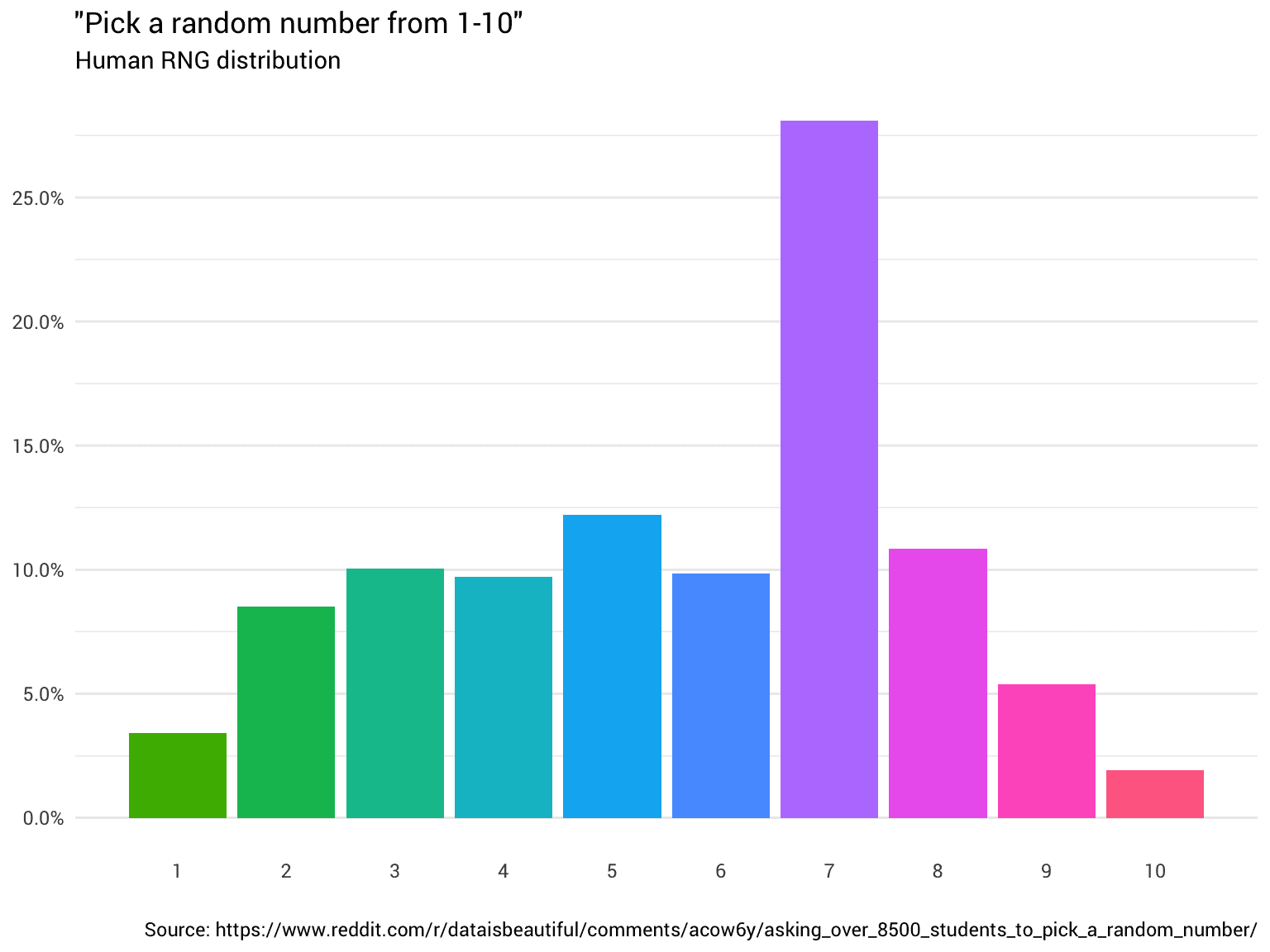

Die Zweideutigkeit dieses Bewertungssystems ist das grundlegende Problem. Das menschliche Gehirn ist von Natur aus schlecht darin, Dingen absolute Werte zuzuordnen.

Anfrage. "Wer hat den Nobelpreis für Physik 2017 gewonnen?"

Dokumentation. "Gravitationswellen wurden erstmals 2015 von LIGO beobachtet."

Welche Note sollte dieses Dokument erhalten? Einige mögen meinen, dass das Jahr falsch ist, und es niedrig bewerten; aber Physik-Enthusiasten wissen, dass der Nobelpreis 2017 genau an den Entdecker der Gravitationswellen verliehen wurde, und würden es daher hoch bewerten. Dieser enorme subjektive Unterschied macht die absolute Bewertung zu einem großen Rauschen.

Die Lösung: vom "Bewerten" zum "Vergleichen" übergehen

Wenn absolute Bewertungen unzuverlässig sind, können wir dann einfach vergleichen? Das menschliche Gehirn ist zwar nicht gut in absoluten Bewertungen, aber extrem gut in relativen Urteilen.

Anfrage. "Wer hat den Nobelpreis für Physik 2017 gewonnen?"

Dokument 1. Der Nobelpreis wurde 2015 an die Entdecker der Gravitationswellen verliehen.

Dokument 2. Gravitationswellen wurden erstmals im September 2015 mit dem LIGO-Gravitationswellendetektor beobachtet.

Fast jeder würde zustimmen, dass Dokument 1 relevanter ist als Dokument 2. Durch paarweise Vergleiche erhalten wir gelabelte Daten mit einem sehr hohen Signal-Rausch-Verhältnis. Das ist genau das, was ELO Der Kerngedanke des Bewertungssystems ist nicht die Frage "wie stark bist du", sondern "wer ist zwischen dir und einer anderen Person stärker". Mit einer großen Anzahl von Zwei-gegen-Zwei-Ergebnissen können wir eine relativ genaue Rangliste für jeden "Spieler" (Dokument) berechnen.

Das Problem besteht nun darin, wie man eine große Anzahl von paarweisen Vergleichsergebnissen in einen brauchbaren Vektor von absoluten Punktzahlen umwandelt.

Überblick über den Ausbildungsprozess

Auf dieser Grundlage wurde ein innovatives Schulungsprogramm entwickelt:

- Ternäre Probenahme und Kennzeichnung. Für jede Abfrage werden zunächst 100 Kandidatendokumente abgerufen. Zufällige Auswahl von Dokumententripeln

(q, d_i, d_j)und ermöglicht die Beurteilung von großen Sprachmodellen (LLM) in Clusternd_i和d_jWas ist wichtiger? - Training eines paarweisen Vergleichsmodells: die ausnutzen

LLMder etikettierten Daten, um ein leichtes paarweisesrerankerdie es ermöglicht, die relativen Vorzüge zweier beliebiger Dokumente effizient vorherzusagen. - Berechnung der ELO-Punkte. Für jedes Suchkandidatendokument werden mehrere Runden von "Simulationsübereinstimmungen" unter Verwendung des im vorherigen Schritt trainierten Modells durchgeführt, und dann wird die

ELODer Algorithmus errechnet für jedes Dokument einen Rangwert. - Trainieren Sie das endgültige Modell. 将

ELOPunkte als "Standardantwort", um eine Standard-Ein-Punkt-Antwort zu trainierenrerankerdie es ermöglicht, die Relevanz eines Dokuments direkt vorherzusagen. - Intensives Lernen - Feinabstimmung. Nach dem überwachten Lernen wird das Verstärkungslernen eingeführt, damit das Modell die Rangordnungsstrategie durch Selbstversuche und Fehler weiter optimieren kann, um die endgültige Leistung zu verbessern.

Kerntechnologie: Paarweise Vergleiche und ELO-Bewertungen

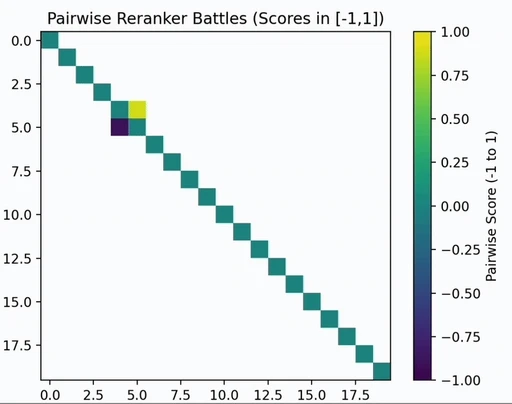

Training paarweiser Komparatoren

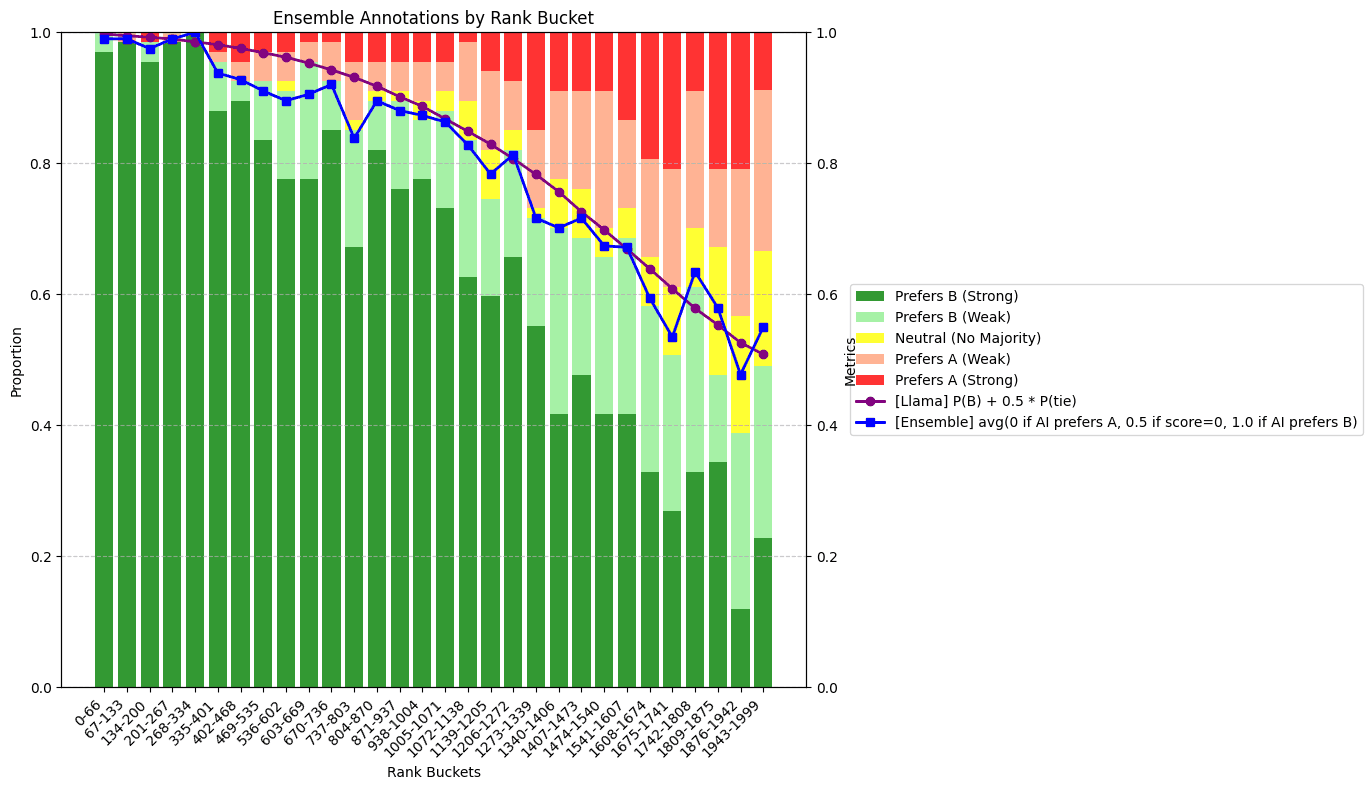

Erstens: Das Forschungsteam verwendete drei LLM Zusammensetzung des Integrationsmodells, für eine große Anzahl von Dokumentenpaaren (d_i, d_j) Beurteilen Sie die Verdienste und erstellen Sie eine [0, 1] zwischen den Präferenzergebnissen. Dieser Prozess ist kostspielig, weshalb das Ziel darin besteht, ihn nicht direkt anzuwenden, sondern qualitativ hochwertige Trainingsdaten zu erzeugen.

Diese Daten wurden dann zur Feinabstimmung eines leichtgewichtigen Open-Source-Modells verwendet, um einen effizienten "paarweisen Vergleicher" zu trainieren.

Eine ELO-Bewertung erhalten

ELO Modell sagt Spieler voraus i Überwinder j Die Wahrscheinlichkeit ergibt sich aus der Differenz zwischen den Punktzahlen der beiden e_i - e_j. Die Vorhersageformel lautet:

pij = pi / (pi + pj)

Darunter.p_i = 10^(e_i / 400). Mit dieser Formel können wir die Wahrscheinlichkeiten mit den Punktzahlen in Beziehung setzen.

Bei einer großen Anzahl von paarweisen Übereinstimmungsergebnissen (die vom Komparator im vorherigen Schritt generiert wurden) ist es möglich, eine Maximum-Likelihood-Schätzung vorzunehmen, die diese Übereinstimmungsergebnisse am besten erklärt durch ELO mark e_i, e_j, .... Die Verlustfunktion lautet wie folgt:

𝓁 = -∑i, jwijlog(pi/(pi+pj)) = ∑i, jwijlog(1+eej-ei)

In der Praxis wurden alle 100 Dokumente für jede Abfrage n² Teilvergleiche sind unrealistisch. In der Studie wurde festgestellt, dass nur Stichproben O(n) Teilvergleiche (z. B. die Konstruktion einiger randomisierter Turnierschleifen) würden ausreichen, um einen nahezu identischen Vergleich mit dem vollständigen Vergleich zu erhalten. ELO Ergebnis.

Abfrageübergreifende Anpassung der Verzerrung

die oben genannte ELO Die Berechnung erfolgt innerhalb einer einzigen Abfrage, was ein neues Problem schafft:

- Bei einer Abfrage, auf die es keine gute Antwort gibt, erhält das am wenigsten schlechte Dokument auch eine hohe relative

ELOErgebnis (erster Platz in der Differenz). - Für eine Anfrage mit vielen guten Antworten kann eine ziemlich gute Dokumentation einen niedrigen relativen Wert erhalten

ELOPunktzahl (am Ende der Liste in den Auszeichnungen).

Dies kann das Training des endgültigen Modells ernsthaft verfälschen. Um dieses Problem zu lösen, muss ein "Cross-Query-Bias" eingeführt werden. b"zur Kalibrierung von Score-Benchmarks zwischen verschiedenen Abfragen.

Die Kernidee besteht darin, das Modell in die Lage zu versetzen, nicht nur "zwei Antworten auf dieselbe Frage", sondern auch "zwei verschiedene Antworten auf zwei verschiedene Fragen" zu vergleichen, d. h. (q_1, d_1) 与 (q_2, d_2) Was ist relevanter. Dieser "Äpfel mit Birnen"-Vergleich ist viel lauter, aber er liefert uns die Schlüsselinformationen, die wir brauchen, um den Schwierigkeitsgrad verschiedener Abfragen zu kalibrieren. Mit einer komplexeren ELO Modell kann die gewünschte Verzerrung für jede Abfrage berechnet werden blautet die Formel in etwa wie folgt:

P(P₁ > P₂) = (p₁ + b₁) / ((p₁ + b₁) + (p₂ + b₂))

Training eines Ein-Punkt-Modells

Mit den oben genannten Schritten lässt sich eine absolute Punktzahl ermitteln, die hochwertige, aussagekräftige f(q, d) = elo(q, d) + b(q) Funktion erstellt wird.

Der letzte Schritt besteht darin, den von dieser Funktion erzeugten Datensatz zu verwenden, um die Feinabstimmung einer endgültigen Lösung durch den mittleren quadratischen Standardfehlerverlust zu überwachen. reranker Modellierung. Das Forschungsteam stellte fest, dass die Qwen Die Feinabstimmung der Modellfamilie führt zu den besten Ergebnissen, woraus die zerank-1 和 zerank-1-small Modelle.

Dieser Schwerpunkt auf der mathematischen Modellierung durch ELO Der Ansatz des Systems, qualitativ hochwertige Trainingsdaten zu generieren, stellt die reranker Eine einzigartige und wirksame Richtung, die es in diesem Bereich zu erforschen gilt. Sie löst grundlegend die Probleme des Rauschens und der Engpässe, die durch die Abhängigkeit von unzuverlässigen manuellen absoluten Bewertungen bei traditionellen Methoden entstehen.