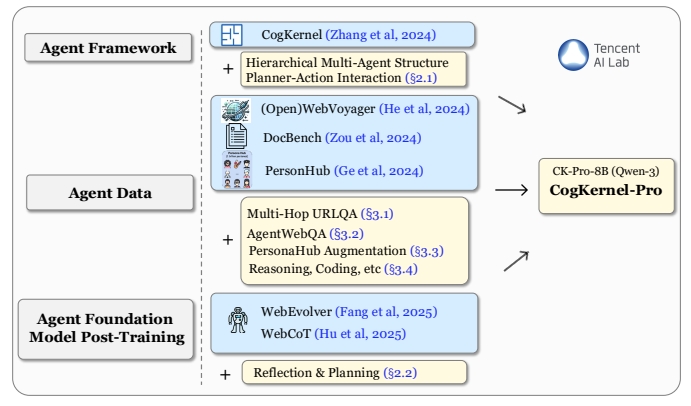

Cognitive Kernel-Pro ist ein Open-Source-Framework, das vom KI-Labor von Tencent entwickelt wurde und Nutzern helfen soll, tiefe Forschungsintelligenz aufzubauen und intelligente Basismodelle zu trainieren. Es integriert Webbrowsing, Dateiverarbeitung und Codeausführung, um Nutzer bei komplexen Forschungsaufgaben zu unterstützen. Der Schwerpunkt des Frameworks liegt auf der Verwendung freier Tools, um Open Source und Zugänglichkeit zu gewährleisten. Die Nutzer können die Intelligenzen lokal einsetzen und ausführen, wobei Aufgaben wie Echtzeitinformationen, Dateiverwaltung und Codegenerierung einfach zu handhaben sind. Das Projekt hat bei GAIA-Benchmarks gut abgeschnitten und erreicht oder übertrifft sogar die Leistung einiger Closed-Source-Systeme. Der Code und das Modell sind vollständig quelloffen und werden auf GitHub gehostet, um Beiträge der Gemeinschaft und weitere Forschung zu fördern.

Funktionsliste

- Web-Browsing: Intelligente Körper können Web-Informationen in Echtzeit abrufen, indem sie den Browser steuern, um Vorgänge wie Klicken und Tippen auszuführen.

- Dateiverarbeitung: Unterstützt das Lesen und Verarbeiten lokaler Dateien, um wichtige Daten zu extrahieren oder Berichte zu erstellen.

- Codeausführung: Automatisches Generieren und Ausführen von Python-Code zur Datenanalyse oder Aufgabenautomatisierung.

- Modularer Aufbau: Bietet eine Architektur mit mehreren Modulen, die es den Nutzern ermöglicht, die Funktionskombinationen der Intelligenzen individuell anzupassen.

- Unterstützung von Open-Source-Modellen: Integrieren Sie Qwen3-8B-CK-Pro und andere Open-Source-Modelle, um die Nutzungskosten zu senken.

- Aufgabenplanung: Intelligente Einrichtungen können auf der Grundlage von Benutzeranweisungen Aufgabenpläne erstellen und komplexe Aufgaben aufschlüsseln.

- Sicherer Sandbox-Betrieb: Unterstützung der Ausführung von Code in einer Sandbox-Umgebung, um die Sicherheit des Betriebs zu gewährleisten.

Hilfe verwenden

Einbauverfahren

Um Cognitive Kernel-Pro zu verwenden, müssen die Benutzer die folgenden Installations- und Konfigurationsschritte in ihrer lokalen Umgebung durchführen. Nachfolgend finden Sie einen detaillierten Installationsprozess, um sicherzustellen, dass die Benutzer schnell loslegen können.

1. die Vorbereitung der Umwelt

Stellen Sie zunächst sicher, dass Sie Python 3.8 oder höher auf Ihrem System installiert haben und dass Sie über das Tool Git verfügen. Dies wird für Linux- oder macOS-Systeme empfohlen; Windows-Benutzer müssen einige zusätzliche Abhängigkeiten installieren. Hier sind die grundlegenden Schritte:

- Installation von Abhängigkeiten: Führen Sie den folgenden Befehl aus, um die erforderlichen Python-Pakete zu installieren:

pip install boto3 botocore openai duckduckgo_search rich numpy openpyxl biopython mammoth markdownify pandas pdfminer-six python-pptx pdf2image puremagic pydub SpeechRecognition bs4 youtube-transcript-api requests transformers protobuf openai langchain_openai langchain selenium helium smolagents - Installation von Systemabhängigkeiten(Linux-System):

apt-get install -y poppler-utils default-jre libreoffice-common libreoffice-java-common libreoffice ffmpegDiese Tools unterstützen die Konvertierung von Dateien und die Multimedia-Verarbeitung.

- Einstellen des Python-Pfads: Fügen Sie den Projektpfad in die Umgebungsvariable ein:

export PYTHONPATH=/your/path/to/CogKernel-Pro - KlonprojektKlonen Sie das Cognitive Kernel-Pro-Repository von GitHub:

git clone https://github.com/Tencent/CognitiveKernel-Pro.git cd CognitiveKernel-Pro

2. die Dienste der Konfigurationsmodellierung

Cognitive Kernel-Pro-Unterstützung vLLM oder TGI Model Server, um Open-Source-Modelle auszuführen. Im Folgenden wird ein Beispiel für vLLM gezeigt:

- Installation von vLLM:

pip install vllm - Starten des ModelldienstesAngenommen, Sie haben die Qwen3-8B-CK-Pro-Modellgewichte heruntergeladen, führen Sie den folgenden Befehl aus, um den Dienst zu starten:

python -m vllm.entrypoints.openai.api_server --model /path/to/downloaded/model --worker-use-ray --tensor-parallel-size 8 --port 8080 --host 0.0.0.0 --trust-remote-code --max-model-len 8192 --served-model-name ck

3. die Konfiguration von Webbrowser-Diensten

Das Projekt verwendet Playwright, um Web-Browsing-Funktionen bereitzustellen. Führen Sie das folgende Skript aus, um den Browserdienst zu starten:

sh ck_pro/ck_web/_web/run_local.sh

Vergewissern Sie sich, dass der Dienst auf dem Standardport ausgeführt wird localhost:3001。

4. die Durchführung des Hauptprogramms

Nachdem Sie das Modell und den Browserdienst vorbereitet haben, führen Sie die Hauptanwendung aus, um die Aufgabe auszuführen:

NO_NULL_STDIN=1 python3 -u -m ck_pro.ck_main.main --updates "{'web_agent': {'model': {'call_target': 'http://localhost:8080/v1/chat/completions'}, 'web_env_kwargs': {'web_ip': 'localhost:3001'}}, 'file_agent': {'model': {'call_target': 'http://localhost:8080/v1/chat/completions'}}}" --input /path/to/simple_test.jsonl --output /path/to/simple_test.output.jsonl |& tee _log_simple_test

--inputGibt die Aufgabeneingabedatei im JSON-Zeilenformat an, wobei jede Zeile eine Aufgabenbeschreibung enthält.--outputGibt den Pfad zu einer Ausgabedatei an, in der die Ergebnisse der Smart Body-Ausführung gespeichert werden.

5. vorsichtsmaßnahmen

- SicherheitEs wird empfohlen, das Programm in einer Sandbox-Umgebung mit deaktivierten sudo-Rechten auszuführen, um potenzielle Risiken zu vermeiden:

echo "${USER}" 'ALL=(ALL) NOPASSWD: !ALL' | tee /etc/sudoers.d/${USER}-rule chmod 440 /etc/sudoers.d/${USER}-rule deluser ${USER} sudo - Debug-Modus: kann hinzufügen

-mpdbum den Debug-Modus für die Fehlersuche aufzurufen.

Hauptfunktionen

Webbrowser

Die Web-Browsing-Funktion von Cognitive Kernel-Pro ermöglicht es Intelligenzen, mit Webseiten wie Menschen zu interagieren. Der Benutzer gibt eine Aufgabenbeschreibung ein (z. B. "Finde die letzten Commits zu einem Repository auf GitHub"), und die Intelligenz öffnet automatisch einen Browser und klickt, tippt, usw., um die gewünschten Informationen zu erhalten. Und so funktioniert es:

- Definieren Sie Aufgaben in der Eingabedatei, zum Beispiel:

{"task": "find the latest commit details of a popular GitHub repository"} - Der intelligente Körper erstellt einen Aufgabenplan, ruft den Playwright-Browser auf und besucht die Ziel-Webseite.

- Extrahiert den Inhalt einer Webseite und liefert das Ergebnis, das in einer Ausgabedatei gespeichert wird.

Bearbeitung von Dokumenten

Die Dateiverarbeitungsfunktion unterstützt das Lesen und Analysieren von Dateien in vielen Formaten (z.B. PDF, Excel, Word). Die Benutzer können Dateipfade und Aufgaben angeben, z. B. das Extrahieren von Tabellendaten aus PDFs:

- Bereiten Sie die Eingabedatei vor und geben Sie den Dateipfad und die Aufgabe an:

{"task": "extract table data from /path/to/document.pdf"} - Der Smart Body ruft das Dateiverarbeitungsmodul auf, um die Datei zu analysieren und die Daten zu extrahieren.

- Die Ergebnisse werden in einer Ausgabedatei in einem strukturierten Format wie JSON oder CSV gespeichert.

Code-Ausführung

Mit der Funktion zur Codeausführung kann Intelligenz Python-Code generieren und ausführen, um Datenanalysen oder Automatisierungsaufgaben zu erledigen. Zum Beispiel bei der Analyse von Daten in einer CSV-Datei:

- Geben Sie eine Beschreibung der Aufgabe ein:

{"task": "analyze sales data in /path/to/sales.csv and generate a summary"} - Intelligentsia generiert Python-Code zur Verarbeitung der Daten mit Hilfe von Bibliotheken wie Pandas.

- Der Code wird in einer Sandbox-Umgebung ausgeführt und die Ergebnisse werden in einer Ausgabedatei gespeichert.

Planung von Einsätzen

Die Intelligenz erstellt einen Ausführungsplan auf der Grundlage der Komplexität der Aufgabe. Zum Beispiel für "Finden und Zusammenfassen des Inhalts eines Artikels":

- Die Intelligenz zerlegt die Aufgabe in Teilschritte: Suche nach Dokumenten, Herunterladen von PDF-Dateien, Extrahieren von Schlüsselinformationen und Erstellen von Zusammenfassungen.

- Jeder Teilschritt ruft das entsprechende Modul (Webbrowsing, Dateiverarbeitung usw.) zur Ausführung auf.

- Das Endergebnis wird in einem benutzerdefinierten Format ausgegeben.

Featured Function Bedienung

Unterstützung von Open-Source-Modellen

In Cognitive Kernel-Pro ist das Modell Qwen3-8B-CK-Pro integriert, das in GAIA-Benchmarks gut abschneidet. Die Nutzer können die Modellgewichte direkt herunterladen, so dass sie sich nicht auf Closed-Source-APIs verlassen müssen und die Betriebskosten gesenkt werden. Das Modell unterstützt multimodale Aufgaben (z. B. Bildverarbeitung), und die Benutzer können VLM_URL so konfigurieren, dass es multimodale Funktionen verwendet.

Sicherheits-Sandbox-Betrieb

Um Risiken im Zusammenhang mit der Codeausführung zu vermeiden, wird empfohlen, das Framework in einer Sandbox-Umgebung auszuführen. Benutzer können es über Docker bereitstellen, um die Isolierung des Codes zu gewährleisten:

docker run --rm -v /path/to/CogKernel-Pro:/app -w /app python:3.8 bash -c "pip install -r requirements.txt && python -m ck_pro.ck_main.main"

Anwendungsszenario

- akademische Forschung

Mit Cognitive Kernel-Pro können Benutzer nach akademischen Arbeiten suchen, Schlüsselinformationen extrahieren und Zusammenfassungen erstellen. Wenn Sie zum Beispiel eingeben: "Finde die neuesten Arbeiten im Bereich KI und fasse sie zusammen", sucht die Intelligenz automatisch auf arXiv, lädt die PDF-Datei der Arbeit herunter, extrahiert die Zusammenfassung und die Schlussfolgerungen und erstellt einen kurzen Bericht. - Datenanalyse

Geschäftsanwender können das Framework nutzen, um lokale Datendateien zu analysieren. Beispielsweise eignet sich die Verarbeitung von CSV-Dateien mit Verkaufsdaten zur Erstellung von statistischen Diagrammen und Trendanalyseberichten für schnelle Geschäftseinblicke. - Automatisierte Aufgaben

Entwickler können Intelligenz nutzen, um sich wiederholende Aufgaben zu automatisieren, z. B. das Herunterladen von Webdaten, die Organisation von Dateiinhalten oder die Durchführung von Code-Tests, um die Produktivität zu steigern. - Entwicklung der Open-Source-Gemeinschaft

Entwickler aus der Gemeinschaft können sich an der kontinuierlichen Verbesserung des Frameworks beteiligen, indem sie Intelligenzen auf der Grundlage des Frameworks anpassen, Funktionsmodule erweitern, z. B. neue Dateiparser hinzufügen oder andere Open-Source-Modelle integrieren.

QA

- Ist für Cognitive Kernel-Pro eine kostenpflichtige API erforderlich?

Kein Bedarf. Das Framework verwendet vollständig quelloffene Tools und Modelle (z. B. Qwen3-8B-CK-Pro) und ist nicht von kostenpflichtigen APIs abhängig. Benutzer können die Modellgewichte einfach herunterladen und lokal einsetzen. - Wie kann eine sichere Codeausführung gewährleistet werden?

Es wird empfohlen, das Projekt in einer Sandbox-Umgebung (z. B. Docker) auszuführen, sudo-Berechtigungen zu deaktivieren und den Netzwerkzugang zu beschränken. Die Projektdokumentation enthält detaillierte Richtlinien zur Sicherheitskonfiguration. - Welche Dateiformate werden unterstützt?

Unterstützt gängige Formate wie PDF, Excel, Word, Markdown, PPTX usw. Text-, Tabellen- oder Bilddaten können durch das Dateiverarbeitungsmodul extrahiert werden. - Wie gehen Sie mit komplexen Aufgaben um?

Der intelligente Körper zerlegt komplexe Aufgaben in Teilaufgaben, erstellt Ausführungspläne und ruft Module zum Surfen im Internet, zur Dateiverarbeitung oder zur Codeausführung auf, um sie Schritt für Schritt zu erledigen. - Werden multimodale Aufgaben unterstützt?

Ja, multimodale Aufgaben wie Bildverarbeitung oder Videoanalyse werden unterstützt. Der Benutzer muss VLM_URL konfigurieren und Unterstützung für multimodale Modelle bereitstellen.