Chutes ist eine KI-Modell-Computing-Plattform für Entwickler. Sie basiert auf einer dezentralen Open-Source-Architektur, und die Nutzer müssen keine komplexen Server selbst verwalten. Mit dieser Plattform können Entwickler schnell eine Vielzahl von Open-Source-KI-Modellen einsetzen und ausführen, z. B. große Sprachmodelle oder Modelle zur Bilderzeugung. Im Kern bietet Chutes.ai eine serverlose Computing-Umgebung, d. h. die Nutzer laden einfach ihren Code hoch und die Plattform übernimmt den Rest der Lauf- und Skalierungsaufgaben. Die Plattform verfügt über ein Pay-as-you-use-Modell, bei dem man für das bezahlt, was man nutzt, was eine kostensparende Möglichkeit für Startups und einzelne Forscher ist, die flexible Rechenressourcen benötigen. Die Plattform bietet stabile und effiziente Berechnungsunterstützung für KI-Inferenzaufgaben durch die Konsolidierung von GPU-Ressourcen weltweit.

Funktionsliste

- Serverlose BereitstellungBenutzer können jedes KI-Modell ohne Serverkonfiguration und -verwaltung einsetzen.

- Schnelle Expansion:: Das System kann Rechenressourcen automatisch an die Arbeitslast anpassen.

- Unterstützung für mehrere ModelleDie Plattform ist nicht auf große Sprachmodelle (Large Language Models, LLMs) beschränkt, sondern unterstützt auch eine breite Palette von KI-Anwendungen wie Bilder, Video, Sprache, Musik und 3D-Modellierung.

- Maßgeschneiderte UmgebungenBenutzer können ihren eigenen Code hochladen oder Docker-Container verwenden, um jedes Open-Source-Modell auszuführen.

- API zuerstBietet eine saubere API-Schnittstelle für die einfache Integration seiner Funktionen in jede Anwendung oder jedes System.

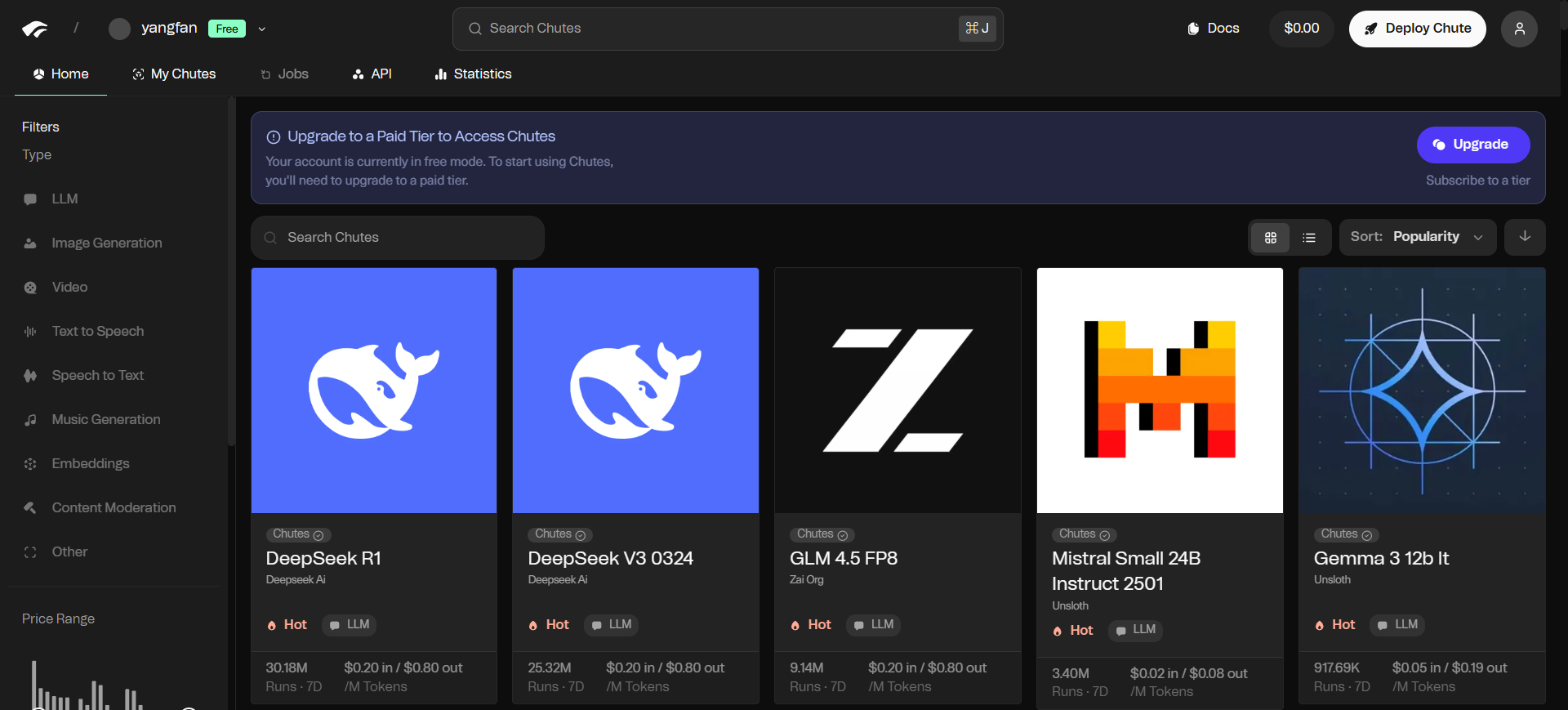

- Modellbibliothek:: Die Plattform stellt die neuesten Open-Source-Modelle zur Verfügung und geht oft kurz nach ihrer Veröffentlichung in Betrieb.

- nach Bedarf zahlenBezahlung: Die Bezahlung erfolgt auf der Grundlage des tatsächlichen Volumens der Computeranfragen, und es sind verschiedene Stufen von Abonnementplänen verfügbar.

- dezentralisiertes NetzAufbauend auf dem Bittensor-Netzwerk nutzt es verteilte GPU-Ressourcen zur Bereitstellung von Rechendiensten.

Hilfe verwenden

Die Chutes.ai-Plattform vereinfacht den Prozess der Bereitstellung und Nutzung von KI-Modellen und ermöglicht es Entwicklern ohne Expertenwissen über das Management von Cloud-Diensten, schnell loszulegen. In ihrem Kern bietet sie eine serverlose Umgebung, in der sich die Nutzer nur auf die Modelle und den Code selbst konzentrieren müssen.

Registrieren und API-Schlüssel anfordern

- Besuchen Sie die offizielle Website von Chutes.ai und erstellen Sie ein Konto.

- Sobald Sie angemeldet sind, finden Sie den Abschnitt API-Verwaltung in Ihrem Konto-Dashboard oder auf Ihrer Einstellungsseite.

- Erzeugen Sie einen neuen API-Schlüssel. Dieser Schlüssel ist Ihr Berechtigungsnachweis für den Zugriff auf die Datenverarbeitungsressourcen der Plattform, also bewahren Sie ihn sicher auf.

Verwendung des Modells über die API

Chutes.ai ist mit dem API-Format von OpenAI kompatibel, was den Wechsel und die Integration sehr einfach macht. Wenn Sie die API von OpenAI bereits verwendet haben, müssen Sie nur wenige Codeänderungen vornehmen.

Schritt 1: Einstellen der Abfrageadresse

Ersetzen Sie die in Ihrem Code angeforderte Ziel-URL durch die von Chutes.ai bereitgestellte Proxy-Adresse:

https://llm.chutes.ai/v1/chat/completions

Schritt 2: Konfigurieren Sie den API-Schlüssel

Authentifizieren Sie Ihren API-Schlüssel als Bearer Token in den Kopfzeilen der Anfrage (Headers).

Authorization: Bearer YOUR_CHUTES_API_KEY

Schritt 3: Spezifizieren Sie das Modell

In den JSON-Daten im Body der Anfrage (Body) wird diemodelgibt das Modell an, das Sie verwenden möchten. Wenn Sie z. B. eines der DeepSeek-Modelle verwenden möchten, können Sie es auf setzen:

"model": "deepseek-ai/DeepSeek-V3"

Es folgt ein Beispiel für das Senden einer Anfrage mit cURL:

curl -X POST https://llm.chutes.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_CHUTES_API_KEY" \

-d '{

"model": "deepseek-ai/DeepSeek-V3",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello! Can you tell me a joke?"

}

]

}'

Sie müssen den Code in der DateiYOUR_CHUTES_API_KEYErsetzen Sie den Schlüssel durch Ihren eigenen.

Verwendung in Anwendungen Dritter

Chutes.ai kann auch leicht in Anwendungen von Drittanbietern integriert werden, die benutzerdefinierte Modellschnittstellen unterstützen, wie z. B. Janitor AI oder KoboldAI.

Der Einrichtungsvorgang läuft in der Regel wie folgt ab:

- Suchen Sie in der Option Einstellungen der App das Portal API oder Modellkonfiguration.

- Option

自定义或兼容OpenAIDer Typ der API. - Geben Sie in das Feld API-Adresse oder Proxy-URL die Adresse der Chutes-Anforderung ein:

https://llm.chutes.ai/v1/chat/completions。 - Geben Sie in das Feld API-Schlüssel den von Ihrem Chutes.ai-Konto generierten Schlüssel ein.

- Geben Sie in das Feld Modellname die Modellbezeichnung der gewünschten Rutschenplattform ein, z. B.

deepseek-ai/DeepSeek-V3。

Sobald die Einstellungen gespeichert sind, lässt die App das KI-Modell durch das Berechnungsnetzwerk von Chutes.ai laufen.

Setzen Sie Ihre eigenen Modelle ein

Für fortgeschrittene Benutzer, die benutzerdefinierte Modelle ausführen müssen, ermöglicht Chutes.ai das Hochladen von eigenem Code oder Docker-Containern. Detaillierte Anweisungen zum Verpacken und Bereitstellen eines benutzerdefinierten "Chute" (Container) finden Sie in der offiziellen Dokumentation. Dieser Prozess erfordert in der Regel, dass Sie das Modell und die zugehörigen Abhängigkeiten in ein Standard-Container-Image packen, das dann über die Tools der Plattform hochgeladen und bereitgestellt werden kann.

Anwendungsszenario

- Schnelles Prototyping von KI-Anwendungen

Für Start-ups oder Entwickler, die eine Idee schnell validieren müssen, bietet Chutes.ai eine Umgebung, in der sie sich nicht um die zugrunde liegenden Einrichtungen kümmern müssen. Die Entwickler können sich ganz auf die Anwendungslogik und das Benutzererlebnis konzentrieren und mit den vorhandenen Open-Source-Modellen der Plattform schnell einen funktionalen Prototyp erstellen. - Ausweitung der KI-Funktionen in bestehenden Anwendungen

Wenn eine bestehende Website oder App KI-Funktionen integrieren muss (z. B. intelligenten Kundenservice, Inhaltsempfehlungen oder Textzusammenfassungen), können Entwickler ihre Produkte durch Aufruf der API-Schnittstelle von Chutes.ai problemlos um leistungsstarke Modellierungsfunktionen erweitern, ohne dass hohe Hardware- und Wartungskosten anfallen. - Akademische Forschung und Experimente

Forscher müssen oft verschiedene KI-Modelle oder Algorithmen testen. Das Pay-as-you-go-Modell und die flexible Modellunterstützung von chutes.ai erleichtern die akademische Forschung. Forscher können jederzeit auf die neuesten Open-Source-Modelle für Experimente zurückgreifen, zu überschaubaren Kosten und ohne Zeitaufwand für die Konfiguration der Umgebung. - Bearbeitung umfangreicher Datenaufgaben

Für Aufgaben, die eine umfangreiche Texteinbettung, Datenanalyse oder Bildverarbeitung erfordern, kann die kommende Funktion "Long Jobs" von Chutes.ai genutzt werden. Nutzer können Batch-Aufgaben einreichen und die verteilten Rechenressourcen der Plattform nutzen, um ihre Arbeit effizient zu erledigen.

QA

- Wie unterscheidet sich Chutes.ai von den KI-Diensten, die von traditionellen Cloud-Anbietern (z. B. AWS, Google Cloud) angeboten werden?

Bei herkömmlichen Cloud-Anbietern müssen die Nutzer in der Regel virtuelle Maschinen, Container-Instanzen und Netzwerke selbst konfigurieren und verwalten, was ein komplizierter Prozess ist. chutes.ai bietet serverlose Computing-Dienste, die alle zugrunde liegenden technischen Details kapseln. Benutzer können das Modell direkt bereitstellen und aufrufen, und die Plattform kümmert sich automatisch um die Ressourcenzuweisung und Skalierung, wodurch die Schwelle für die Nutzung erheblich gesenkt wird. - Was bedeutet "dezentralisiert" auf der Plattform?

"Dezentralisiert" bedeutet, dass die Rechenressourcen von Chutes.ai nicht aus einem einzigen Rechenzentrum stammen, sondern aus einem Netz von GPU-Anbietern, die über den ganzen Globus verteilt sind. Diese Struktur verbessert die Stabilität und Ausfallsicherheit des Systems und bietet theoretisch durch Wettbewerbsmechanismen kostengünstigere Rechendienste. - Ist es sicher, Daten von Modellen auf Chutes.ai laufen zu lassen?

Chutes.ai sichert den Code der Nutzer, indem es ihn in einer isolierten Umgebung ausführt. Die Plattform plant außerdem die Einführung von vertrauenswürdigen Ausführungsumgebungen (Trusted Execution Environment, TEE), die ein höheres Maß an Datenschutz für Nutzer bieten, die mit sensiblen Daten arbeiten. - Was ist, wenn das Modell, das ich verwenden möchte, auf der Plattform nicht verfügbar ist?

Chutes.ai ermöglicht es Benutzern, ihre eigenen Modelle hinzuzufügen. Sie können jedes Open-Source-Modell in einen Docker-Container packen und auf der Plattform ausführen.