Baidu gab am 30. Juni bekannt, dass es sein neuestes Produkt offiziell als Open Source zur Verfügung stellt. ERNIE 4.5 Eine Familie von groß angelegten multimodalen Modellen. Die Familie besteht aus 10 Varianten in verschiedenen Maßstäben, die die Mixed Expertise (MoE)-Architektur vollständig einbeziehen und eine Komplettlösung von Modellen über Entwicklungskits bis hin zu Einsatzwerkzeugen bieten, die alle auf dem Apache 2.0 Unter Lizenz geöffnet.

Technologiekern: Heterogene MoE-Architektur für Multimodalität

Im Gegensatz zu dem in der Branche üblichen MoE-Modell ist dasERNIE 4.5 Eines der besonderen Merkmale von MoE ist sein innovativer "Multimodal Heterogeneous MoE"-Vortrainingsansatz. Die Architektur ist so konzipiert, dass das Modell bei der Verarbeitung multimodaler Informationen wie Text und Bilder gemeinsame Parameter nutzen kann, während unabhängige Parameter für spezifische Modalitäten beibehalten werden.

Um dieses Ziel zu erreichen, hat das Forschungs- und Entwicklungsteam eine Reihe von Techniken entwickelt, darunter modalitätsisoliertes Routing, orthogonaler Router-Verlust und multimodaler Token-balancierter Verlust. Der Kerngedanke dieser Verfahren besteht darin, sicherzustellen, dass das Lernen der textuellen und visuellen Modalitäten sich gegenseitig fördern kann, anstatt sich beim gemeinsamen Training gegenseitig zu behindern, wodurch das multimodale Verständnis des Modells erheblich verbessert wird, ohne die Leistung der textuellen Aufgabe zu beeinträchtigen.

Neben der Modellarchitektur hob Baidu auch seine Effizienzoptimierungen in der Trainings- und Inferenzinfrastruktur hervor. Mit Techniken wie Expertenparallelität im Knoten, speichereffizientem Pipeline-Scheduling, FP8-Training mit gemischter Genauigkeit und feinkörniger Neuberechnung erreichte das größte Sprachmodell vor dem Training eine Modell-FLOPs-Auslastung (MFU) von 47%. Auf der Inferenzseite hat derERNIE 4.5 Algorithmen wie die parallele Zusammenarbeit mehrerer Experten und die faltungskodierte Quantisierung wurden verwendet, um eine 4-Bit/2-Bit-Low-Bit-Quantisierung zu erreichen.

Leistung: Mehrdimensionaler Vergleich mit den Spitzenmodellen der Branche

Nach den von Baidu veröffentlichten Benchmarking-ErgebnissenERNIE 4.5 Starke Wettbewerbsfähigkeit in mehreren Dimensionen.

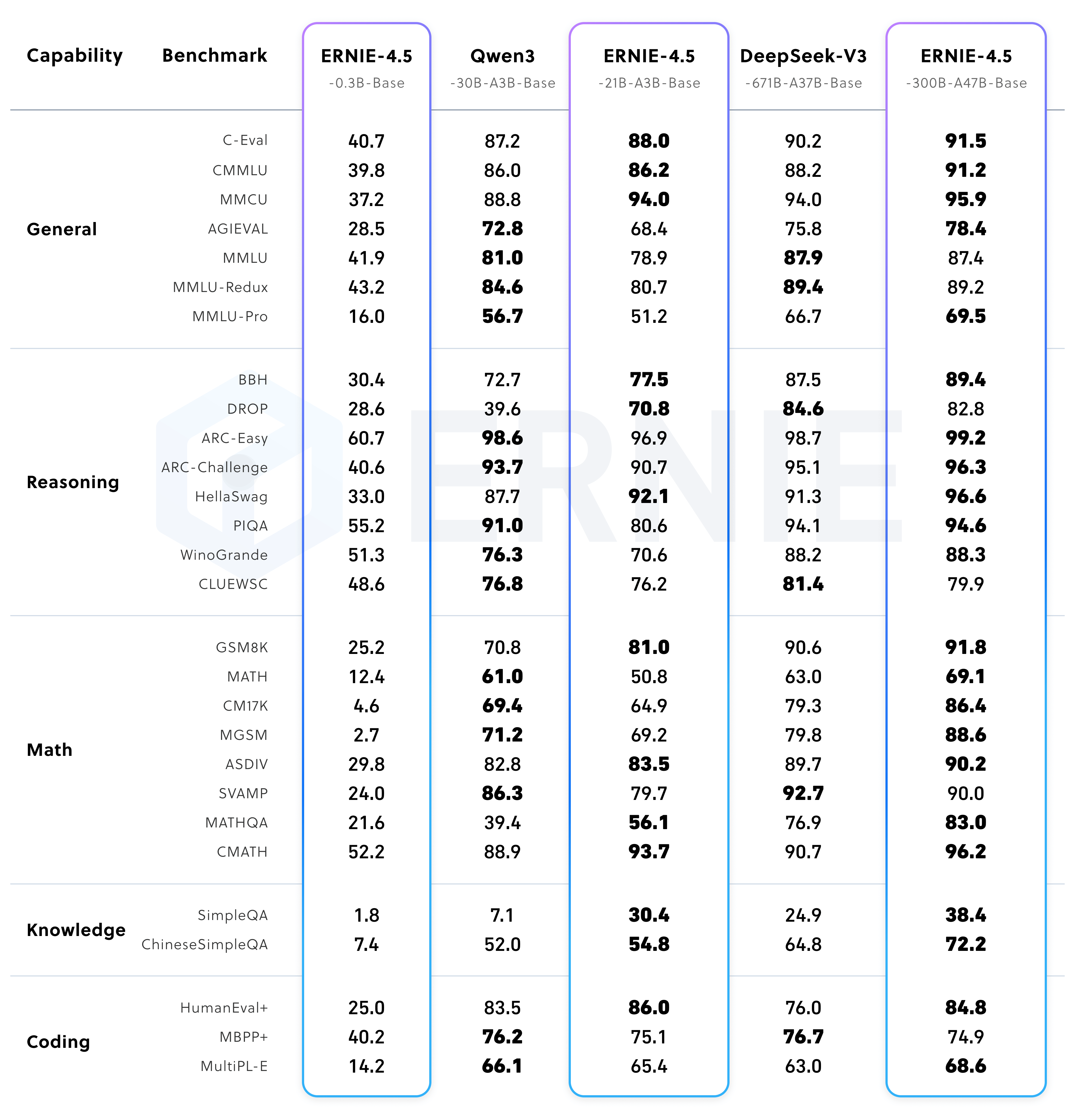

Leistung des vortrainierten Basismodells

ERNIE-4.5-300B-A47B-Base Das Modell schneidet bei 22 von 28 Benchmarks besser ab. DeepSeek-V3-671B-A37B-Base. Dies zeigt, dass das Modell in den Bereichen Verallgemeinerbarkeit, Schlussfolgerungen und wissensintensive Aufgaben führend ist.

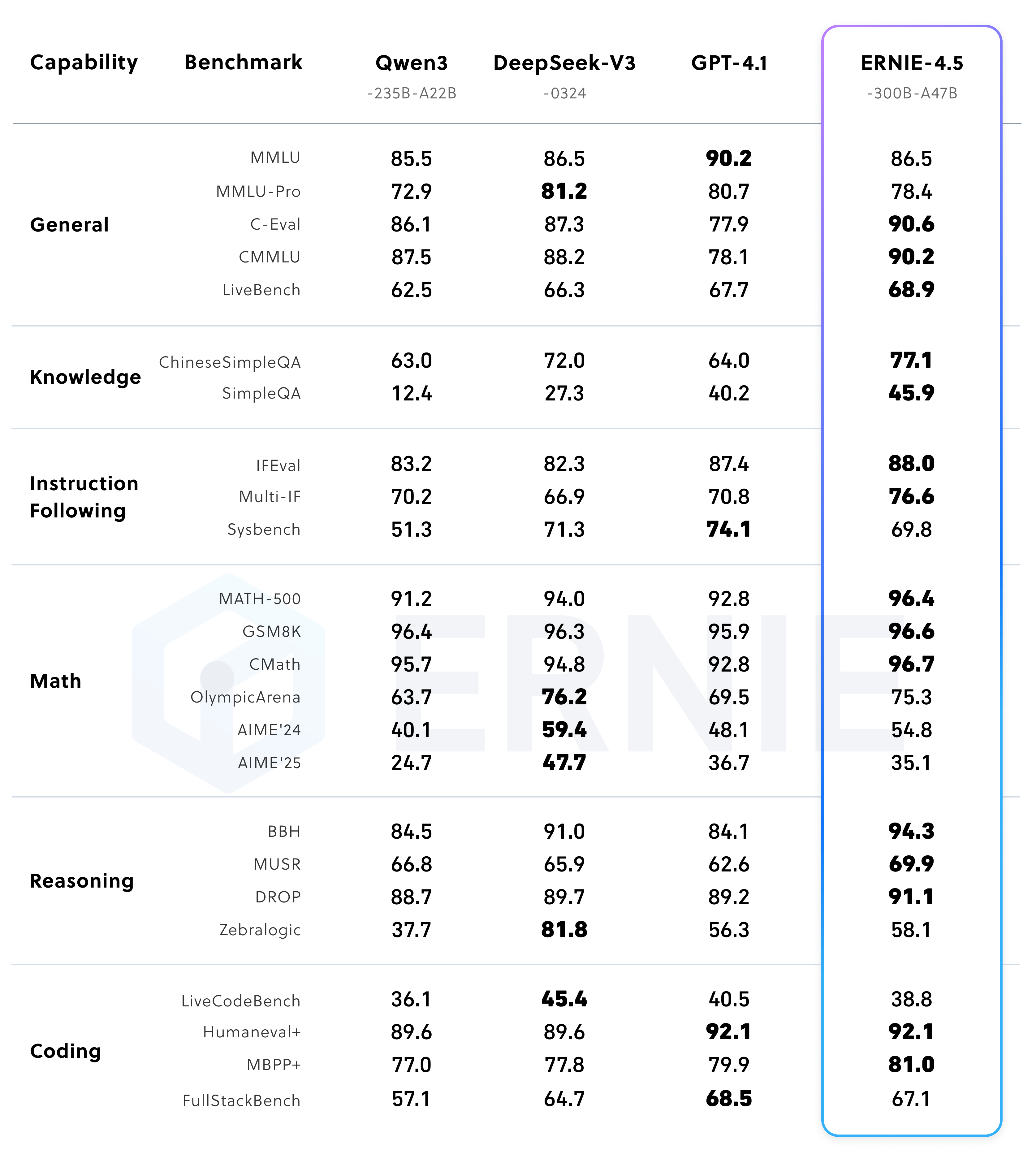

Modellleistung nach Feinabstimmung der Befehle

Nach der Befehlsfeinabstimmung der ERNIE-4.5-300B-A47B Das Modell erzielte Spitzenwerte bei Aufgaben wie "Instruction Followed" (IFEval) und "Knowledge Quiz" (SimpleQA).

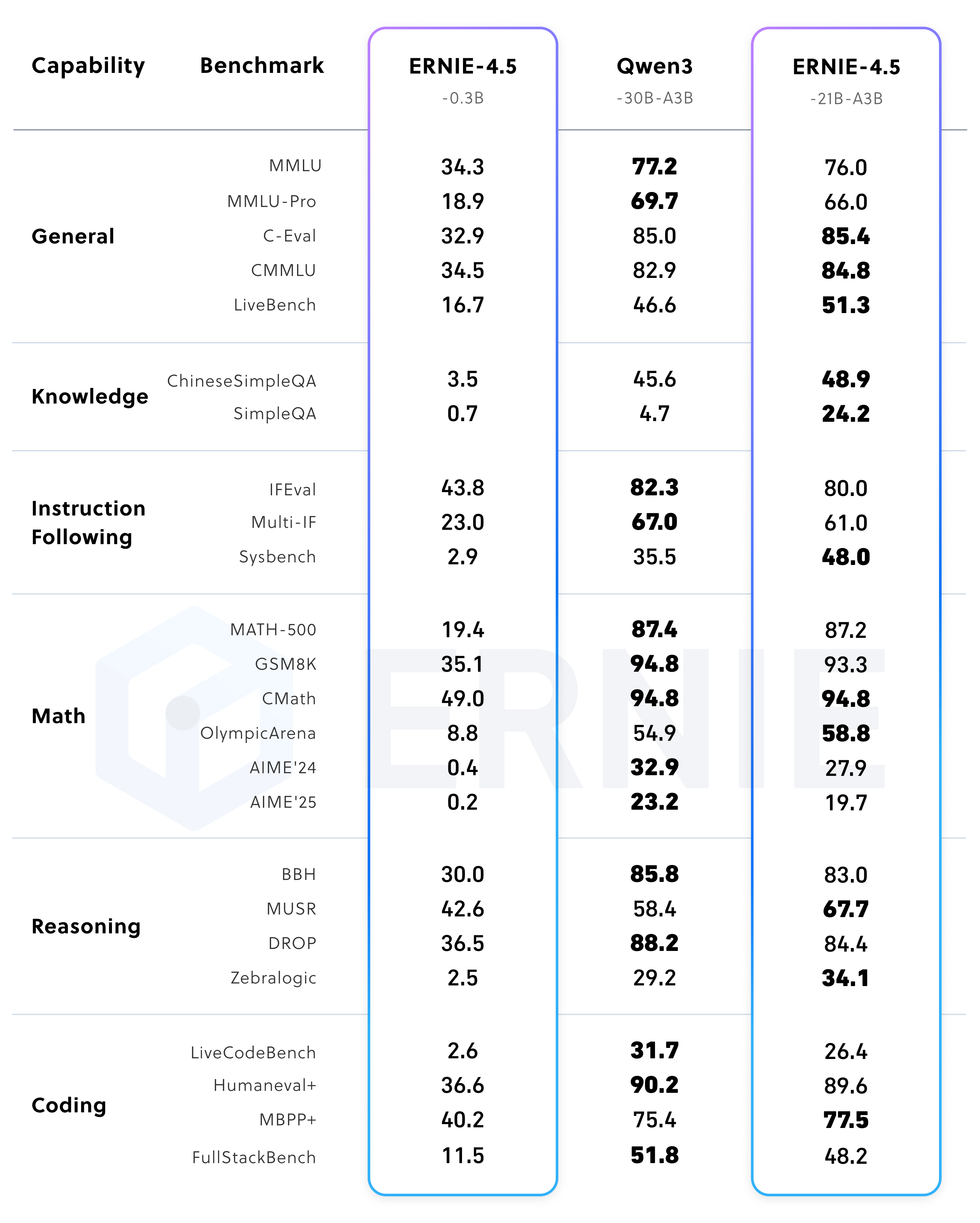

Gleichzeitig ist die kleinere Parametergröße von ERNIE-4.5-21B-A3B Modell, das eine Gesamtzahl von Senatoren von etwa Qwen3-30B von 70%, übertrifft diesen jedoch bei mathematischen und Inferenz-Benchmarks wie BBH und CMATH und zeigt damit eine hohe Parametereffizienz.

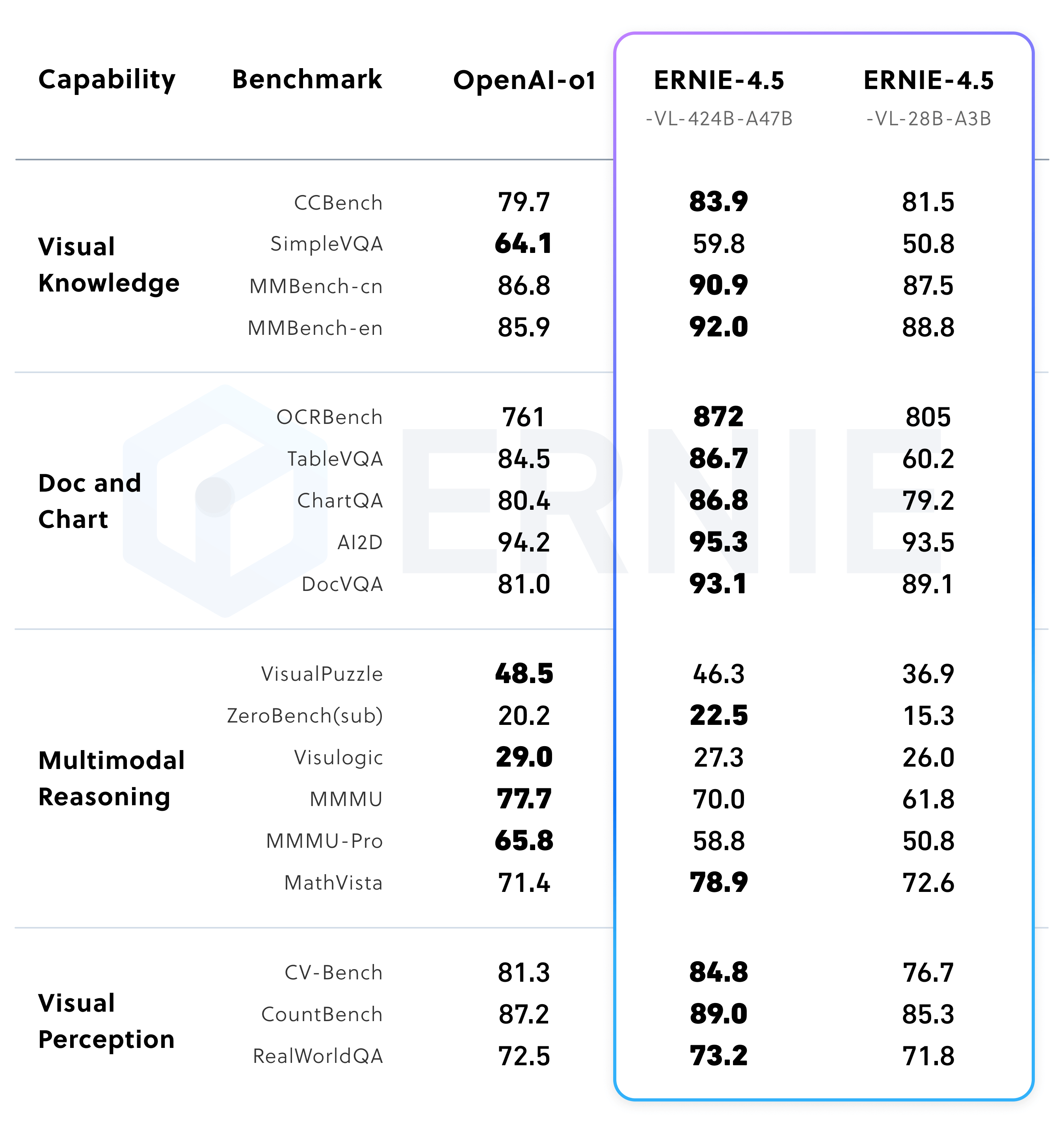

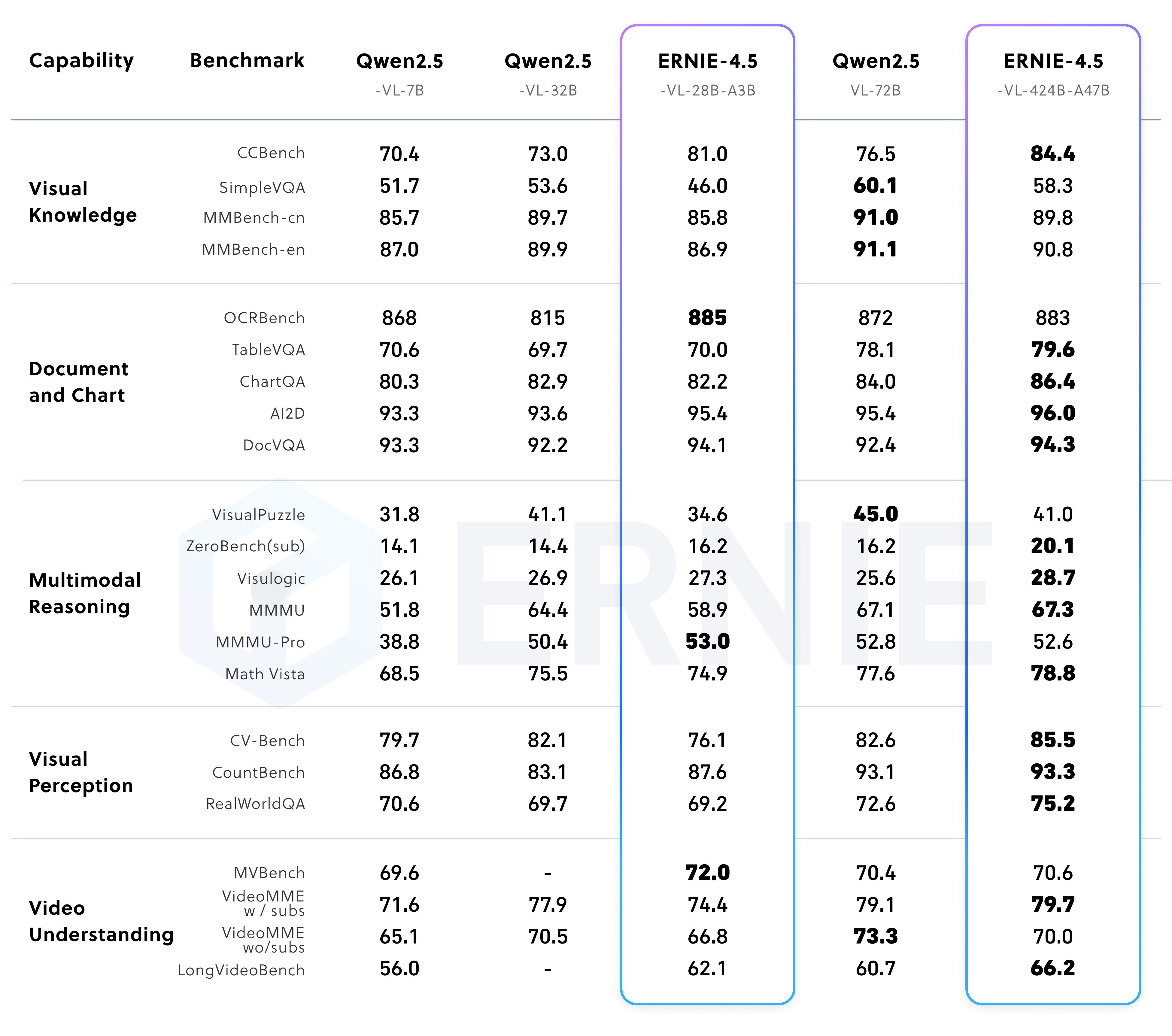

Multimodale Modellleistung

ERNIE 4.5 Das Visual Language Model (VLM) unterstützt sowohl den "Denkmodus" als auch den "Nicht-Denkmodus".

Im Nicht-Denk-Modus konzentriert sich das Modell auf eine effiziente visuelle Wahrnehmung und das Verstehen von Dokumenten und Diagrammen. Im Denkmodus hingegen behält das Modell seine starken Wahrnehmungsfähigkeiten bei und verbessert gleichzeitig die Fähigkeit zur MathVista、MMMU Argumentationsfähigkeit bei komplexen Benchmarks wieERNIE-4.5-VL Die leichtgewichtige Version von Qwen2.5-VL-32B。

Ökologie und Toolchain:ERNIEKit 和 FastDeploy

ERNIE 4.5 Die Modellfamilie basiert auf PaddlePaddle Deep-Learning-Framework und bietet außerdem PyTorch Kompatible Versionen. Baidu hat zwei zentrale Tools veröffentlicht, um die Hürde für Entwickler zu senken.

- ERNIEKit: Modell-Feinabstimmung und -Anpassung

ERNIEKitist ein industrietaugliches Entwicklungs-Toolkit, das die überwachte Feinabstimmung (SFT), die direkte Präferenzoptimierung (DPO) und dieLoRAQuantisiertes Training (QAT) und Quantisierung nach dem Training (PTQ) sowie eine Reihe anderer gängiger Trainings- und Kompressionstechniken.Entwickler können Modelle herunterladen und SFT- oder DPO-Aufgaben über Befehlszeilentools durchführen.

# 下载模型 huggingface-cli download baidu/ERNIE-4.5-300B-A47B-Base-Paddle \ --local-dir baidu/ERNIE-4.5-300B-A47B-Base-Paddle # 监督微调 (SFT) erniekit train examples/configs/ERNIE-4.5-300B-A47B/sft/run_sft_wint8mix_lora_8k.yaml \ model_name_or_path=baidu/ERNIE-4.5-300B-A47B-Base-Paddle - FastDeploy: effiziente Modellbereitstellung

FastDeployist ein effizientes Einsatz-Toolkit für große Modelle mit einer API, die mit demvLLM和OpenAIProtokoll, das den Einsatz der Servitisierung mit nur einem Klick unterstützt. Es bietet dieERNIE 4.5s MoE-Modell bietet eine industrietaugliche Lösung für den Einsatz auf mehreren Computern mit integrierten Beschleunigungstechniken wie Low-Bit-Quantisierung, Kontext-Caching und spekulative Decodierung.Der Beispielcode für die lokale Inferenz lautet wie folgt:

from fastdeploy import LLM, SamplingParams prompt = "Write me a poem about large language model." sampling_params = SamplingParams(temperature=0.8, top_p=0.95) llm = LLM(model="baidu/ERNIE-4.5-0.3B-Paddle", max_model_len=32768) outputs = llm.generate(prompt, sampling_params)Serviced Deployments hingegen können mit einer einzigen Befehlszeile gestartet werden:

python -m fastdeploy.entrypoints.openai.api_server \ --model "baidu/ERNIE-4.5-0.3B-Paddle" \ --max-model-len 32768 \ --port 9904

Open-Source-Lizenzierung und Zitierung

ERNIE 4.5 Das Modell folgt Apache License 2.0 Vereinbarung erlaubt die Lizenz die kommerzielle Nutzung.

Verwenden Sie für Ihre Recherchen die folgenden Zitate BibTeX Format:

@misc{ernie2025technicalreport,

title={ERNIE 4.5 Technical Report},

author={Baidu ERNIE Team},

year={2025},

eprint={},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={}

}