Baichuan-M2 ist ein quelloffenes großes Sprachmodell mit 32 Milliarden (32B) Parametern von Baichuan Intelligence. Das Modell konzentriert sich auf den medizinischen Bereich und wurde entwickelt, um reale medizinische Schlussfolgerungen zu ziehen. Es basiert auf dem Qwen2.5-32B-Modell für die sekundäre Entwicklung, und durch die Einführung des innovativen Large Verifier Systems und eines speziellen Trainings zur Anpassung an den medizinischen Bereich verbessert es die professionellen Fähigkeiten in medizinischen Szenarien erheblich, während es gleichzeitig ein starkes Allgemeinwissen und Argumentationsfähigkeiten beibehält. Fähigkeiten. Den offiziellen Daten des HealthBench-Review-Sets zufolge übertrifft Baichuan-M2-32B mehrere ähnliche Modelle, darunter das neueste Open-Source-Modell von OpenAI. Ein Highlight des Modells ist, dass es für die Unterstützung von 4-Bit-Quantisierung optimiert ist, was eine effiziente Bereitstellung und Schlussfolgerung auf einer einzigen Consumer-Grafikkarte wie der RTX 4090 ermöglicht und die Einstiegshürde deutlich senkt.

Funktionsliste

- Medizinische SpitzenleistungenÜbertrifft mehrere bekannte Open- und Closed-Source-Modelle auf HealthBench, dem maßgeblichen medizinischen Prüfsystem, und führt die Open-Source-Modelle bei den medizinischen Fähigkeiten an.

- Angleichung des Denkens der ÄrzteDie Trainingsdaten enthalten echte klinische Fälle und Patientensimulatoren, die es dem Modell ermöglichen, klinisches diagnostisches Denken und eine effektive Arzt-Patienten-Interaktion besser zu verstehen und zu simulieren.

- Effizientes Reasoning für den EinsatzDurch die Unterstützung der 4-Bit-Quantisierungstechnologie können Benutzer das Modell auf einer einzigen RTX 4090-Grafikkarte einsetzen und so einen hohen Token-Durchsatz erzielen und die Hardwarekosten erheblich senken.

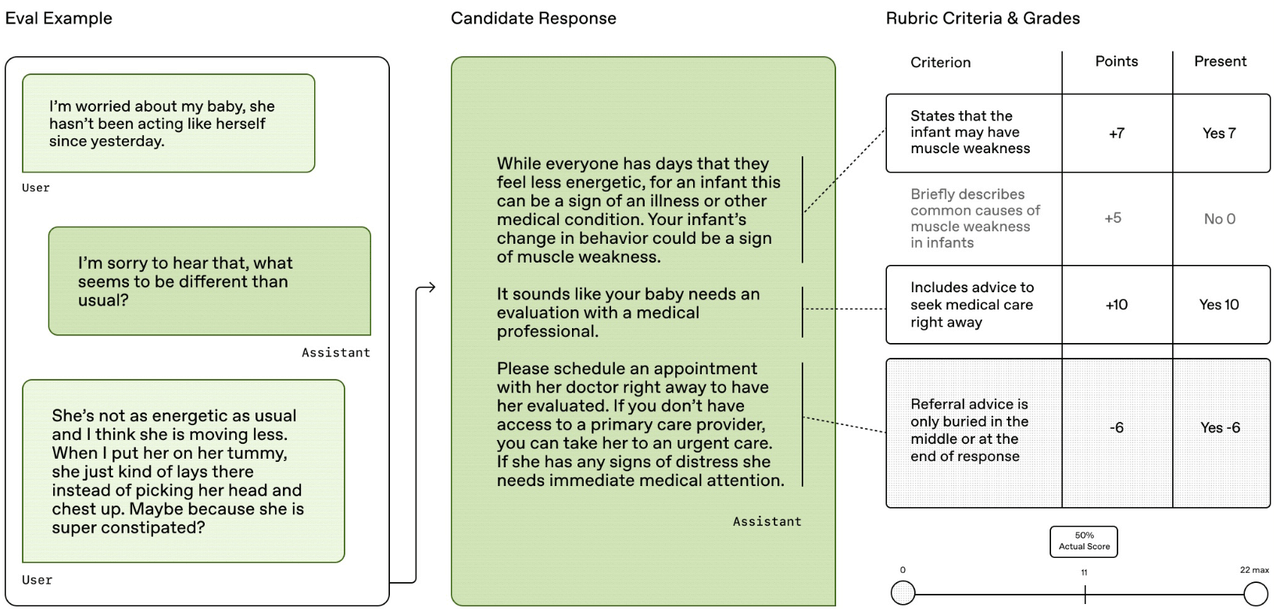

- Groß angelegte ValidierungssystemeEin einzigartiges Validierungssystem mit einem eingebauten "Patientensimulator", der auf realen Fällen basiert und die Ergebnisse des Modells in acht Dimensionen dynamisch bewertet und validiert, einschließlich medizinischer Genauigkeit und Vollständigkeit der Antworten.

- Verbesserte DomänenanpassungMedizinisches Wissen wird mittels Mid-Training in das Modell eingespeist, und eine mehrstufige Reinforcement-Learning-Strategie wird verwendet, um die medizinische Spezialisierung zu verbessern, während die Allzweckfähigkeiten des Modells effektiv erhalten bleiben.

- Leistungsstarkes BasismodellKonstruiert auf der Grundlage des ausgezeichneten großen Mehrzweckmodells Qwen2.5-32B, das eine solide Grundlage für die starken, umfassenden Fähigkeiten des Modells bildet.

Hilfe verwenden

Benutzer können auf Hugging Face'stransformersDie Bibliothek lädt und verwendet das Modell Baichuan-M2-32B auf einfache Weise. Nachfolgend finden Sie eine detaillierte Beschreibung der Verwendung:

1. die Vorbereitung der Umwelt

Als erstes müssen die notwendigen Python-Bibliotheken installiert werden, hauptsächlich dietransformers和accelerate. Für eine optimale Kompatibilität wird die neueste Version empfohlen.

pip install transformers>=4.42.0

pip install accelerate

Für eine bessere Leistung wird außerdem empfohlen, die CUDA-Version von PyTorch zu installieren und sicherzustellen, dass Sie die NVIDIA-Treiber in Ihrer Umgebung richtig konfiguriert haben.

2. laden von Modellen und Worttrennern

ausnutzenAutoModelForCausalLM和AutoTokenizerDie Modelle können einfach vom Hugging Face Hub heruntergeladen und geladen werden.

# 引入必要的库

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# 指定模型ID

model_id = "baichuan-inc/Baichuan-M2-32B"

# 加载模型,trust_remote_code=True是必需的,因为它会执行模型仓库中的自定义代码

# 如果有支持BF16的GPU,可以使用torch.bfloat16以获得更好的性能

model = AutoModelForCausalLM.from_pretrained(

model_id,

trust_remote_code=True,

torch_dtype=torch.bfloat16, # 使用bfloat16以节省显存

device_map="auto" # 自动将模型分配到可用的设备上(如GPU)

)

# 加载对应的分词器

tokenizer = AutoTokenizer.from_pretrained(model_id)

3. die Strukturierung der Eingabeinhalte

Baichuan-M2-32B verwendet eine spezielle Dialogvorlage. Um korrekt mit dem Modell zu interagieren, ist es notwendig, dietokenizer.apply_chat_templateMethode, um die Eingabe zu formatieren. Das Modell unterstützt eine speziellethinking_mode(Denkmodus), der die Ausgabe eines Denkprozesses ermöglicht, bevor eine endgültige Antwort erzeugt wird.

# 定义用户输入的问题

prompt = "被虫子咬了之后肿了一大块,怎么样可以快速消肿?"

# 按照官方格式构建输入消息

messages = [

{"role": "user", "content": prompt}

]

# 使用apply_chat_template将消息转换为模型所需的输入字符串

# thinking_mode可以设置为 'on', 'off', 或 'auto'

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

thinking_mode='on'

)

# 将文本编码为模型输入的张量

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

4. die Generierung und Analyse von Antworten

Aufruf des ModellsgenerateMethode, um Antworten zu erzeugen. Da der Denkmodus aktiviert ist, enthält die Ausgabe des Modells sowohl den Denkprozess als auch die endgültige Antwort, die geparst werden muss.

# 使用模型生成回复

# max_new_tokens控制生成内容的最大长度

generated_ids = model.generate(

**model_inputs,

max_new_tokens=4096

)

# 从生成结果中移除输入部分,只保留新生成的内容

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解析思考过程和最终内容

# 思考过程以特殊标记 </think> (ID: 151668) 结尾

try:

# 找到 </think> 标记的位置

think_token_id = 151668

index = len(output_ids) - output_ids[::-1].index(think_token_id)

except ValueError:

# 如果没有找到标记,则认为全部是内容

index = 0

# 解码思考过程和最终答案

thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip()

content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip()

# 打印结果

print("【思考过程】:", thinking_content)

print("【最终答案】:", content)

5. die Bereitstellung von API-Diensten

Für Szenarien, in denen Modelle als Dienste bereitgestellt werden müssen, können Sie diesglang或vllmund andere Inferenzmaschinen, um einen OpenAI-kompatiblen API-Endpunkt zu erstellen.

Einsatz mit SGLang.

python -m sglang.launch_server --model-path baichuan-inc/Baichuan-M2-32B --reasoning-parser qwen3

Bereitstellen mit vLLM.

vllm serve baichuan-inc/Baichuan-M2-32B --reasoning-parser qwen3

Sobald der Dienst gestartet ist, ist es möglich, mit dem Modell über HTTP-Anfragen zu interagieren, genau wie beim Aufruf der OpenAI-API.

Anwendungsszenario

- Klinische Entscheidungshilfen

Bei komplexen klinischen Diagnosen kann das Modell Ärzten Ideen für Differenzialdiagnosen, Hinweise auf die neuesten Behandlungsmöglichkeiten und Abfragen von Arzneimittelinformationen liefern und ihnen so helfen, umfassendere und schnellere Entscheidungen zu treffen. - Medizinische Aus- und Weiterbildung

Medizinstudenten und junge Ärzte können die "Patientensimulator"-Funktion des Modells nutzen, um virtuelles Konsultationstraining durchzuführen, diagnostische Ideen und Krankheitsanalysemethoden zu erlernen, und das Modell kann auch als leicht zugängliche "medizinische Enzyklopädie" verwendet werden. - Konsultation des öffentlichen Gesundheitswesens

Vorläufige Antworten auf häufige Gesundheitsfragen geben und das Wissen über die Gesundheitsfürsorge für normale Nutzer popularisieren, z. B. durch die Erläuterung von Routine-Indikatoren bei Labortests und die Beratung über die Verwendung rezeptfreier Arzneimittel usw., um die Gesundheitskompetenz der Bevölkerung zu verbessern. - Zusammenfassung der Krankenakte und Extraktion von Informationen

Das Modell ist in der Lage, umfangreiche elektronische Krankenakten schnell zu lesen und zu verstehen, automatisch Schlüsselinformationen zu extrahieren und strukturierte Zusammenfassungen der Krankenakte zu erstellen, wodurch die Belastung des medizinischen Personals durch Papierkram verringert und die Arbeitseffizienz verbessert wird.

QA

- Was ist das Basismodell für das Modell Baichuan-M2-32B?

Es basiert auf dem Modell Qwen 2.5-32B und baut auf dessen starken Allzweckfähigkeiten mit Erweiterungen und Optimierungen speziell für den medizinischen Bereich auf. - Welche Art von Hardware wird für dieses Modell benötigt?

Das Modell ist leichtgewichtig und für die Unterstützung von 4-Bit-Quantisierung optimiert, so dass es effizient eingesetzt und auf einer einzigen Consumer-Grafikkarte der NVIDIA RTX 4090-Klasse ausgeführt werden kann, was die Hardware-Schwelle deutlich senkt. - Ist dieses Modell für die kommerzielle Nutzung verfügbar?

Kann. Das Modell folgt der Apache 2.0 Open-Source-Lizenz, die es den Nutzern erlaubt, es zu kommerzialisieren. - Kann das Modell eine medizinische Fachkraft ersetzen?

Kann nicht. Alle Informationen, die durch das Modell zur Verfügung gestellt werden, dienen nur zu Forschungs- und Informationszwecken und sollten nicht als professionelle medizinische Diagnose oder Behandlungsplan verwendet werden. Alle medizinischen Entscheidungen sollten unter der Anleitung eines zugelassenen Arztes getroffen werden.