ARGO ist eine quelloffene KI-Agentenplattform mit dem Kernkonzept "local first", das es den Nutzern ermöglicht, einen leistungsstarken und engagierten KI-Assistenten auf ihrem eigenen PC aufzubauen. Die Plattform integriert eine Vielzahl fortschrittlicher Technologien im Bereich der KI, wie z.B. ein Multi-Intelligenz-System, das es KI ermöglicht, selbstständig zu denken und Aufgaben zu planen, die RAG-Technologie, die den Zugang zu lokalen Wissensdatenbanken erleichtert, und das Herunterladen und Verwalten lokaler großsprachiger Modelle mit einem Klick. Mit ARGO können Nutzer komplexe Aufgaben wie tiefgreifende Recherchen, die Erstellung von Inhalten oder Datenanalysen sicher und privat erledigen, da alle Daten lokal gespeichert werden und der Offline-Betrieb vollständig unterstützt wird. eigene Super-KI-Intelligenz zu haben.

Funktionsliste

- Lokalisierung und DatenschutzDie Software unterstützt den kompletten Offline-Betrieb und alle Benutzerdaten 100% werden auf dem lokalen Computer gespeichert, um Datenschutz und Sicherheit zu gewährleisten. Out-of-the-box Windows, macOS und Linux-Clients sind verfügbar.

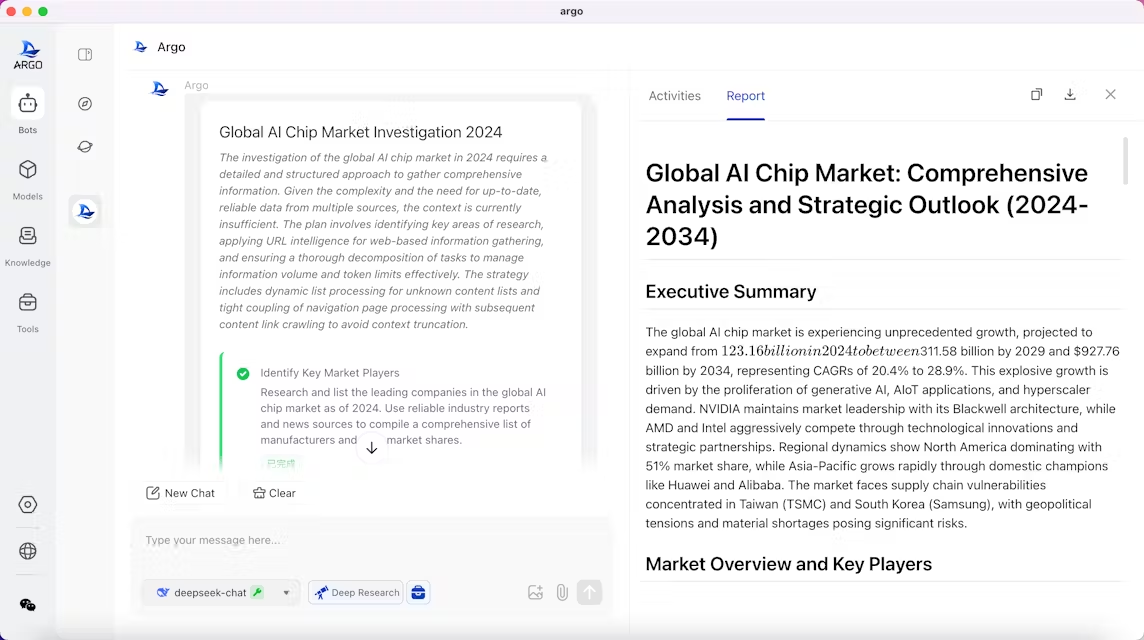

- Multi-Intelligenz-ZusammenarbeitEine integrierte Multi-Intelligenz-Aufgabenmaschine, die wie ein Team zusammenarbeiten kann. Sie kann selbstständig die Absicht des Benutzers verstehen, Aufgabenschritte planen, mehrstufige Arbeiten durchführen und schließlich Berichte erstellen.

- Maßgeschneiderte IntelligentsiaBenutzer können exklusive Intelligenzen auf der Grundlage spezifischer Bedürfnisse erstellen, z. B. Reiseplanungsassistenten, Industrieanalysten oder Rechtsberater. Mit einer einfachen Beschreibung ist es möglich, einen KI-Assistenten für ein bestimmtes Szenario anzupassen.

- Kompatibel mit vielen großen ModellenIntegriertes Ollama ermöglicht das Herunterladen und Ausführen großer Open-Source-Modelle mit einem Klick. Es unterstützt auch den Zugang zu den APIs von OpenAI, Claude, DeepSeek und vielen anderen Closed-Source-Modellen, so dass die Benutzer flexibel zwischen lokalen Modellen und Cloud-API-Modellen wechseln können, je nach Bedarf.

- Lokale RAG-Wissensbasis-EngineUnterstützt den Import von Wissen aus Dateien, Ordnern, Websites und anderen Kanälen. Wenn sie mit einem lokalen Ordner verbunden ist, kann die Wissensdatenbank dynamisch synchronisiert und aktualisiert werden. Sie ist in der Lage, Dokumente in verschiedenen Formaten wie PDF, Word, Webseiten usw. zu analysieren und den Referenzinhalt bei der Beantwortung von Fragen zurückzuverfolgen.

- integriertes ToolsetIntegrierter Web-Crawler, Browser-Steuerung, lokale Dateiverwaltung und viele andere nützliche Tools, und unterstützen den Benutzer, die Integration ihrer eigenen Tools zu erweitern.

- Entwicklung des kontinuierlichen LernensDie Software ist in der Lage, die Arbeitsgewohnheiten und Vorlieben des Nutzers zu erlernen und kann im Laufe der Nutzung optimiert werden, um sich schließlich zu einem intelligenten Körper zu entwickeln, der den Nutzer besser versteht (diese Funktion wird derzeit getestet).

- Reichhaltige Chat-InteraktionUnterstützt die Darstellung von mathematischen Formeln, Mermaid-Diagrammen (Flussdiagramme, Sequenzdiagramme usw.) und ermöglicht die freie Verzweigung von Dialogen, was die Verwaltung und Nachverfolgung von Kommunikationsprotokollen für die Benutzer erleichtert.

Hilfe verwenden

ARGO wurde entwickelt, um den Prozess der Bereitstellung und Nutzung lokaler KI-Intelligenzen zu vereinfachen, so dass Sie schnell loslegen können, egal ob Sie ein technisch nicht versierter Benutzer oder ein Entwickler sind.

Grundlegende Hardware-Anforderungen

Stellen Sie vor der Installation von ARGO sicher, dass Ihr Computer die folgenden Mindestanforderungen an die Konfiguration erfüllt:

- CPU:: Mindestens 4 Kerne

- Speicher (RAM)Mindestens 8 GB

Wenn Sie vorhaben, umfangreiche Sprachmodelle mit höheren Leistungsanforderungen auszuführen, empfiehlt es sich, höher konfigurierte Hardware zu verwenden, insbesondere Computer mit NVIDIA-Grafikkarten, um die Vorteile der GPU-Beschleunigung zu nutzen.

Desktop-Client-Installation (für Einsteiger empfohlen)

Dies ist die einfachste und unkomplizierteste Art der Nutzung, ohne zusätzliche Konfiguration, Download und Nutzung.

- Besuchen Sie ARGOs offizielle GitHub-Seite (Releases).

- Je nach Betriebssystem laden Sie das entsprechende Installationspaket herunter:

- Windows: Downloads mit dem Suffix

.exeDateien, wie zum Beispiel dieargo-0.3.1-windows-x64-installer.exe。 - macOS (Apple Silicon): Downloads mit dem Suffix

osx-installer.dmgDateien, wie zum Beispiel dieargo-0.3.1-osx-installer.dmg。 - macOS (Intel): Downloads mit dem Suffix

mac-intel-installer.dmgDateien, wie zum Beispiel dieargo-0.3.1-mac-intel-installer.dmg。

- Windows: Downloads mit dem Suffix

- Sobald der Download abgeschlossen ist, doppelklicken Sie auf die Installationsdatei und folgen Sie den Anweisungen auf dem Bildschirm, um die Installation abzuschließen.

Bereitstellung mit Docker (für Entwickler und fortgeschrittene Benutzer)

Wenn Sie mit Docker vertraut sind oder ARGO in einer Server-, All-in-one- usw. Umgebung einsetzen möchten, können Sie diesen Ansatz wählen. Dieser Ansatz ist flexibler und kann leicht mit anderen Diensten integriert werden.

Zusätzliche Software-Anforderungen:

Docker >= 24.0.0Docker Compose >= v2.26.1

Wählen Sie je nach Ihren Bedürfnissen eine der folgenden Bereitstellungsoptionen:

Option 1: Nur Installation von ARGO (Anschluss an externes Ollama)

Wenn der Ollama-Dienst bereits lokal läuft oder andere Container Ollama ausführen, können Sie diesen Befehl verwenden, damit ARGO sich mit dem bestehenden Dienst verbindet.

docker compose -f docker/docker-compose.yaml up -d

zur Kenntnis nehmenDieses Programm beinhaltet nicht den Ollama-Dienst, so dass die Möglichkeit, einige Modelle innerhalb der Software herunterzuladen (z. B. von HuggingFace), eingeschränkt sein kann.

2) Option 2: Installation von ARGO mit Ollama (CPU-Version)

In diesem Szenario werden sowohl ARGO als auch Ollama eingesetzt und die CPU für die Modellinferenz verwendet. Dies ist der empfohlene Weg, um lokale Modelle auf Geräten ohne NVIDIA-Grafikkarten auszuführen.

docker compose -f docker/docker-compose.ollama.yaml up -d

AnweisungenOllama wird als Dienst mit ARGO an der Dienstadresse eingerichtet. http://ollama:11434Die ARGO-Schnittstelle unterstützt das automatische Herunterladen und Laden von lokalen Modellen innerhalb der ARGO-Schnittstelle.

3) Option 3: Installation von ARGO mit Ollama (GPU-Version)

Verwenden Sie diese Lösung, wenn Sie einen Rechner mit einer NVIDIA-Grafikkarte besitzen und die Modellinferenz mithilfe der GPU beschleunigen möchten.

docker compose -f docker/docker-compose.ollama.gpu.yaml up -d

VoraussetzungenVergewissern Sie sich, dass das NVIDIA Container Toolkit ordnungsgemäß auf Ihrem Host installiert ist. Mit dieser Version wird die GPU-Unterstützung aktiviert, und der Ollama-Dienst wird ebenfalls innerhalb von Containern bereitgestellt und unterstützt die GPU-Beschleunigung.

ARGO besuchen

Nach einer erfolgreichen Bereitstellung über Docker öffnen Sie in Ihrem Browser die http://localhost:38888 Der Zugriff auf die ARGO-Benutzeroberfläche ist möglich.

Grundfunktion Betrieb

- Modell-ManagementSie können beliebte Open-Source-Modelle aus der Community mit einem einzigen Klick herunterladen oder API-Schlüssel konfigurieren, um sich mit entfernten Modelldiensten wie OpenAI zu verbinden.

- Intelligentsia schaffenMit der Intelligence Factory können Sie die Rollen einer neuen Intelligenz definieren, ihre Arbeitsziele festlegen, die Modelle und Werkzeuge binden, die sie verwenden kann, und ihre eigene Wissensbasis konfigurieren.

- betreiben.Das intelligente System von ARGO unterteilt diese Aufgabe automatisch in mehrere Schritte, wie z. B. "Suche nach den neuesten Informationen", "Zusammenstellen der wichtigsten Informationen", "Schreiben eines Berichts" usw., und führt sie nacheinander aus. ARGO unterteilt die Aufgabe automatisch in mehrere Schritte, z. B. "Suche nach den neuesten Informationen", "Zusammentragen von Schlüsselinformationen", "Schreiben eines Berichts" usw., und führt sie nacheinander aus.

- Nutzung der WissensdatenbankIm Modul Wissensbasisverwaltung können Sie eine Wissensbasis erstellen, indem Sie eine Datei hochladen, sie mit einem lokalen Ordner verknüpfen oder eine URL eingeben. Nach der Erstellung können Sie die entsprechende Wissensdatenbank während des Dialogs mit der intelligenten Stelle einbinden, und die intelligente Stelle wird Fragen auf der Grundlage der von Ihnen bereitgestellten Informationen beantworten.

Anwendungsszenario

- Persönlicher Assistent

ARGO kann als persönlicher Assistent rund um die Uhr eingesetzt werden, der den Nutzern hilft, ihre Termine zu verwalten, Einkaufsvorschläge zu machen und die täglichen Aufgaben zu erledigen. - Studium und Forschung

Studenten und Forscher können ARGO zur Unterstützung ihres Lernens nutzen. Es kann helfen, komplexe akademische Konzepte zu verstehen, reichhaltige Lernressourcen bereitzustellen, Studienpläne anzupassen und bei Bedarf Ratschläge für die Wiederholung zu geben. Durch die Montage von Papieren und Lehrbüchern kann ARGO zu einem professionellen akademischen Quiz-Assistenten werden. - Erstellung von Inhalten

Für Autoren, Blogger und Vermarkter kann ARGO automatisch Artikelentwürfe erstellen, den Schreibstil optimieren, kreative Inspirationen liefern und die Effizienz und Qualität der Inhaltserstellung erheblich verbessern. - Unterstützung bei der Programmierung der Entwicklung

Entwickler können ARGO verwenden, um Codeschnipsel zu erzeugen, Programme zu debuggen oder Lösungen für technische Probleme zu finden. Es kann als unermüdlicher Programmierpartner fungieren, der Entwicklern hilft, Programmieraufgaben effizienter zu lösen. - Berater in Spezialgebieten

Durch individuelle Anpassung kann ARGO in einen Experten für eine bestimmte Branche verwandelt werden, z. B. in einen Rechtsberater oder einen Branchenanalysten. Die Nutzer können einen intelligenten Körper schaffen, der mit einer spezialisierten Wissensbasis ausgestattet ist, um den Anforderungen eines bestimmten Fachgebiets gerecht zu werden. - Datenanalyse und Berichterstattung

ARGO analysiert schnell Daten, erstellt Diagramme und Berichte und bietet Datenunterstützung für Geschäftsentscheidungen. Die Benutzer müssen lediglich Datendateien importieren und Anweisungen für deren Analyse geben.

QA

- Ist ARGO kostenlos?

Ja, ARGO ist ein Open-Source-Projekt, das unter der LICENSE-Lizenz veröffentlicht wird. Sie können es kostenlos herunterladen, verwenden und verändern. - Sind meine Daten sicher?

Eine der Kernfunktionen von ARGO ist "local first", d.h. alle Daten, einschließlich der Gesprächsprotokolle, der Inhalte der Wissensdatenbank und der Modelldateien, werden auf Ihrem eigenen Computer gespeichert und nicht auf einen Cloud-Server hochgeladen, so dass ARGO vollständig von LINE unterstützt wird. - Welche AI-Modelle kann ich verwenden?

ARGO ist sehr kompatibel. Es verfügt über integriertes Ollama, das das Herunterladen und Ausführen nativer Open-Source-Modelle im GGUF-Format erleichtert. Es unterstützt auch die Verbindung zu großen Closed-Source-Modell-Anbieter wie OpenAI, Claude, DeepSeek, etc. über API-Schlüssel. - Können auch technisch nicht versierte Personen ARGO benutzen?

Ja. ARGO bietet ein grafisches Installationspaket für Windows- und macOS-Benutzer, das mit einem Doppelklick und ohne komplizierte Befehlszeilenoperationen installiert werden kann, was es ideal für Benutzer mit nicht-technischem Hintergrund macht. - Befindet sich dieses Projekt noch in der Entwicklung?

Ja, das ARGO-Projekt befindet sich derzeit in einem frühen Stadium der schnellen Entwicklung. Das Entwicklungsteam arbeitet aktiv an der Verbesserung von Funktionen und der Behebung von Problemen und plant, in Zukunft weitere Funktionen wie globale personalisierte Erinnerungen, zeitgesteuerte Aufgaben und mehr hinzuzufügen.