Da die sprachübergreifende Kommunikation zum Kernstück der Globalisierung geworden ist, war das Simultandolmetschen schon immer die größte Herausforderung im Bereich der maschinellen Übersetzung. Vor kurzem hat das Seed-Team von Byte Jump ein Programm namens Seed LiveInterpret 2.0 Das Modell des End-to-End-Simultandolmetschens bietet eine zuverlässige technische Lösung für die sprachübergreifende Kommunikation in Echtzeit.

Geringere Latenzzeit, natürlicheres Erlebnis

Die meisten der herkömmlichen maschinellen Simultandolmetschsysteme verwenden ein kaskadiertes Schema, d. h. das dreistufige Modell "Spracherkennung (ASR) → Textübersetzung (MT) → Sprachsynthese (TTS)". Obwohl dieses Modell ausgereift ist, führt jede Verbindung zu einer Verzögerungsakkumulation, und Fehler werden in der Verbindung übertragen, um sie zu verstärken, was den endgültigen Übersetzungseffekt und die Echtzeit stark reduziert.

Seed LiveInterpret 2.0 Die End-to-End (E2E)-Speech-to-Speech (S2S)-Modellierung wurde verwendet, um die drei oben genannten Schritte in ein einziges Modell zu integrieren. Diese Architektur ermöglicht es dem Modell, Vollduplex-Sprachverstehen und -Generierung zu erreichen, was zu einem besseren Gleichgewicht zwischen Übersetzungsgenauigkeit und Latenz führt.

Offiziell veröffentlichten Daten zufolge sind in Sprache-zu-Text-Szenarien (S2T) dieSeed LiveInterpret 2.0 Die durchschnittliche Verzögerung beim ersten Wort beträgt nur 2,21 Sekunden; in komplexeren Speech-to-Speech-Szenarien (S2S) beträgt die Ausgabeverzögerung nur 2,53 Sekunden. Diese durchschnittliche Latenzzeit von 2 bis 3 Sekunden kommt der Leistung eines professionellen menschlichen Simultandolmetschers sehr nahe, was den reibungslosen Ablauf des Dialogs erheblich verbessert.

Samplefreie Klangwiedergabe und präzises Verständnis

Neben der geringen Latenzzeit verfügt das Modell auch über eine Zero-Shot-Stimmenreplikationsfunktion. Das bedeutet, dass es die Stimmqualitäten eines Sprechers in Echtzeit und ohne vorheriges Training nachbilden kann, wobei sein einzigartiges Timbre und seine Identität erhalten bleiben, wodurch Verwirrung aufgrund von Stimmgleichheit in Gesprächen mit mehreren Personen vermieden wird.

In komplexen Übersetzungsszenarien, z. B. bei Zungenbrechern, Gedichten, Esskultur usw., beweist das Modell seine Fähigkeit, den Kontext und den kulturellen Hintergrund genau zu verstehen, und erzielt eine natürliche und genaue Übersetzung zwischen Englisch und Chinesisch.

Daten zur Modellbewertung

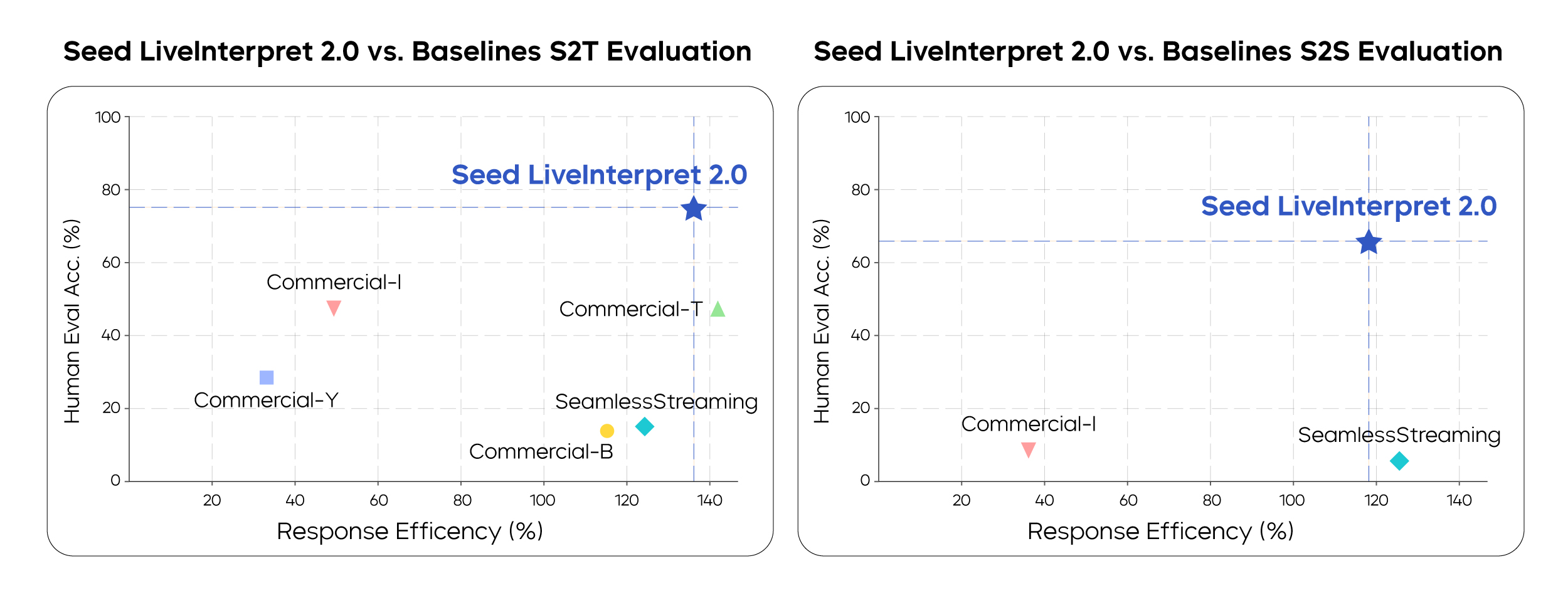

Bei einer manuellen Bewertung wird dieSeed LiveInterpret 2.0 Die Qualitätsbewertung des bidirektionalen Simultandolmetschens Chinesisch-Englisch von Sprache zu Text (S2T) übertraf mit 74,8 von 100 Punkten das zweitplatzierte Basissystem der Branche (47,3) um 581 TP3T.

Unter den Systemen, die Sprache-zu-Sprache-Übersetzung (S2S) unterstützen, erreicht das Modell eine durchschnittliche chinesisch-englische bidirektionale Übersetzungsqualität von 66,3 (die Bewertungsdimensionen umfassen Übersetzungsgenauigkeit, Latenz, Sprechgeschwindigkeit, Aussprache und Geläufigkeit), was anderen Basissystemen weit überlegen ist. Es ist erwähnenswert, dass die meisten der in den Vergleich einbezogenen Systeme noch nicht einmal die Funktion der Tonwiedergabe unterstützen.

Das Aufkommen dieser Technologie ist nicht nur eine weitere Iteration von Übersetzungswerkzeugen, sondern signalisiert, dass eine natürlichere und immersivere Art der Kommunikation über Sprachen hinweg Realität wird. Ob es sich um ein internationales Treffen, eine Geschäftsverhandlung oder eine Auslandsreise handelt, die Sprache wird kein Hindernis mehr für die Verbindung sein, wenn der Maschinendolmetscher in der Lage ist, "die Stimme so zu hören, als wäre sie ein Mensch".