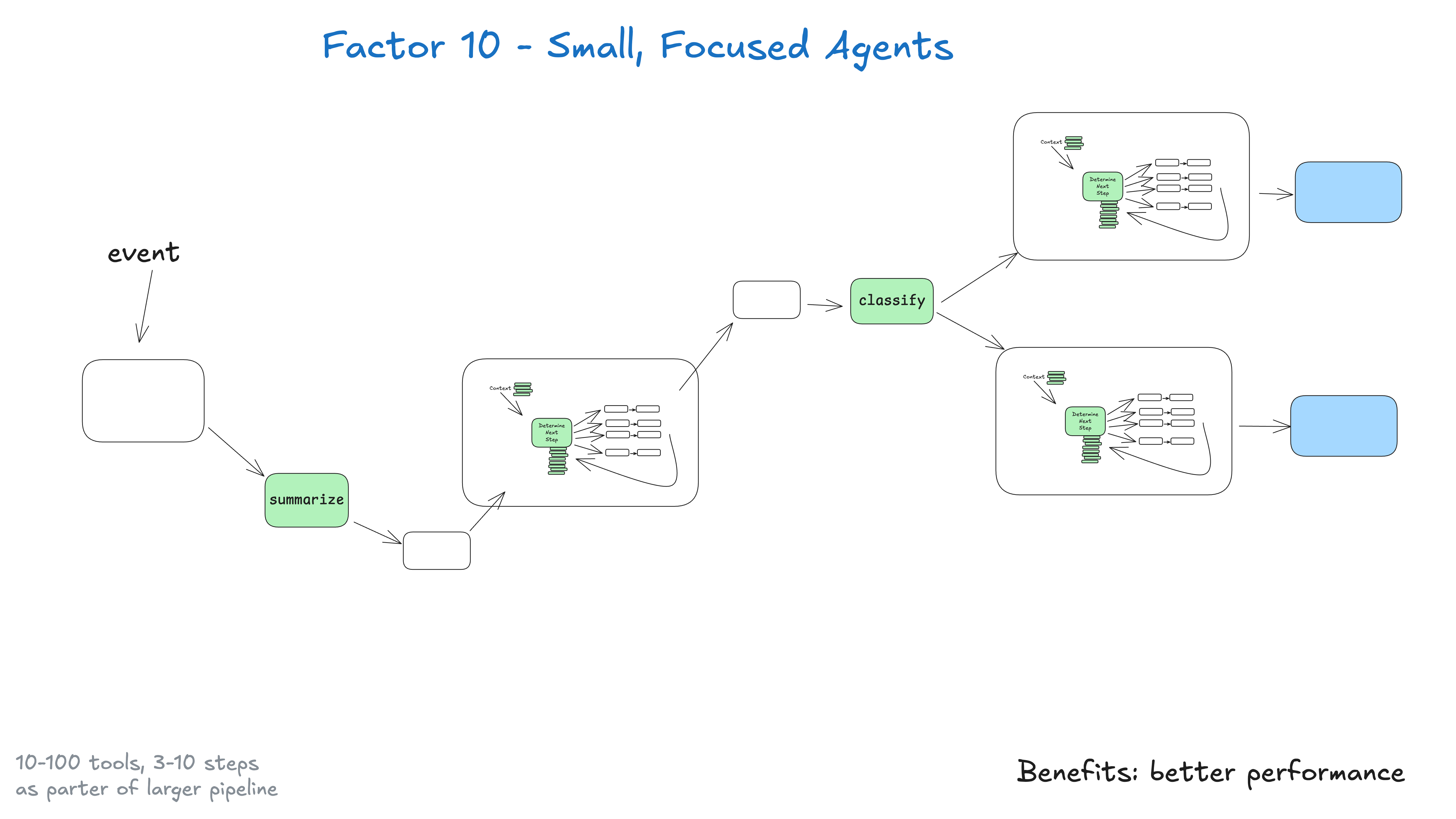

Anstatt monolithische Intelligenzen zu bauen, die versuchen, alles zu tun, ist es besser, kleine, konzentrierte Intelligenzen zu bauen, die eine Sache gut machen können. Intelligenzen sind nur ein Baustein in einem größeren, weitgehend deterministischen System.

Die wichtigste Erkenntnis liegt hier in den Grenzen großer Sprachmodelle: Je größer und komplexer die Aufgabe ist, desto mehr Schritte sind erforderlich, was ein längeres Kontextfenster bedeutet. Je größer der Kontext wird, desto wahrscheinlicher ist es, dass das große Sprachmodell verloren geht oder den Fokus verliert. Indem wir den Intelligenzen erlauben, sich auf bestimmte Bereiche zu konzentrieren und maximal 3-10, vielleicht 20 Schritte auszuführen, können wir das Kontextfenster überschaubar halten und die hohe Leistung des großen Sprachmodells beibehalten.

Je größer der Kontext, desto größer die Gefahr, dass große Sprachmodelle verloren gehen oder den Fokus verlieren

Die Vorteile von kleinen, konzentrierten Intelligenzen:

- kontrollierter Kontext: kleinere Kontextfenster bedeuten bessere Leistung für große Sprachmodelle

- Klare ZuständigkeitenJede Information hat einen klar definierten Umfang und Zweck

- Höhere ZuverlässigkeitWeniger Gefahr, sich in komplexen Arbeitsabläufen zu verirren

- Leichter zu testenTesten und Validieren bestimmter Funktionen ist einfacher

- Verbesserte FehlersucheLeichtere Erkennung und Behebung von Problemen, wenn sie auftreten

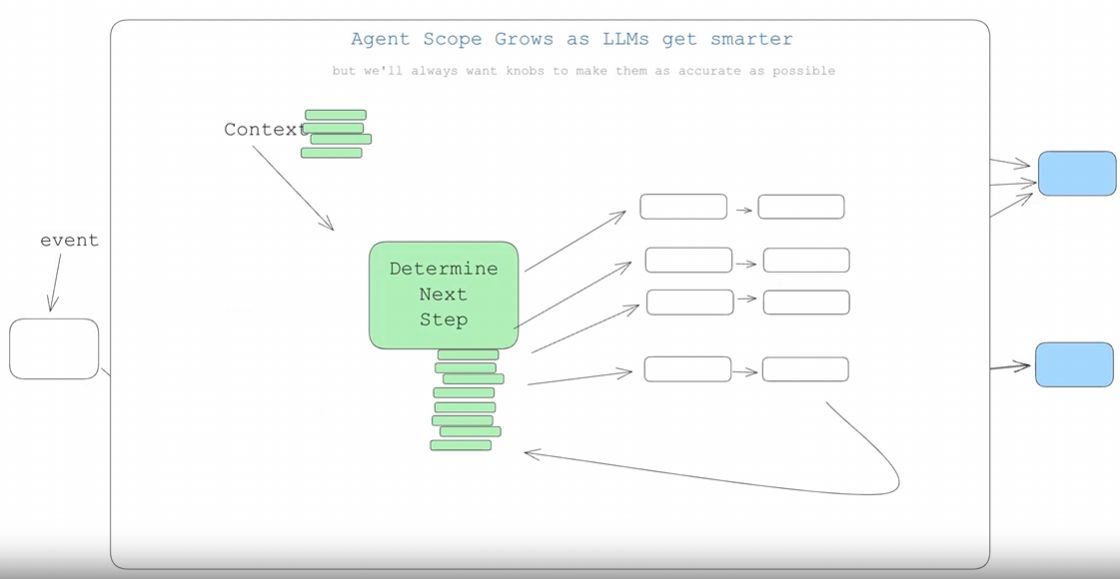

Was passiert, wenn große Sprachmodelle intelligenter werden?

Wenn große Sprachmodelle intelligent genug werden, um Arbeitsabläufe mit mehr als 100 Schritten zu bewältigen, müssen wir das dann noch tun?

Langer Rede kurzer Sinn: ja. Wenn Intelligenz und große Sprachmodelle sich weiterentwickeln, dann wahrscheinlich wird natürlich erweitert, um längere Kontextfenster zu verarbeiten. Das bedeutet, dass mehr Teile einer größeren DAG verarbeitet werden. Dieser kleine, fokussierte Ansatz stellt sicher, dass Sie heute Ergebnisse erhalten, und bereitet Sie auch auf die allmähliche Skalierung von Intelligenzen vor, wenn das große Sprachmodell-Kontextfenster zuverlässiger wird. (Wenn Sie schon einmal eine große deterministische Codebasis refaktorisiert haben, nicken Sie jetzt wahrscheinlich mit dem Kopf).

Der Schlüssel dazu ist die bewusste Kontrolle der Größe/des Umfangs der Intelligenzen und die Erweiterung nur in einer Weise, die die Qualität erhält. Wie im Fall von Das sagt das Team, das NotebookLM entwickelt hat:

Ich denke, dass die magischsten Momente bei der Entwicklung von KI immer dann kommen, wenn ich sehr, sehr, sehr nah an der Grenze der Fähigkeiten des Modells bin.

Wo auch immer diese Grenze liegt, wenn man sie findet und konsequent einhält, kann man erstaunliche Erlebnisse schaffen. Es gibt viele Gräben, die hier gebaut werden können, aber wie immer erfordert es ein gewisses Maß an technischer Strenge.