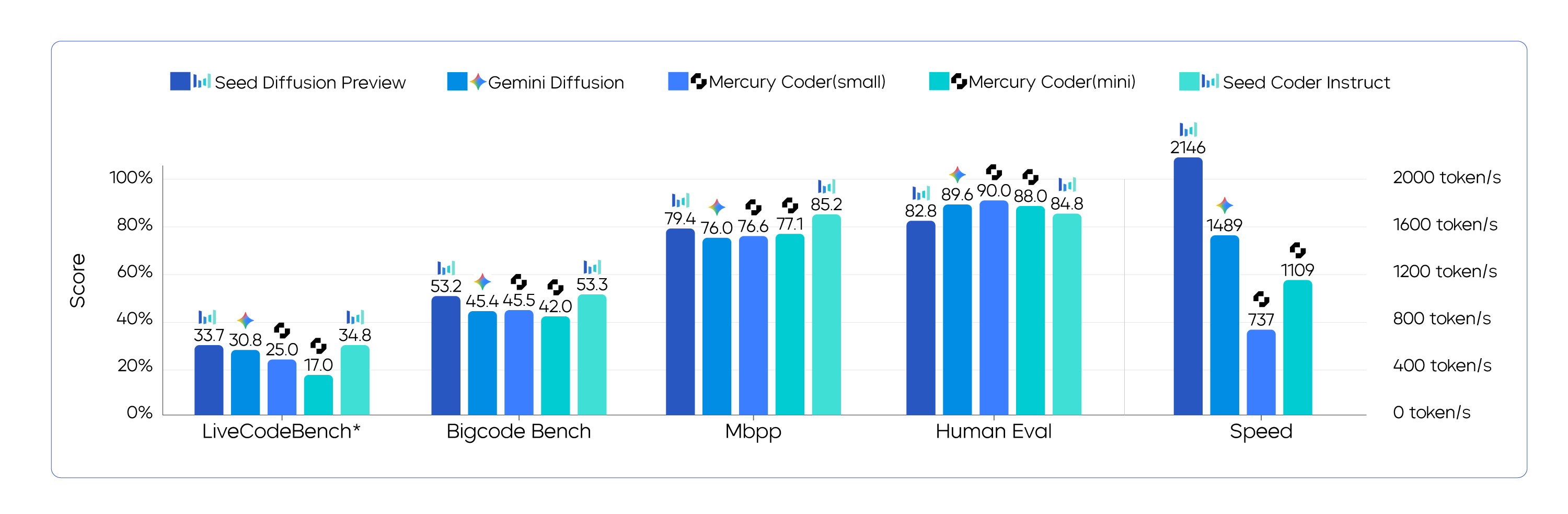

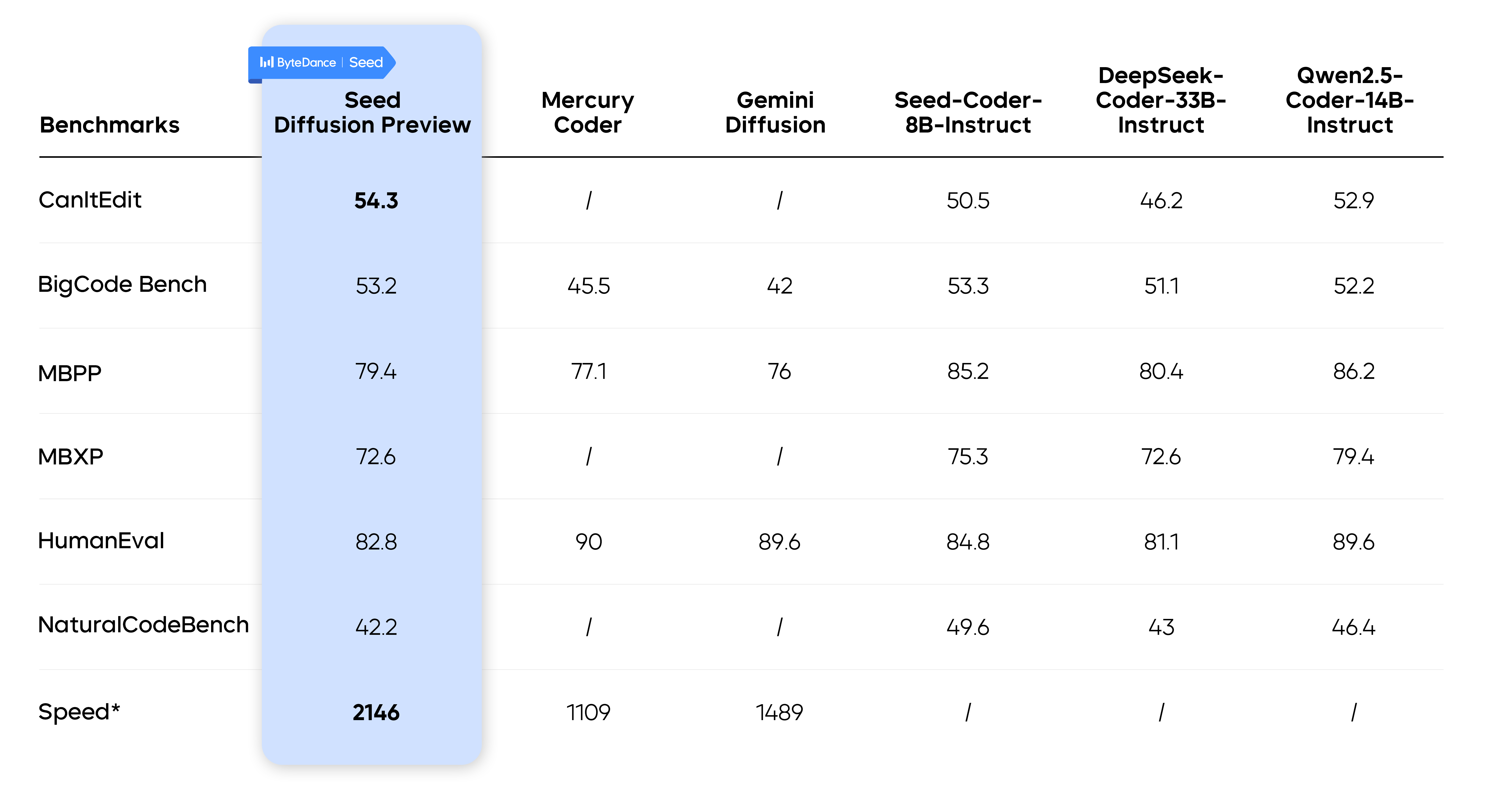

バイトジャンプ Seed という新製品を発表した。 Seed Diffusion Preview このモデルはコード生成に特化した実験的言語モデルである。このモデルは離散状態拡散技術に基づいており、いくつかのコアコードベンチマークで同等の性能を維持しながら、同じサイズの自己回帰モデルよりも5.4倍速い2146トークン/秒の推論速度を達成している。

この結果は、コードモデリングの速度品質パレートフロンティアの新しいベンチマークを設定し、コード生成の分野における離散拡散法の大きな可能性を示している。

自己回帰モデリングの「スピード・シャックル

現在主流のコード生成モデルのほとんどは、自己回帰的なアーキテクチャを使用しており、次のコードを1つずつ予測する。 token これは人間が文章を書くときの「逐語的出力」に似ている。このメカニズムはコードの一貫性を保証するが、同時に克服できないスピードのボトルネックも生み出す。各トークンの生成は前のトークンに依存するため、プロセス全体を効率的に並列化することができず、結果として長いコード列の処理が遅くなる。

Seed Diffusion 拡散モデルの採用は、根本的なゲームチェンジャーとなった。拡散モデルは当初、画像生成の分野で頭角を現し、どちらかというと「ぼかしから明瞭化へ」というペインティングプロセスのように機能した。コード生成では、ノイズの多い(あるいは "ぼやけた")画像から始めることができる。 [MASK] 最初のステップは、テンプレート(タグ)から始まる多段階の「ノイズ除去」によって、完全で構造的に正しいコードを並列に復元することである。理論的には、この並列デコード機能により、生成速度を大幅に向上させることができる。

Seed Diffusion 推論のスピードテスト条件が異なるため、他のモデルとの直接的なベンチマークは難しい。例えばMercury Coder を独自のデータセットとH100ハードウェアで評価した。 Gemini Diffusion 速度データは、未知のハードウェア上の混合タスクベンチマークから取得される。

スピードアップの核となる方法論

Seed チームは、拡散モデリングの理論的な利点を実用的な応用に結びつけるために、いくつかの重要な技術を導入した。

パターン充填から論理編集への2段階学習

拡散モデルをトレーニングする従来の方法には欠点がある。 [MASK] タグを配置し、他のカバーされていないコードが完全に正しいことを過度に信頼することは、技術的には「誤った相関」として知られている。

この限界を打ち破るため、チームは2段階の学習戦略を考案した:

- 第1段階:マスクによる拡散トレーニング。 この段階では、モデルは標準的な「穴埋め」タスクを通じて、コードのローカルコンテキストと固定パターンを学習する。

- 第2段階:編集に基づく拡散トレーニング。 このフェーズでは、編集距離に基づく摂動(挿入と削除の操作)を導入し、最初に発見されたトークンも含め、モデルにすべてのトークンを再検討させ、修正させる。これにより、コードのグローバルロジックを理解し修正するモデルの能力が大幅に向上する。

実験データは、第2段階のトレーニング導入後、モデルが CanItEdit ベンチマーキング pass@1 のスコアは、自己回帰モデルよりも4.8%高かった(54.3対50.5)。

先験的な融合コード構造の制約付き逐次拡散

シーケンシャルなデータとはいえ、コードは左から右へと厳密に生成されるわけではない。例えば、変数は使用される前に宣言されなければならない。完全に順不同の生成は、先験的にこの構造を無視することになり、性能の制限につながる。

この目的のために、チームは「制約付き順序学習」を提案している。トレーニング後の段階では、モデルは自己蒸留によって正しいコードの依存関係を学習し、それに従う。

戦略的学習と効率的並列復号化において

並列解読の理論的な利点は、実際には実現が難しい。一つの並列推論の計算オーバヘッドは高く、オーバヘッドを相殺するために総ステップ数を減らすと、生成の質がまた犠牲になる。

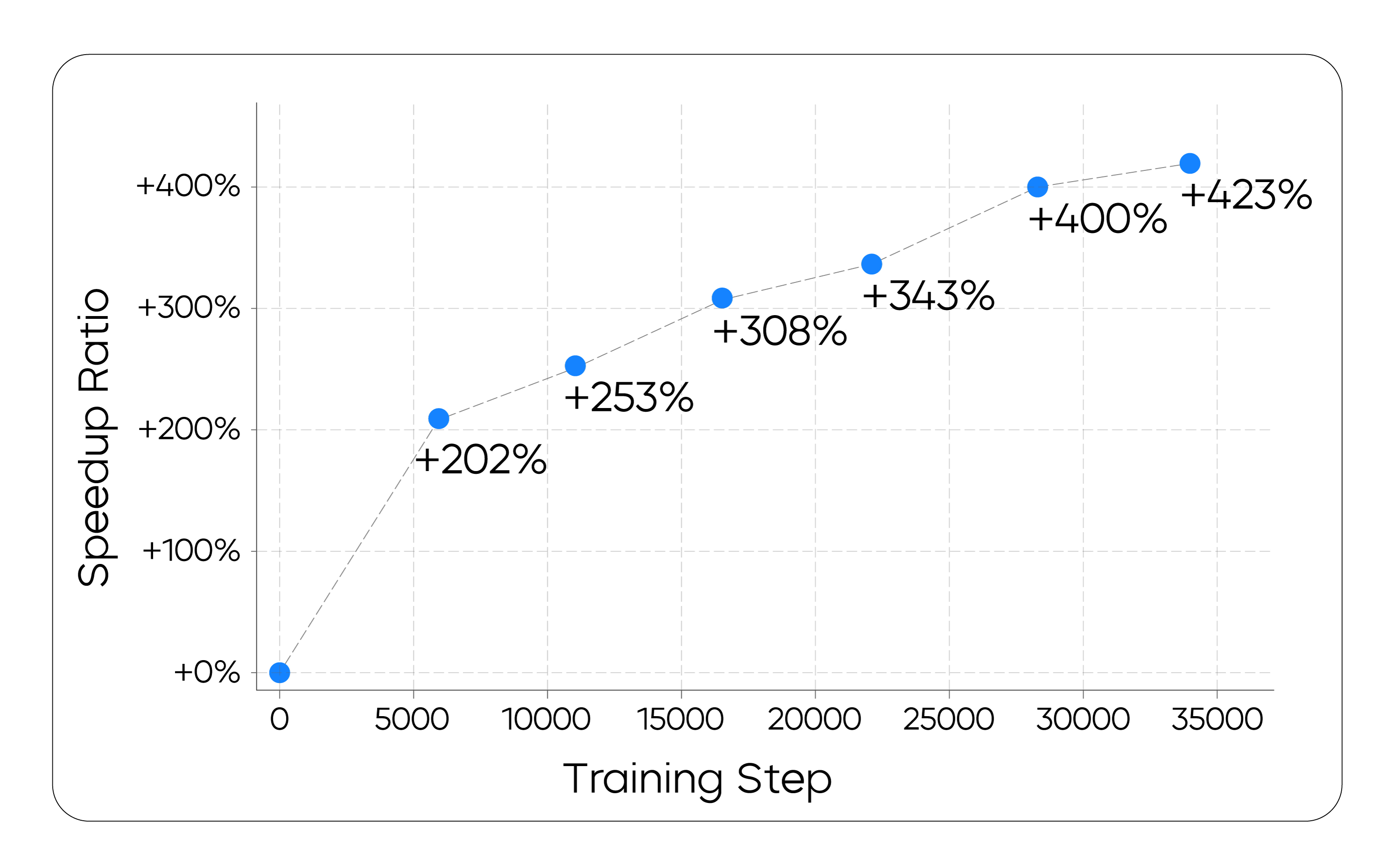

チームはこの目的のために、オンポリシー学習パラダイムを提案した。その目的は、最終的な出力の質を維持しながら生成ステップ数を最小化し、モデル自身の生成プロセスを直接最適化するようにモデルを訓練することである。 |τ|.その目的関数は以下の通りである:

Lτ = E(x0,τ)∼D[log V(xτ) - λ * |τ|].

実際には、ステップ数を直接最小化すると学習が不安定になる。その代わりに、チームはより安定した代理損失関数を採用し、モデルがより効率的に収束するように促した。このプロセスは、非自己回帰生成の文献で使われてきた「パターンフィルタリング」技法に似ており、非効率的あるいは低品質な生成経路は、訓練を通じて暗黙のうちに「刈り込まれる」。

理論から工学的実現へ

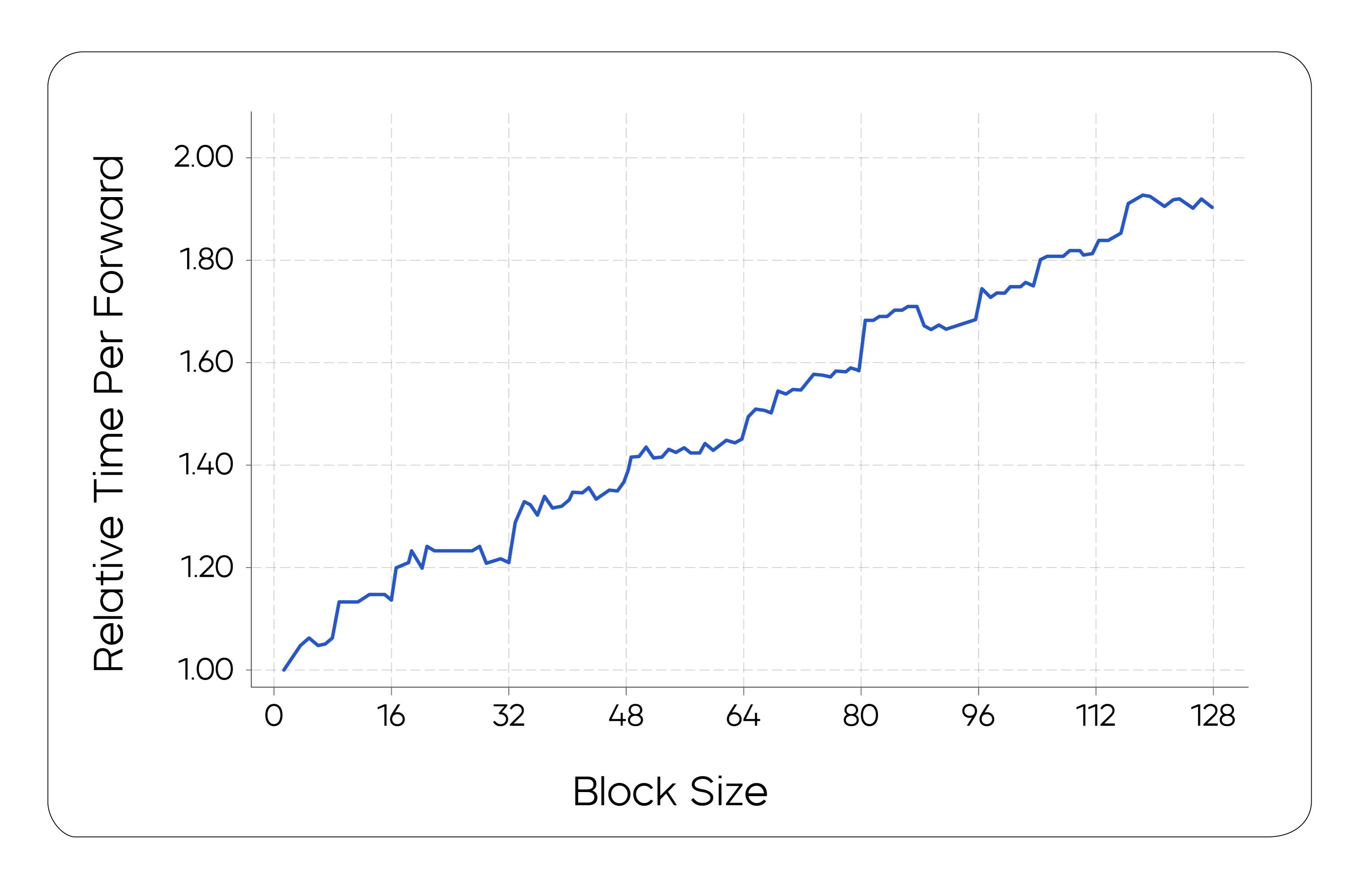

計算と待ち時間のバランスをとるためにSeed チームはチャンク並列拡散サンプリング方式を用いた。この方式は、チャンク間の因果関係の順序を維持しながら KV-caching テクニックは、生成されたチャンクから情報を再利用する。チームはまた、チャンク型並列推論を効率的にサポートするために、基盤となるインフラフレームワークを特に最適化した。

実験結果と市場展望

ジェネレーション・タスク・テストではSeed Diffusion Preview 拡散モデルの並列ポテンシャルがフルに発揮され、同じサイズの自己回帰モデルの5.4倍のスピードアップを達成した。

しかも、この高速性は品質を犠牲にしたものではない。複数の業界ベンチマークテストにおいてSeed Diffusion Preview その性能はトップクラスの自己回帰モデルに匹敵し、コード編集のようなタスクではそれらを上回ることさえある。

この結果は、次のことを示唆している。 Seed Diffusion 離散拡散法に代表される離散拡散アプローチは、次世代の生成モデルの基本フレームワークとなる可能性を秘めているだけでなく、その応用範囲の広さを予感させる。開発者にとって、5.4倍のスピードアップは、よりスムーズなリアルタイムコード補完、より高速な単体テスト生成、そしてより効率的な bug を修正することで、人間とコンピューターの共同プログラミングの体験を根本的に改善することができる。

を受けて Seed Diffusion プロジェクトの継続的な探求、複雑な推論タスクへの応用の可能性、スケーリング法則がさらに明らかになるだろう。