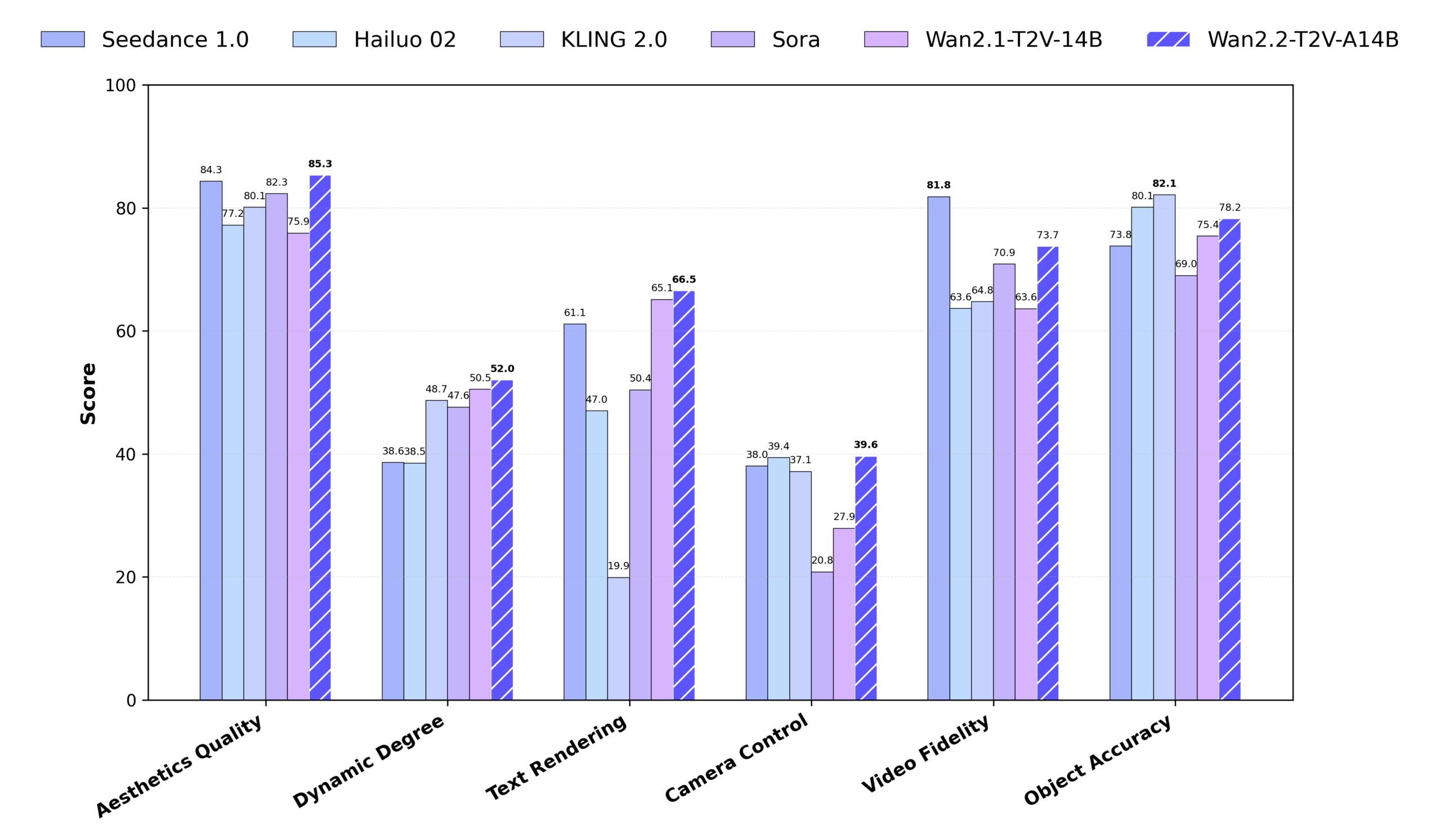

Wan2.2は、Alibaba Tongyi Labsによって開発されたオープンソースのビデオ生成モデルで、テキストや画像から高品質のビデオを生成することに重点を置いています。Wan2.2は720P@24fpsのHD動画生成をサポートし、民生用GPU(RTX 4090など)で動作するため、個人クリエイターや開発者に適しています。Wan2.1と比較して、Wan2.2は学習データに65.6%の画像と83.2%の動画を追加し、モーション生成、意味理解、美観を大幅に改善しました。Wan2.2は、Wan-Bench 2.0ベンチマークにおいていくつかの商用モデルを上回り、強力なパフォーマンスと幅広いアプリケーションの可能性を示しています。

機能一覧

- テキストからビデオへ(T2V) テキストの説明から480Pまたは720Pの5秒間のビデオを生成し、複雑なシーンやアクションをサポートします。

- イメージ・トゥ・ビデオ(I2V) 静止画から動画を生成し、画像の一貫性とスタイルを維持する。

- テキストと画像の共同生成(TI2V) テキストと画像を組み合わせて、低RAMデバイス用の720P@24fpsビデオを生成します。

- 高効率ビデオ可変オートエンコーダ(Wan-VAE) 16×16×4の圧縮率を実現し、高画質な映像の再構成に対応。

- ハイブリッド・エキスパート・アーキテクチャ(MoE) 高ノイズと低ノイズの両方のエキスパートモデルを使用して、生成品質を向上させ、計算効率を維持します。

- 映画の美学 ライティング、コンポジション、トーンの微調整をサポートし、プロフェッショナルなシネマスタイルのビデオを作成します。

- 複雑なモーションの生成 ダンス、格闘、パルクールなどのダイナミックなアクションを、スムーズで自然な動きでサポートします。

- チップ・エクステンション Dashscope APIまたはネイティブのQwenモデルを使用して、テキストキューを充実させ、ビデオのディテールを向上させます。

- 低メモリ最適化 FP8量子化とモデルオフロードをサポートし、GPUメモリ要件を削減。

- マルチプラットフォームの統合 DiffusersとComfyUIをサポートし、コマンドラインとグラフィカルインターフェースの両方で操作できます。

ヘルプの使用

設置プロセス

Wan2.2を使用するには、ローカルまたはサーバー上で環境を設定する必要があります。以下の詳細なインストールと使用手順は、初心者や経験豊富な開発者に適しています。

1.環境準備

お使いのシステムが以下の要件を満たしていることをご確認ください:

- ソフトウェア T2V-A14BおよびI2V-A14Bモデルは、少なくとも80GBのビデオメモリを搭載したGPU(例:A100)が必要です。TI2V-5Bモデルは、24GBのビデオメモリを搭載したコンシューマー向けGPU(例:RTX 4090)をサポートしています。

- オペレーティングシステム Windows、Linux、macOSに対応しています。

- パイソン版 Python 3.10以降。

- 依存ツール Git, PyTorch (2.4.0以降推奨), Hugging Face CLI, ModelScope CLI.

2.コードベースのクローン化

ターミナルまたはコマンドプロンプトで以下のコマンドを実行し、Wan2.2のコードベースをクローンする:

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

3.依存関係のインストール

必要なPythonライブラリをインストールします。以下のコマンドを実行する:

pip install -r requirements.txt

pip install "huggingface_hub[cli]" modelscope

マルチGPUアクセラレーションを使用する場合は、次のものをインストールする必要があります。 xfuser>=0.4.1:

pip install "xfuser>=0.4.1"

銘記する もし flash_attn インストールに失敗した場合は、他の依存関係を最初にインストールし、最後にそれらを個別にインストールすることをお勧めします。 flash_attn。

4.モデルの重みをダウンロードする

Wan2.2では、T2V-A14B、I2V-A14B、TI2V-5Bの3機種を用意している。 ダウンロードコマンドは以下の通りである:

Hugging Face ダウンロード :

huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14B

huggingface-cli download Wan-AI/Wan2.2-I2V-A14B --local-dir ./Wan2.2-I2V-A14B

huggingface-cli download Wan-AI/Wan2.2-TI2V-5B --local-dir ./Wan2.2-TI2V-5B

ModelScope ダウンロード :

modelscope download Wan-AI/Wan2.2-T2V-A14B --local_dir ./Wan2.2-T2V-A14B

modelscope download Wan-AI/Wan2.2-I2V-A14B --local_dir ./Wan2.2-I2V-A14B

modelscope download Wan-AI/Wan2.2-TI2V-5B --local_dir ./Wan2.2-TI2V-5B

5.環境変数の設定(オプション)

Hint Extension を使用している場合は、Dashscope API キーを設定する必要があります:

export DASH_API_KEY=your_dashscope_api_key

海外ユーザーの場合は、追加の設定が必要です:

export DASH_API_URL=https://dashscope-intl.aliyuncs.com/api/v1

事前にAlibaba CloudでAPIキーを申請する必要があります。

6.生成スクリプトの実行

Wan2.2 提供 generate.py スクリプトはビデオを生成するために使用されます。以下は各タスクの実行例である:

テキストからビデオへ (T2V-A14B) :

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- シングルGPU 80GBのビデオメモリが必要。

--offload_model True和--convert_model_dtype必要なグラフィックメモリを削減。 - マルチGPU :

torchrun --nproc_per_node=8 generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

画像からビデオへ(I2V-A14B) :

python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --offload_model True --convert_model_dtype --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上,背景是模糊的海景和绿色山丘"

- 画像の解像度は、ターゲットビデオの解像度と一致させる必要がある。

- 入力画像のみを頼りにした、促しなしの単語生成をサポート:

DASH_API_KEY=your_key python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --prompt '' --image examples/i2v_input.JPG --use_prompt_extend --prompt_extend_method 'dashscope'

テキスト画像共同生成(TI2V-5B) :

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- 画像入力 (I2Vモード):

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上"

- TI2V-5Bは、24GBのビデオメモリを持つGPUをサポートし、720P@24fpsのビデオを生成するのに約9分かかる。

チップ・エクステンション :

Dashscope API を使用します:

DASH_API_KEY=your_key python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'dashscope' --prompt_extend_target_lang 'zh' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

Qwenのネイティブモデル(例えば Qwen/Qwen2.5-7B-Instruct):

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'local_qwen' --prompt_extend_model 'Qwen/Qwen2.5-7B-Instruct' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

7.ComfyUIの使用

Wan2.2はGUIユーザーのためにComfyUIに統合されています。インストール手順

- ComfyUI-WanVideoWrapperのクローン:

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git

cd ComfyUI-WanVideoWrapper

pip install -r requirements.txt

- モデルファイルを ComfyUI カタログ

- T2V/I2Vモデル:

ComfyUI/models/diffusion_models/ - VAEモデル:

ComfyUI/models/vae/ - CLIPモデル:

ComfyUI/models/clip_vision/

- T2V/I2Vモデル:

- ComfyUIでワークフローを読み込み、Wan2.2モデルをインポートし、プロンプトを設定して実行する。

8.ディフューザーの使用

Wan2.2はディフューザーに統合され、モデルの呼び出しが簡単になりました:

from diffusers import DiffusionPipeline

pipeline = DiffusionPipeline.from_pretrained("Wan-AI/Wan2.2-TI2V-5B-Diffusers")

pipeline.to("cuda")

video = pipeline(prompt="两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战").videos

対応機種はT2V-A14B、I2V-A14B、TI2V-5Bです。

主な機能の操作

テキストからビデオへ

ネオンが点滅する夜の街並み」など、詳細なテキスト説明を入力して5秒間の動画を生成します。雪に覆われた森を背景に、赤いコートを着た少女が雪の中を歩いている」など、具体的なキューを入力することをお勧めします。キュー拡張機能 (--use_prompt_extend説明文は、より詳細な画像を生成するために自動的に強化することができます。

画像からビデオへ

画像をアップロードし、テキストで説明すると、アニメーション・ビデオが生成されます。例えば、猫の写真をアップロードし、「草の上で蝶を追いかける猫」と入力すると、対応するアニメーションが生成されます。画像の解像度がターゲット動画と同じであることを確認してください。

テキストと画像の共同生成

TI2V-5Bモデルは、720P@24fpsビデオを生成するために、テキストまたは画像入力をサポートしています。ビデオメモリが少ないデバイスに適しており、生成速度が速く、安定した結果が得られます。

映画の美学

Wan2.2は、照明、構図、色調を細かくコントロールできる。例えば、「サイド照明、ハイコントラスト、ウォームトーン、森の中に佇む若者」と入力すると、映画のようなスタイルのビデオが生成されます。

複雑なモーションの生成

障害物を飛び越えるストリートパルクールの選手」や「ネオンステージでパフォーマンスするヒップホップダンサー」などのダイナミックなアクションを、スムーズで自然な動きで生成するためのサポート。

アプリケーションシナリオ

- コンテンツ制作

- クリエイターは、テキストや画像を広告、ショートフィルム、ソーシャルメディアコンテンツ用のショートビデオに変換することができます。例えば、「星々を旅するSF宇宙船」のアニメーション動画を作成する。

- 教育&プレゼンテーション

- 教師は、静的なコースウェアを動的なビデオに変換して、教育や学習を強化することができる。例えば、歴史的な出来事の説明をビデオに変換し、歴史的な場面を見せることができます。

- ゲーム・アニメーション開発

- 開発者は、ゲームの背景ビデオやアニメーションのプロトタイプを生成することができます。例えば、ゲームシーンのリファレンスとして「中世の村の日常生活」を生成します。

- 商業宣伝

- 企業は製品のプロモーションビデオを作成できる。例えば、「アウトドアスポーツシーンにおけるスマートウォッチの活用」と入力すると、その機能を紹介するショートビデオが生成される。

- アート

- アーティストは静的な絵画を動的な動画に変えることができる。例えば、抽象画を流れるようなアニメーション効果に変えることができる。

QA

- Wan2.2の対応解像度は?

- T2V-A14BとI2V-A14Bは480Pと720Pをサポートし、TI2V-5Bは720P(1280)をサポートする。704または7041280)。

- 低ビデオメモリ・デバイスはどのように機能するのか?

- TI2V-5B モデル(24GB ビデオメモリ)を使用する場合は、以下の設定を有効にしてください。

--offload_model True、--convert_model_dtype和--t5_cpu必要なグラフィックメモリを削減。

- TI2V-5B モデル(24GB ビデオメモリ)を使用する場合は、以下の設定を有効にしてください。

- ビデオの画質を向上させるには?

- Detailed Cue Wordsを使用し、Cue Expansionを有効にし、FP16モデル(FP8よりも高品質)を選択する。

- 商業利用は可能か?

- はい、Wan2.2はApache 2.0ライセンスのもとでライセンスされており、関連する法律に従って、商用プロジェクトで使用することができます。

- Wan2.2がWan2.1より改善された点は?

- MoEアーキテクチャの導入により、トレーニングデータに65.6%の画像と83.2%の動画が追加され、より複雑な動きと映画品質の美的効果がサポートされる。