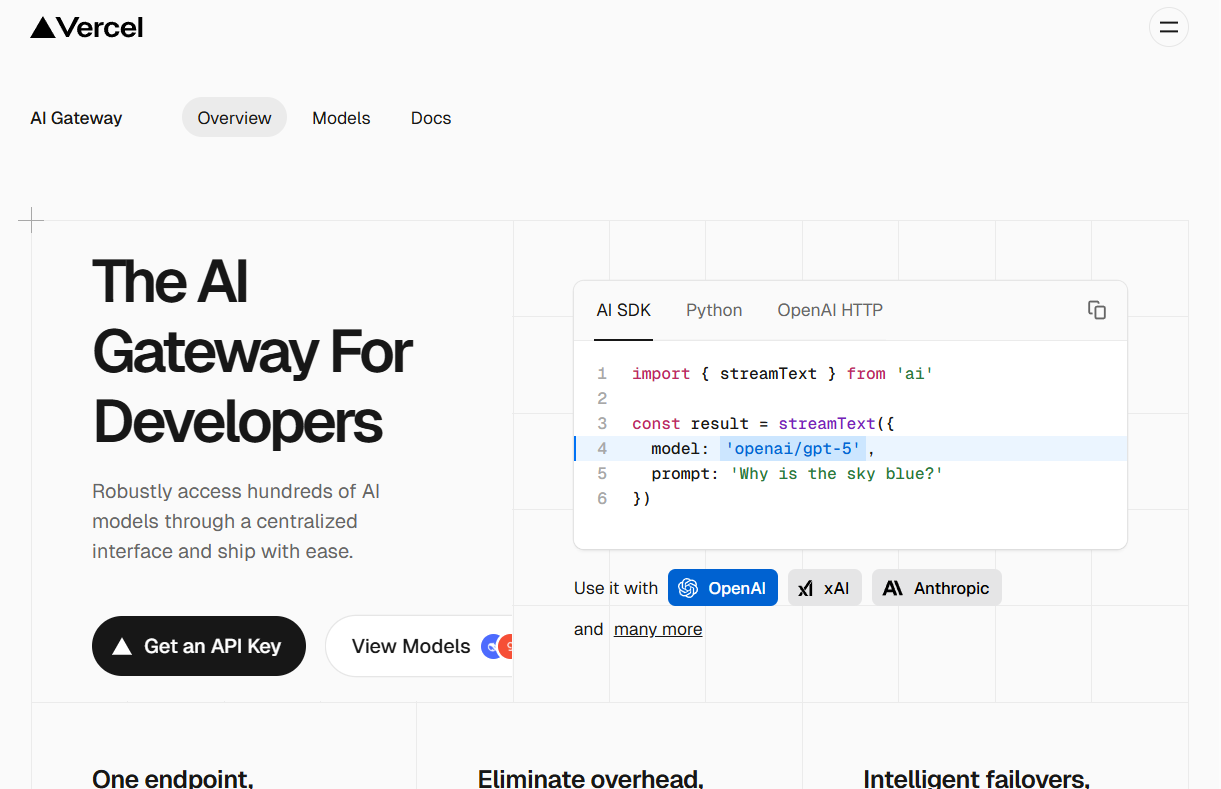

Vercel AI Gatewayは開発者向けに設計された中間層サービスです。 統一されたAPIインターフェースを提供することで、開発者は1つのコードで異なるベンダーの複数のAIモデルにアクセスできる。 このサービスの主な目的は、AIアプリケーションの開発と管理のプロセスを簡素化することである。開発者は、AIモデルごとに別々のAPIキーを管理したり、複雑な課金に対応したり、異なるサービス・プロバイダーの料金制限に対処したりする必要がなくなる。 また、インテリジェントな障害バックアップ機能が組み込まれており、AIモデルのサービスに障害が発生した場合、システムが自動的にバックアップモデルに切り替えることができるため、アプリケーションの安定性と信頼性が向上する。 さらに、AI Gatewayは、開発者がより良いコスト管理とサービス最適化のためにアプリケーションの使用量とパフォーマンスを監視するのに役立つロギングと分析ツールも提供する。

機能一覧

- 統一APIインターフェースOpenAI、Anthropic、xAIなど、異なるベンダーの何百ものAIモデルを、1行のコードを変更するだけで切り替えて使用するための、単一のAPIエントリーポイント(エンドポイント)を提供します。

- インテリジェント障害バックアップAIモデルプロバイダーのサービスが中断された場合、ゲートウェイは自動的にリクエストを別のモデルやプロバイダーに切り替えることができ、アプリケーションサービスの継続性を保証します。

- パフォーマンス・モニタリングとロギングゲートウェイを介したすべてのAIリクエストを一元的にロギングすることで、開発者はアプリケーションのパフォーマンスに関する問題の追跡、分析、デバッグが容易になります。

- コスト管理と予算管理開発者が予算を設定し、AIモデル呼び出しのコストをリアルタイムで監視することで、コスト超過を防ぐことができます。

- 鍵管理の簡素化開発者は複数のベンダーのAPIキーを自分のアプリケーションで管理する必要がありません。

- シームレスな統合Vercel AI SDK、OpenAI SDK、その他の主流のフレームワークと簡単に統合でき、開発者は使い慣れたツールを使って開発することができます。

- 速度無制限Vercel自身はAPIリクエストにレート制限を設けないため、開発者はアップストリーム・プロバイダーが提供する最大スループットをフルに活用できる。

ヘルプの使用

Vercel AI Gatewayは、アプリケーションにおける大規模言語モデル(LLM)の統合と管理のプロセスを簡素化するために設計されています。開発者がVercelの統一インターフェースと対話するだけで、市場に出回っている主要なAIモデルの多くを呼び出すことができるプロキシレイヤーとして機能します。

ステップ1: APIキーの取得

- ヴェルセルAIゲートウェイの公式ウェブサイトをご覧ください。

- サインアップ」をクリックして、Vercelアカウントに登録してください。新規ユーザーは、プラットフォーム上のどのモデルも体験できる毎月5ドルのクレジットを無料でご利用いただけます。

- ログイン後、AI Gatewayのコントロールパネルで、新しいプロジェクトを作成し、専用のAPIキーを取得することができます。このキーはその後のAPIリクエストの認証に使用されますので、大切に保管してください。

ステップ2:開発環境の設定

AI Gatewayは複数のプログラミング言語やフレームワークと連携することができます。以下はPython環境とOpenAI公式SDKの設定と使い方の例です。

まず、開発環境にOpenAIのPythonライブラリがインストールされていることを確認してください。まだインストールされていない場合はpipコマンドでインストールする:

pip install openai

インストールが完了したら、Vercelから取得したAPIキーを環境変数として設定する必要がある。そうすることで、コードにキーをハードコードするよりも安全です。

ターミナルで環境変数を設定する:

export AI_GATEWAY_API_KEY='你的Vercel AI Gateway API密钥'

を含めてください。你的Vercel AI Gateway API密钥これを最初のステップで入手した本物のキーに置き換える。

ステップ3:APIリクエストを送信する

設定が完了したら、コードを書くことでAIモデルを呼び出すことができます。コアとなる操作は、OpenAIクライアントをbase_urlパラメータには、Vercel AI Gatewayのユニファイド・インターフェース・アドレスを指定します。

以下は、AIゲートウェイのgrok-4モデル

import os

from openai import OpenAI

# 初始化OpenAI客户端

# 客户端会自动读取名为'AI_GATEWAY_API_KEY'的环境变量作为api_key

# 同时,必须将base_url指向Vercel的网关地址

client = OpenAI(

api_key=os.getenv('AI_GATEWAY_API_KEY'),

base_url='https://ai-gateway.vercel.sh/v1'

)

# 发起聊天补全请求

try:

response = client.chat.completions.create(

# 'model'参数指定了你想要调用的模型

# 格式为 '供应商/模型名称'

model='xai/grok-4',

messages=[

{

'role': 'user',

'content': '天空为什么是蓝色的?'

}

]

)

# 打印模型返回的回答

print(response.choices[0].message.content)

except Exception as e:

print(f"请求发生错误: {e}")

このコードではbase_url='https://ai-gateway.vercel.sh/v1'が鍵となる。 OpenAIに送られるはずだったリクエストを、Vercel AI Gatewayにリダイレクトします。model='xai/grok-4'そして、リクエストを適切なAIプロバイダー(この場合はxAI)に転送し、最終的な結果をあなたに返す。

モデルの切り替え

AI Gatewayの最大の利便性のひとつは、簡単にモデルを切り替えられることだ。もしAnthropicのclaude-sonnet-4モデルを変更するだけです。modelパラメータで十分であり、残りのコードに変更はない:

response = client.chat.completions.create(

model='anthropic/claude-sonnet-4',

messages=[

{

'role': 'user',

'content': '请给我写一个关于太空旅行的短故事。'

}

]

)

print(response.choices[0].message.content)

この設計により、開発者は認証やネットワーク・リクエストに関連する基本的なコードを変更することなく、柔軟にモデルをテストしたり切り替えたりすることができる。

アプリケーションシナリオ

- ラピッドプロトタイピング

AIアプリケーションの開発の初期段階では、開発者はアプリケーションのシナリオに最適なモデルを見つけるために多くの異なるモデルを試す必要があります。AI Gatewayを使用することで、開発者はモデルごとに完全な統合を開発することなく、モデル識別子を変更するだけで、異なるモデルのパフォーマンスとコストを迅速にテストし、比較することができます。 - アプリケーションの信頼性向上

すでにオンライン化され、ユーザーと対面している本番環境のアプリケーションにとって、サービスの安定性は非常に重要です。AI Gatewayの障害バックアップ機能を設定することで、プライマリ・モデルのサービスが利用できない場合、システムは自動的にスタンバイ・モデルに切り替わり、アプリケーションのコア機能に影響がないことを保証し、ユーザー・エクスペリエンスを向上させることができます。 - 新興企業のコスト管理

AI Gateway のモニタリングと予算管理機能は、トークンの消費量と経費をリアルタイムで追跡し、コスト要素を把握するのに役立ちます。予算の上限を設定することで、コードエラーやトラフィックの急増による予期せぬ高額請求を効果的に防ぐことができます。 - マルチモデルアプリケーションの統合管理

AI Gatewayは、開発者がAPIコール、ログ、すべてのモデルの費用を一箇所で監視・管理できる統合管理プラットフォームを提供することで、複雑なO&Mを簡素化します。

QA

- Vercel AI Gatewayを使うのにお金はかかりますか?

Vercelは新規登録者に月額5ドルの無料クレジットを提供しており、このクレジットはプラットフォーム上のAIモデルのいずれかを体験するために使用できる。無料クレジットを使い切るか、ユーザーが初回支払いを済ませると、その後の利用はボリュームごとに課金される。Vercel自体はトークンの価格をマークアップしておらず、料金は上流のプロバイダーを直接利用した場合の価格と一致している。 - AI GatewayはどのようなAIモデルをサポートしていますか?

AI Gatewayは、OpenAI、Anthropic、Google、xAI、Groq、その他多くの主要ベンダーの数百のモデルをサポートしています。サポートの完全なリストは、Vercelの公式ドキュメントまたはモデルマーケットプレイスで見ることができます。 - Vercel AI GatewayはAPIリクエストの速度を制限しますか?

Vercel自身はゲートウェイを介したAPIリクエストのレート制限を設定しない。開発者が利用できるリクエストレートとスループットは、上流のAIモデルプロバイダ独自の制限ポリシーに大きく依存する。 - すでにOpenAIのSDKを使っている場合、AI Gatewayへの移行は複雑ですか?

移行プロセスはとても簡単です。OpenAIクライアントをbase_urlパラメータは、Vercelが提供するゲートウェイアドレスに変更される。api_keyキーをVercelから入手したものに置き換えるだけで十分であり、中核となるビジネスコードはほとんど変更する必要がない。